- 1thinkphp日志泄漏漏洞_Thinkphp5 远程代码执行漏洞事件分析报告

- 2数据要素时代,企业数据如何安全合规流通?

- 3【深度学习】Transformer长大了,它的兄弟姐妹们呢?(含Transformers超细节知识点)...

- 4下载AOSP源码编译、调试、刷机_aosp_arm64-exp-u1b1.230908.003-10811961-24d7d0fa

- 5最强Node js 后端框架学习看这一篇文章就够_使用node写后台 框架

- 6Laravel 6 - 第十五章 验证器

- 7IDEA上配置Maven环境

- 8python 文本分类卡方检验_中文文本分类:你需要了解的10项关键内容

- 9程序员年龄大了,真的会失业吗?那么以后该怎么办_游戏开发年龄大了怎么办

- 10详解UART通信协议以及FPGA实现

XAI-可解释的人工智能

赞

踩

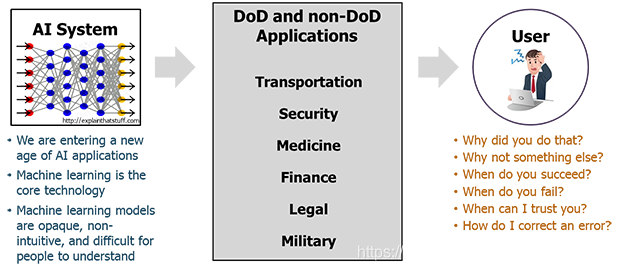

机器学习的巨大成功导致了大量的人工智能(AI)应用程序。 持续的进步有望产生能够自我感知,学习,决定和行动的自主系统。 然而,这些系统的有效性受到机器当前无法向人类用户解释其决策和行动的限制(上图)。 国防部(DoD)面临着需要更智能,自主和共生系统的挑战。 如果未来的战士能够理解,适当地信任并有效地管理新一代的人工智能机器合作伙伴,那么可解释的人工智能 - 特别是可解释的机器学习 - 将是必不可少的。

可解释AI(XAI)计划旨在创建一套机器学习技术:

- 产生更多可解释的模型,同时保持高水平的学习成绩(预测准确性); 和

- 使人类用户能够理解,适当地信任并有效地管理新一代人工智能合作伙伴。

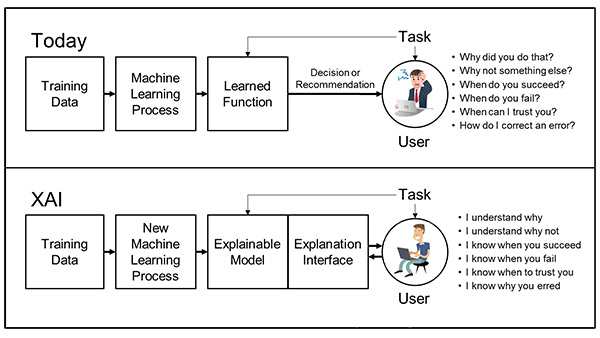

新的机器学习系统将能够解释它们的基本原理,表征它们的优点和缺点,并传达对它们将来如何表现的理解。 实现该目标的策略是开发新的或改进的机器学习技术,以产生更多可解释的模型。 这些模型将结合最先进的人机界面技术,能够将模型转化为最终用户可理解和有用的解释对话(下图)。 我们的策略是采用各种技术,以生成一系列方法,为未来的开发人员提供一系列涵盖性能与可解释性交易空间的设计方案。

XAI是当前DARPA少数计划之一,旨在实现“第三代AI系统”,其中机器了解其运行的环境和环境,并随着时间的推移构建底层解释模型,使其能够表征现实世界现象。

XAI计划通过解决两个领域的挑战问题,专注于多系统的开发:(1)机器学习问题,用于对异构多媒体数据中感兴趣的事件进行分类; (2)机器学习问题,为自治系统构建决策策略,以执行各种模拟任务。

此外,研究人员正在研究解释的心理学。

XAI研究原型在整个项目过程中经过测试和持续评估。 在2018年5月,XAI研究人员展示了他们可解释学习系统的初步实施,并展示了他们的第一阶段评估的初步试点研究结果。 预计2018年11月将进行全阶段1系统评估。

参考

https://www.darpa.mil/program/explainable-artificial-intelligence