热门标签

热门文章

- 1JVM垃圾回收机制_个对象从加载到jvm,再到被gc清除,都经历了什么过程?

- 2Web3小白解惑系列:区块链入门(第三弹)_比特币halving

- 3浅析商业模式画布在鞋服零售行业的应用

- 4目前电视盒子哪个最好?资深小编分享热销电视盒子品牌排行榜_最好的电视盒子市场有哪些

- 5使用brew安装mysql后找不到my.cnf文件

- 6让模型畅所欲言不再Say No丨专访Dolphin开源模型作者Eric Hartford

- 7idea中使用git更新代码,导致未提交代码被覆盖的解决办法_idea代码提交git修改的代码没了

- 8整合SpringSecurity+JWT实现登录认证_spring security认证和授权 整合jwt 的 登录

- 9自动化测试:PO模式详解(经验分享)_自动化测试po模式

- 10springboot/springcloud父子工程项目 打包 部署 到linux cenos7全流程 及 注意事项_spring colud打包成程序

当前位置: article > 正文

LLM大模型服务器端部署_llm studio 在linux的安装

作者:菜鸟追梦旅行 | 2024-05-07 12:10:32

赞

踩

llm studio 在linux的安装

下载终端工具

首先,我们要下载一个软件,叫MobaXterm,在这个软件上可以连接到服务器,通过指令操作服务器。

-

软件:MobaXterm https://mobaxterm.mobatek.net/download.html

-

输入Remote host即可,输入形式为username@serverIP,然后输入密码,就可以访问了

-

(username@serverIP:abc@xxx.xxx.x.xxx)

下载文件传输工具

上面的MobaXterm是用来操纵服务器跑代码的,但是在文件上传和下载这方面还不是很方便,咱们再下载一个专门用来处理文件的软件

- 工具WinSCP https://winscp.net/eng/download.php

安装anaconda

下载anaconda

wget https://repo.anaconda.com/archive/Anaconda3-2023.09-0-Linux-x86_64.sh

- 1

安装anaconda

bash Anaconda3-2023.09-0-Linux-x86_64.sh

- 1

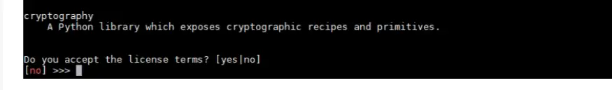

一直敲Enter直到出现以下询问,点击yes

安装目录确认:

确认安装成功

anaconda --version

## or

conda -V

- 1

- 2

- 3

【已解决】bash: conda: command not found_-bash: conda: 未找到命令_一白梦人的博客-CSDN博客

conda 创建新环境使用

conda create -n baichuan2 #创建名为“baichuan2”的环境

conda activate baichuan2 #激活环境

conda info --envs #查看当前活跃的环境

conda list #查看当前环境安装的包和版本

conda install numpy scikit-learn #安装指定的包

conda env remove -n 'env_name' #删除指定的环境

conda env list #查看所有的环境

- 1

- 2

- 3

- 4

- 5

- 6

- 7

问题?

- conda activate chatglm-6b

conda: error: argument COMMAND: invalid choice: 'activate'

(choose from 'clean', 'compare', 'config', 'create', 'info', 'init', ...

- 1

- 2

- 最新版conda移除了activate;

source activate chatglm-6b

- 1

ChatGLM-6b 部署

安装依赖包

pip install -r requirements.txt

- 1

从本地加载模型

参考官方可以先将模型下载到本地,然后从本地加载。

python -c "import torch; print(torch.cuda.is_available())" # 检查cuda是否正常 正常情况下,这里输出false需要重新安装torch pip uninstall torch -y conda install pytorch==1.12.1 torchvision==0.13.1 torchaudio==0.12.1 cudatoolkit=11.3 -c pytorch -y python -c "import torch; print(torch.cuda.is_available())" pip uninstall gradio -y pip install gradio==3.44.4 pip uninstall charset-normalizer -y pip install charset-normalizer==3.2.0 pip uninstall typing-extensions -y pip install --upgrade typing-extensions pip install chardet python -c "from PIL import Image" # 可能会报错 ImportError: DLL load failed while importing _imaging: 找不到指定的模块 需要重新安装Pillow pip uninstall Pillow -y pip install --upgrade pillow python -c "from PIL import Image"

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

运行模型

网页版Demo

修改web_demo.py中的模型所在的位置,改为绝对地址;

tokenizer = AutoTokenizer.from_pretrained("E:\\xxx\\xxx\\chatglm\\chatglm-6b", trust_remote_code=True, revision="")

model = AutoModel.from_pretrained("E:\\xxx\\xxx\\chatglm\\chatglm-6b", trust_remote_code=True, revision="").half().cuda()

- 1

- 2

执行web代码;

python web_demo.py

- 1

问题?

START /usr/bin/firefox "http://127.0.0.1:7861/"

Failed to open connection to "session" message bus: Using X11 for dbus-daemon autolaunch was disabled at compile time, set your DBUS_SESSION_BUS_ADDRESS instead

Running without a11y support!

- 1

- 2

- 3

这个错误信息提示系统连接到 D-Bus 会话总线时出现问题。

要解决此问题,您可以尝试将 DBUS_SESSION_BUS_ADDRESS 环境变量设置为正确的值。以下是设置步骤:

- 打开终端窗口。

- 输入以下命令并按 Enter 键:

echo $DBUS_SESSION_BUS_ADDRESS

- 1

- 如果输出为空或不正确,可以通过运行以下命令设置变量:

export DBUS_SESSION_BUS_ADDRESS=export DBUS_SESSION_BUS_ADDRESS=unix:path=/run/dbus/system_bus_socket

- 1

- 再次尝试运行程序,查看错误是否已解决。

如果上述步骤无法解决问题,您可能需要检查 D-Bus 守护程序是否正常运行或重新安装 D-Bus 包。

问题?Running without a11y support!

- 这个问题还没解决

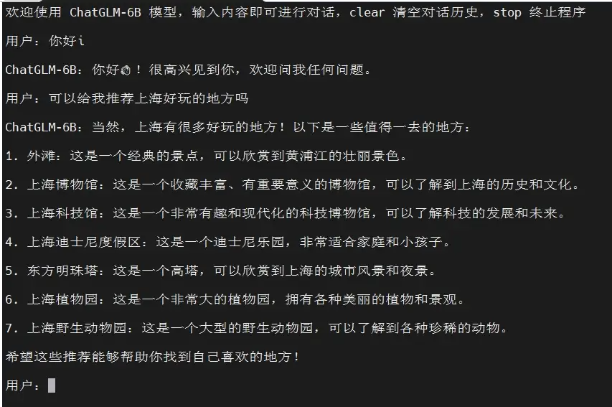

命令行Demo

- 修改 cli_demo.py 中的模型地址;

- 执行程序

python cli_demo.py

- 1

问题?

RuntimeError: CUDA out of memory. Tried to allocate 128.00 MiB (GPU 0; 31.75 GiB total capacity; 9.50 GiB already allocated; 78.12 MiB free; 9.50 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

- 1

看一看GPU卡使用情况

nvidia-smi

- 1

指定GPU卡

CUDA_VISIBLE_DEVICES=1 python cli_demo.py

- 1

运行结果

本文由mdnice多平台发布

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/菜鸟追梦旅行/article/detail/549134

推荐阅读

相关标签