- 1springboot点餐微信小程序毕业设计源码221144

- 2python第三方包离线安装(以matplotlib为例)_matplotlib离线安装包

- 3【Datawhale AI 夏令营第二期--机器学习-电力需求预测挑战赛--Task2学习笔记】

- 4MySQL:七种 SQL JOINS 的实现(图文详解)_mysql out join

- 5Github星标30k+,超火的Spring Boot开源项目,文档贼全_springboot最新开源项目 github

- 6NJU SE 商务智能期末复习

- 7多线程经典面试题_c++多线程面试题

- 8百度测试工程师胜任力模型_硬件测试工程师胜任力怎么写

- 9阿里声音项目Qwen2-Audio的部署安装,在服务器Ubuntu22.04系统——点动科技_qwen2audioforconditionalgeneration

- 10ora-01720 授权选项对于xxxx不存在_grant select on a to b 报错

Ollama + WebUI本地化部署大模型

赞

踩

1、前言

· Ollama是一个开源的 LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型,降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型,包括如Llama 3、Phi 3、Mistral、Gemma等开源的大型语言模型。

Ollama目前支持以下大语言模型:https://ollama.com/library

| Model | Parameters | Size | Download |

| Llama 3 | 8B | 4.7GB |

|

| Llama 3 | 70B | 40GB |

|

| Mistral | 7B | 4.1GB |

|

| Dolphin Phi | 2.7B | 1.6GB |

|

| Phi-2 | 2.7B | 1.7GB |

|

| Neural Chat | 7B | 4.1GB |

|

| Starling | 7B | 4.1GB |

|

| Code Llama | 7B | 3.8GB |

|

| Llama 2 Uncensored | 7B | 3.8GB |

|

| Llama 2 13B | 13B | 7.3GB |

|

| Llama 2 70B | 70B | 39GB |

|

| Orca Mini | 3B | 1.9GB |

|

| LLaVA | 7B | 4.5GB |

|

| Gemma | 2B | 1.4GB |

|

| Gemma | 7B | 4.8GB |

|

| Solar | 10.7B | 6.1GB |

|

本教程主要说明如何在Windows(Win10、Win11)上部署和使用本地模型。

用到的安装包和资料已上传到百度网盘:

链接:百度网盘 请输入提取码

提取码:wzw7

2、Ollama下载与安装

2.1 下载Ollama

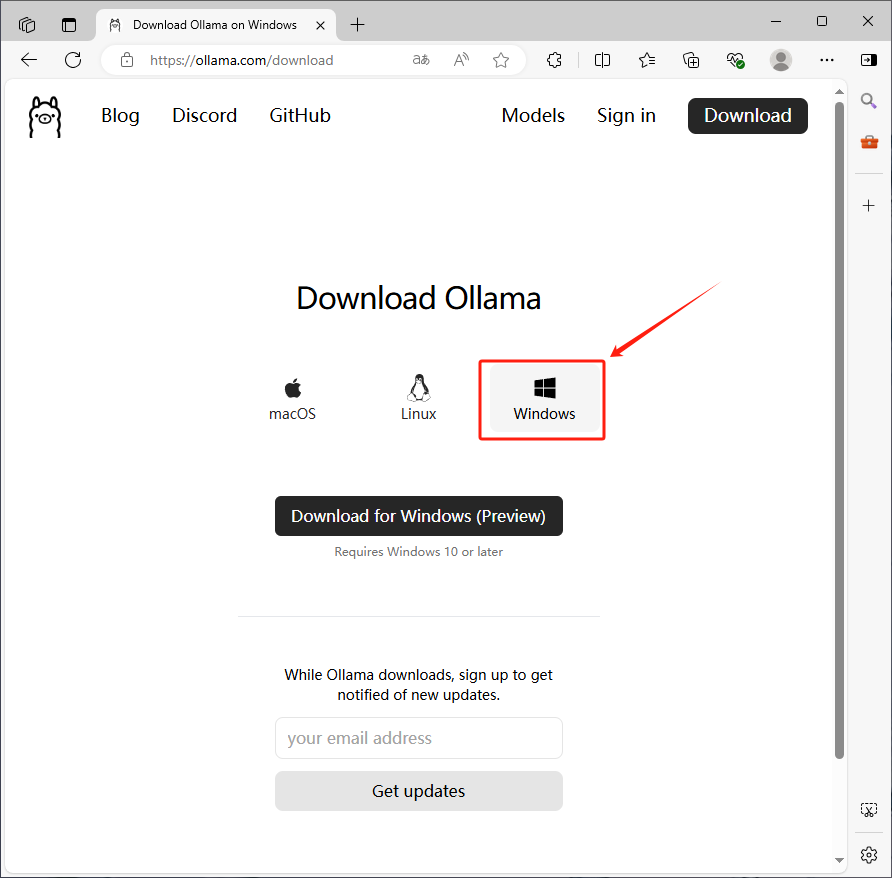

1、官网下载

ollama工具的下载地址为https://ollama.com/download,选择Windows版本进行下载安装即可。

2、网盘下载

链接:百度网盘 请输入提取码

提取码:wzw7

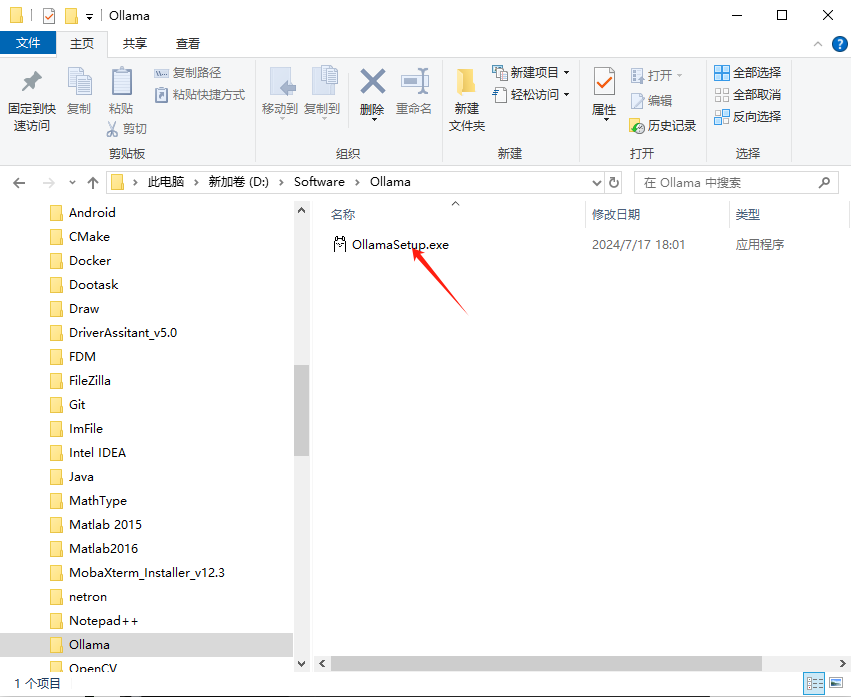

2.2 安装Ollama

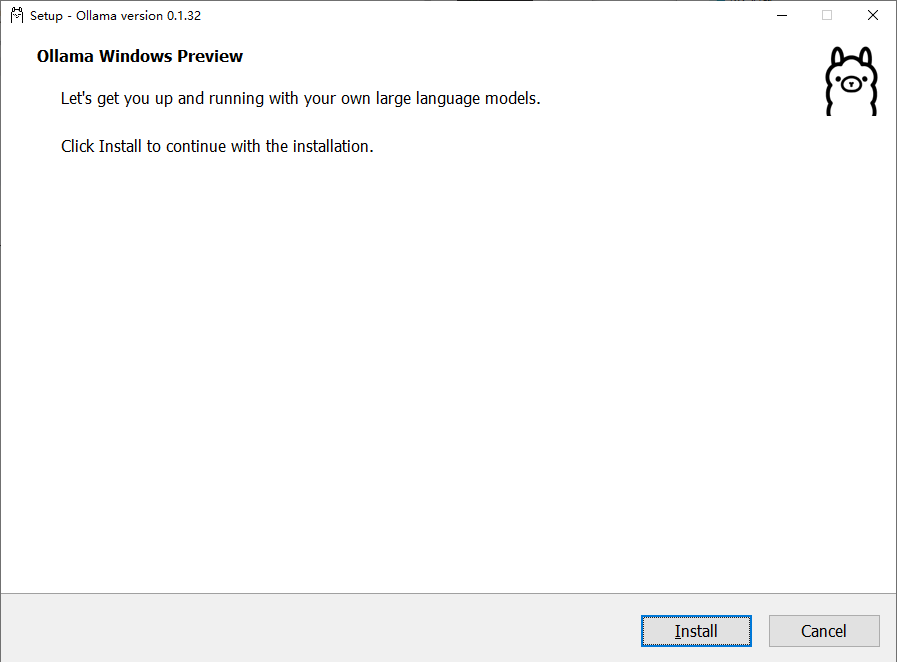

下载后安装,直接点击“Install”。

2.3 更改模型路径

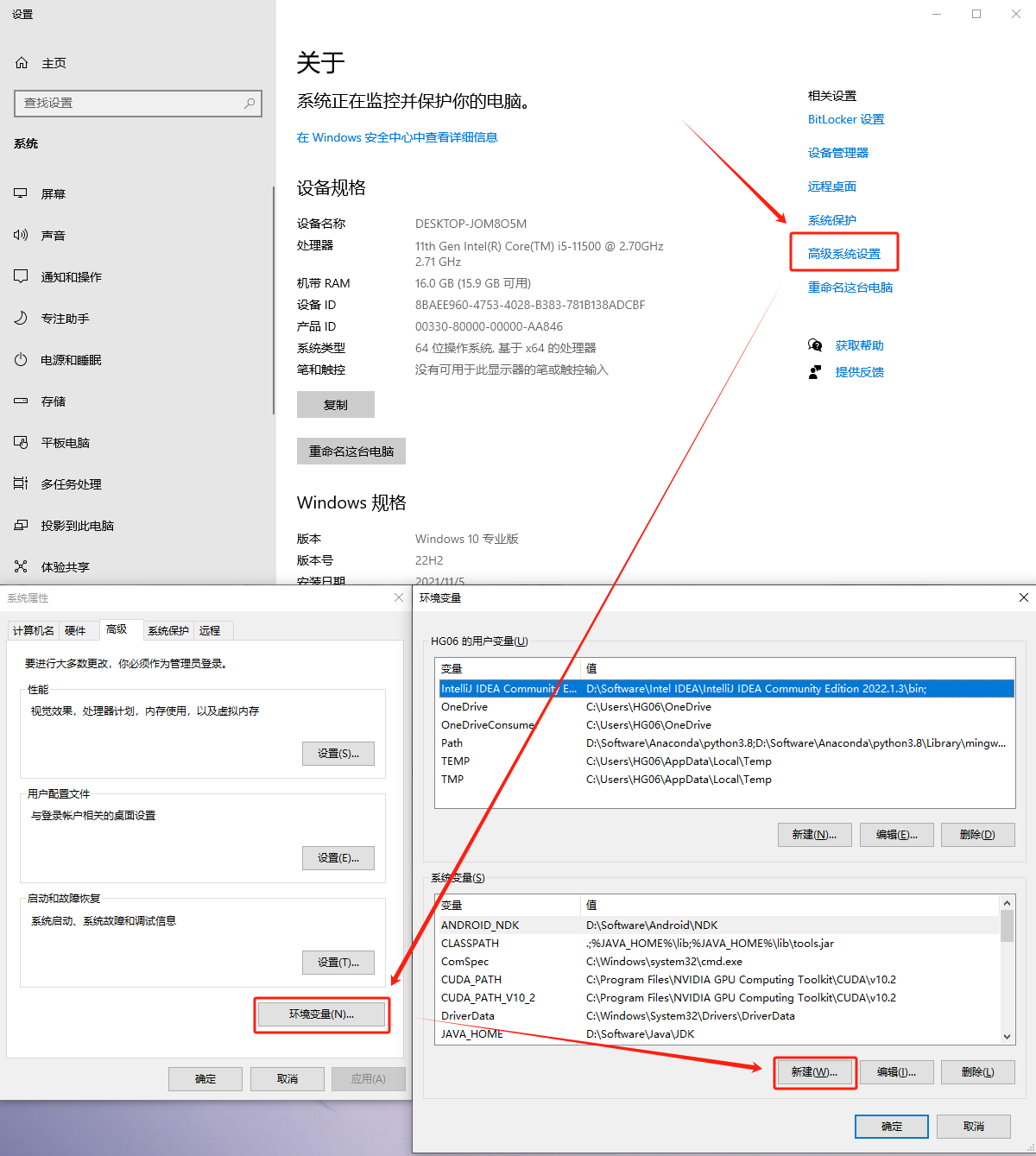

Ollama默认安装路径在C盘中,而安装的大模型少则几个G,大则上百G不等,如果放在C盘肯定是不合适的,所以在安装大模型之前,应该为Ollama指定模型的保存路径。

默认保存路径:C:\Users\<用户名>\.ollama\models

指定新的保存路径需要设置一个新的环境变量OLLAMA_MODELS。这个环境变量应该指向想要保存模型的新目录。

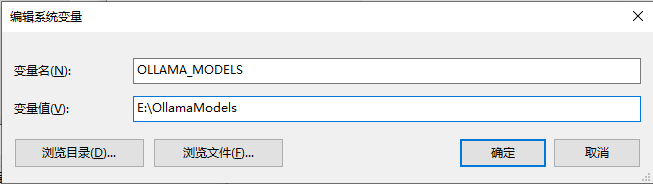

2.3.1 新增系统环境变量

右键点击“此电脑”或“计算机”,选择“属性”;点击“高级系统设置”,在弹出的窗口中点击“环境变量”按钮。在“系统变量”或“用户变量”部分,点击“新建”来创建一个新的环境变量。输入变量名OLLAMA_MODELS和你选择的目录路径(例如E:\OllamaModels)。

设置完环境变量后,需要重启Ollama或者重启电脑以使更改生效,为确保更改生效,建议重启电脑。

2.3.2 重启Ollama

- 结束Ollama。可能需要使用任务管理器(taskmgr.exe)来结束相关进程,并重新启动它。

- 启动Ollama。在命令提示符窗口中重启:输入 ollama serve 来启动Ollama服务。使用图形界面重启:安装过程中创建了Ollama的桌面图标或快捷方式,可以通过双击这些图标来尝试重启Ollama。

- 验证新路径。可以打开命令提示符(CMD),输入echo %ollama_models%来检查环境变量是否设置成功

- 检查日志文件。如果在重启过程中遇到问题,应该查阅Ollama的日志文件。这些文件通常可以在 %LOCALAPPDATA%\Ollama\ 目录中找到,其中 %LOCALAPPDATA% 是一个环境变量,通常指向用户的本地应用数据文件夹。

- 检查任务管理器。如果"Ollama"是一个服务或后台进程,可能需要检查任务管理器。按Ctrl + Shift + Esc打开任务管理器,转到“进程”标签(或Windows 10及更高版本的“详细信息”标签),找到与"Ollama"相关的进程,右键点击并选择“结束任务”。然后,按照上述步骤重新启动服务或应用。

2.3.3 默认路径的模型移动到指定的路径

默认情况下,Ollama的模型可能会下载到C:\Users\<用户名>\.ollama\models目录下,将这目录的子目录blobs内容剪切到指定的路径(比如,%OLLAMA_MODELS%\blobs)。

重新运行Ollama pull命令。

查看模型:ollama list,可见到移动的模型。

2.4 安装大模型

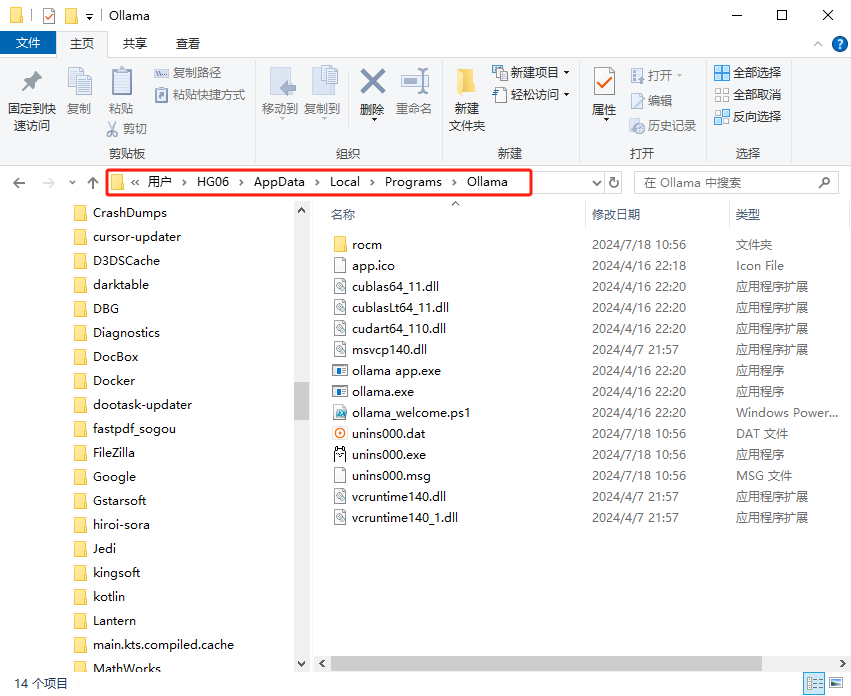

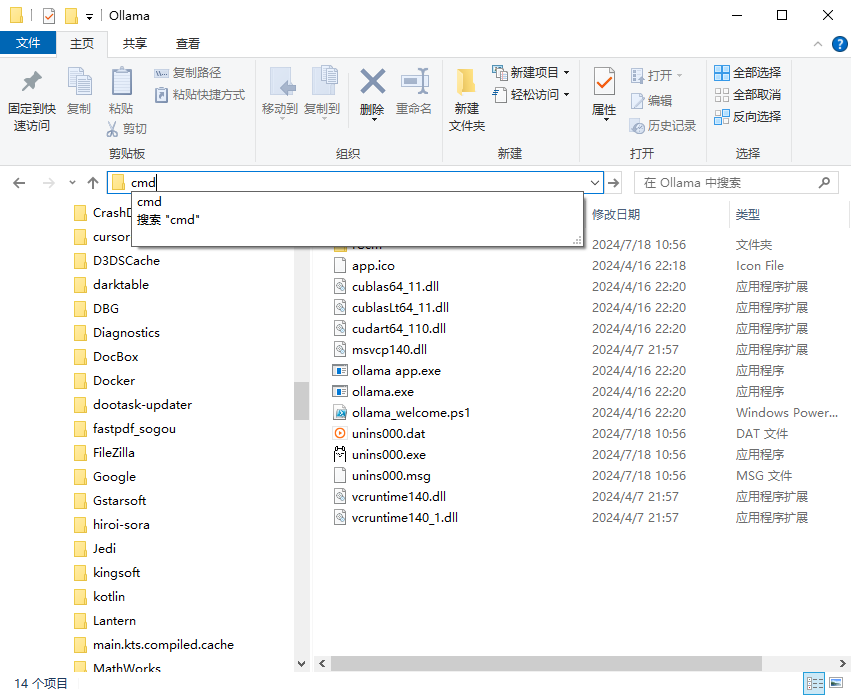

ollama默认安装路径为C:\Users\用户名\AppData\Local\Programs\Ollama,我们先进入到这个路径。

- 然后在地址栏输入

cmd后回车

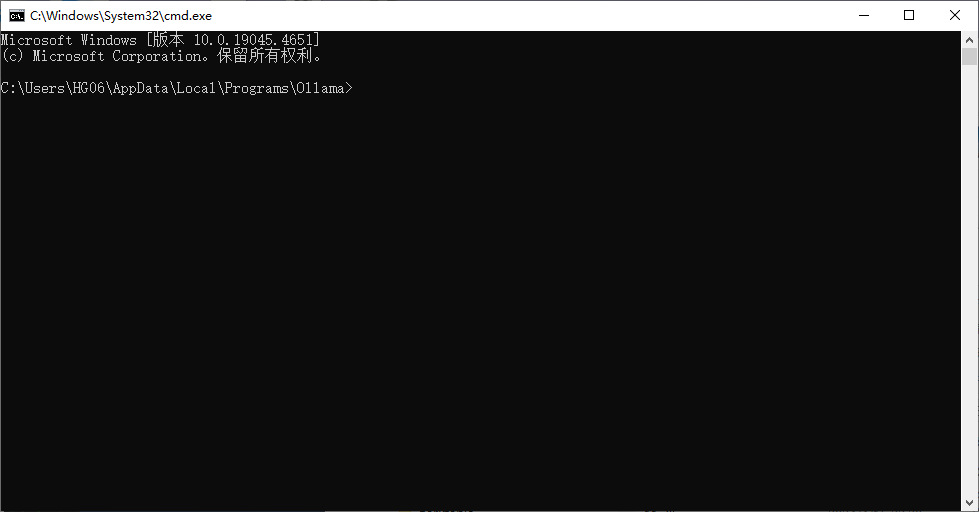

- 此时会打开一个命令终端黑框

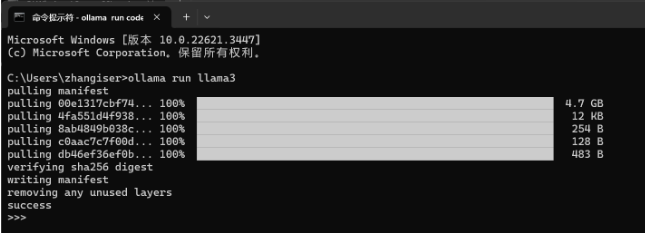

- 现在输入

ollama run llama3

3、WebUI安装

3.1 安装HyperV

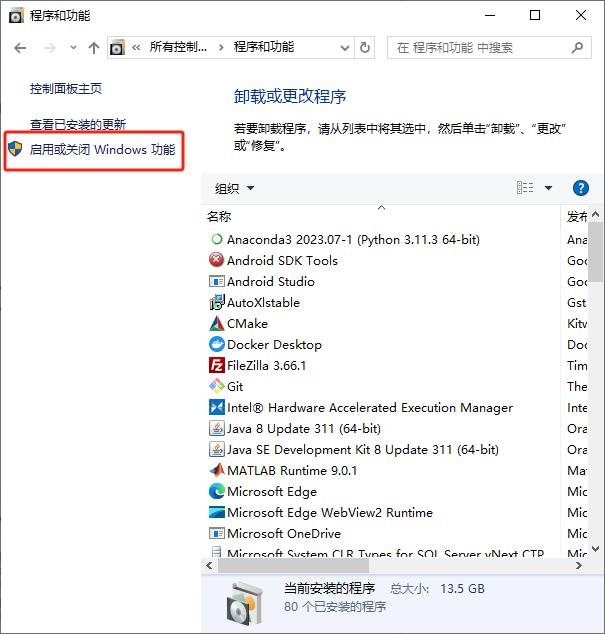

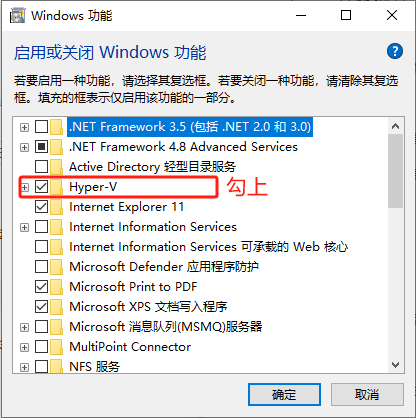

先根据以下操作路径看看自己电脑有没有HyperV安装选项:控制面板-程序-启用或关闭Windows功能-HyperV.

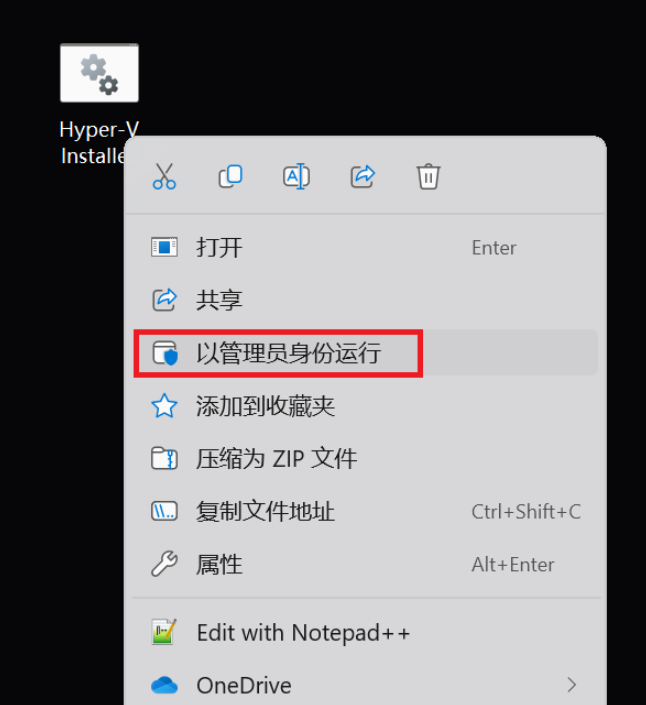

如果没有HyperV安装选项,则新建一个.txt文件,将以下内容拷贝进去,然后把文件后缀名改为.bat,右键以管理员权限运行即可。运行完毕后再次按照上面路径操作安装HyperV

- pushd "%~dp0"

- dir /b %SystemRoot%\servicing\Packages\*Hyper-V*.mum >hyper-v.txt

- for /f %%i in ('findstr /i . hyper-v.txt 2^>nul') do dism /online /norestart /add-package:"%SystemRoot%\servicing\Packages\%%i"

- del hyper-v.txt

- Dism /online /enable-feature /featurename:Microsoft-Hyper-V-All /LimitAccess /ALL

3.2 安装Docker

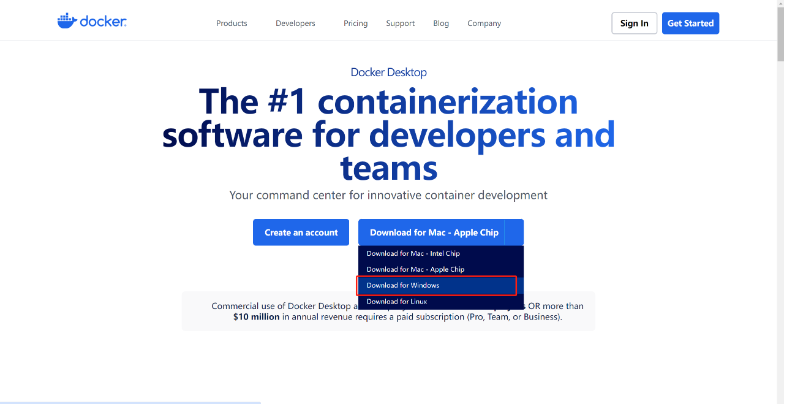

直接在Docker官网https://www.docker.com/products/docker-desktop/下载最新版本的Docker Desktop,我下载的是Docker Desktop4.28.0,其中包含的Docker的版本是25.0.3,Docker-Compose的版本是2.24.6。注意不要混淆Docker和Docker Desktop。如果是低版本的Docker Desktop,那就需要自己手动安装Docker-Compose了。

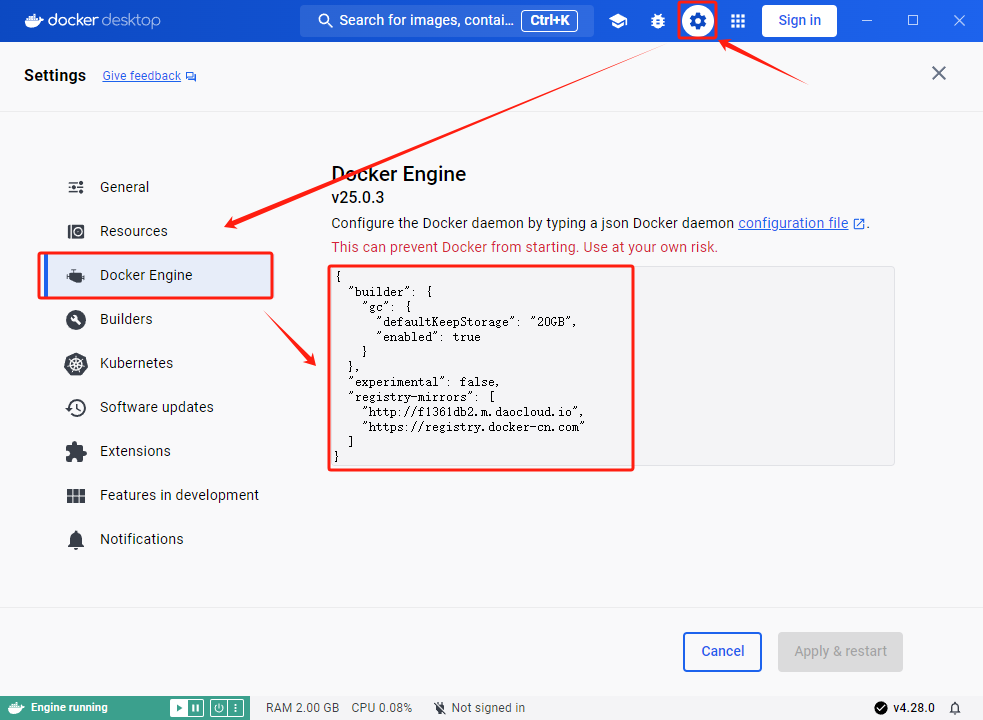

配置一下Docker访问中国镜像源

- {

- "builder": {

- "gc": {

- "defaultKeepStorage": "20GB",

- "enabled": true

- }

- },

- "experimental": false,

- "registry-mirrors": [

- "http://f1361db2.m.daocloud.io",

- "https://registry.docker-cn.com"

- ]

- }

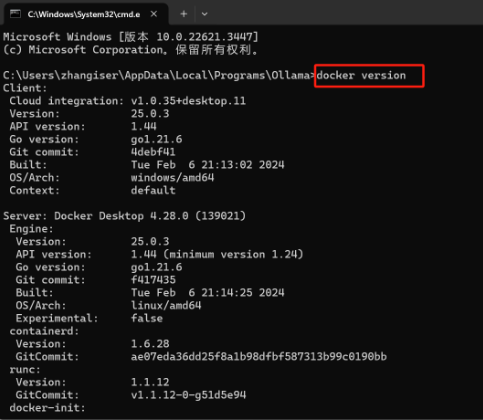

配置完毕之后在cmd输入docker version确认一下是否安装成功了。

3.3 安装聊天界面

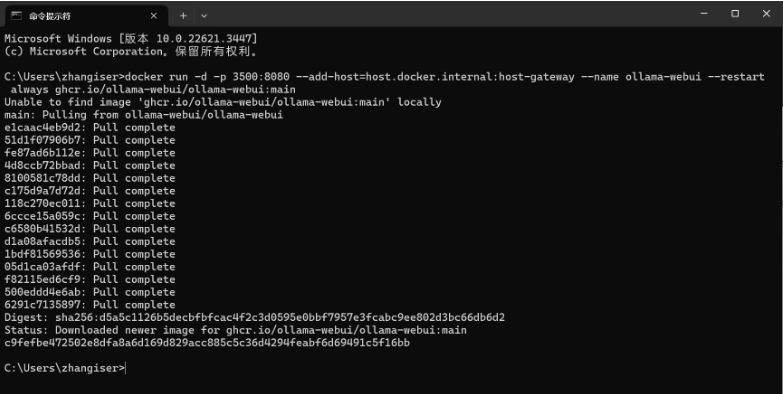

直接在cmd中运行以下命令,安装聊天界面

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

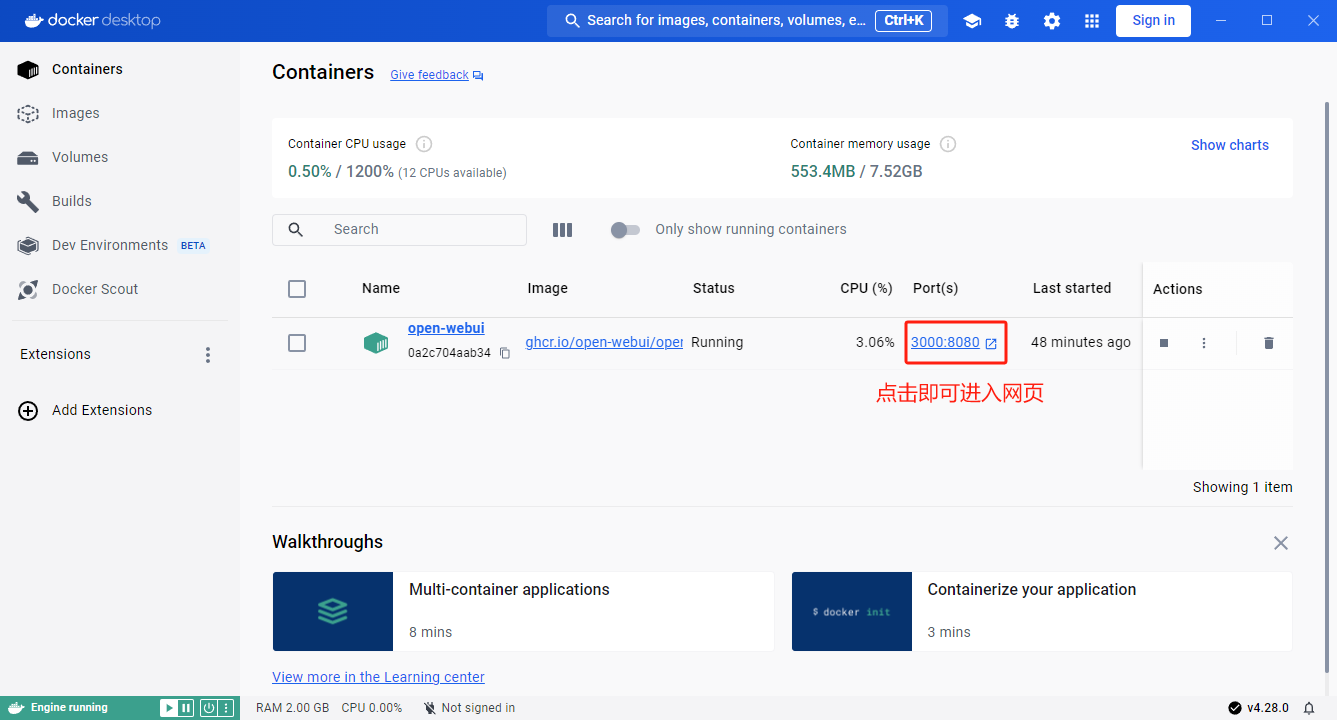

回到Docker界面看看是否已经在运行WebUI了,图标亮起就表示已经在运行了,点击后面的端口号就可以在浏览器中查看了。

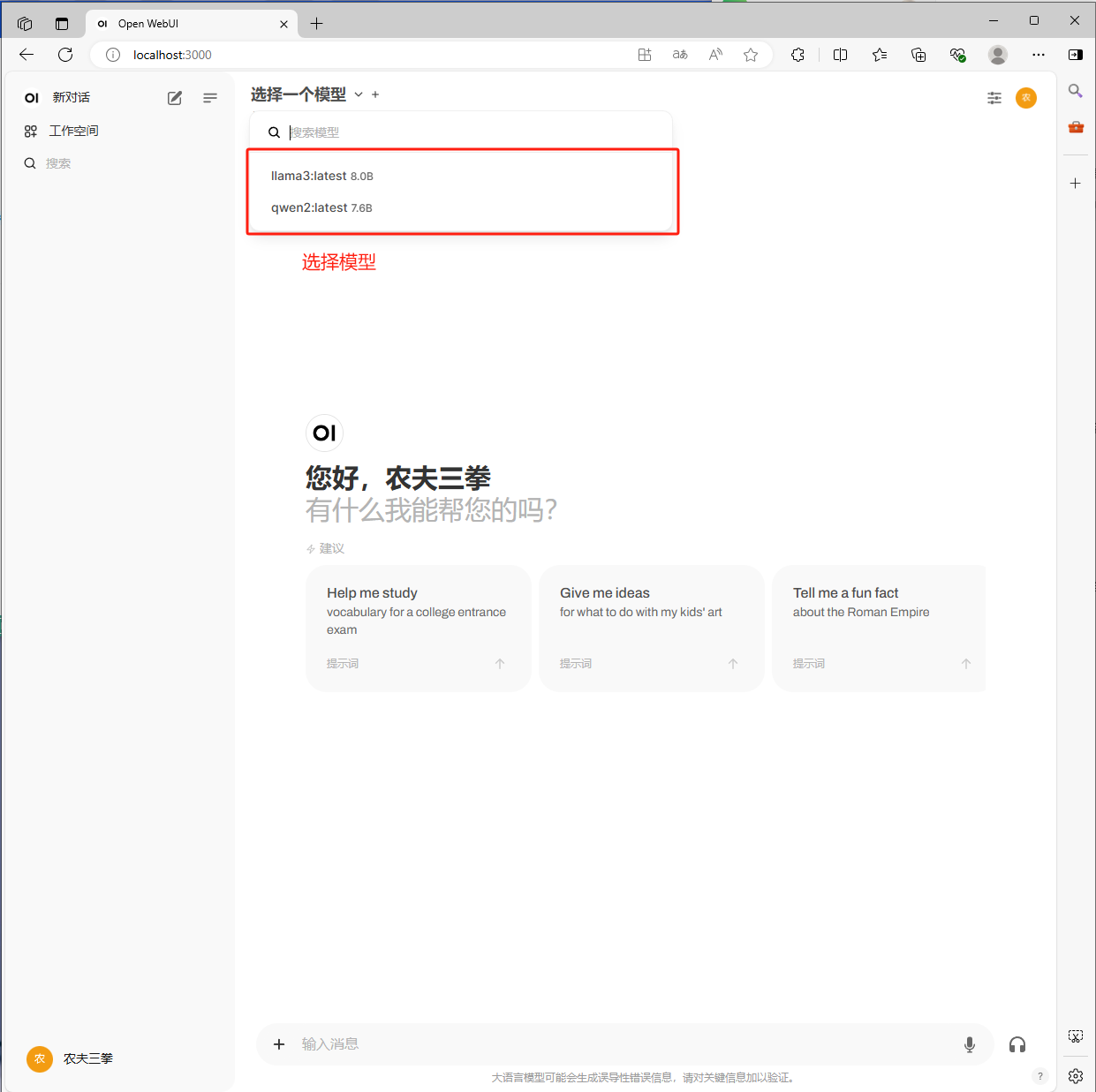

先注册,后登陆,然后选择模型,就可以开始聊天了。

4、日常使用

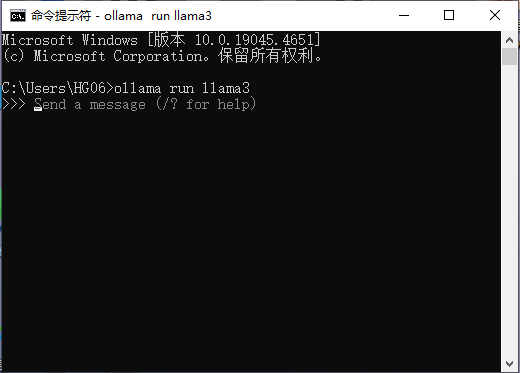

1、打开cmd命令终端,输入 ollama run llama3,运行llama3模型;

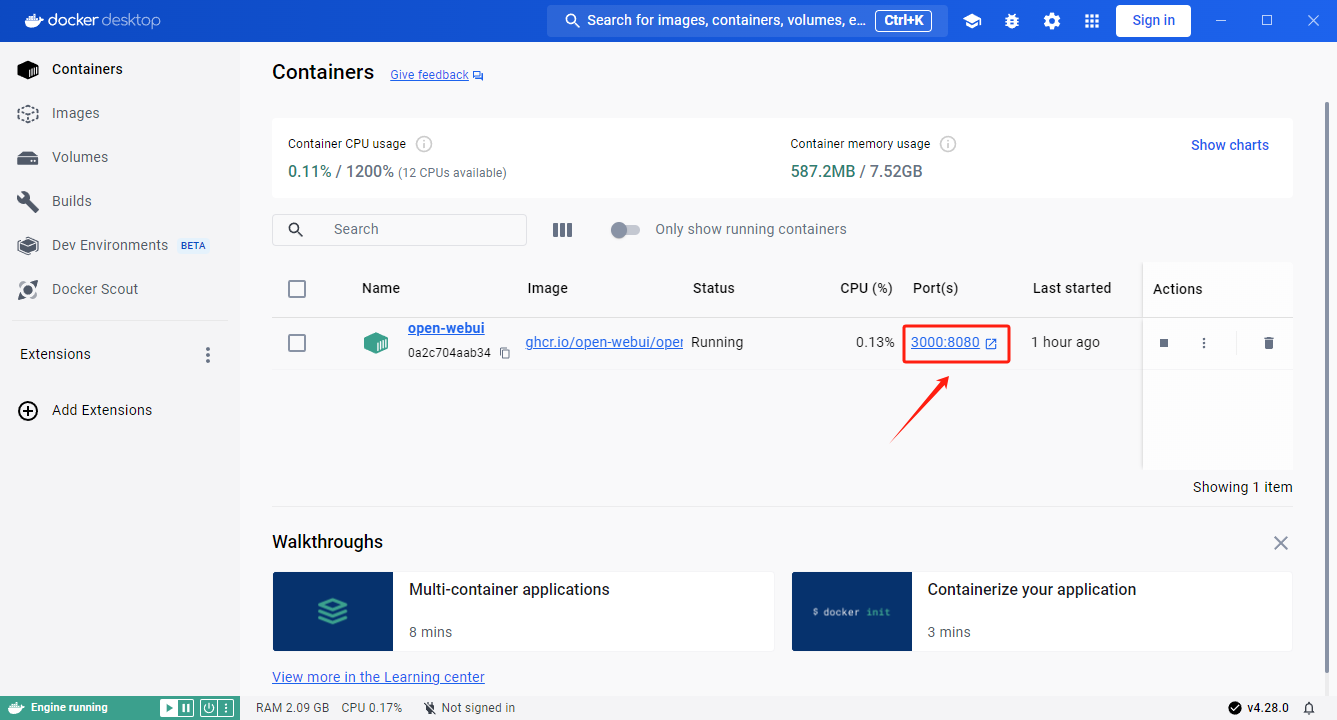

2、打开 Docker Desktop,再通过端口打开网页;

3、选择已经安装好的大模型;

4、接下来就可以正常使用了。