- 1[翻译]NIST CSF、ISO 27001/2、NIST 800-53与SCF安全框架比较_nist sp 800-53

- 2camera驱动_camera driver属于vendor还是system

- 3《中国数据库前世今生》观影——2000年代/数据库分型及国产数据库开端

- 4AD534TE/883B 一款精密IC乘法器/除法器

- 5第十四届蓝桥杯大赛B组真题_蓝桥杯pythonb组真题

- 6WebKit in Android Framework_android framework inflating

- 7Qt:玩转QPainter序列三

- 8Redisson常见问题_attempt to unlock lock, not locked by current thre

- 9matlab里的scalar,scalar_scalar与vector之间的区别

- 10非线性方程组数值求解算法——MATLAB源码_matlab二元非线性方程组数值求解法

面试考点——概率论篇_概率论面试

赞

踩

目录

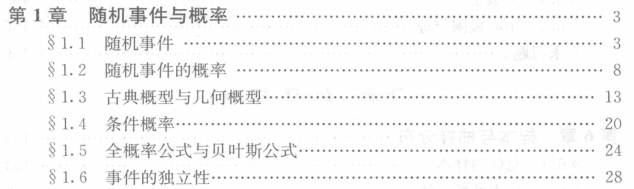

第1章:随机事件与概率

知识点:

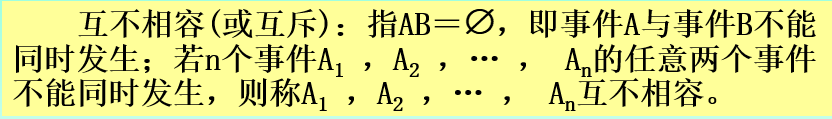

1)什么叫做互斥事件?

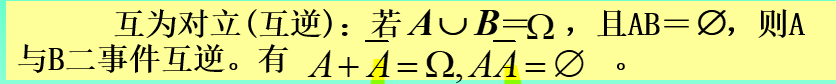

2)什么叫做对立事件?

3)互斥(互不相容)事件和对立(互逆)事件的区别在于?

两者都具备的属性是,AB两个事件不能同时发生,但是后者还有一个约束就是两者的并集等于所有情况。

4)频率和概率有什么联系?

大量实验证实,当重复试验的次数逐渐增大时,频率呈现出稳定性,逐渐稳定于某个常数。

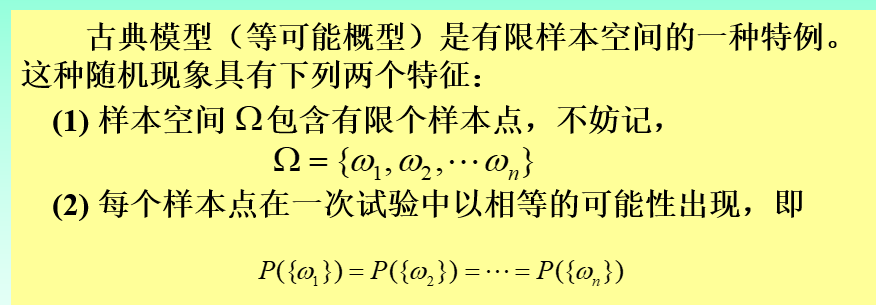

5)什么叫做古典概型

1.有限中情况

2.每种事件等概率发生

最经典的就是排列组合问题

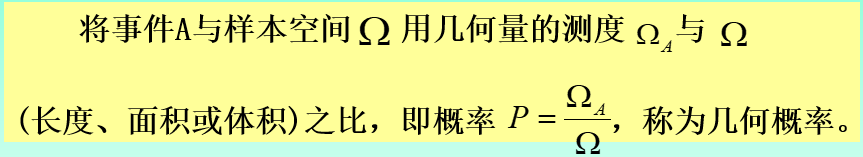

6)什么叫做几何概型

将事件发生的概率用几何形式表示,然后其与总事件(所有面积)之比即为该事件发生概率

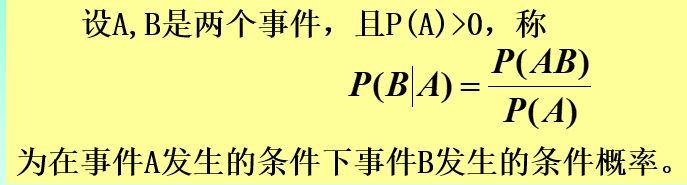

7)什么是条件概率?

例如在A发生条件下B发生的条件概率就等于A和B同时发生的条件/A发生的条件。

8)什么是全概率公式?全概率公式的含义是啥?

也就是如果一个样本空间可以由若干个事件所组成且之间是互斥的,那么A事件发生的概率就等于上述若干个事件中每个事件发生的概率与该事件发生导致A事件发生的概率乘积的和。

全概率公式的核心思想是“由因求果”。

9)什么是贝叶斯公式?含义是什么?

贝叶斯公式可以由全概率公式结合条件概率公式联合得到。

贝叶斯公式的核心思想是“由果求因”。

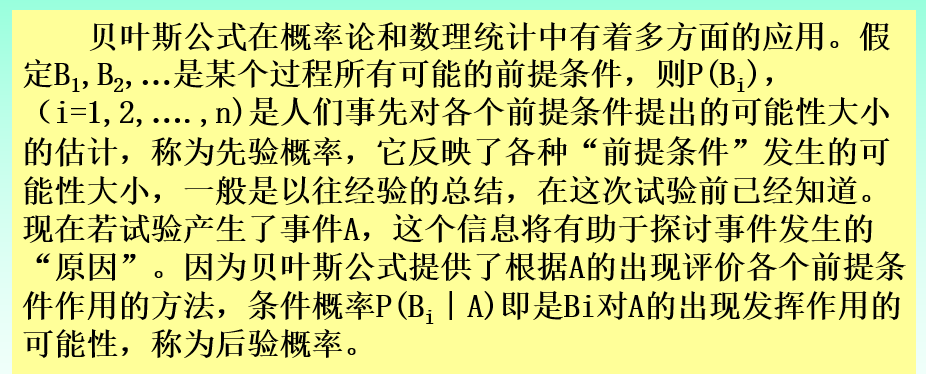

10)什么是先验概率?什么是后验概率?

简单来讲就是根据以往经验所总结出的概率为先验概率;

如果现在发生了事件A,我们可以根据结果去推测发生的事件,那么相应得到的Bi发生的条件概率就是后验概率。

面试题:

1)随机变量和普通变量的区别。

随机变量的取值是随时无规则变化的,随机变量的值不能预知,具有不确定性。

而普通变量在确定条件下值是确定的。

2)贝叶斯公式是用来干嘛的?

贝叶斯公式解决的是一些原因X无法直接观测、测量,而我们希望通过其结果Y来反推出原因X的问题。也即有因求果

3)独立与不相关的联系和区别?

独立是指变量之间完全没有关系,但是不相关则仅要求变量之间没有线性关系,因而独立的要求更高,独立的变量一定是不相关的,但是不相关的不一定是独立的,即独立是不相关的充分不必要条件

4)机器学习里面为什么有概率?

事件的概率是衡量事件发生可能性的度量,虽然在一次试验中某个事件的发生是带有偶然性的,但那些可在相同条件下重复的随机试验却往往呈现明显的数量规律。

机器学习就是创造这种条件,在新的实验到来时候,会产生相同的事件。

5)古典概型和几何概型的区别。

- 古典概型——有限等可能(有限个可能事件,且每个事件都是等可能概率事件)

- 几何概型——无限等可能

6)后验概率和先验概率的联系

后验概率的计算,是以先验概率为前提条件的。如果只知道事情结果,而不知道先验概率(没有以往数据统计),是无法计算后验概率的。

后验概率的计算需要应用到贝叶斯公式。

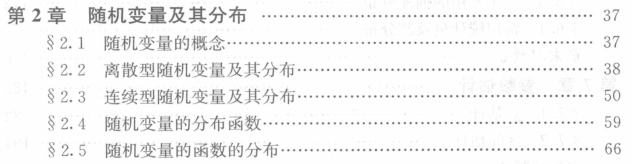

第2章:随机变量及其分布

知识点:

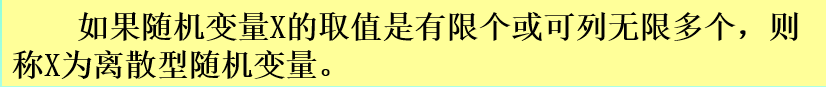

1)什么是离散型随机变量?

2)常见的离散型随机变量及其分布有哪些?

1)0-1变量及其分布(也称为两点分布)(只有两个可能取值,0和1)

2)二项变量及其分布(在0-1分布的基础上,每个事件要么发生,要么不发生,也就是N重伯努利试验)

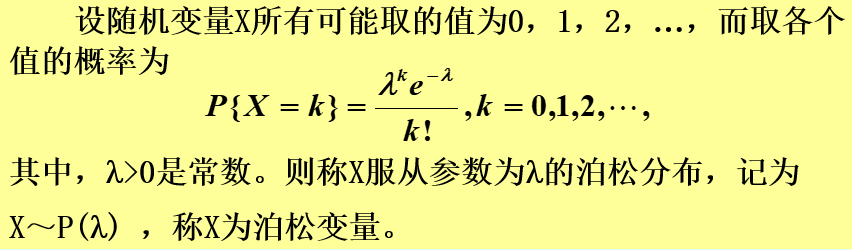

3)泊松变量及其分布(事件X发生的概率符合泊松分布就称为泊松变量)

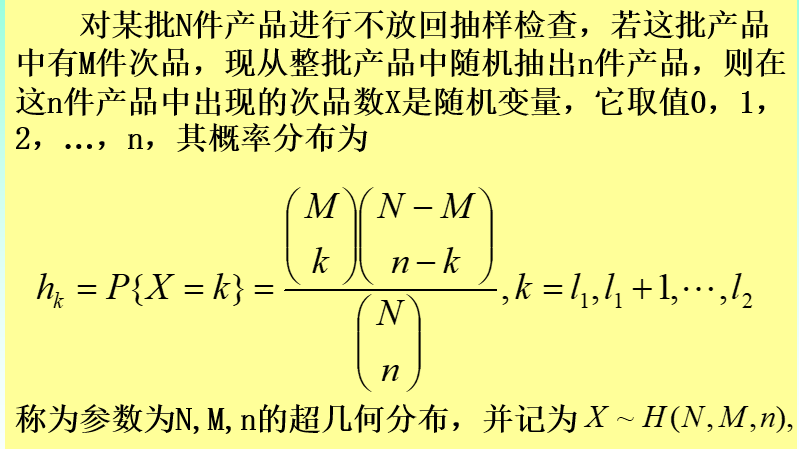

4)超几何变量及其分布(一般用于不放回抽样检查)

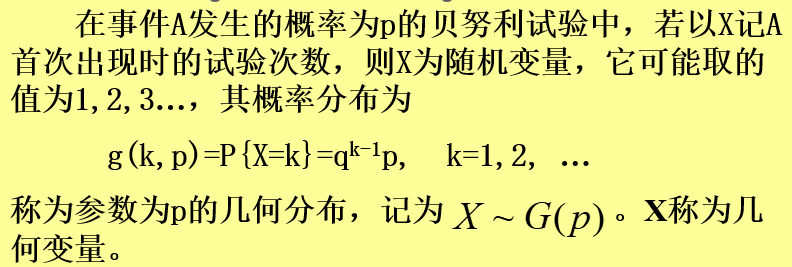

5)几何变量及其分布

几何分布具备无记忆性

3)什么是连续型随机变量?

若某个事件发生的概率为根据密度函数积分得到的概率,则为连续性随机变量。

4)常见的连续型随机变量及其分布

有不同的分布是因为密度函数不同罢了

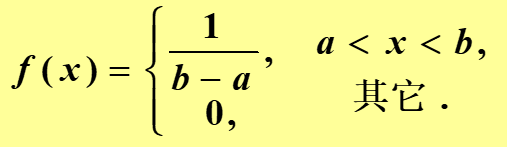

1)均匀变量及其分布:

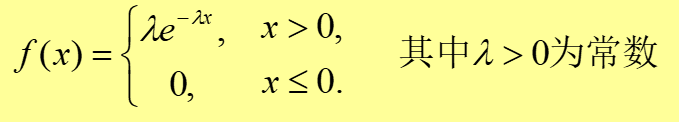

2)指数变量及其分布:

指数分布具备无记忆性

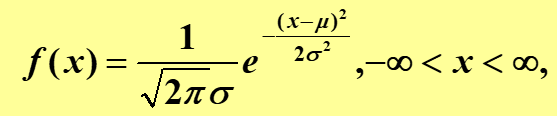

3)正态分布与标准正态分布

正态分布是概率论中最重要的分布,因为正态分布符合对称性,自然世界和社会世界中的大部分事件或者说现象都满足正态分布。

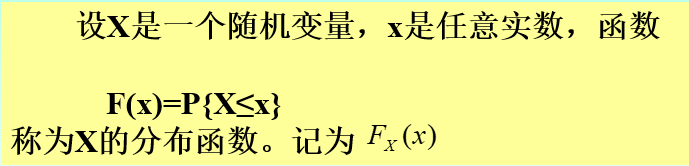

5)什么是随机变量的分布函数?

离散型就是简单的相加;

连续型就是对分布函数进行积分(积分区间的左端点固定,右端点从左向右不断移动);

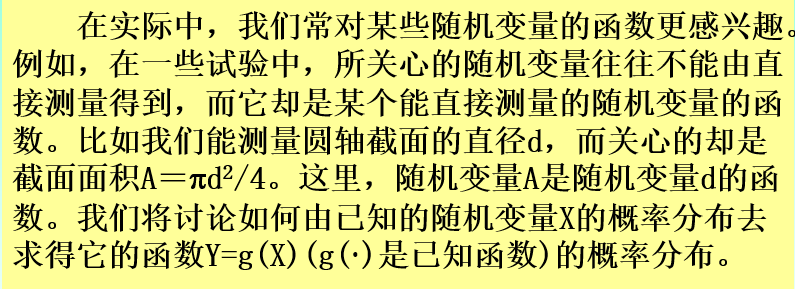

6)什么是随机变量的分布函数的分布?

离散型和连续型有不同的求法,连续型有两种求法。

面试题:

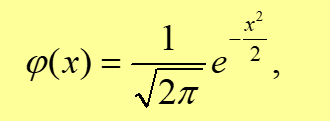

1)什么叫做标准正态分布?

符合期望值为0,标准差为1的分布。

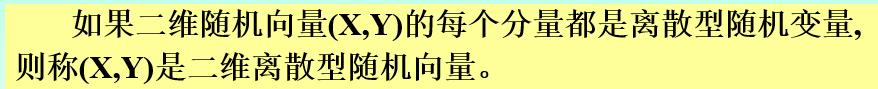

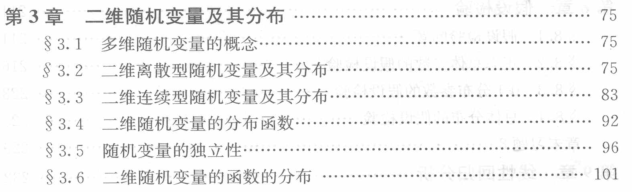

第3章:二维随机变量及其分布

知识点:

1)什么是二维离散型随机变量分布?

放在分布律上其实就是X,Y同时发生的概率。

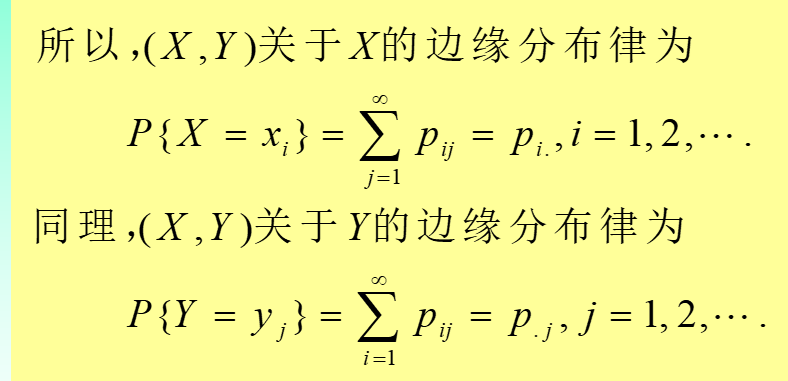

2)什么是二维离散型随机变量的边缘分布?

简单来讲就是分布律中某一行某一列加起来得到的值

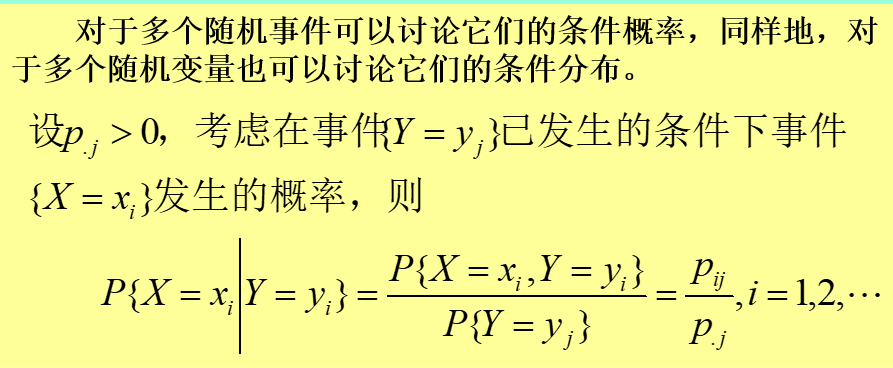

3) 什么是二维离散型随机变量的条件分布?

计算公式中用到了边缘分布

4)什么是二维连续性随机变量的分布?

实质就是二重积分。

5)什么是二维连续性随机变量的边缘分布?

变为一重积分了,积分对象只有一个

6)什么是二维连续性随机变量的条件分布?

和之前一样,也是用到了边缘分布。

7)常见的二维连续性随机变量 有哪些?

二维均匀变量及其分布;

二维正态变量及其分布。

8)什么是二维随机变量的分布函数?

和之前类似,只不过是把一维变为二维。其余的边缘和条件不再赘述

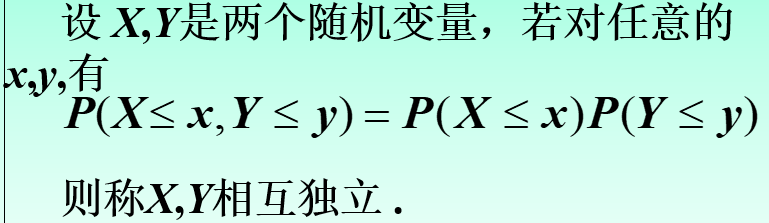

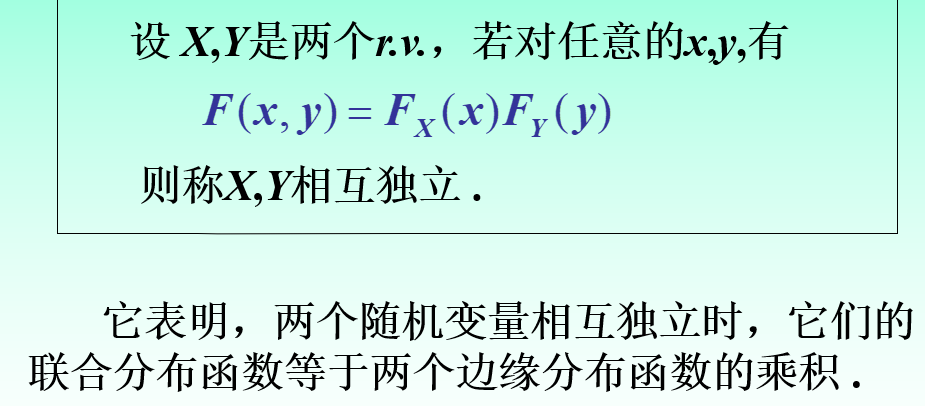

9)随机变量的独立性指的是什么?

随机变量若相互独立,则有如下性质:

面试题:

1)联合概率和边缘概率 是什么?

联合概率指的是包含多个条件且所有条件同时成立的概率,记作P(X=a,Y=b)或P(a,b)。

边缘概率是与联合概率对应的,P(X=a)或P(Y=b),这类仅与单个随机变量有关的概率称为边缘概率。

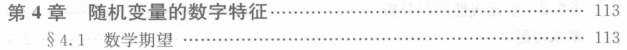

第4章:随机变量的数字特征

知识点:

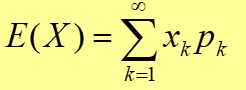

1)离散型随机变量的数学期望

每个事件发生的概率*事件所代表的值

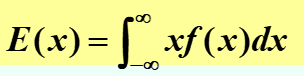

2)连续型随机变量的数学期望

不同之处在于被积分的函数中包括了x

3)离散型和连续型变量的标准差(方差)

方差刻划了随机变量的取值相对于其数学期望(均值)的分散程度

标准差就是方差的开根号

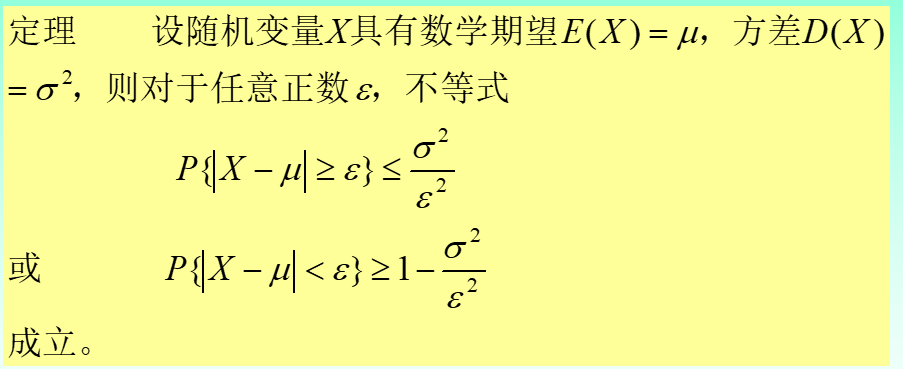

4)什么是切比雪夫不等式,有何用途?

切比雪夫不等式可以使我们在随机变量X的分布未知的情况下,对事件|X-m|<e的概率做出估计。应用切比雪夫不等式必须满足E(X)和D(X)存在且有限这一条件。

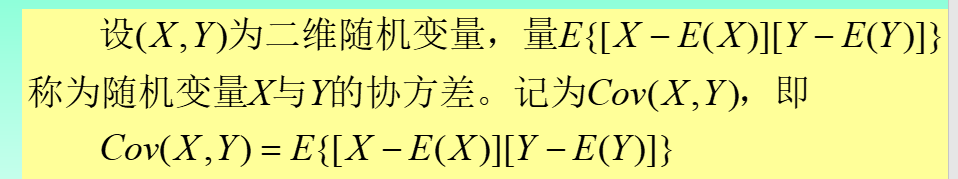

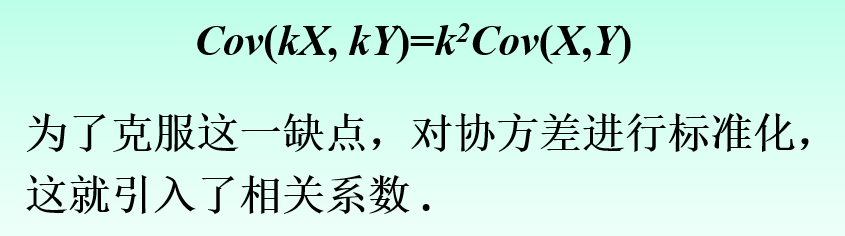

5)什么是协方差?

协方差的大小在一定程度上反映了X和Y相互间的关系,但它还受X与Y本身度量单位的影响

方差是协方差的一种,不过协方差更多的是表示两个变量的变化趋势是否一致。也就是说如果其中一个大于自身的期望值,另外一个也大于自身的期望值,那么两个变量之间的协方差就是正值。 如果两个变量的变化趋势相反,即其中一个大于自身的期望值,另外一个却小于自身的期望值,那么两个变量之间的协方差就是负值。

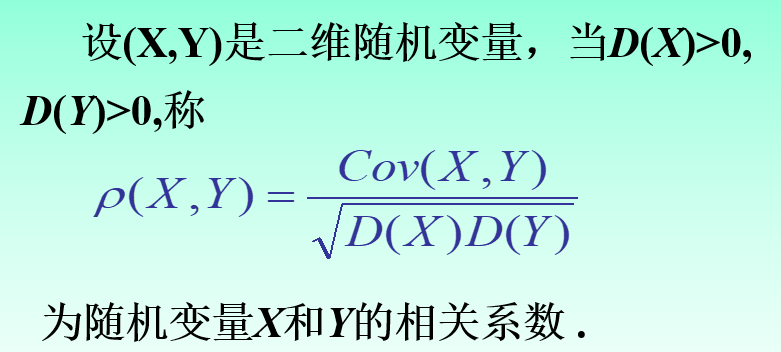

6)什么是相关系数?

相关系数就是X与Y的相关性;若X,Y独立,则相关系数为0,相关系数的范围为[-1,1]之间

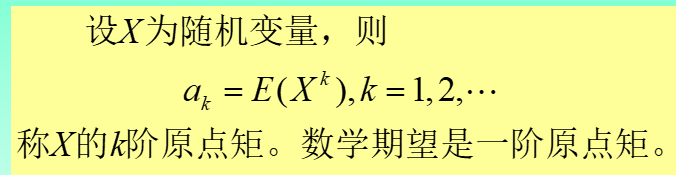

7)什么是矩?

面试题:

1)相关系数或协方差为0的时候能否说明两个分布无关?为什么?

只能说明不线性相关,不能说明无关。因为在数学期望存在的情况下,独立必不相关,不相关未必独立。

第5章:大数定理与中心极限定理

知识点:

1)什么是大数定理?有哪几种?

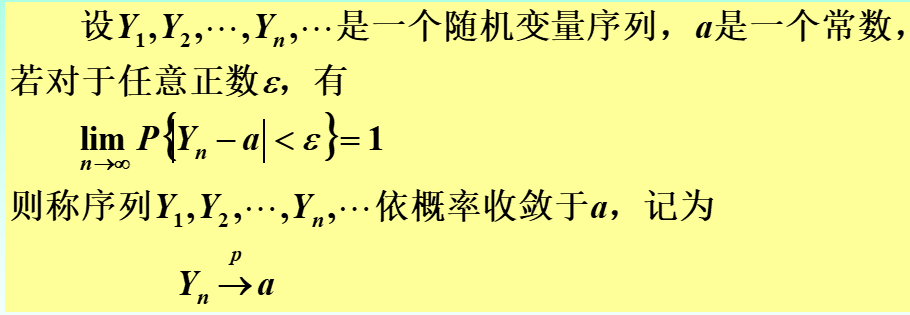

大数定理的实质是依概率收敛,是用来描述随机事件的长期稳定性。

在大样本情况下,样本平均值可以作为总体期望值的估计,这在抽样调查和统计分析中尤为重要。

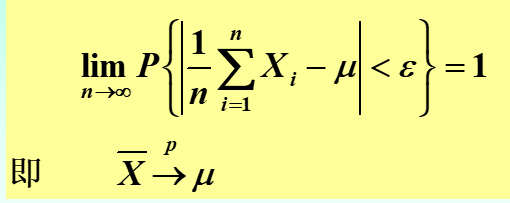

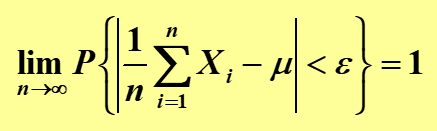

1)切比雪夫大数定理(X序列的平均值收敛于某个值)

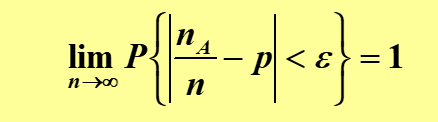

2)伯努利大数定理(A发生的频率依概率收敛于A的概率)

3)辛钦定理(和切比雪夫类似,不同之处在于没有要求随机变量的方差的存在)

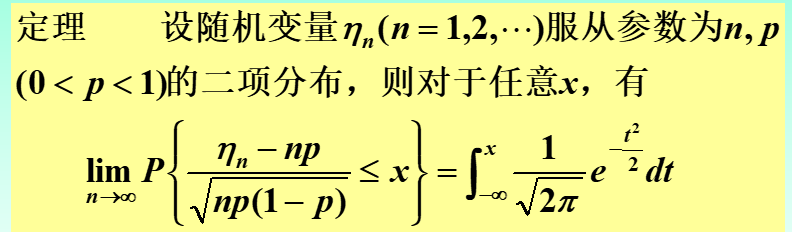

2)什么是中心极限定理?有哪几种?

中心极限定理描述了在某些条件下,独立同分布随机变量的和(或平均值)的分布趋近于正态分布的性质。

具体来说,当样本量足够大时,即使单个随机变量本身不是正态分布的,它们的和或平均值的分布也会近似于正态分布。

3)大数定理和中心极限定理的区别?

我们以抛掷硬币作为例子:

- 大数定理:告诉我们样本均值会趋近于总体期望值。例如,掷硬币次数足够多时,正面出现的比例会接近0.5。

- 中心极限定理:告诉我们样本和的标准化形式会趋近于正态分布。例如,掷硬币次数足够多时,正面出现次数的标准化分布会接近正态分布。

通过这个掷硬币的例子,我们可以更直观地理解大数定理和中心极限定理的区别。大数定理关注的是“结果的平均值”,而中心极限定理关注的是“结果的分布形式”。

面试题:

第6章:样本与抽样分布

知识点:

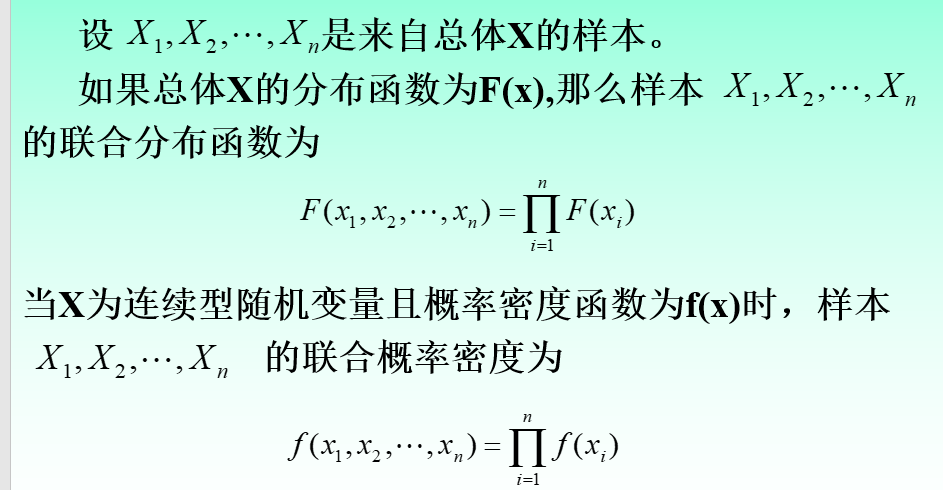

1)什么是样本的联合分布?

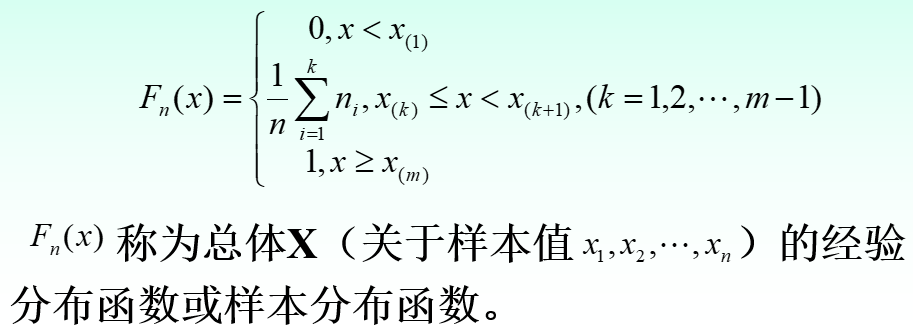

2)什么是经验分布函数?

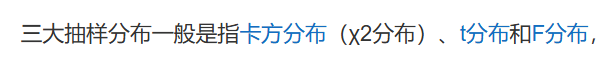

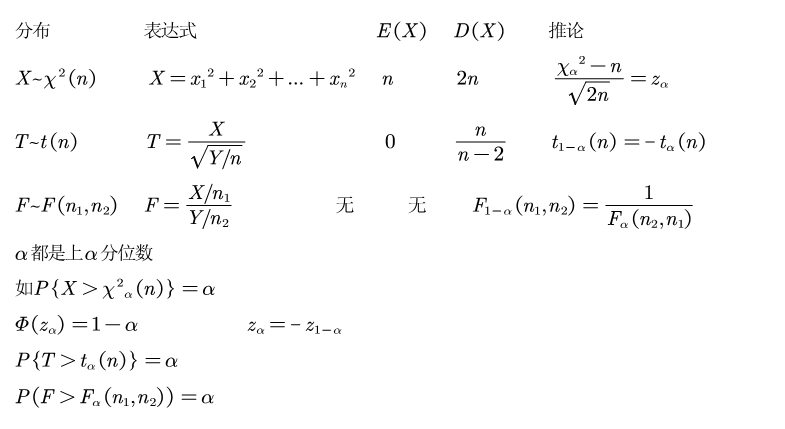

3)3大抽样分布是什么?

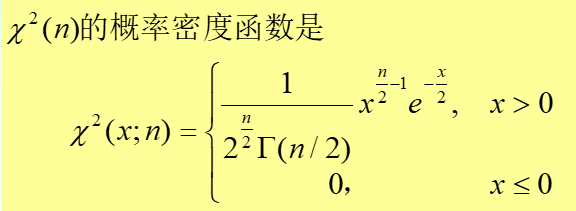

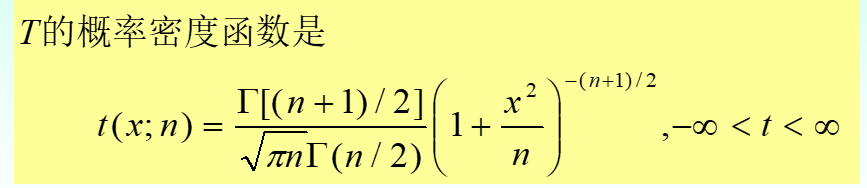

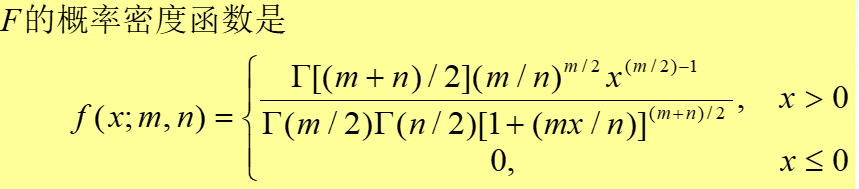

三者的概率密度函数不同

1)卡方分布:

2)t分布

3)F分布

面试题:

第7章:参数估计

知识点:

1)参数估计包含哪两种问题?

点估计

区间估计

2)用于点估计的方法有哪些?

点估计是统计学中用于估计总体参数(如均值、方差等)的方法。

1)矩估计法

- 计算样本的样本矩(如样本均值、样本方差等)。

- 设定总体矩的表达式并将样本矩代入,求解总体参数。

2)极大似然估计法

- 写出样本数据的似然函数,即数据出现的联合概率密度函数。

- 取对数得到对数似然函数,以便于求导。

- 对对数似然函数求导并求解,使得导数为零的参数值即为极大似然估计值。

两者的区别:

矩估计法:通过样本矩来估计总体参数。例如,利用样本均值和样本方差来估计总体均值和总体方差。

极大似然估计法:通过最大化样本数据的似然函数来估计总体参数。例如,通过最大化硬币正面出现次数的概率来估计硬币正面出现的概率。

3)用区间估计的方法有哪些?

不同情况有不同的计算公式

1)单个正态总体均值与方差的置信区间

2)两个正态总体均值差与方差比的置信区间

面试题:

第8章:假设检验

知识点:

1)假设检验包含哪2种情况?

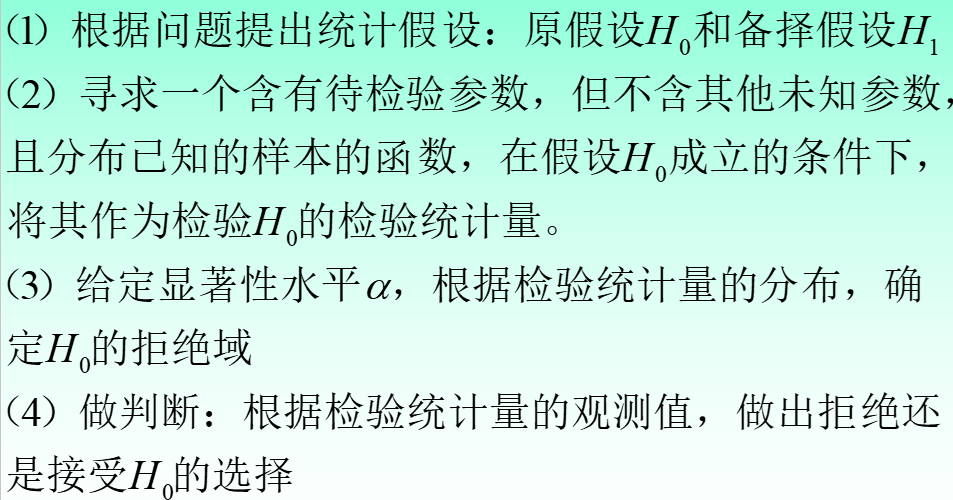

2)假设检验的步骤包括什么?

面试题:

1)什么是假设检验,最常用的方法是啥?

是用来判断样本与样本、样本与总体的差异是由抽样误差引起还是本质差别造成的统计推断方法。显著性检验是假设检验中最常用的一种方法

第9章:线性回归分析

知识点:

NEU没教,先不写。

面试题:

第10章:方差分析

知识点:

NEU没教,先不写。