- 1数据库实验八 触发器实验_请编写触发器在每一次删除商品信息表(goodsinfo)的记录时在输出窗口输出“删除{商

- 2MIMO中的迫零算法

- 3失业之后如何调整自己,才能摆脱迷茫期?

- 4介绍一个生成流程图工具—解放生产力_ai生成流程图

- 5【模型详解】从注意力机制到VIT到DETR,万字长文详解_vit多头注意力机制细节

- 6pagerank算法_PageRank 及衍生

- 7org.springframework.dao.DataRetrievalFailureException数据检索失败的解决方法,亲测有效,已解决,嘿嘿嘿_method threw 'org.springframework.dao.dataretrieva

- 8python爬虫入门教程(非常详细),超级简单的Python爬虫教程_python 爬虫教程

- 9AI短视频制作一本通:文本生成视频、图片生成视频、视频生成视频_怎样用文档图片自动ai合成视频

- 10ZooKeeper 基本介绍

一张顶20张H100!首款大模型专用ASIC挑战英伟达,哈佛辍学华人参与创办

赞

踩

梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

首款大模型推理专用ASIC芯片问世,一上来就要挑战英伟达——

一张顶20张H100

700亿参数Llama 3吞吐量达到每秒500000(五十万)tokens

比英伟达下一代芯片GB200快一个数量级,还更便宜

Sohu芯片,来自初创公司Etched,一经推出就引起业界墙裂关注。

作为专用集成电路ASIC,与通用计算的GPU不同,它只支持Transformer一种算法,无法运行同为神经网络的CNN、LSTM、以及Mamba等状态空间模型。

Etched公司也刚刚完成1.2亿美元A轮融资(约8.7亿元人民币),Peter Thiel、GitHub现任CEO Thomas Dohmke等重量级天使投资人参与。公司还透露,已有某客户预定了价值数千万美元的硬件产品。

今天的每个SOTA模型都基于Transformer,ChatGPT、Sora、Gemini、Stable Diffusion 3等。

假如有一天Transformer被SSM、RWKV或任何新架构取代,我们的芯片将毫无价值。

但如果我们是对的,Sohu将改变世界。

对此,Mamba作者Tri Dao也感叹:

这是一场豪赌,不过大模型推理需求正盛,所以可能是正确的入场时机。

有网友一算,人平均每天说1.8万个单词,那Sohu芯片一秒内就能生成21个人一天说的所有话,感觉太虚幻了。

(但实际上每秒500000tokens吞吐量包含输入和输出,不是纯生成这么多)

那么Sohu能威胁到英伟达的地位么?

考虑到Sohu更适合推理而不是训练,对于其他注重AI推理的芯片如Groq和SambaNova更是一种挑战,而不是威胁英伟达。

实在不行,老黄也可以使用钞能力把整个Etched买下来嘛(手动狗头)。

把Transformer烧录到芯片里

ASIC全称是应用专用集成电路(Application-Specific Integrated Circuit),相当于把某种特定的程序“硬件化”。并且只为一种任务优化,去掉不必要的功能,以达到比通用芯片更快并且功耗更低的目的。

如比特币后期,矿工们就抛弃了GPU,使用挖矿专用ASIC芯片能带来更多的利润。又或者手机里的视频解码芯片,通常也是一种ASIC。

具体到Sohu,就相当于把Transformer网络架构“烧录”到芯片里,公司名称Etched也是取自“蚀刻”的意思。

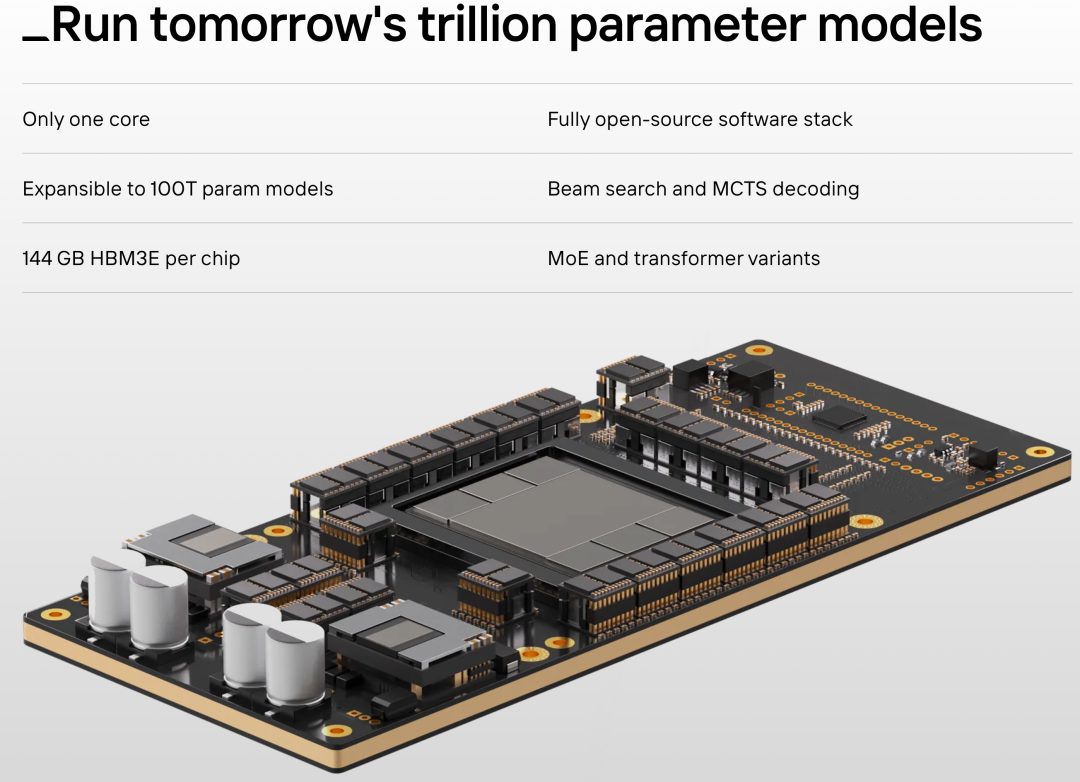

Sohu由台积电4nm工艺制造,只有1个核心,每张芯片配有144GB HBM3E高带宽内存。

一张芯片最高能支持100万亿参数大模型(现在根本还没有这么大的),支持MoE架构和各种Transformer变体,支持束搜索和蒙特卡洛树搜索解码。

基本上今天主流大模型需要的支持都考虑到了。

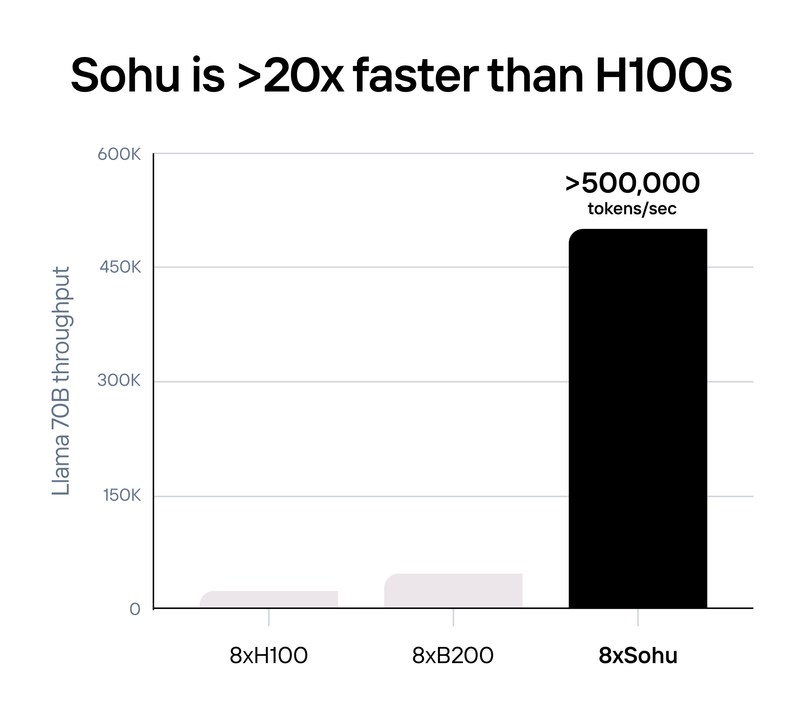

在Etched自己给出的测试结果中,Sohu比推理Llama-3 70B比H100快20倍以上,

具体设置如下:

FP8精度的Llama-3 70B,无稀疏性,8倍模型并行,2048输入长度/128输出长度

使用TensorRT-LLM 0.10.08(最新版本)评估H100性能,B200的数字是估计的

Etched团队表示,H100有800亿个晶体管,却只有3.3%用于矩阵乘法,这种大模型推理时最常见的运算。

只支持Tranformer的Sohu芯片FLOPS有效利用率超过90%(GPU大约是30%),无需用低精度量化或稀疏性等降低推理成本,同时也在一定程度上削弱模型能力的方法了。

让AI模型快了20倍、同时更便宜,能带来哪些改变?

Etched团队列举了今天SOTA模型的几个痛点:

Gemini需要60秒才能回答与视频有关的问题

编程智能体的成本还高于人类软件工程师

视频生成模型每秒约生成一帧

同时它们也给出了3个应用场景参考:

实时语音客服,几毫秒理解几千字并给出回复。

具体场景是饭店顾客问还需要等多长时间才有座位,AI查询系统中每桌预定情况数据后,计算出还要等45分钟,并引导用户预定位置。

代码场景,使用树搜索算法并行比较几百个方案,选择最好的。

文本生成,也能更好地利用投机解码提高生成的质量和速度。

目前Sohu开发者云已开启抢先体验申请,在实际场景中能取得什么样的效果,量子位将持续关注。

两哈佛辍学生创办

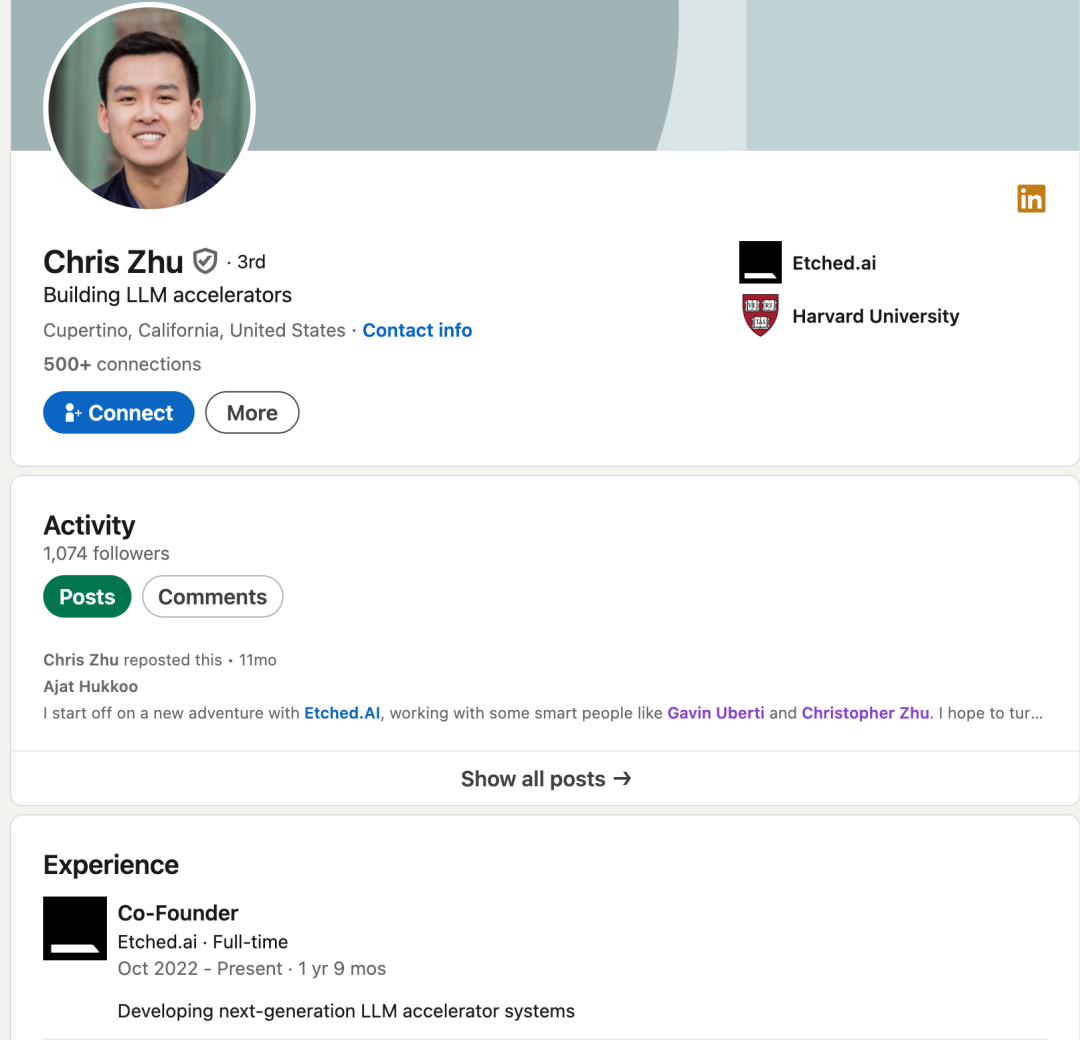

Etched公司成立仅两年,由两位哈佛辍学生Gavin Uberti和Chris Zhu创办。

两人声称在2022年就赌Transformer将改变世界。领英资料也显示公司创立时间在2022年10月,比ChatGPT问世还早一个月。

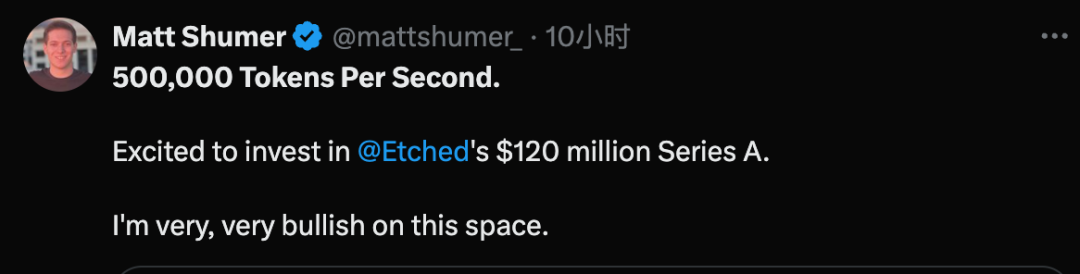

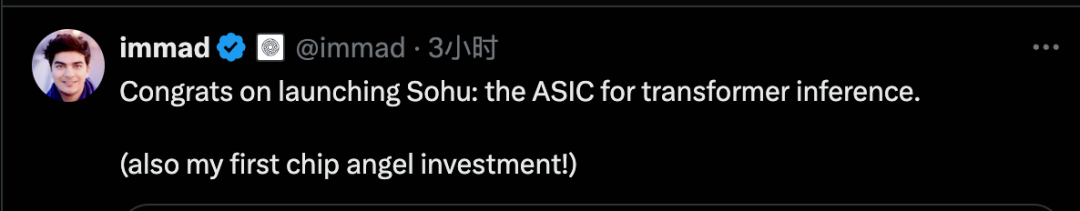

Etched刚刚完成1.2亿美元的A轮融资,由Primary Venture Partners和Positive Sum Ventures共同领投,主要投资人还包括Peter Thiel、GitHub首席执行官Thomas Dohmke、Cruise联合创始人Kyle Vogt和Quora联合创始人Charlie Cheever。

除了这些大咖之外,我们发现也有不少AI初创公司创始人投资了Etched后激情“晒单”。

投资者中的不少人都认同Transformer专用芯片是不可避免的新趋势。

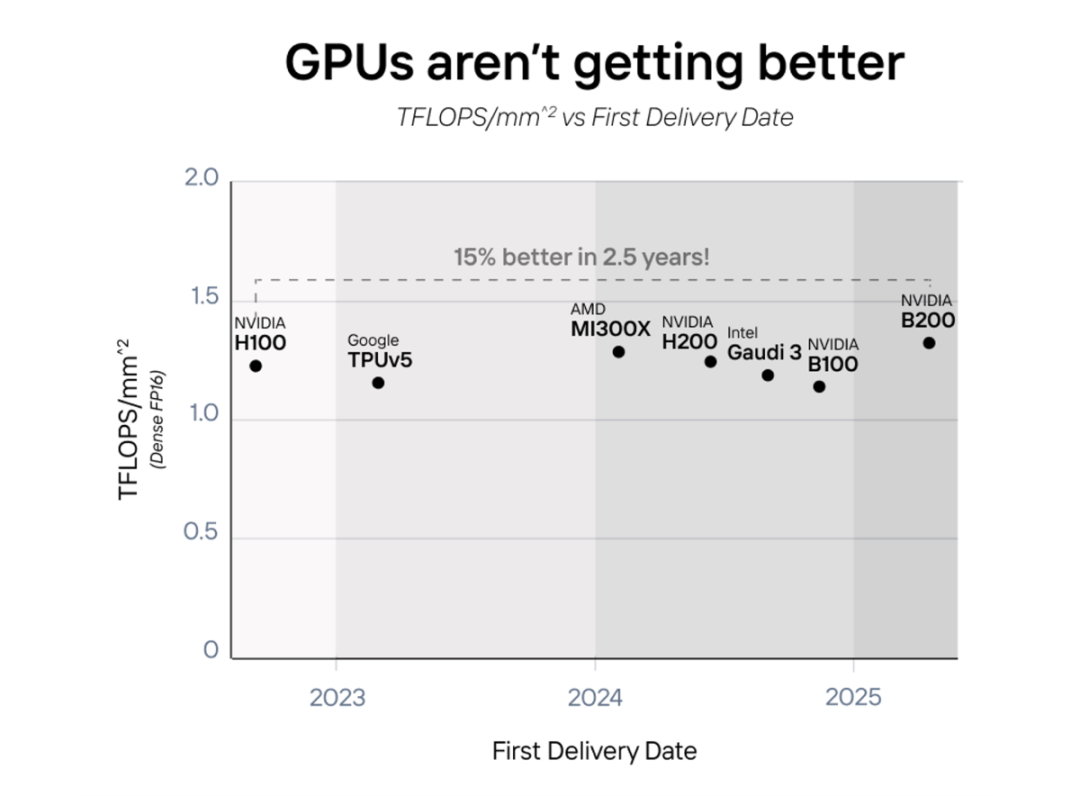

四年间,GPU并没有变得更好

Etched提出,GPU在过去四年间效率并没有变得更好,只是变得更大了:芯片每平方毫米的的TFLOPS几乎持平。

事实上老黄本人也在今年GTC大会上提出:“我们需要更大的GPU,如果不能更大,就把更多GPU组合在一起,变成更大的虚拟GPU。”

在Etched看来,随着摩尔定律放缓,同时在性能和效率上取得突破的方法只剩下专用化。

不过对Etched和Sohu芯片,业界也有人提出质疑。

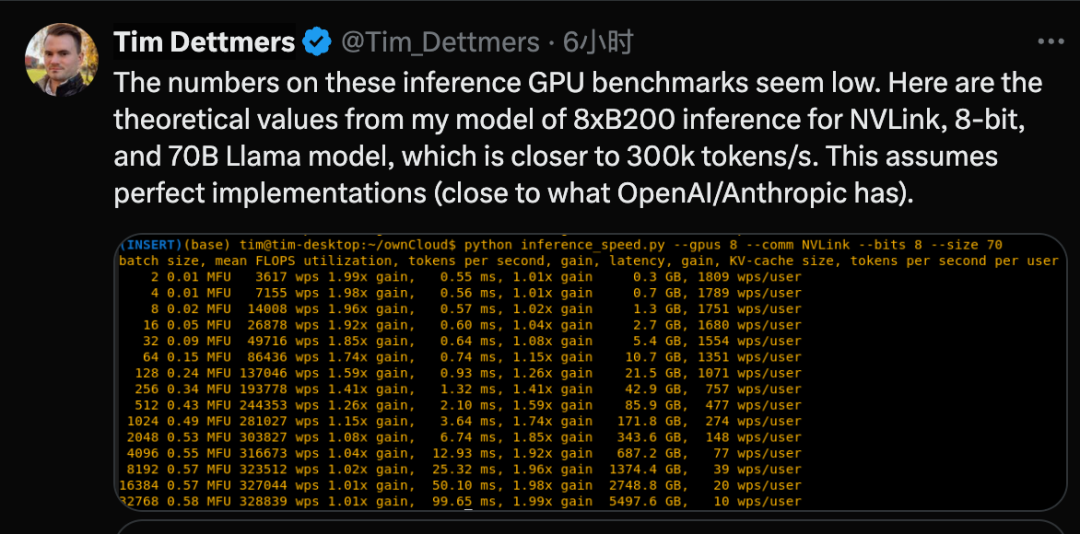

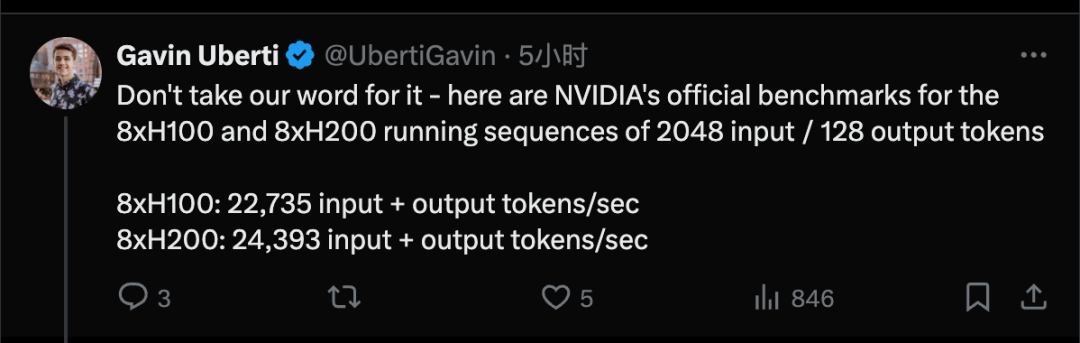

曾撰写爆火教程“2023年性价比GPU选购指南”的华盛顿大学博士生Tim Dettmers指出,Etched官方的测试数据中GPU的性能可能并不是当前SOTA方法。

创始人Uberti解释H100的数据取自英伟达官方测试。

也有人不看好的原因是,Transformer之后还是会有下一个重大架构突破。

曾有投资人透露,至少有6家公司正在秘密开发Transformer专用ASIC芯片,现在看来Etched只是浮出水面的第一家。

你看好Transformer专用芯片吗?欢迎在评论区留下你的看法。

参考链接:

[1]https://www.etched.com/announcing-etched

[2]https://x.com/Etched/status/1805625693113663834

[3]https://x.com/Object_Zero_/status/1769673722057662821

— 完 —

量子位年度AI主题策划正在征集中!

欢迎投稿专题 一千零一个AI应用,365行AI落地方案

或与我们分享你在寻找的AI产品,或发现的AI新动向

点这里

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。