- 1springboot 生成zip 并且实现zip加密_springboot zip加密

- 2良心推荐:免费云计算/存储/数据库资源汇总!_免费云数据库

- 3【前端新手小白】学习Javascript的【开源好项目】推荐_适合新手练手的web前端项目

- 4神经元振荡中相位幅值耦合的量化:锁相值、平均向量长度、调制指数和广义线性模型交叉频率耦合_相位振幅耦合

- 5为何我们决定从零开始创建 NGINX Gateway Fabric

- 6探索未来建站新可能:MIPCMS - 一个高性能的Web开发框架

- 7从头开始构建GPT标记器_gtp谱refrain怎么标记

- 8FastDFS实用笔记 (Docker 搭建环境 + 整合 SpringBoot)_docker fastdfs

- 9鸿蒙界面开发_鸿蒙在函数中怎么写页面

- 10OpenCV与AI深度学习 | 实战 | 文本图片去水印--同时保持文本原始色彩(附源码)

Isaac Lab支持的强化学习框架介绍

赞

踩

在Isaac Lab中使用rl_games强化学习框架进行机械臂训练实验

运行命令:

python source/standalone/workflows/rl_games/train.py --task=Isaac-Franka-Cabinet-Direct-v0一、Stable Baselines 3

Stable Baselines 3(SB3)是一个建立在PyTorch之上的高质量强化学习库。它继承了Stable Baselines库的设计原则,但采用了PyTorch作为其后端,以提供更高效的模型训练和推理能力。SB3提供了多种经典的强化学习算法实现,如A2C、PPO、DQN等,并且拥有简洁易用的API接口,使得研究者和开发者可以快速实现和测试自己的强化学习算法。SB3还提供了丰富的环境和工具,以支持从入门到高级的强化学习项目开发。

二、SKRL

SKRL是一个专注于强化学习和自适应控制算法开发的Python库。它强调灵活性和可扩展性,同时保持代码的简洁性和可读性。SKRL提供了一系列的工具和组件,包括各种强化学习算法的实现、环境接口以及用于训练和评估模型的工具。这些工具使得用户能够方便地构建和测试复杂的强化学习系统。此外,SKRL还支持与其他强化学习框架和工具的集成,为用户提供了更大的灵活性。

三、RL Games

RL Games是saac Gym里使用的强化学习框架,是一个高性能 RL库,是目前用下来训练速度最快的框架之一,如比sb3快。性能良好且轻量,Lab中很多例程都是使用该框架。但是个人觉得该框架文档不丰富(都没个LOGO),二次开发难度较高。且目前在Lab里不支持字典状态量,详细见这篇博客:

Isaac Lab 使用 Stable Baselines3 实现 Multi Input Policy![]() http://t.csdnimg.cn/gq3e0其有着非常丰富的示例和示例的超参数,是一个不错的学习入门框架;

http://t.csdnimg.cn/gq3e0其有着非常丰富的示例和示例的超参数,是一个不错的学习入门框架;

总之,RL Games是一个专注于使用深度学习进行游戏开发和训练的库。它特别关注于Unity游戏引擎的集成,使开发者能够在Unity中直接利用强化学习算法。RL Games提供了一套框架和工具,帮助用户快速创建复杂的、多智能体的游戏环境,并探索强化学习在游戏和仿真中的应用。它的高效性和易用性使得研究人员能够迅速迭代和测试他们的强化学习模型。

四、Robomimic

Robomimic是一个旨在通过模仿学习来让机器人理解和复制人类行为的强化学习框架。它提供了数据集、工具和技术,使得机器人可以从人类演示中学习到有效的动作,并将其应用于实际环境中。Robomimic关注于将人类行为转化为机器人的可执行任务,为机器人技术的研究和应用提供了新的可能性。

robomimic_video

五、RSL-RL

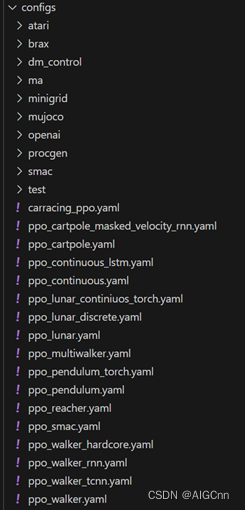

RSL-RL 是苏黎世联邦理工学院的腿部机器人实验室联合Nvidia开发,目前多用于多关节类的机器人学习算法开发,目前有master和algorithms两个分支, algorithms分支支持D4PG、DDPG、DPPO、DSAC、PPO、SAC、TD3这些强化学习算法, Lab 默认使用的是master分支里目前只有PPO的示例,其它算法需要自己安装与合并分支;

RSL-RL(Reinforcement Learning with State Representation Learning)是一个结合了状态表示学习(SRL)的强化学习框架。SRL技术使得智能体能够从原始感觉输入中学习到有效的状态表示,这对于处理高维、复杂的环境特别重要。RSL-RL通过结合SRL和RL,旨在提高智能体在复杂环境中的学习效率和性能。这个框架特别适用于那些需要从视觉输入中学习策略的应用,如机器人导航和自动驾驶。RSL-RL提供了一套工具和环境,使得研究人员能够方便地实现和测试基于SRL的强化学习算法。

-------------------------------------------------------------------------------------------------------------------------------

欢迎加群一起交流学习