- 1基于电影爬虫及Spark数据分析可视化设计-计算机毕业源码设计_基于spark爬虫数据分析

- 2数据结构Map(java)_java 的map是什么数据结构

- 3SylixOS USB总线原理浅析_usb接口有四根线,分别是vcc、d+、d-和gnd为什么只有一个地

- 4Python+Opencv是实现车牌自动识别_python opencv 汽车识别

- 5SQLAlchemy 连接 MySQL 数据库(一)_sqlalchemy 链接mysql

- 6ReiBoot(iOS系统修复工具)v6.9.5.0官方版_reiboot需要付费?

- 7Kafka(什么是Kafka?Kafka的设计与实现!顺便教你如何搭建Kafka!)_kafka的实现怎么写

- 8Artix7系列FPGA实现SDI相机编码输出,基于GTP高速接口,提供4套工程源码和技术支持

- 9MySQL全文索引、联合索引、like查询、json查询速度大比拼_mysql json查询效率

- 10MAC笔记本终端命令行指令的使用指南_mac命令行

Langchain Chatchat:开源代码与离线部署的完美融合_好易智算

赞

踩

写在前面

一.好易智算介绍

1.官网网址

好易智算官网:https://www.haoee.com/

在使用了好易智算后,这个平台大概有以下几个优点:

① 对比其他平台,卡源丰富,通过底层优化,不会出现有卡不能开机的情况;

② 优质算力集成多款主流免费应用;

③ 免去繁琐部署,一键开机,即开即用;

好易智算共有算力市场、应用市场、交流社区三大功能模式。

此外,好易智算平台最近推出的“399 包月活动”更是为广大用户带来了前所未有的优惠。只需 399 元,用户即可在接下来的 30 天内享受到无限次的高性能计算服务,无论是大数据分析、深度学习还是复杂的模拟计算,都能轻松应对。这一活动进一步降低了先进计算资源的使用成本,让智能计算的力量触手可及。

2.应用市场

好易智算的应用市场提供了包含 Stable Diffusion WebUI、omost、SUPIR、kohya-ss、上河 AI、magicanimate、chattts、flashface、ootdiffusion、SadTalker、ComfyUI、Facefusion、Langchain Chatchat、Musetalk、Wav2lip、Fooocus、lora-scripts 等在内的多款应用,涵盖 AI 绘图、视频生成、图片生成及音频生成等多元化场景制作应用,无需部署、开箱即用、即点即用,为用户提供流畅、便捷的创作体验。

3.算力市场

好易智算提供多样化的显卡类型,以及弹性、可扩展的云计算资源,例如:RTX3090、RTX4090d、A100、Atlas 300V、Atlas 300T 等,旨在满足用户对于低成本、高效率的使用需求,确保每一个创新想法都能迅速转化为现实。

4.好易平台优势点总结

| 竞品名称 | 劣势 | 我们应对优势 |

|---|---|---|

| A***L | 卡源紧张,很难抢到❌ | 卡量充足,随时开机✅ |

| A***L | 开机无卡,重新开卡需要拷贝数据,操作麻烦❌ | 无缝开机,原数据自动流转,无需拷贝转移✅ |

| ***脑 | 仅有应用模式,深度使用层面不够灵活❌ | 镜像/应用均有,按需使用更灵活✅ |

| ***脑 | 3 天释放数据❌ | 数据保存 15 天,安心过年、安心度过黄金周,不用担心数据被清空✅ |

| 恒***云 | 算力资源非直营,产品质量良莠不齐❌ | 显卡全直营,品质有保障✅ |

| 恒***云 | 机主素质不一,定价很随意,很容易遇到矿机改装❌ | 全直营,定价体系规范统一,0 矿机,0 风险✅ |

| 揽***舟 | 10GB 免费储存空间❌ | 免费网盘容量 50GB,大容量✅ |

| 揽***舟 | 应用只有 6 个,可用应用比较少❌ | 应用丰富,涵盖范围广,除了已经上线的 9 个,还即将计划上线✅ |

| 揽***舟 | 算力资源价格贵,4090 高达 3.1 元小时❌ | 价格低,还享受 95 折优惠,2.12 元/小时✅ |

| 仙***云 | 25GB 免费储存空间❌ | 免费网盘容量 50GB,大容量✅ |

在使用了好易智算平台后,您将体验到以下显著优势:

- 卡源丰富性:与其他平台相比,好易智算提供了更多样化的卡源选择,通过底层技术优化,确保每张卡都能顺利启动,无卡顿、无故障,让您的使用过程更加顺畅。

- 优质算力集成:平台集成了多款主流的免费应用,为您提供了强大的算力支持,无论是数据处理还是图形渲染,都能满足您的需求。

- 简化操作流程:好易智算致力于简化用户的使用流程,一键开机,即开即用,免去了繁琐的部署步骤,让您能够快速投入到工作或娱乐中,提高效率。

- 高性能计算服务:平台提供的高性能计算服务,能够应对各种复杂的计算任务,无论是科研计算还是商业分析,都能提供稳定而高效的解决方案。

- 用户友好的界面设计:好易智算的用户界面设计直观易用,即便是初学者也能快速上手,无需复杂的学习曲线。

- 全天候客户支持:我们提供全天候的客户服务支持,无论您遇到任何问题,都有专业的团队随时待命,为您提供帮助。

- 安全性与稳定性:平台注重数据安全与系统稳定性,采用先进的安全措施保护您的数据,确保计算过程的安全无忧。

- 灵活的计费模式:提供灵活的计费选项,无论是按需付费还是包月服务,都能满足不同用户的需求,帮助您合理规划预算。

选择好易智算,让您的计算任务变得更加轻松高效,享受科技带来的便利!立即体验,开启智能计算新篇章。

二.Langchain Chatchat 介绍

1.什么是 Langchain Chatchat?

Langchain-Chatchat 是一个基于 ChatGLM 等大语言模型与 Langchain 等应用框架实现的,开源、可离线部署的检索增强生成(RAG)大模型知识库项目,

是一个集成多模型的对话平台,实现自然语言交互。 Langchain-Chatchat 是在 Langchain 基础上封装了一层聊天服务,可以对接底层多种离线 LLM(大语言模型)

和在线的 LLM(也可以对接自定义的在线 LLM),提供基于知识库聊天功能相关的一系列 API。

2.Langchain Chatchat 特点

Langchain-Chatchat 构建高 可复用

可自由上传细分专业领域语料自由训练模型,实现不同领域的自然语言深度交互。

- 开源代码,随取随用

- 支持离线部署,数据隐私性强

- 多语言无障碍交流,消除沟通障碍

三.Langchain Chatchat 构建步骤

1.应用入口

在应用市场中找到如图所示的 Langchain Chatchat 应用,点击立即使用。

2.创建应用

在创建应用页面选择合适的机器,主要有计费方式、选择 GPU 等。

计费方式我们这里选择按量计费,创建新应用是默认的,就是我们要创建的Langchain Chatchat应用。

GPU 选择

- RTX 4090D/24GB

- CPU: 12 核 内存:60 GB

- 数据盘:50GB

可以看到价格是 1.88 每小时,未优惠的价格为 2.35 每小时,性价比还是很高的,确认好信息后,我们点击立即创建。

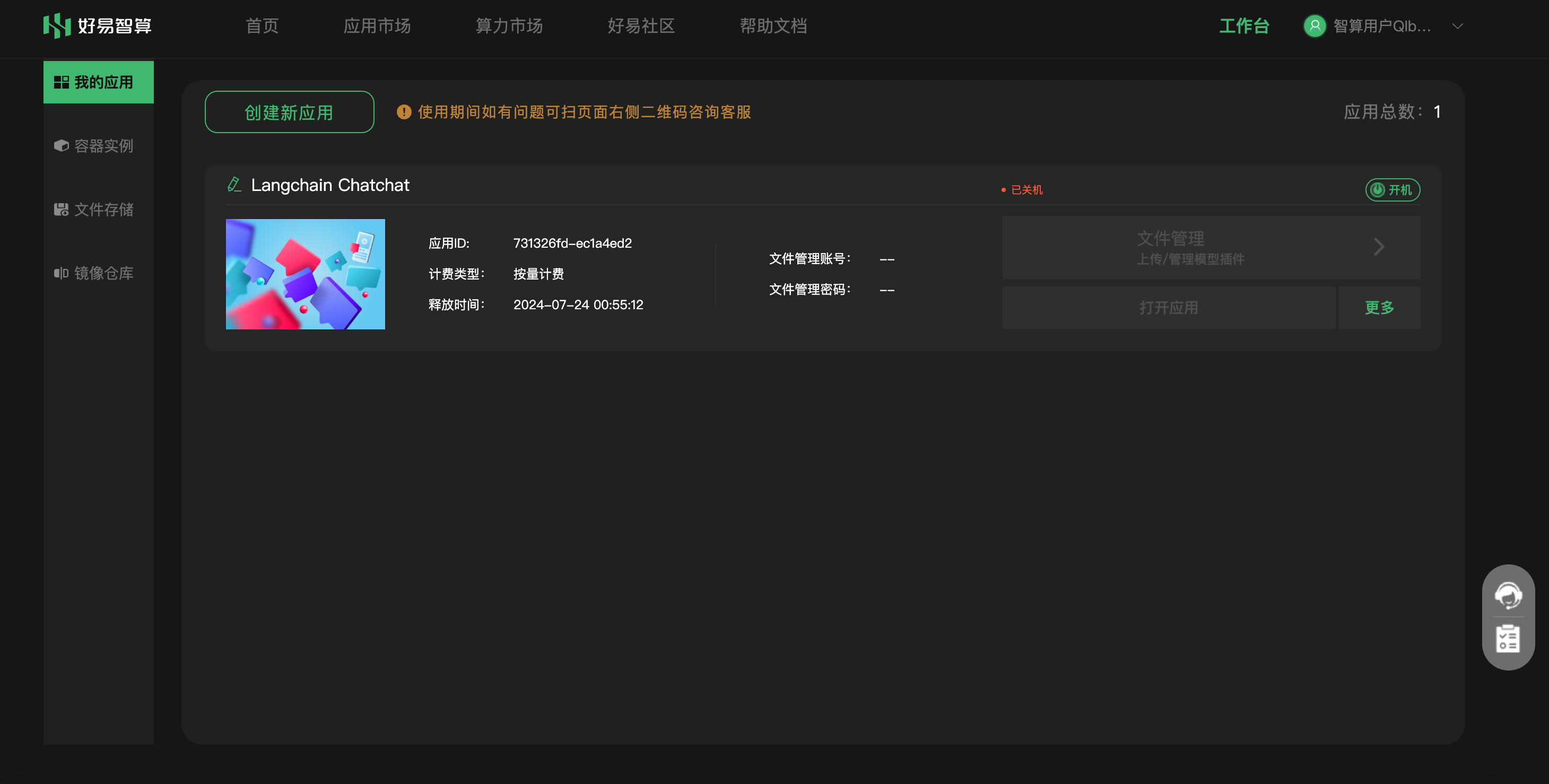

3.我的应用

立即创建后,会自动跳转到我的应用界面,创建新应用会花费一些时间,大概需要 1 分钟的时间引用就创建好了,我们可以点击如图所示的打开应用按钮,会跳转到应用的页面。

四.Langchain Chatchat 会话

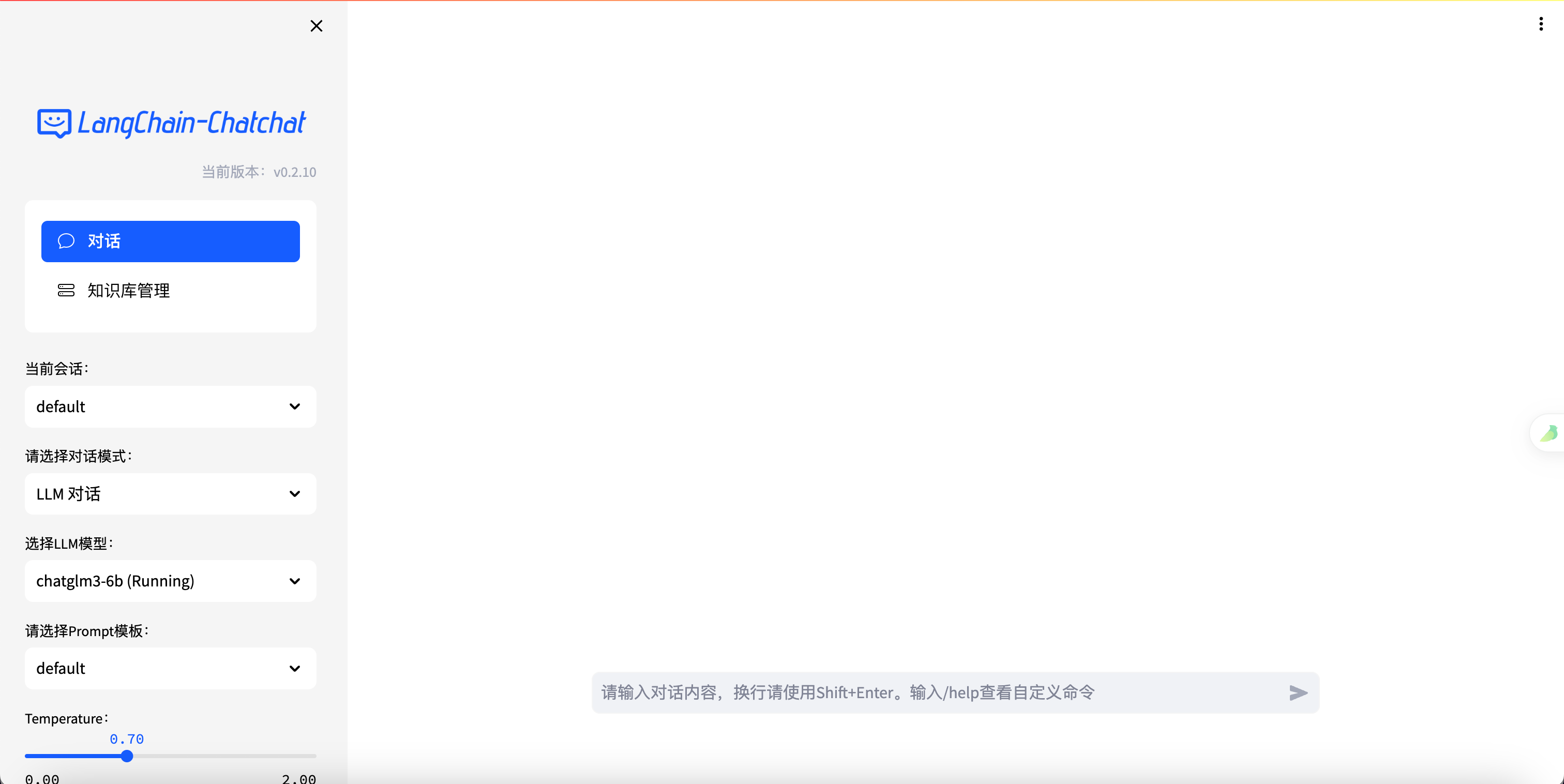

1.会话首页

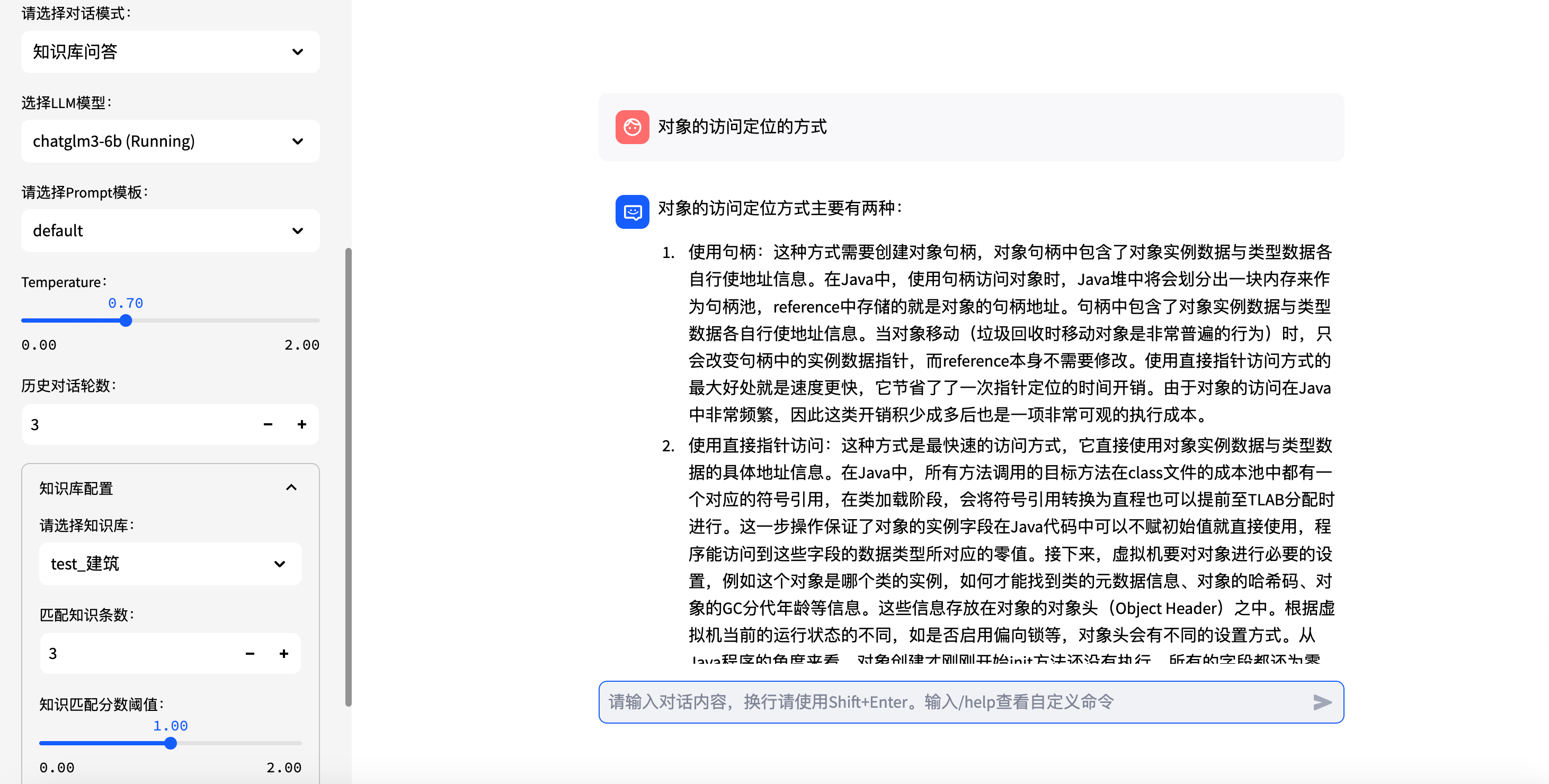

点击打开应用后,会跳转到会话首页,是一个聊天对话框,左侧可以设置一些参数,下面我会详细介绍一下这些参数的作用

2.系统按键区

如图右侧隐藏起来的是系统功能按键区,主要是一些帮助服务,为了体验更好而设置。

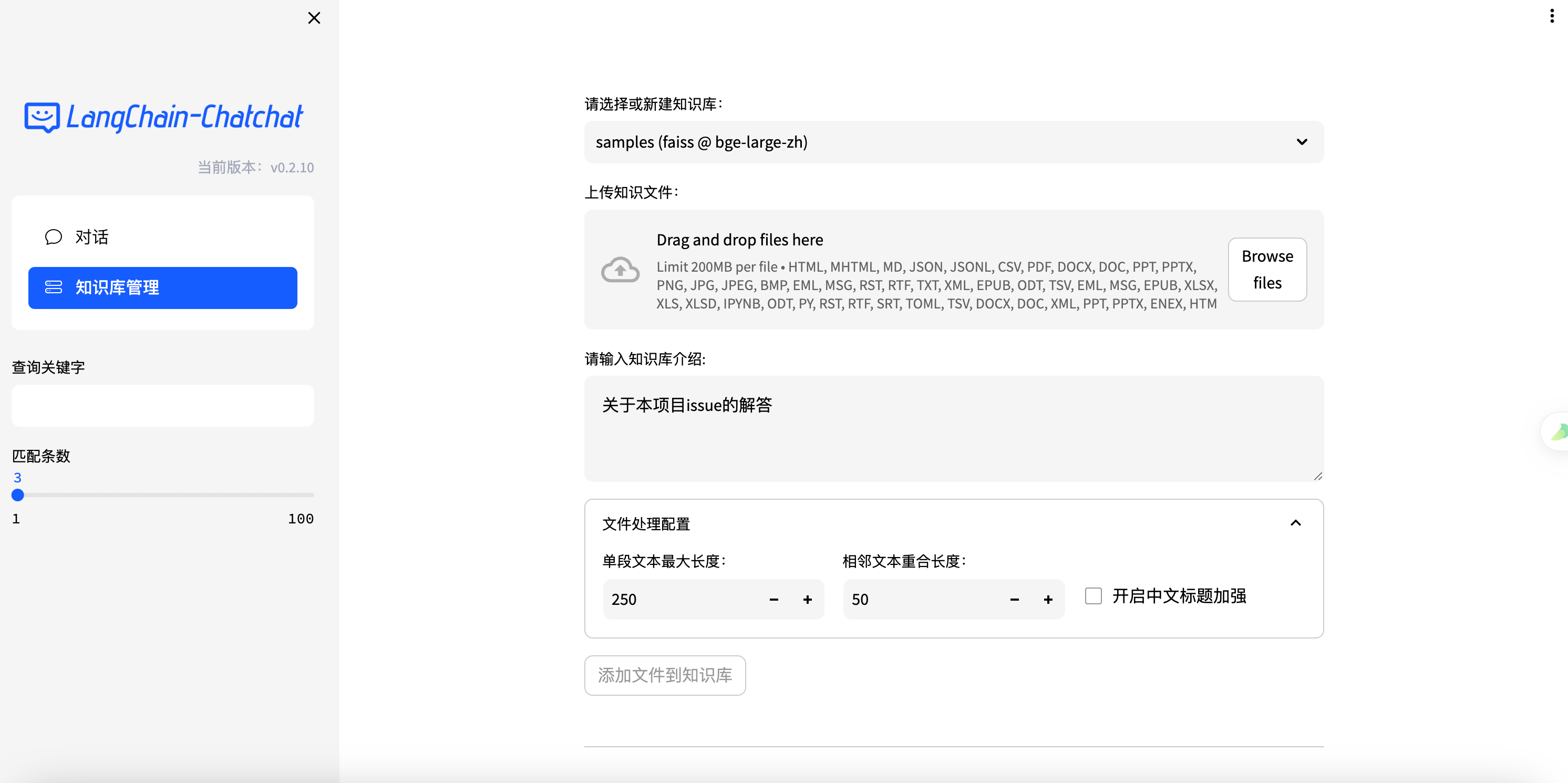

3.知识库管理

知识库管理就是我们可以自定义的上传各种各样格式的文件,这些文件通过 embedding 后会存入到向量数据库中供后续问答的时候使用,回答的结果会基于和问题相关的知识库切片进行回答。

知识库管理首页:

4.会话模式

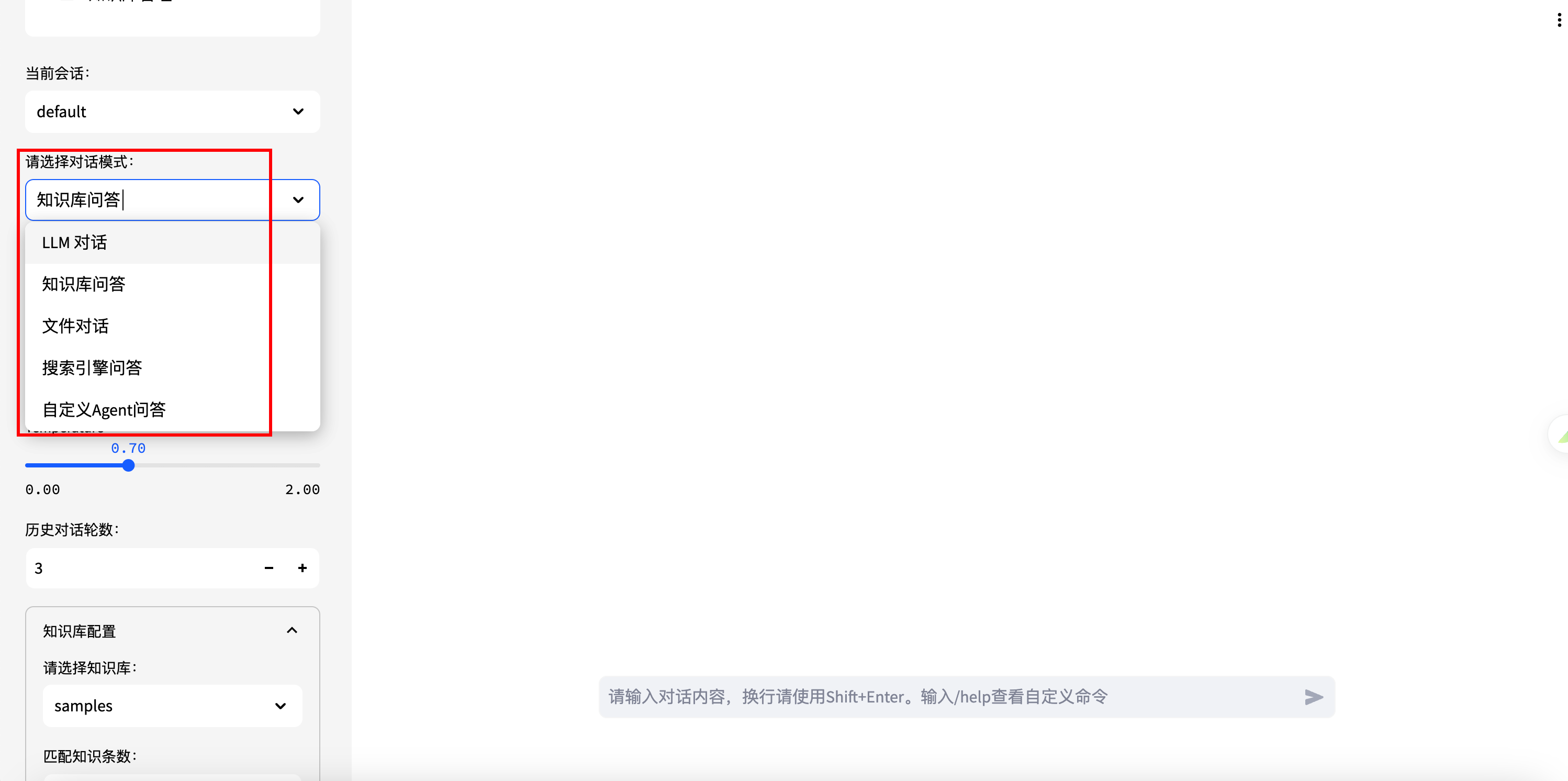

Chatchat 的会话模式多种多样,灵活多样,满足各种需求,主要有如下几类会话类型:

-

LLM 对话

-

知识库问答

-

文件对话

-

搜索引擎问答

-

自定义 Agent 问答

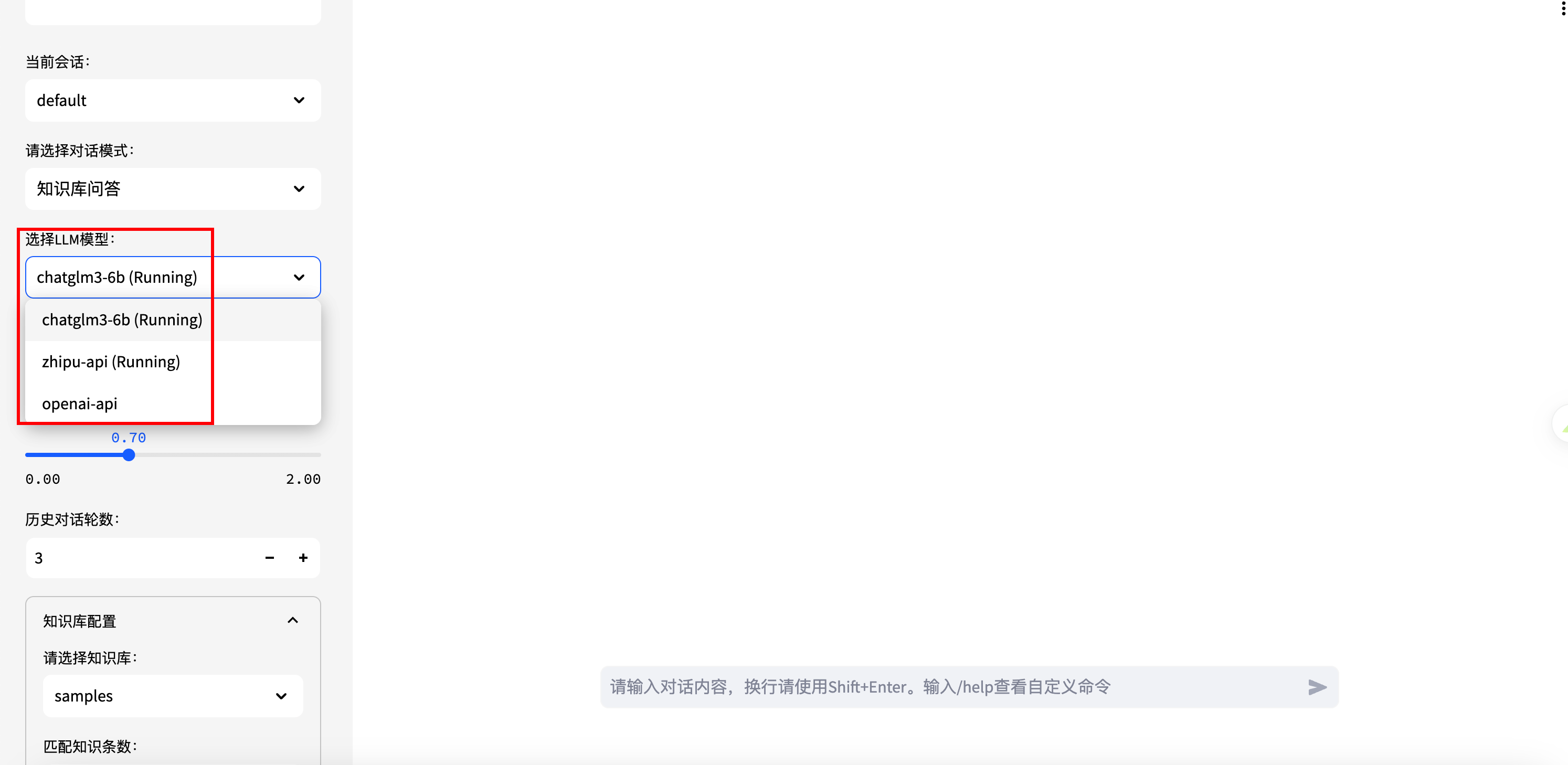

5.模型种类

模型的种类目前有三种,不同的模型由于训练的参数量不同,会导致回答效果不一样。

LLM 模型

-

chatglm3-6b (Running)

-

zhipu-api (Running)

-

openai-api

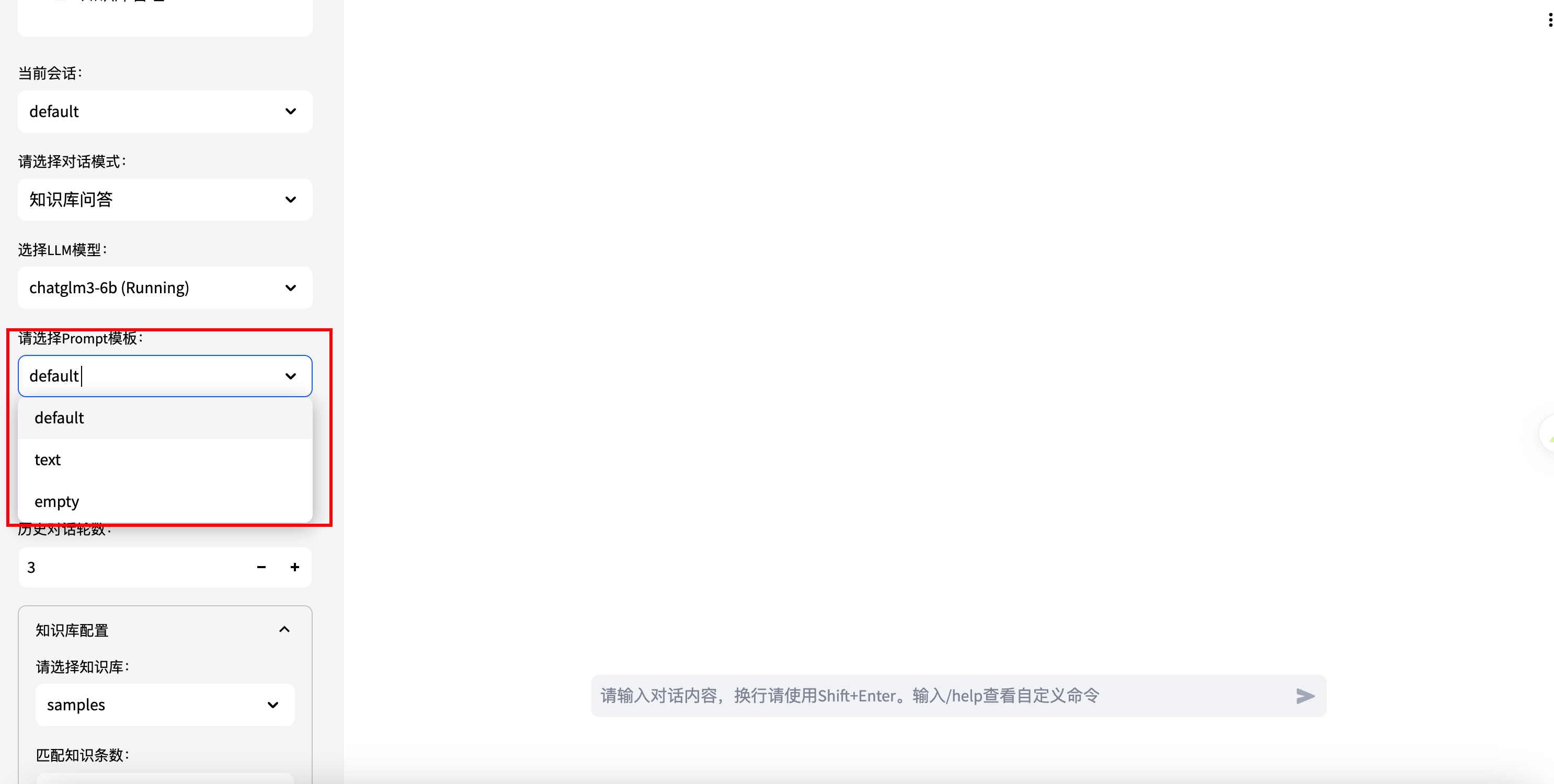

6.prompt 设置

prompt 设置主要是为了我们在对面前,告诉大模型一些公共的基础信息或者回答格式,需要基于这些基础信息和回答格式风格进行回答,满足使用者的要求。

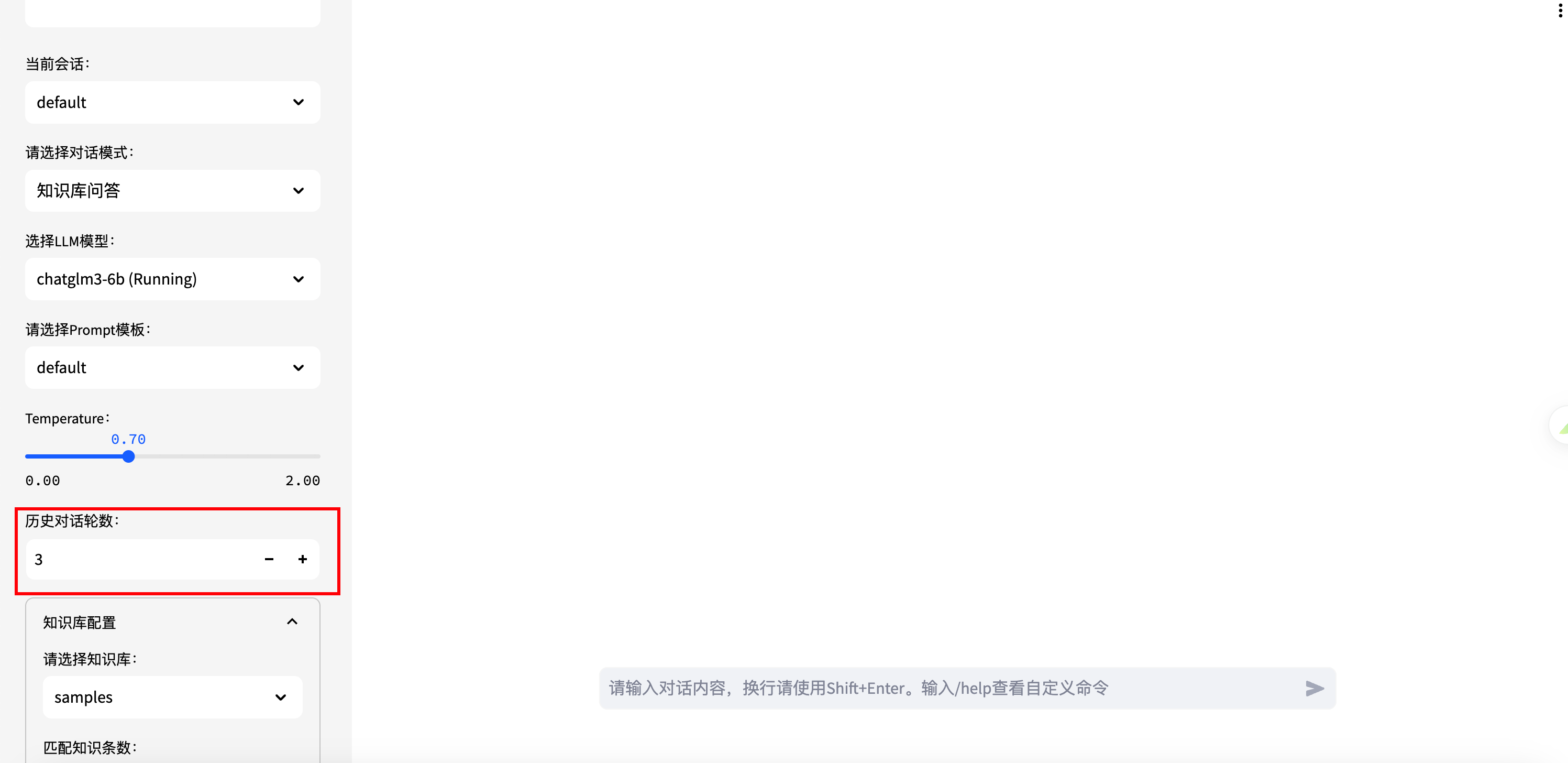

7.Temperature 设置

Temperature 主要是控制大模型的发散度的,Temperature 值越小,大模型越严谨,不会随意发散回答,Temperature 值越大,则大模型会根据自己的理解进行发散性的总结回答,我们需要根据不同的需求场景对 Temperature 进行不同的设置。

8.多轮对话

历史对话轮数就是控制多轮对话,对话轮数越大,大模型在回答的时候参考的上下文就越长,回答的时候会基于之前的问答进行参考,进而对新问题有一个更加准确的回答,当然历史对话轮数越大,传给大模型的 token 数也就越大,我们在使用的时候也需要根据自己的需求设置合适的大小。

9.问答效果图

如何指定小学1年级的学习计划

编写一个红黑树的代码

10.关闭应用

使用完成注意关闭应用,避免资源浪费。

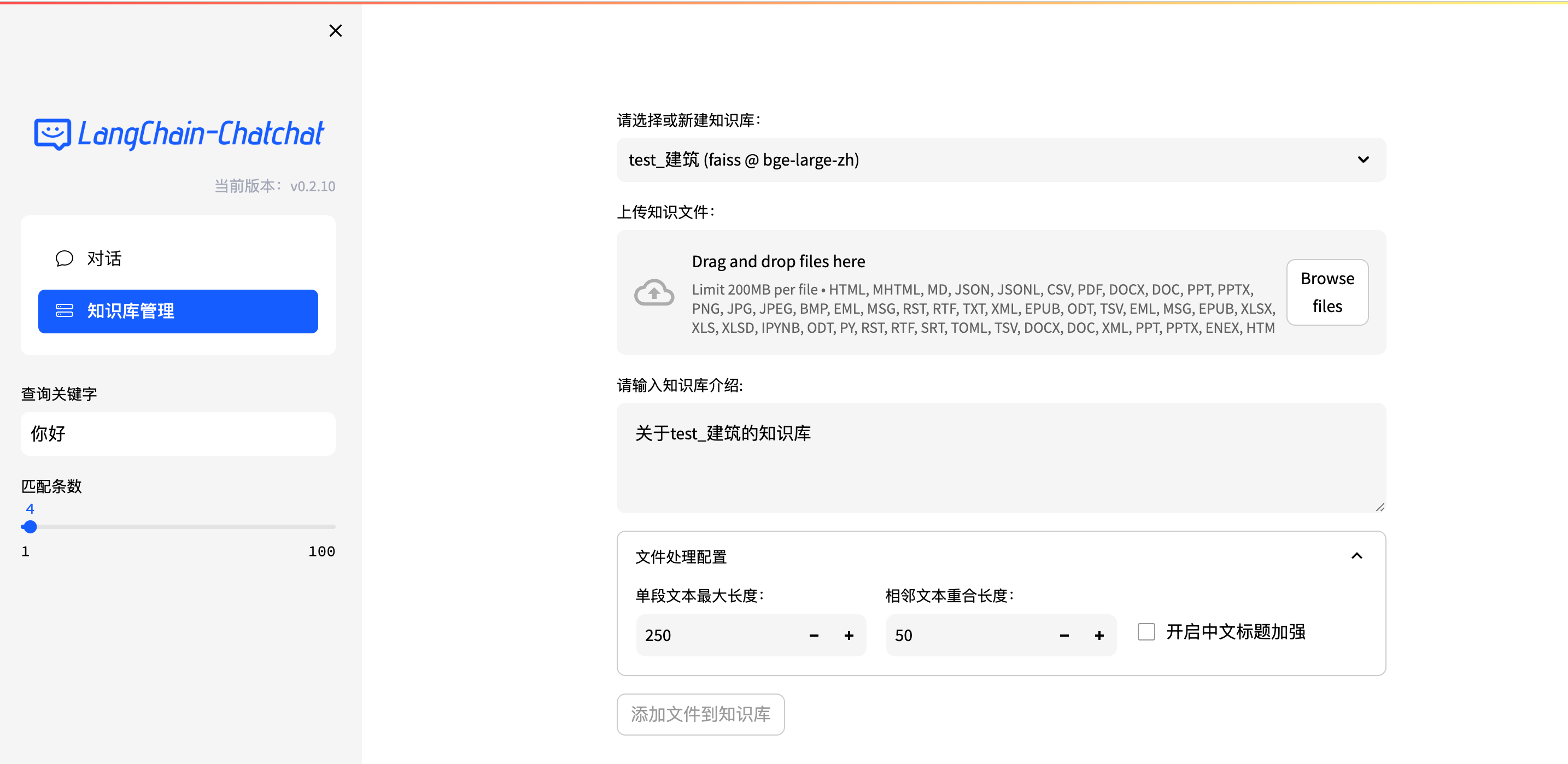

五.自定义知识库

1.新建知识库

选择新建知识库,填写新建知识库的名称,给知识库添加简介,并选择合适的向量库类型和 Embedding 模型。

向量库类型

-

es

-

faiss

-

milvus

-

zilliz

-

pg

-

es

-

milvus_kwargs

Embedding 模型

-

ernie-tiny

-

ernie-base

-

text2vec-base

-

text2vec

-

text2vec-paraphrase

-

text2vec-sentence

-

text2vec-multilingual

-

text2vec-bge-large-chinese

-

m3e-small

-

m3e-base

-

m3e-large

-

bge-small-zh

-

bge-base-zh

-

bge-large-zh

-

bge-large-zh-noinstruct

-

bge-base-zh-v1.5

-

bge-large-zh-v1.5

-

piccolo-base-zh

-

piccolo-large-zh

-

nip_gte_sentence-embedding_chinese-large

-

text-embedding-ada-002

-

minimax-api

-

qianfan-api

-

qwen-api

2.上传文件

筛选准备好和当前知识库相关的文件资料,把资料文件上传到知识库,点击添加文件到知识库,同一个知识库可以添加多个文件。

3.向量知识库

可以对文件进行切片处理,其中单文本最大长度和相邻文本重合长度是动态调整的,并且可以自定义是否开启中文标题加强。切片后的结果如下图所示,主要是 JVM 基础知识的一些切片信息。

4.chat 端

在聊天对话框选择对话模式为知识库问答,然后在知识库配置中选择知识库,并且选择召回的条数,以及知识匹配分数阈值,问了一些和知识库 PDF 相关的问题,发现可以很好的回答出来,检索知识库起到了明显的作用。

5.知识库出处

通过点击知识库匹配结果,我们可以看到切片在 PDF 中的出处,进而根据切片进行总结回答,为用户提供一个满意的答案。

6.Chatchat 使用总结

在使用 Langchain Chatchat 过程中,我们可以发现 Langchain Chatchat 功能多样,有很多自定义参数可以进行配置,然后流式输出的速度很快,主要原因是运载应用的机器算力强大,非常值得尝试使用。

Langchain Chatchat优点:

- 应用运载机器每小时 1.8 元,性价比非常高

- 开源代码,随取随用

- 支持离线部署,数据隐私性强

- 多语言无障碍交流,消除沟通障碍

- 支持自定义知识库

- 流式输出答案如流水一样,速度非常快,体验很棒