- 14.k8s:cronJob计划任务,初始化容器,污点、容忍,亲和力,身份认证和权限

- 2C语言----二维数组

- 3创建Oracle本地数据库详细步骤,Oracle-创建本地数据库

- 4Ubuntu下的STM32开发环境搭建(VScode+CubeMX+arm-none-eabi-gcc交叉编译工具链),使用JLink进行烧录(非OpenOCD),使用Ozone进行调试_ozone调试

- 5【java基础-实战3】list遍历时删除元素的方法_list 遍历删除

- 6【云计算学习教程】探讨私有云计算平台的搭建(附带3套解决方案)_私有云云平台解决方案学习路径(3)_如何学习私有云

- 7LiveGBS流媒体平台GB/T28181功能-获取GB28181接入的海康大华宇视华为摄像头硬件NVR设备通道视频直播流地址HLS/HTTP-FLV/WS-FLV/WebRTC/RTMP/RTSP_gb28181平台

- 8【附源码】流浪动物救助及领养管理系统(源码+毕业论文齐全)java开发ssm框架javaweb javaee项目,可做计算机毕业设计或课程设计_流浪动物救助系统

- 9网易 Duilib:功能全面的开源桌面 UI 开发框架_duilib 跨平台

- 10cookie,session和token的区别_chrome查看token

最强端侧多模态模型MiniCPM-V 2.5,8B 参数,性能超越 GPT-4V 和 Gemini Pro_minicpm-v 8b 开源代码

赞

踩

前言

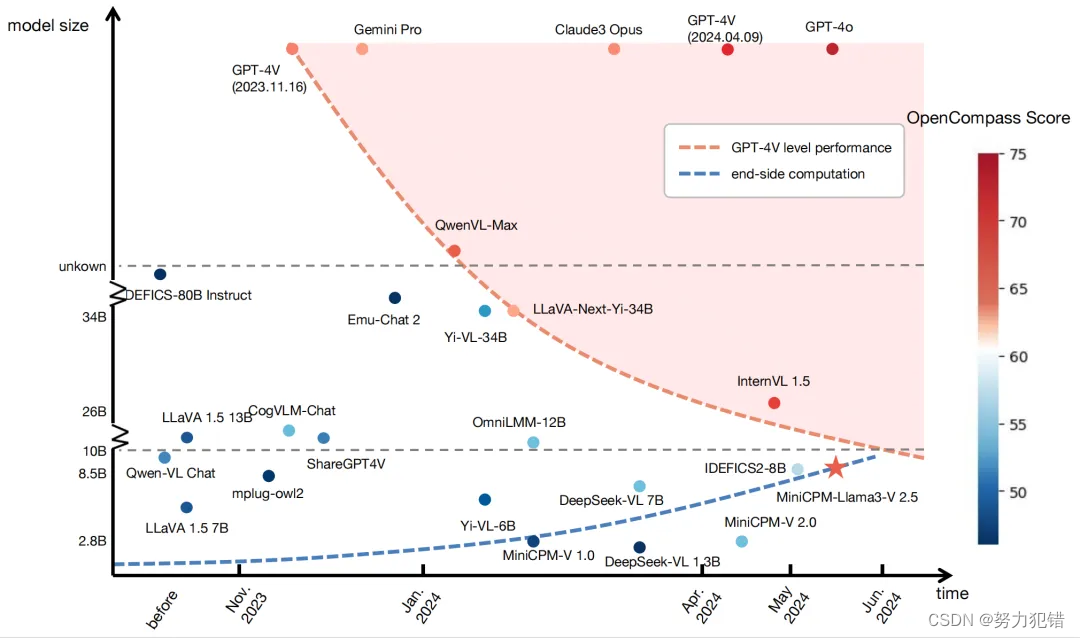

近年来,人工智能领域掀起了一股大模型热潮,然而大模型的巨大参数量级和高昂的算力需求,限制了其在端侧设备上的应用。为了打破这一局限,面壁智能推出了 MiniCPM 模型家族,致力于打造高性能、低参数量的端侧模型。近期,面壁智能再次推出了最新一代端侧多模态模型 MiniCPM-Llama3-V 2.5,以 8B 的参数量级,展现出了超越 GPT-4V 和 Gemini Pro 等多模态巨无霸的强大实力。

-

Huggingface模型下载:https://huggingface.co/openbmb/MiniCPM-Llama3-V-2_5

-

AI快站模型免费加速下载:https://aifasthub.com/models/openbmb

技术特点

MiniCPM-Llama3-V 2.5 拥有以下关键技术特点:

-

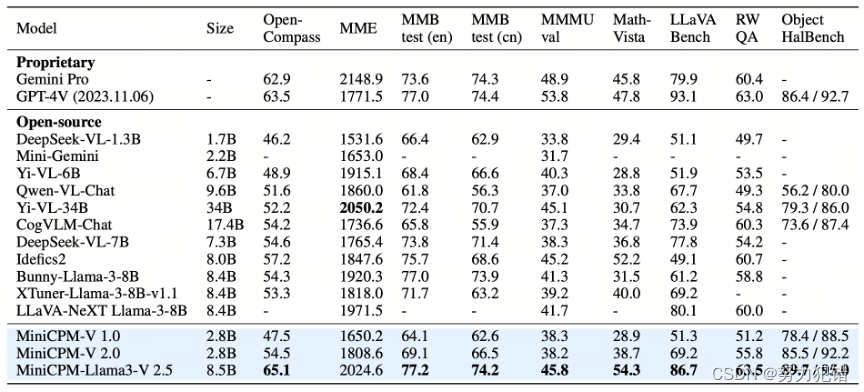

以小博大,参数精简,性能卓越

MiniCPM-Llama3-V 2.5 仅拥有 8B 参数,却在多模态综合性能、OCR 能力、幻觉控制等方面超越了 GPT-4V 和 Gemini Pro 等更大模型,证明了面壁智能在模型压缩和性能优化方面的领先技术。

-

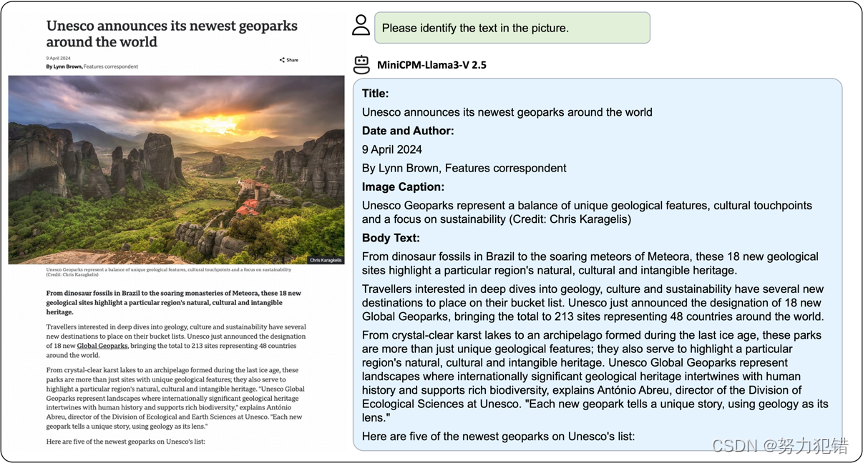

OCR 能力 SOTA,识别精准,效率更高

MiniCPM-Llama3-V 2.5 在 OCRBench 基准测试中取得了 SOTA 成绩,超越了 Claude 3V Opus、Gemini Pro 等标杆模型,展现出强大的 OCR 能力。模型支持高效编码及无损识别 180 万高清像素图片,并支持任意长宽比,甚至能识别 1:9 极限比例图像,突破了传统 OCR 技术只能识别 20 万像素小图的瓶颈。

-

复杂推理能力强,更懂图像,更会思考

MiniCPM-Llama3-V 2.5 不仅仅能理解图像中的文字,还能深入洞察图像,在更复杂、更接近人类的水平上进行思考和解决问题。例如,面对一张充满繁密字迹的建筑风景图,模型不仅能够识别出《三体》主题,还能正确推理出这些建筑是为了纪念《三体》及其对中国科幻文学的贡献而设计。

-

首次实现端侧系统级加速,效率提升 150 倍

MiniCPM-Llama3-V 2.5 首次实现了端侧系统级多模态加速,在图像编码方面,整合了 NPU 和 CPU 加速框架,并结合显存管理、编译优化技术,实现了 150 倍的加速提升。在语言模型推理方面,经过优化,模型在手机端的语言解码速度提升到 3-4 token/s,大幅提升了端侧应用的效率。

-

支持 30+ 种语言,拥抱世界开源社区

MiniCPM-Llama3-V 2.5 支持 30+ 种语言,包括德语、法语、西班牙语、意大利语、俄语等主流语言,基本覆盖一带一路国家。基于自研的跨语言泛化技术,模型仅通过少量翻译的多模态数据的指令微调,就能对多语言多模态对话性能高效泛化,让全球用户都能享受到端侧多模态技术的便利。

性能优势

MiniCPM-Llama3-V 2.5 在多个方面展现出了优异的性能:

-

多模态综合性能: 在 OpenCompass 平台上,MiniCPM-Llama3-V 2.5 以 8B 的参数量级,综合性能超越了 GPT-4V 和 Gemini Pro,展现了小模型大潜力的优势。

-

幻觉控制: 在 Object HalBench 榜单上,MiniCPM-Llama3-V 2.5 的幻觉率大幅降低,再次超越 GPT-4V 和 LLaVA-NeXT-34B,证明了模型在生成可靠、可信答案方面的进步。

-

空间理解能力: 在 RealWorldQA 榜单上,MiniCPM-Llama3-V 2.5 的性能仅次于 InternVL-Chat-V1.5 (26B),却依旧超越了 GPT-4V 和 Gemini Pro,展现了模型在处理空间信息方面的能力。

应用场景

MiniCPM-Llama3-V 2.5 在多个领域具有广泛的应用潜力,可以为用户提供更便捷、更具创意的创作体验:

-

智能手机应用: 可以用于手机上的图像识别、文字识别、问答、语音助手等功能。

-

智慧家居: 可以用于智能家居设备的图像识别、语音控制、信息查询等功能。

-

工业应用: 可以用于工业场景的图像识别、故障诊断、安全监控等功能。

-

医疗领域: 可以用于医学图像分析、诊断辅助等功能。

总结

MiniCPM-Llama3-V 2.5 的发布,标志着端侧多模态模型迈上了新的台阶,它用实力证明了模型参数量级并非衡量性能的唯一指标,小模型也能拥有强大的能力。相信未来 MiniCPM 模型家族将会在更多领域发挥重要作用,为人们的生活带来更多便利和乐趣。

模型下载

Huggingface模型下载

https://huggingface.co/openbmb/MiniCPM-Llama3-V-2_5

AI快站模型免费加速下载

https://aifasthub.com/models/openbmb