- 1开源模型应用落地-LangChain试炼-CPU调用QWen1.5(一)_使用cpu跑qwen大模型

- 2连续环境下基于enhanced GA算法的多目标多机器人路径算法_基于遗传算法ga的机器人

- 3第七章 短语宏与XML IVR_inter digit timeout

- 4通过简单api对接,免费制作查题公众号_爱点题库接口

- 5解决 “E- 仓库xx没有 Release 文件。N- 无法安全地用该源进行更新,所以默认禁用该源”_n: 无法安全地用该源进行更新,所以默认禁用该源。

- 6Android Jetpack组件 DataStore的使用和简单封装,2024年最新Android开发视频教程

- 7ChatGLM2-6B 大语言模型本地搭建_国内chatglm2镜像

- 8使用install4j打包java项目教程及一些小问题的解决_install4j使用教程

- 9Windows电脑的显存容量查看

- 10Windows11安全中心提示页面不可用

SLMs之Phi-3:Phi-3的简介、安装和使用方法、案例应用之详细攻略

赞

踩

SLMs之Phi-3:Phi-3的简介、安装和使用方法、案例应用之详细攻略

导读:2024年4月23日,微软发布Phi-3,这是微软推出的一款新的开源AI模型家族Phi-3。

背景痛点:小语言模型(SLM)尽管规模不大,但在语言理解、代码编写和数学计算等方面表现出色。

产品介绍:

>> Phi-3家族成员包括Phi-3-mini(待推出的Phi-3-small和Phi-3-medium)。

>> Phi-3-mini是首个支持上万字符上下文窗口的小型模型,性能影响小。

>> Phi-3模型在相同规模或者比它大一倍模型的多个语言评测指标上都表现出色。

核心特点:

>> 安全首要,按照微软责任AI标准开发。

>> 高效、低延迟,尤其适用于边缘计算。

>> 低成本,面向资源有限且任务简单的场景。

应用场景:

>> 边缘和嵌入式设备

>> 延迟敏感场景

>> 成本面临限制的场景

优势:

>> 在同规模模型基础上显著提升性能

>> 安全培训与评估丰富

>> 提供不同规模选择,满足多样需求

综上,微软Phi-3 family旨在提供更多选择以满足客户需求,新推出的Phi-3-mini是一个稳定性能的小型语言模型,特别适用于边缘和低延迟场景。

目录

3、模型效果:其中Phi-3-small稍微较强于LLaMA-3-8B,而Phi-3-medium几乎全胜于LLaMA-3-8B

T1、在Azure AI Studio中利用部署-评估-微调工具链进行部署和评估

T2、在Ollama上进行本地运行,并根据需要进行定制和微调

Phi-3的简介

2024年4月23日,Phi-3是由微软开发的一系列开放AI模型,旨在重新定义小型语言模型(SLMs)的可能性。Phi-3模型以其卓越的性能和高效的成本而著称,超越了同等大小和稍大一号的模型,在各种语言、推理、编码和数学基准测试中表现优异。Phi-3系列包括Phi-3-mini等多个模型,其中Phi-3-mini拥有38亿参数,可在Microsoft Azure AI Studio、Hugging Face和Ollama等平台上使用。

官网地址:https://azure.microsoft.com/en-us/blog/introducing-phi-3-redefining-whats-possible-with-slms/

1、Phi-3的特点

>> 支持不同长度的上下文窗口,其中Phi-3-mini是同类模型中首个支持最多128K令牌上下文窗口的模型。

>> 经过指令调整,可以遵循不同类型指令,使模型即开即用。

>> 在Azure AI上利用部署-评估-微调工具链,以及在Ollama上提供本地运行支持。

>> 经过优化,支持跨平台的ONNX Runtime,并可在GPU、CPU甚至移动硬件上运行。

>> 作为NVIDIA NIM微服务提供,具有标准API接口,可在任何地方部署,并针对NVIDIA GPU进行了优化。

2、Phi-3的核心技术点

>> 高质量数据的训练,确保模型的性能和效果。

>> 安全后训练,包括强化学习人类反馈、自动化测试和对数十种危害类别的评估。

>> 符合微软负责任AI标准,遵循责任、透明、公平、可靠和安全、隐私和安全、包容等原则。

3、模型效果:其中Phi-3-small稍微较强于LLaMA-3-8B,而Phi-3-medium几乎全胜于LLaMA-3-8B

Phi-3模型在关键基准测试中显著优于同大小和更大尺寸的语言模型(见下方的基准测试数字,数字越高越好)。Phi-3-mini的表现优于其两倍大小的模型,而Phi-3-small和Phi-3-medium则超过了包括GPT-3.5T在内的更大模型。

所有报告的数字都是使用相同的流程产生的,以确保这些数字具有可比性。因此,由于评估方法上的微小差异,这些数字可能与其他已发布的数字不同。我们在技术论文中提供了更多关于基准测试的细节。

注意:Phi-3模型在事实知识基准测试(如TriviaQA)上的表现不如小型模型,因为较小的模型尺寸导致保留事实的能力较低。

Phi-3的安装和使用方法

在Microsoft Azure AI Studio、Hugging Face或Ollama上查找和下载Phi-3-mini模型。

1、下载模型

地址:https://huggingface.co/collections/microsoft/phi-3-6626e15e9585a200d2d761e3

2、模型微调与部署

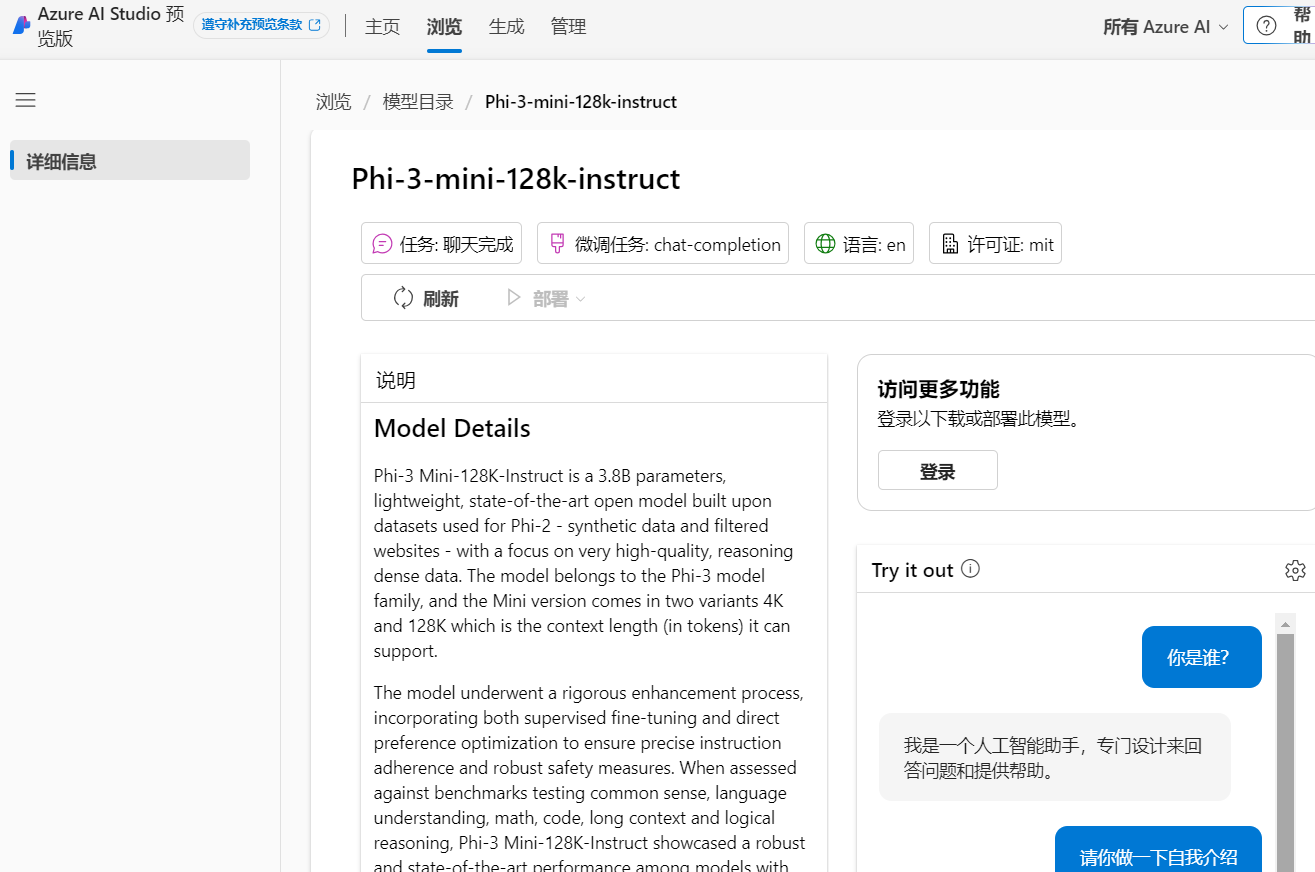

T1、在Azure AI Studio中利用部署-评估-微调工具链进行部署和评估

T2、在Ollama上进行本地运行,并根据需要进行定制和微调

地址:phi3

3、模型体验

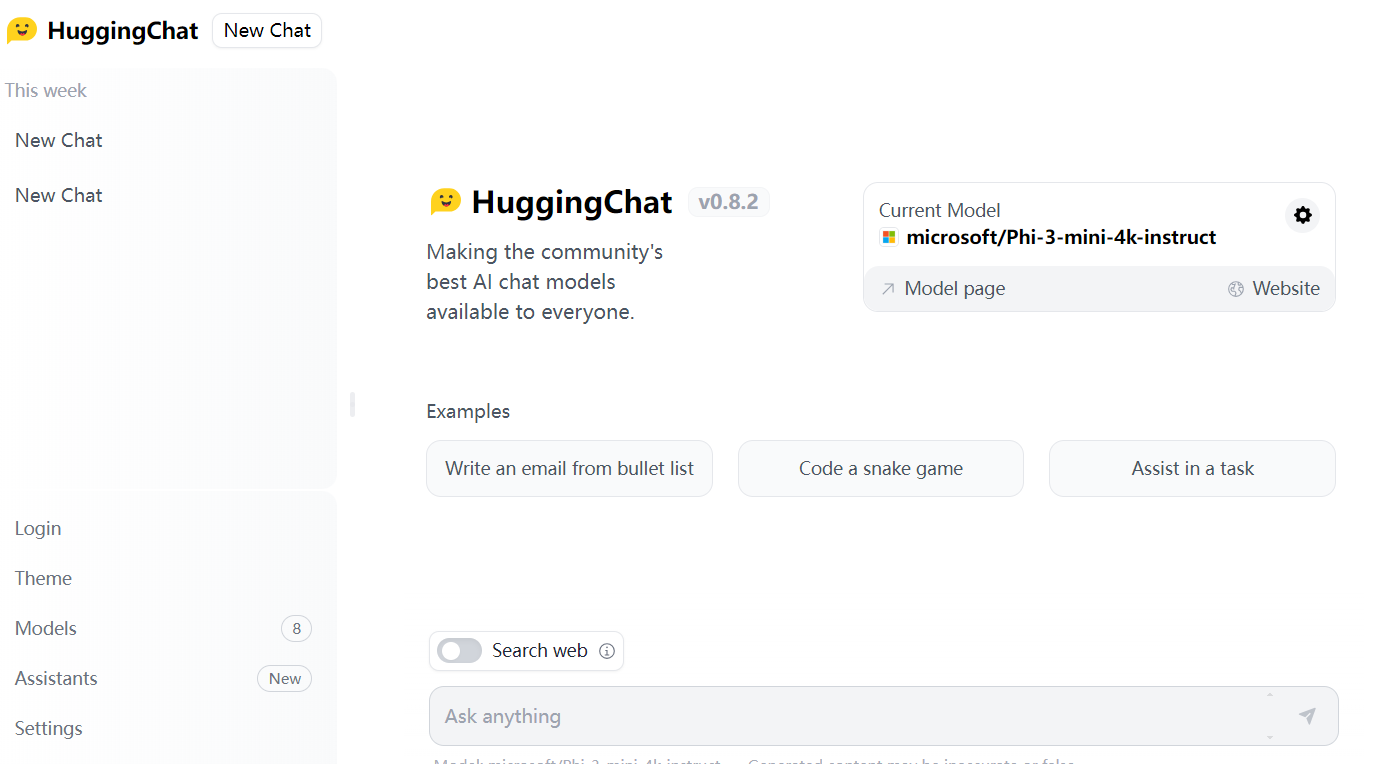

T1、HuggingFace平台

地址:https://huggingface.co/chat/models/microsoft/Phi-3-mini-4k-instruct

T2、Azure平台

Phi-3的案例应用

在资源受限环境中,如设备上和离线推断场景。

在需要快速响应时间的延迟绑定场景中。

在成本受限的使用案例中,尤其是那些任务较简单的情况下。

在农业领域等地方,通过与微软合作伙伴模板的使用,提供具有降低成本运行的强大小型模型,以帮助改善农民的效率和准确性。