- 1【鸿蒙软件开发】ArkTS常用组件之Button_鸿蒙开发,如何创建一个button

- 2ORB_SLAM错误总结_failed to invoke rospack to get compile flags for

- 3maven 的 GAVP

- 4Windows修改huggingface模型下载地址_huggingface模型下载路径

- 5通过STM32 stlink utility工具对ST-LINK芯片信息进行读取和升级以及SWD烧录媒介_stm32stlinkutility读取芯片

- 6【愚公系列】2023年12月 HarmonyOS教学课程 061-ArkTS语言基础类库(容器类库)

- 7Java限流方案常用算法详解 固定时间窗口 滑动时间窗口 漏桶限流 令牌桶限流_java滑动窗口算法限流

- 8超详细,抖音cid广告计划搭建全流程解读

- 9鸿蒙系统(HarmonyOS)应用开发精品课程_鸿蒙软件开发面向哪些课程实验教学

- 10jvm blog_cannot create vm thread. out of system resources.

TCP:结合轨迹规划和控制预测的端到端自动驾驶框架_wayve 端到端

赞

踩

热爱自动驾驶研究的你,是否还在为如何融合多传感器信息而苦恼,亦或是为提升上游检测和预测模块的点数而卷得不可开交?不妨换个思路,在端到端模型输出形式上对症下药,乘坐我们的TCP,纵使路途遥远充满挑战,也能安全为您保驾护航。

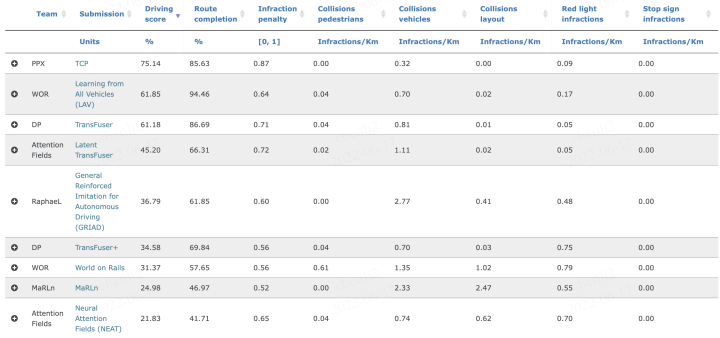

CARLA是一个广泛用于自动驾驶相关研究的开源模拟器,CARLA Autonomous Driving Leaderboard 是一个用来衡量自动驾驶模型在复杂城市交通环境下行驶性能的平台,自动驾驶模型需要在不同天气,光照环境下,应对各类富有挑战性的驾驶场景,完成驾驶任务。我们提出了一个统一了两种典型输出形式(轨迹规划和控制预测)的端到端自动驾驶(E2E AD)模型 - TCP (Trajectory-guided Control Prediction),仅使用单一单目相机作为输入,便取得了75.14 Driving Score 和 0.87 Infraction Penalty,在CARLA Autonomous Driving Leaderboard上取得了 第一名 的分数,远超其他使用多传感器输入的方法(多相机和激光雷达)。

论文地址: http://arxiv.org/pdf/2206.08129.pdf

项目地址: https://github.com/OpenPerceptionX/TCP

主要撰写小伙伴: @吴鹏浩、陈立

PS:未经授权,禁止转载

TD;LR (太长不看版):

1.不同于以往的端到端模型,TCP有何特别?

-

模型设计着重点?NOT encoder!以往的端到端模型往往专注于输入信息的融合异己输入encoder部分的设计,而TCP专注于提取到feature之后的预测部分。

-

E2E AD 输出形式,轨迹or控制?平常的端到端模型采用轨迹+PID/控制信号中的一种,而TCP研究了这两种输出形式的各自特点和优劣,并将二者结合在一个统一框架中,达到取长补短优势互补的效果。

2.我们做了哪些具体工作?

-

我们通过大量实验分析了两种输出模型(轨迹预测+PID模型和直接输出控制模型)各自的特点。

-

针对模仿学习中,对于state-action pair独立同分布假设带来的问题,我们提出了推演预测未来多步控制信号的方案,赋予模型较短时序上的推理能力。

-

我们将轨迹预测分支和多步控制分支整合在一个框架中,并加入二者的交互,并根据先验方案灵活结合两分支输出,获得最佳的最终控制信号。

3.TCP模型效果如何?

作为一个简单有效的框架,TCP以单相机作为输入,在不同测试环境和场景下,出色应对各类挑战性的驾驶场景,在CARLA AD Leaderboard上取得了 第一名 的成绩 (75.14 Driving Score 和 0.87 Infraction Penalty 均远超其他方法)。Demo视频如下: