- 1unity基础(5)——安装配置Visual Studio_unity安装visual studio2019

- 2turn.js 试用

- 3HarmonyOS开发实战之认证服务 (auth in Serverless by ArkTS)_arkts 用户注册代码

- 4使用Truffle for Vscode插件部署本地智能合约_vscode以太坊开发

- 5微信小程序设置 tabbar icon 大小_微信小程序tabbar图标大小

- 6Vue中使用百度地图Vue Baidu Map —— 获取当前位置_vue3中vue-baidu-map-3x获取当前位置

- 7Mixed Content: The page at ‘<URL>‘ was loaded over HTTPS, but requested an insecure script ‘<URL>‘.

- 8pygame windows下载安装方法_pygame库下载

- 9U3D对话任务插件 Dialogue System for Unity 研究(一)_dialogue system of unity插件介绍

- 10MySQL数据表的约束

打造Ai作图studio需要哪些工具_ai studio

赞

踩

这篇文章依然是比较轻松的方式跟大家介绍Ai生成会使用到的一些工具,希望这些工具可以帮助到你更好的更稳定的快捷的生成高质量图片。说来轻松其实也不算轻松,虽然我已经按照生成的链路对工具做了规整。但是里面涉及到的工具其实确实不算少,并且很多工具其实是一类工具(就是只是给了个例子,要用好可能还得自己做更进一步挑选适配)。要理解每个工具在自己生产中如何使用才能做到提效提质,那确实得花一番工夫去了解工具原理,现在工具能做到什么程度,自己要如何改造工具。

Ai生成图片已经开始慢慢由toy变成了可以稳定生成的链路。大有计算成像平民化大众化链路趋势,1.计算图像学高升的数学知识+牛逼的编程技巧才能实现图像创作——专业管线渲染计算成像;2.Ai作图你只要会说话,就能生成一个不错的图片,然后加上各种Ai模型配合(你要了解使用原理)就能生成还算专业图片——平民化计算成像。

训练辅助工具

图片打标

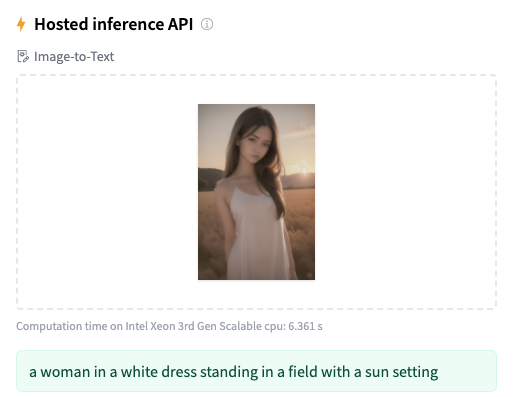

图片自然描述-image caption

https://huggingface.co/Salesforce/blip-image-captioning-large

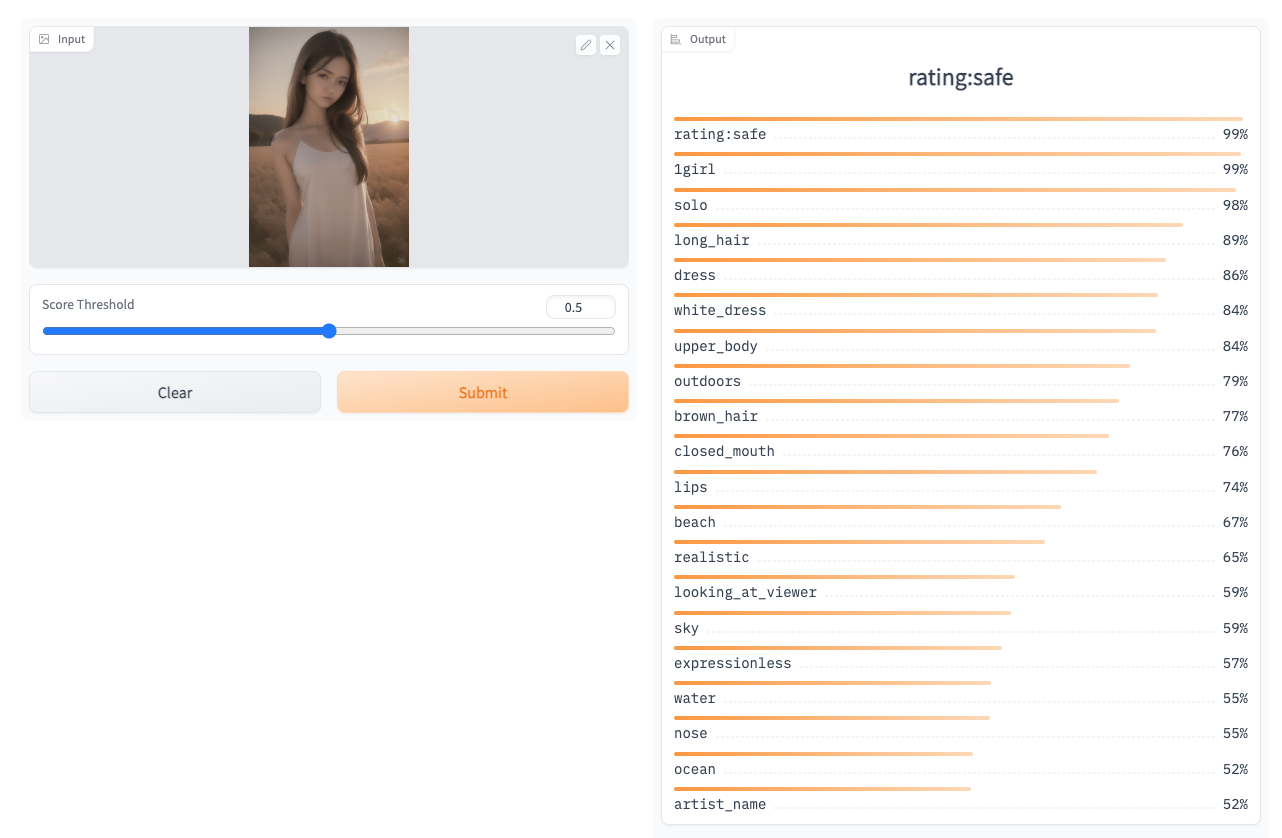

图片打标——iprompt

https://huggingface.co/spaces/hysts/DeepDanbooru

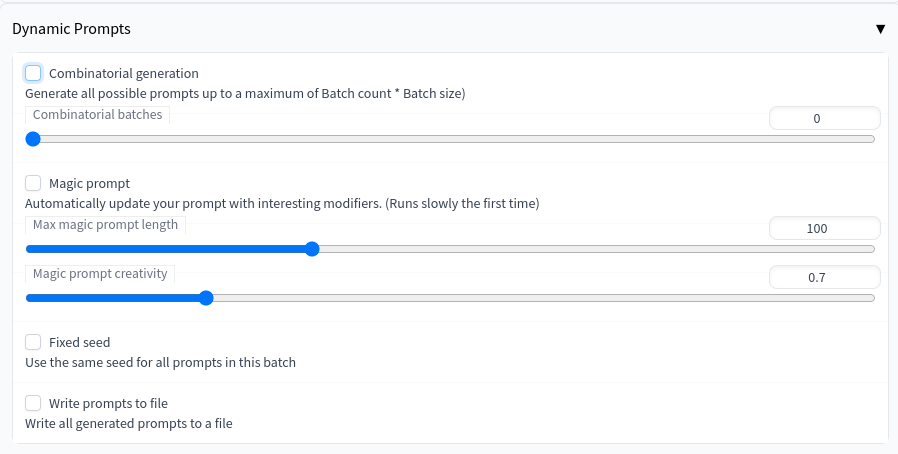

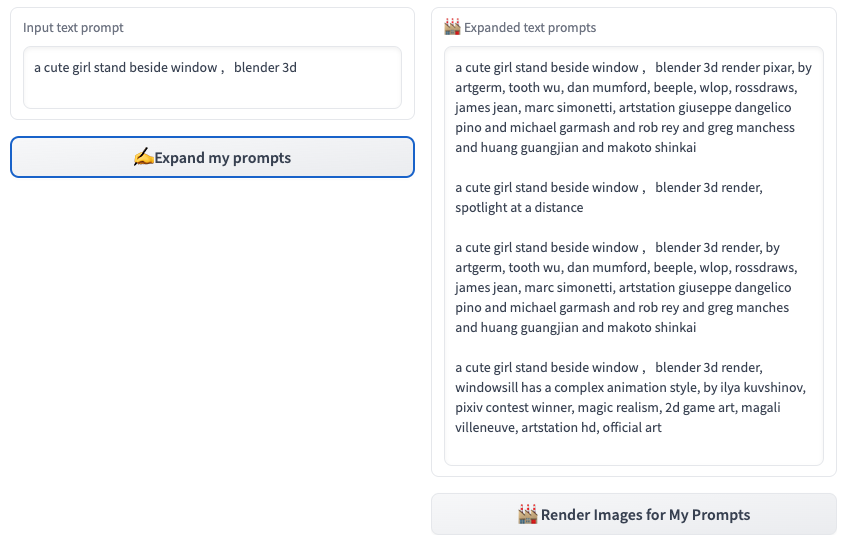

prompt是文本生成图,无中生有的核心。所以prompt的工具其实还有非常多,大家可以日常整理手机,当然我也会持续更新此文档。https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Extensions-Prompt

https://github.com/adieyal/sd-dynamic-prompts

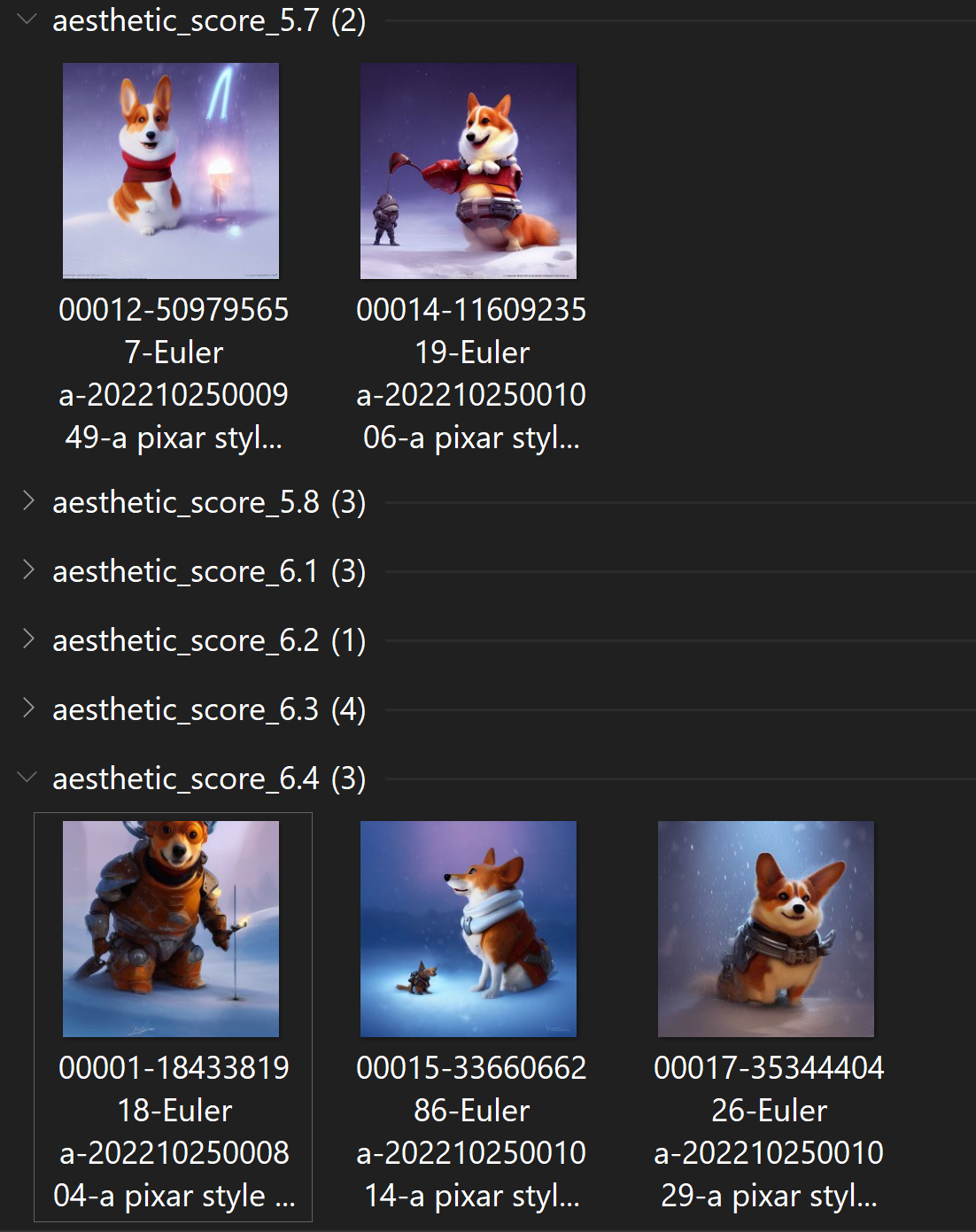

图片质量打分工具

https://github.com/tsngo/stable-diffusion-webui-aesthetic-image-scorer

图片扩充

尺寸调整

这个难点在于如何识别出物体位置、边界然后做图片归一化

https://github.com/nachifur/MulimgViewer

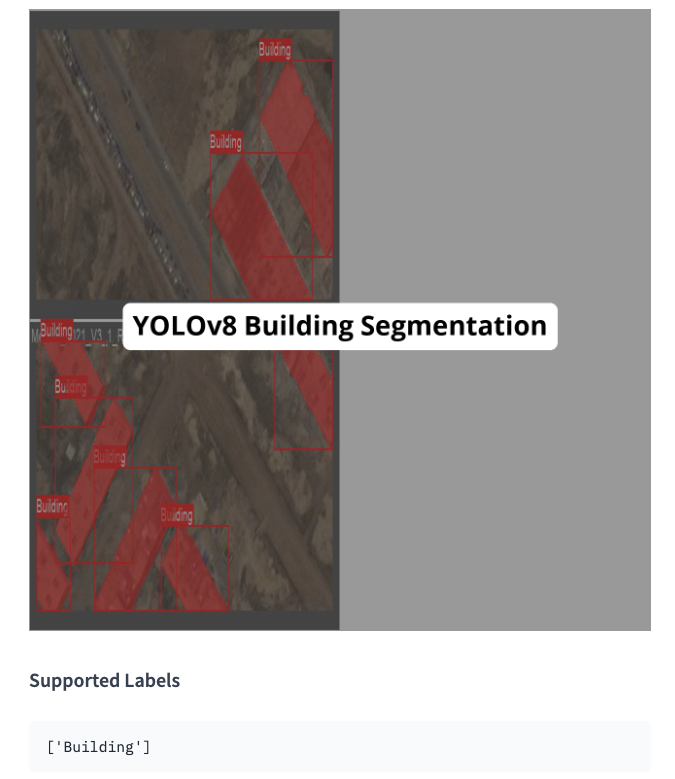

物体边界识别

https://huggingface.co/keremberke/yolov8m-building-segmentation

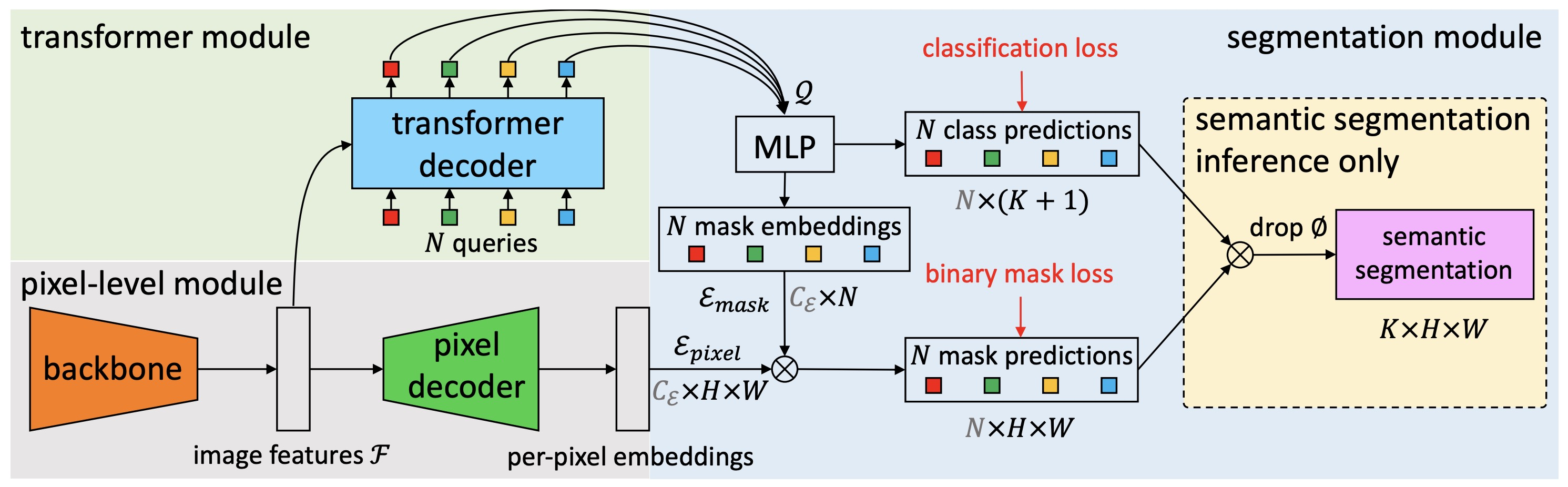

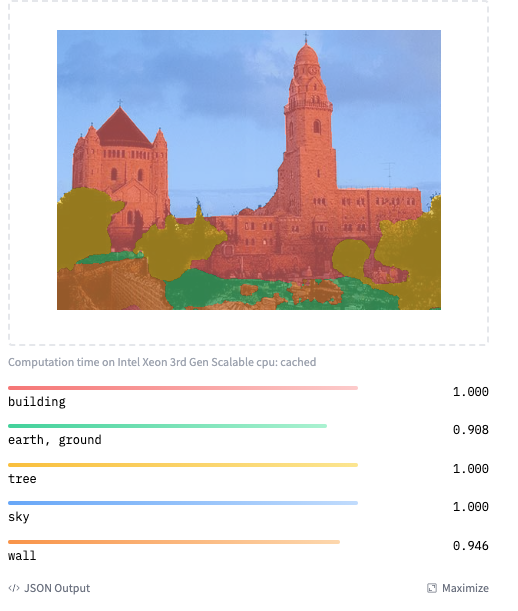

物体轮廓线识别

https://bowenc0221.github.io/maskformer/

内容填充

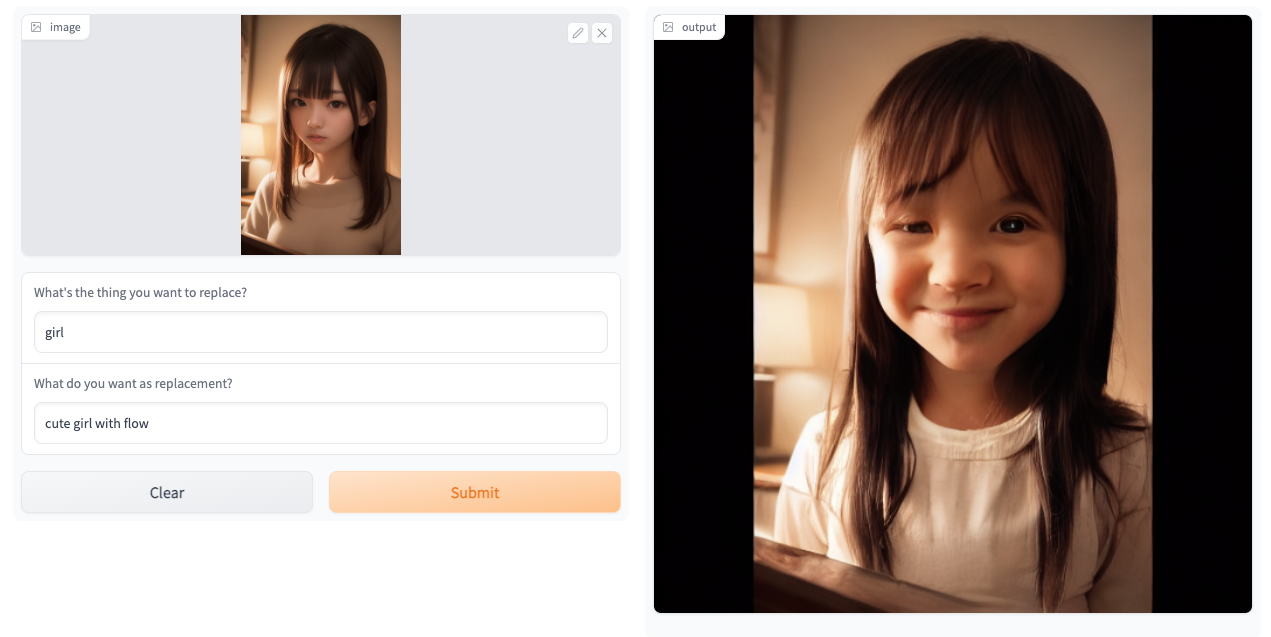

https://huggingface.co/spaces/nielsr/text-based-inpainting

图片增强

https://github.com/albumentations-team/albumentations

人像工具

人脸调整

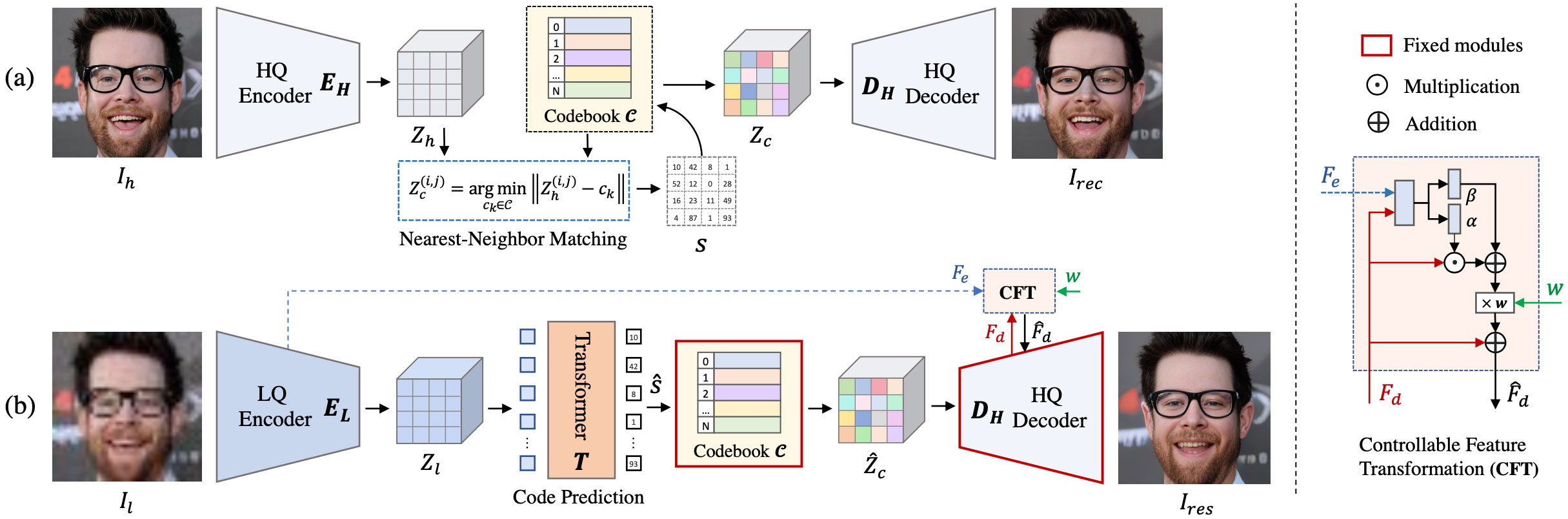

生成清晰的人脸https://huggingface.co/spaces/sczhou/CodeFormer

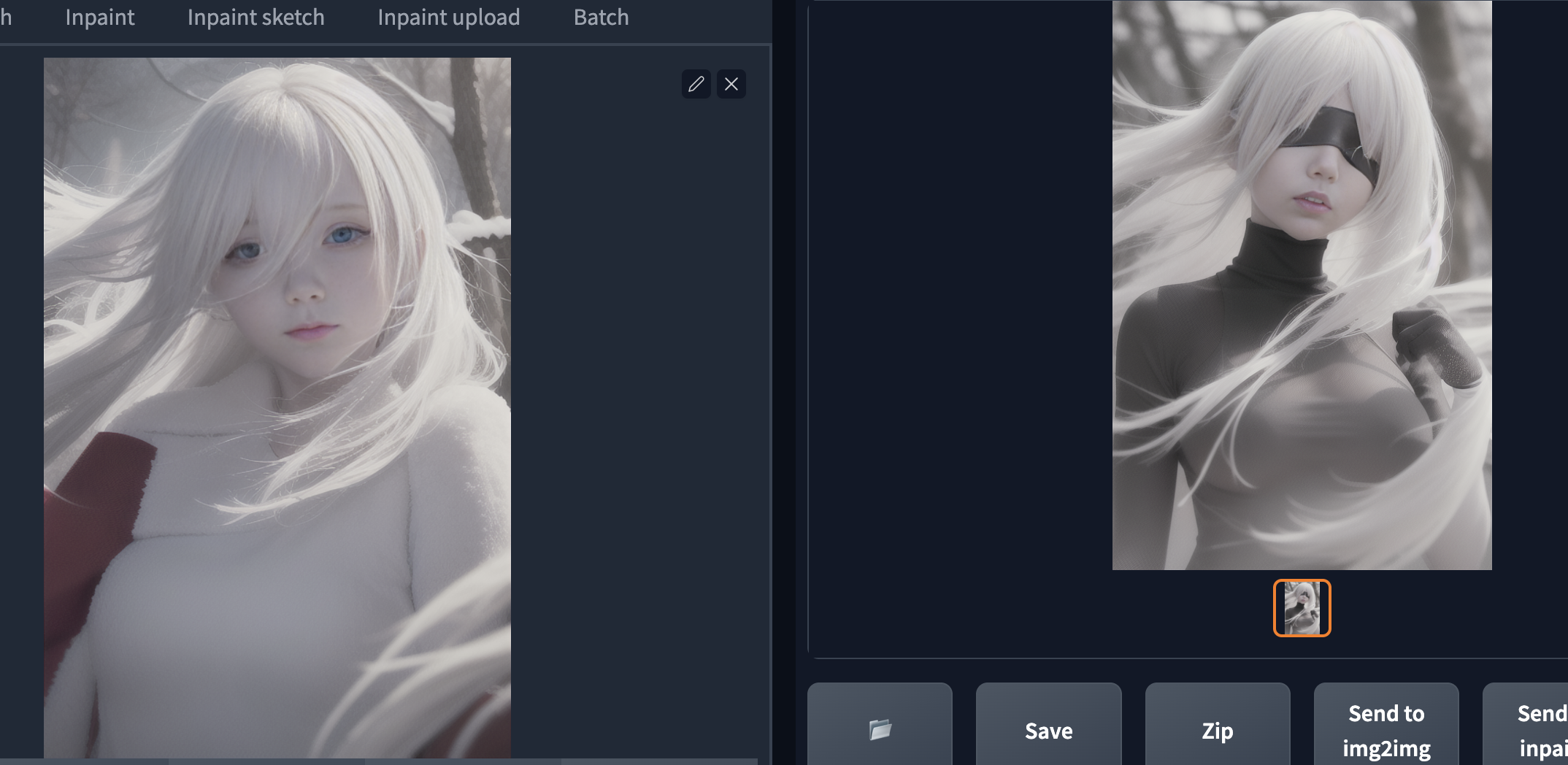

来张实际效果

手指调整

1.如果出现手指可以描述是五个手指

2.利用negative prompt把手指不正常的去处

3.训练一个正面人物手指处理lora

多手调整

1.训练模型时候加重negative prompt人物手的描述权重

2.训练一个人物手脚过滤模型

产图工具

模型

通用内容模型

SD原生模型:

sd1.5、sd2.1

https://stablediffusionweb.com/

写实模型:

dreamlike-photoreal-2.0

二次元模型:

novel ai

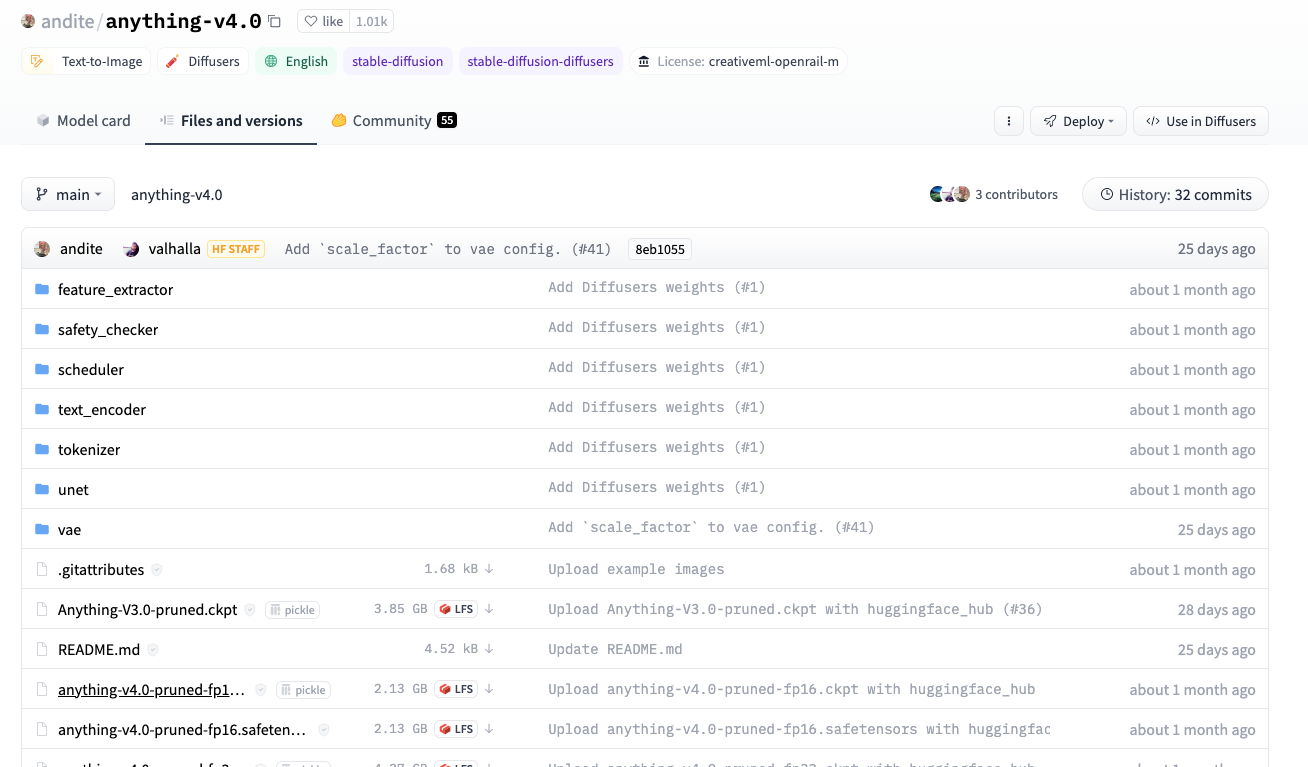

https://huggingface.co/andite/anything-v4.0

专用内容模型

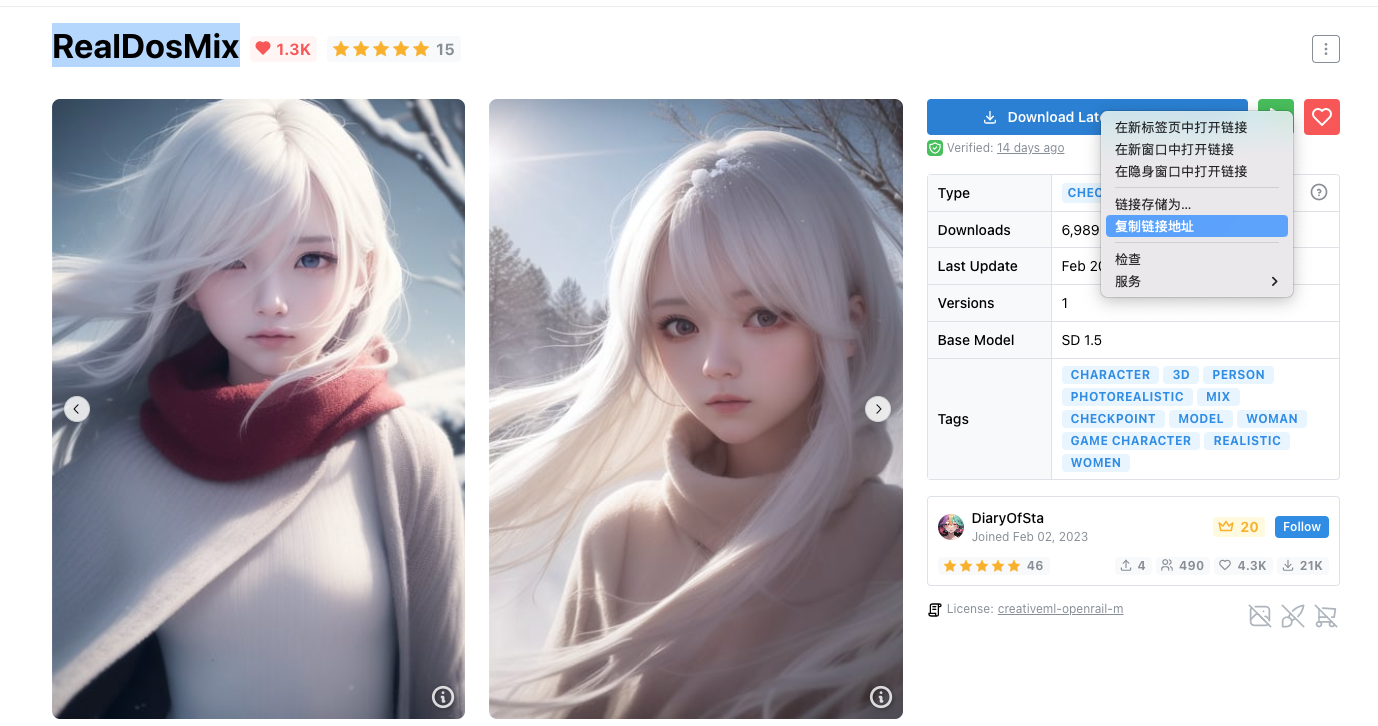

亚洲人脸模型:

https://civitai.com/models/6925/realdosmix)+Realistic

https://huggingface.co/dcy/AsiaFacemix

插画风格:

q萌:kawaye1_6000(Q萌)

厚涂:

FloydianSound/WLOP_Diffusion_v1-5

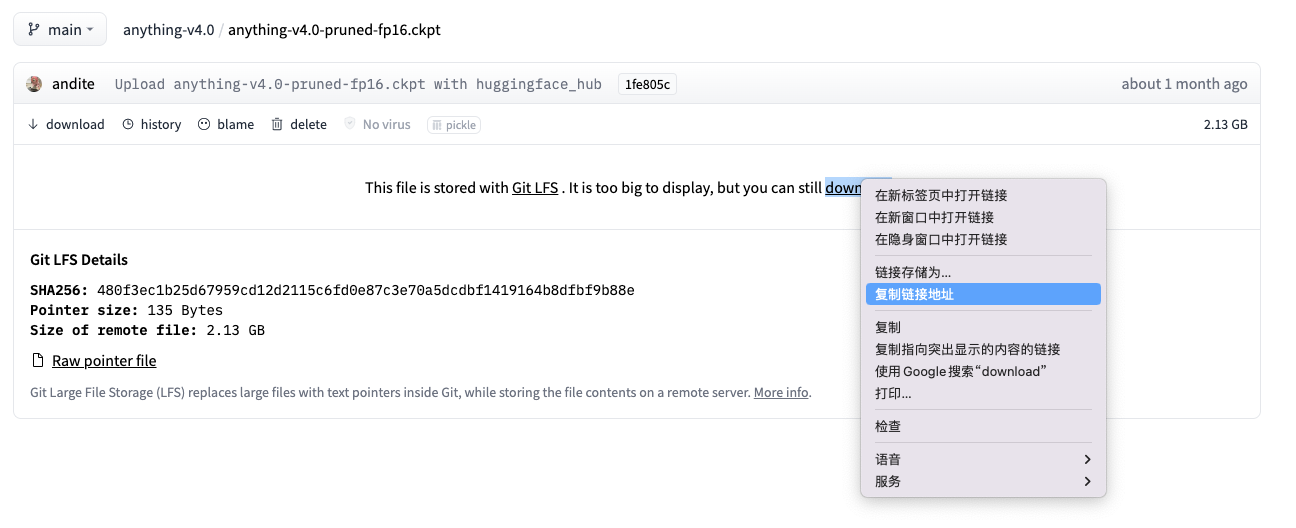

civitai模型如何获取下载地址

huggingface模型如何获取下载地址

第一步:找到卡片页:files and versions

第二步:选择模型点进去

得到模型url地址就可以用:aria2c工具下载

例:

aria2c https://huggingface.co/andite/anything-v4.0/resolve/main/anything-v4.0-pruned-fp16.safetensors

lora层

这里有太多东西可以说,但是基本都是要自己准备数据训练模型来实现。比较考验技术底子,说白了就是你想让模型学习什么。

再记一句话吧,要做真正工业应用的产品,而不只是toy自己训练模型是必须的。并且利用好lora,可以把lora当成功能分层,效果分层类似计算成像的管线路子效果可以做到很震撼。

深度图层

https://github.com/thygate/stable-diffusion-webui-depthmap-script

对图片生成深度图层,可以用在3D或者AR、VR虚拟生成,元宇宙世界中使用。或者可以用在游戏引擎中做角色建模,也可以在3d打印时候使用。

场景环境控制(这块大家还未重视,做独立的场景生成模型)

室内场景

室外场景

光照控制

色系控制

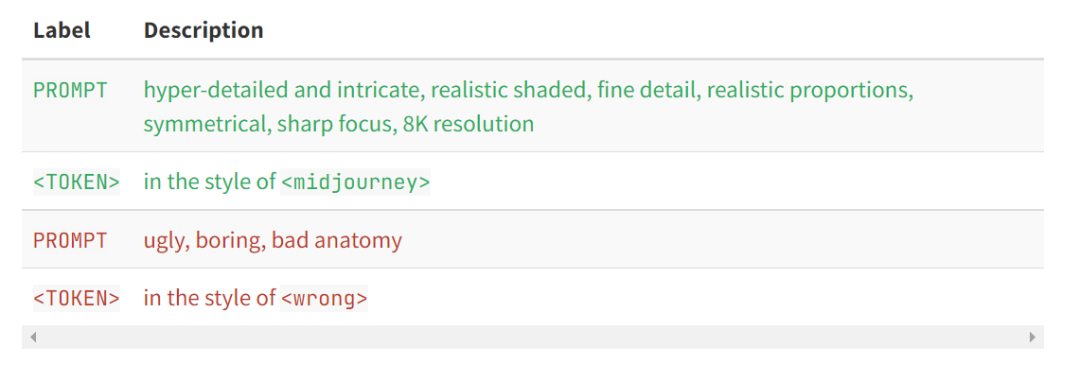

prompt扩写润色

https://huggingface.co/spaces/blairoreilly/merve-chatgpt-prompts-bart-long

https://huggingface.co/spaces/awacke1/PromptRefinery

后效处理工具

图片角色背景融合

多物体融合渲染:https://github.com/Extraltodeus/multi-subject-render

利用深度图扩展,可以根据物体的深度距离创建多物体前景+背景做多物体融合。

多角色融合

https://www.cs.cmu.edu/~custom-diffusion/

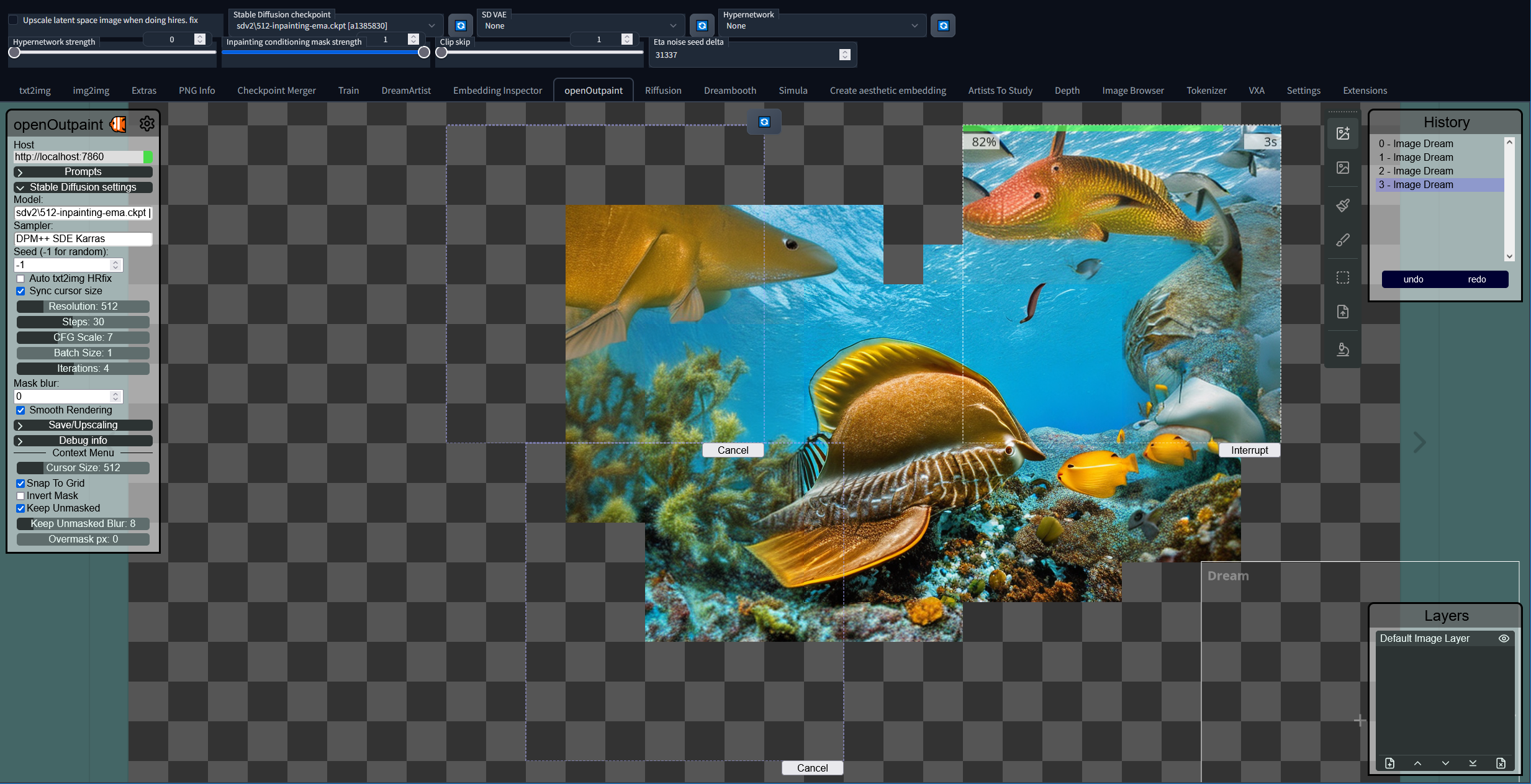

其它工程思路:单独生成角色,然后把多个角色放上来,用outpaint方式来融合

https://github.com/zero01101/openOutpaint-webUI-extension

多物体融合渲染:https://github.com/Extraltodeus/multi-subject-render

利用深度图扩展,可以根据物体的深度距离创建多物体前景+背景做多物体融合。

光照调整

可以通过风格调整来实现,对同一种光照图片做**光照lora

位置调整

角色适合放在场景图片什么位置:可以考虑objectdetector对相似背景下物体放置位置预估,然后吧角色放置合适位置,做后续融合处理

多角色融合时候和场景图片如何做位置调整:可以考虑objectdetector对相似背景下物体放置位置预估,然后吧角色放置合适位置,做后续融合处理

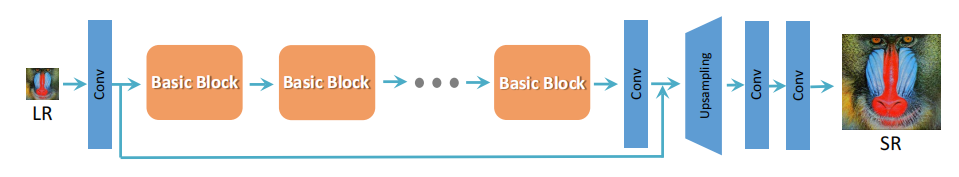

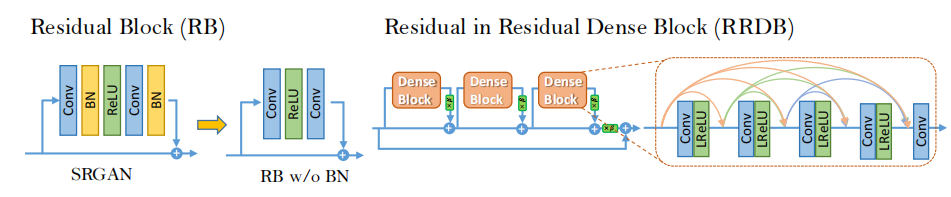

超分

实现生成图片的尺寸放大,图片的高清晰度优化https://github.com/xinntao/ESRGAN

studio易用性工具

多语言插件

https://github.com/dtlnor/stable-diffusion-webui-localization-zh_CN

aria2内容下载工具

高速稳定下载文件:https://aria2.github.io/

提效工具

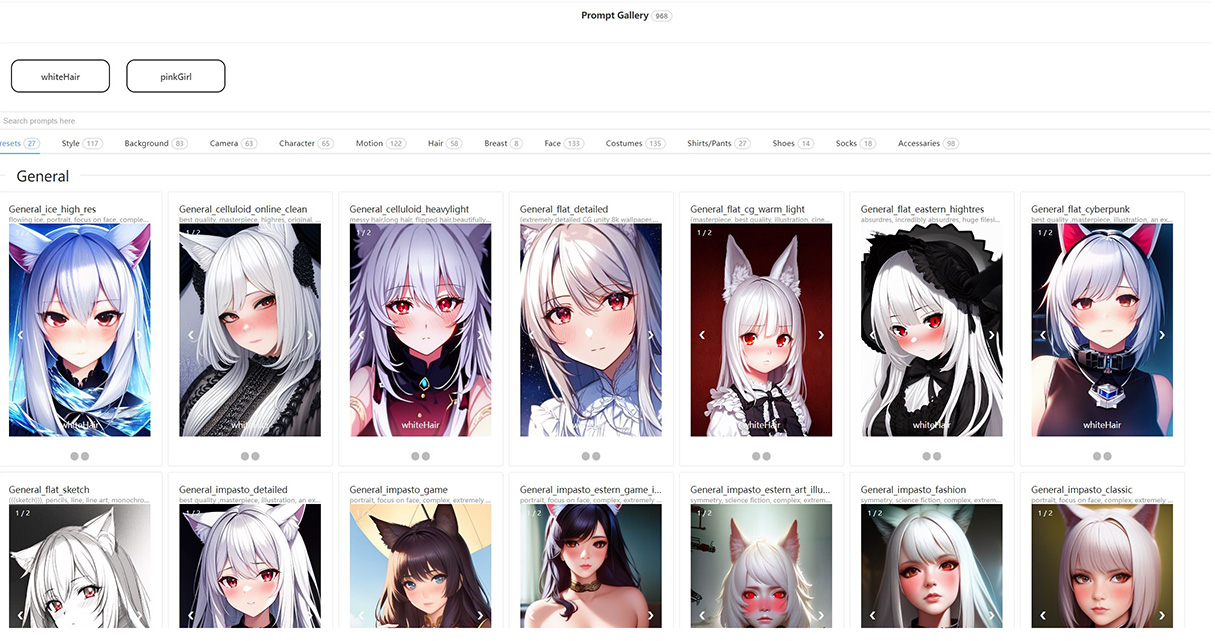

批量prompt效果展示,选择最佳prompthttps://github.com/dr413677671/PromptGallery-stable-diffusion-webui

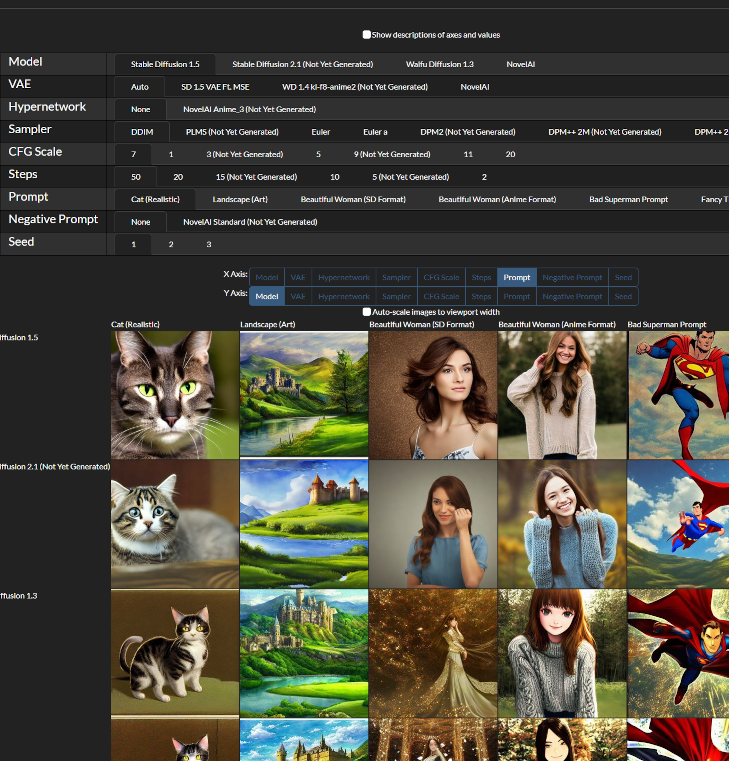

多参数最有效果选择https://github.com/mcmonkeyprojects/sd-infinity-grid-generator-script