热门标签

热门文章

- 1opencv使用dnn模块训练模型_opencv dnn训练

- 2Python上海美食餐厅餐馆商家爬虫数据可视化分析和推荐查询系统 开题报告

- 3MySQL窗口函数(排序函数)_mysql排序窗口函数

- 4Sql insert into 后获得自动插入的id

- 5SQLlite在安卓中的基本详解和简单使用_sqlite在安卓客户端的作用

- 6计算机毕业设计之校园废品回收小程序_校园废旧物品回收小程序

- 7Stable Diffusion - 真人照片的高清修复 (StableSR + GFPGAN) 最佳实践_gfpgan 可见程度

- 8关于腾讯云服务器发送邮件被拦截问题_腾讯云不能使用163邮箱发送邮件

- 9如何对HttpWebRequest异步调用?

- 10golang中的反射--初识(切片)_golang reflect 切片

当前位置: article > 正文

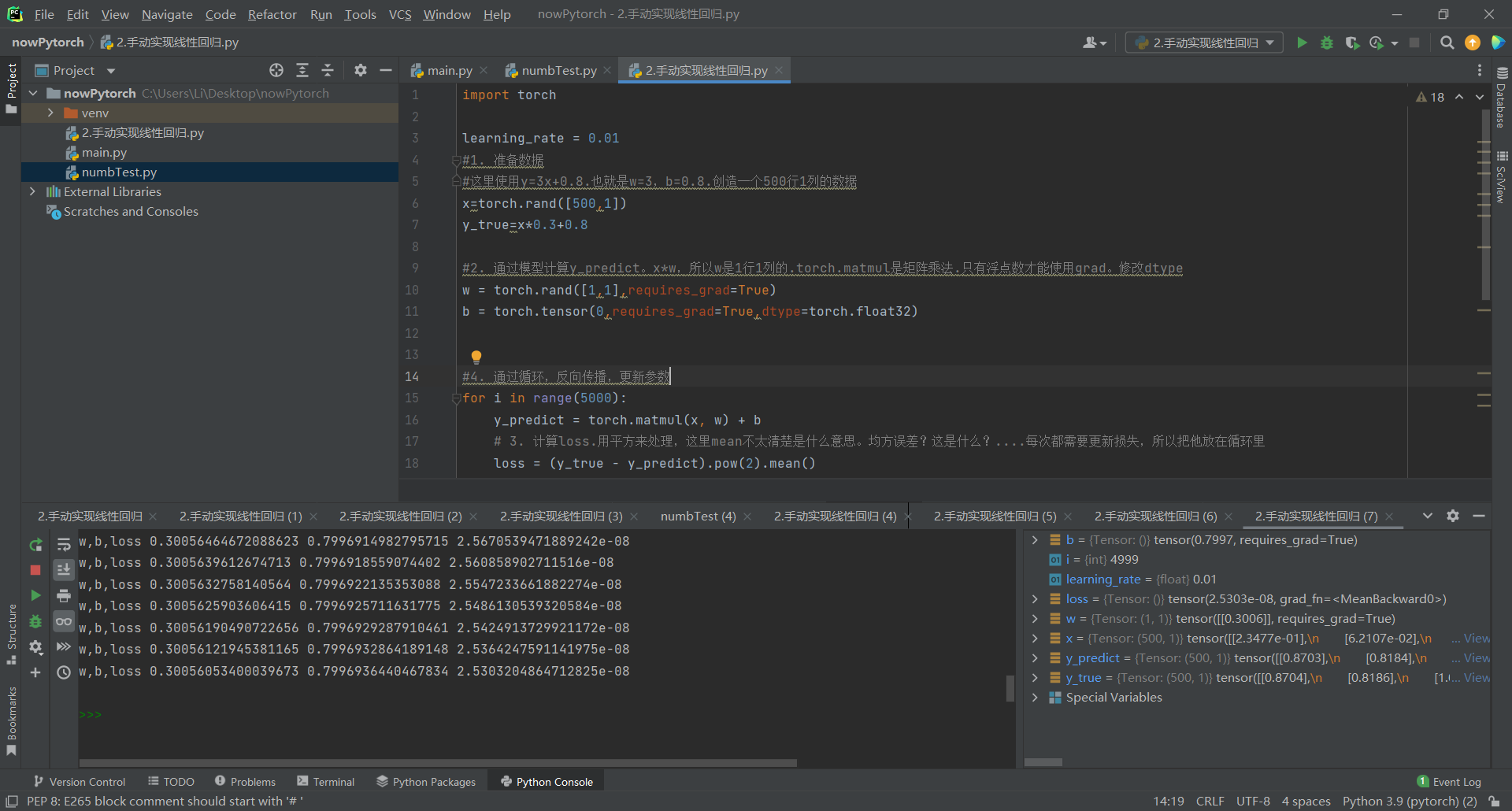

Pytorch线性回归实现(Pycharm实现)

作者:2023面试高手 | 2024-03-09 21:46:01

赞

踩

Pytorch线性回归实现(Pycharm实现)

步骤都在注释里写清楚了,可以自己调整循环的次数观察输出的w与b和loss的值

- import torch

-

- #学习率,用来进行w和b的更新

- learning_rate = 0.01

- #1. 准备数据

- #这里使用y=3x+0.8.也就是w=3,b=0.8.创造一个500行1列的数据

- x=torch.rand([500,1])

- y_true=x*0.3+0.8

-

- #2. 通过模型计算y_predict。x*w,所以w是1行1列的.torch.matmul是矩阵乘法.只有浮点数才能使用grad。修改dtype

- w = torch.rand([1,1],requires_grad=True)

- b = torch.tensor(0,requires_grad=True,dtype=torch.float32)

-

-

- #4. 通过循环,反向传播,更新参数

- for i in range(5000):

- y_predict = torch.matmul(x, w) + b

- # 3. 计算loss.用平方来处理,这里mean不太清楚是什么意思。均方误差?这是什么?....每次都需要更新损失,所以把他放在循环里

- loss = (y_true - y_predict).pow(2).mean()

-

- #每次backward之前梯度置为0

- if w.grad is not None:

- w.grad.data.zero_()

- if b.grad is not None:

- b.grad.data.zero_()

-

- loss.backward() #反向传播.这时w和b的梯度就算出来了w.grad,b.grad

- w.data = w.data - learning_rate * w.grad

- b.data = b.data - learning_rate * b.grad #要注意左边不要写成grad,写成grad之后b的内容就一直是0

- print("w,b,loss",w.item(),b.item(),loss.item())

输出:

可以观察到w接近0.3,b接近0.8。和预想值十分接近了。

问题:

这里的理解有欠缺。。。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/2023面试高手/article/detail/216529

推荐阅读

相关标签