热门标签

热门文章

- 1如何实现一个漂亮的微信小程序朋友圈、表白墙、校内圈(小程序篇,附源码)_小程序开发 朋友圈动态页面

- 2C#初学者的Hello World代码_艾孜尔江撰_c# helloworld代码

- 3学会使用Android Studio网格布局制作计算器界面_使用网格布局,实现一个计算器界面的设计,要求至少有一个控件跨越多行、一个控件跨

- 4win7无法连接远程桌面--必须为远程桌面启用Windows防火墙例外_win7家庭普通版远程桌面必须放通防火墙

- 5stm32cube fatfs tf卡读写 文件系统创建文件 调试笔记 f205_fatfs 新建文件

- 6python定义一个空变量_Python 学习笔记 - Python 变量

- 7人工智能2 -- 大数据时代下的机器学习导论篇_简述基于大数据的机器学习的特点

- 8[VB.NET][C#]调用API获取或设置键盘按键状态_vb.net api接口

- 9SpringCloudAlibaba微服务架构搭建(三)Nacos组件之配置中心(动态取值,纯纯干货)_nacos服务动态配置

- 10Xcode 15 打开工程闪退_xcode15 应用闪退

当前位置: article > 正文

PyTorch——报错解决:RuntimeError: CUDA out of memory. Tried to allocate 20.00 MiB (GPU 0; 3.94 GiB total c_torch.cuda.outofmemoryerror: cuda out of memory. t

作者:2023面试高手 | 2024-03-11 21:20:50

赞

踩

torch.cuda.outofmemoryerror: cuda out of memory. tried to allocate 20.00 mib

1、完整报错

RuntimeError: CUDA out of memory. Tried to allocate 20.00 MiB (GPU 0; 4.00 GiB total capacity; 2.41 GiB already allocated; 5.70 MiB free; 2.56 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

2、原因

batch_size过大,导致内存容量撑不住了。

通过打开任务管理器,我们很清楚的发现,原因就是内存容量不足,导致报错。

3、解决方法

减小batch_size

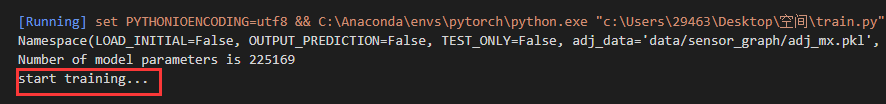

正常运行:

任务管理器检测情况:

参考文章

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/2023面试高手/article/detail/220635

推荐阅读

相关标签