- 1全网最全保姆级VM虚拟机安装配置centos7系统_vm安装centos7

- 2Android连接SQLite数据库_android.连接sqllite

- 3鸿蒙web应用,鸿蒙(HarmonyOS)-Fa应用中WebView的使用

- 4探索云原生时代:技术驱动的业务架构革新

- 5【微信小程序】计算器案例_微信小程序计算器制作

- 6linux修改rc.local权限,CentOS7中rc.local中的指令不能生效问题。

- 7深度解析:Allure报告如何提升你的测试效率?

- 8【Flutter】如何新建项目,运行你的第一个 flutter 工程项目_flutter 终端新建命令

- 9macOS Python安装教程_mac安装python

- 10Django的AbstractUser的几大步骤

深度学习-TokenEmbedding-安装torch-GPU版本_token3embedding

赞

踩

TokenEmbedding:

向量矩阵:

类似字典,第一行为字典里第一个词的词向量;

例子:embedding若为300维,字典中有30000个词

token-embedding维度为:30000(列)*300(行),每一行为一个词向量。

第三行为,字典中第三个字对应的词向量。词向量大小为300维。

若中英文混杂,调用的中文tokenembedding,会将英文当做UNK处理。在特定领域需要自己进行词向量和词表的构建,效果会更好。

NLP任务中的字典:

一一对应关系,例:一个字对应一个索引

根据字典得到索引,就能得到词向量,任务结束后得到索引,根据词典,在返回结果。

深度学习处理NLP任务:

不处理特殊字符,以字为单位。都有对应的embedding

下载anaconda:

Index of /anaconda/archive/ | 清华大学开源软件镜像站 | Tsinghua Open Source Mirror

cuda和cuDNN的关系和对应关系:

https://www.jianshu.com/p/622f47f94784

https://www.cnblogs.com/yeran/p/11345990.html

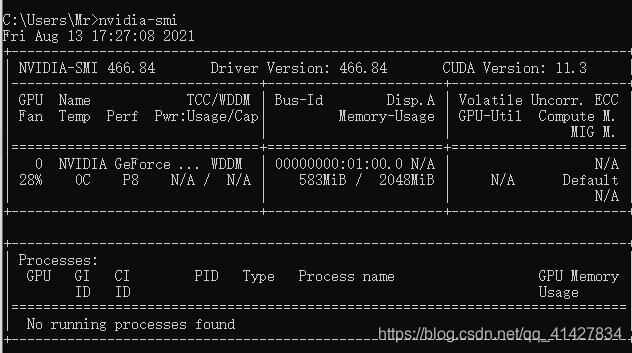

查看cuda版本

win+r

cmd

nvcc --version

查看对应版本

pytorch版本,cuda版本,系统cuda版本查询和对应关系 - 一动不动的葱头 - 博客园 (cnblogs.com)

根据cuda版本下载离线对应torch:

torch-N.x.x+cu110....

torchaudio-0.x.x(x.x版本与上面对应

torchvision-...+cu110...

https://download.pytorch.org/whl/torch_stable.html

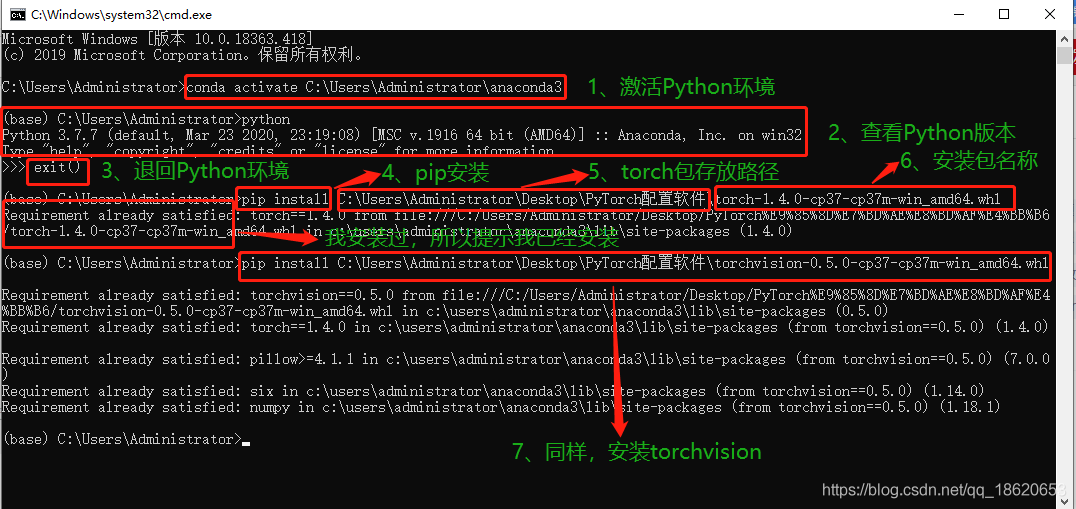

离线安装

图转自(25条消息) 如何离线安装PyTorch_ZiLiangQin的博客-CSDN博客_如何离线安装pytorch

测试torch.cuda命令:

- import torch

- #返回当前设备索引

- # torch.cuda.current_device()

- #返回GPU的数量

- # torch.cuda.device_count()

- #返回gpu名字,设备索引默认从0开始

- # torch.cuda.get_device_name(0)

- #cuda是否可用

- # torch.cuda.is_available()

-

- # pytorch 查看cuda 版本

- # 由于pytorch的whl 安装包名字都一样,所以我们很难区分到底是基于cuda 的哪个版本。

- # print(torch.version.cuda)

-

- # 判断pytorch是否支持GPU加速

- # print (torch.cuda.is_available())

-

-

- # 【PyTorch】查看自己的电脑是否已经准备好GPU加速(CUDA)

- # 那么在CUDA已经准备好的电脑上,会输出:cuda:0

- # 而在没有CUDA的电脑上则输出:cpu

- device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

- print(device)

- ————————————————

- 版权声明:本文为CSDN博主「Gabriel_wei」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

- 原文链接:https://blog.csdn.net/Gabriel_wei/article/details/109897175