- 1【comfyUI插件分享】解放生产力!一键抠图只需要..._comfyui segment anything

- 2“智慧之门:探索未来的9个免费人工智能网站“_免费ai入口

- 3RUST内存安全杂述_rust 为什么安全

- 4云计算学习1——OpenStack云计算安装部署步骤图文并茂(先电2.2)_硬件 部署云计算 简书

- 5【机器学习300问】60、图像分类任务中,训练数据不足会带来什么问题?如何缓解图像数据不足带来的问题?

- 6【Flink实战系列】Flink SQL 实时同步数据到 Hive_flink实时写入hive

- 7SpringBoot+海康威视摄像头实现在前端的预览_海康威视摄像头实时预览嵌套在前端

- 8AI写作生成器哪个好用一点,试试下面这五款

- 9深入理解深度学习——BERT(Bidirectional Encoder Representations from Transformers):基础知识

- 10React驱动的低代码革命:重塑应用开发方式

【NLP基础知识三】词嵌入(Word Embeddings)之“GloVe:单词表示的全局向量”_glove word embeddings

赞

踩

如果你是NLP领域初学者,欢迎关注我的博客,我不仅会分享理论知识,更会通过实例和实用技巧帮助你迅速入门。我的目标是让每个初学者都能轻松理解复杂的NLP概念,并在实践中掌握这一领域的核心技能。

通过我的博客,你将了解到:

- NLP的基础概念,为你打下坚实的学科基础。

- 实际项目中的应用案例,让你更好地理解NLP技术在现实生活中的应用。

- 学习和成长的资源,助你在NLP领域迅速提升自己。

不论你是刚刚踏入NLP的大门,还是这个领域的资深专家,我的博客都将为你提供有益的信息。一起探索语言的边界,迎接未知的挑战,让我们共同在NLP的海洋中畅游!期待与你一同成长,感谢你的关注和支持。欢迎任何人前来讨论问题。

【NLP 基础知识一】词嵌入(Word Embeddings)

【NLP 基础知识二】词嵌入(Word Embeddings)之“Word2Vec:一种基于预测的方法”

【NLP基础知识三】词嵌入(Word Embeddings)之“GloVe:单词表示的全局向量”

5、GloVe:单词表示的全局向量

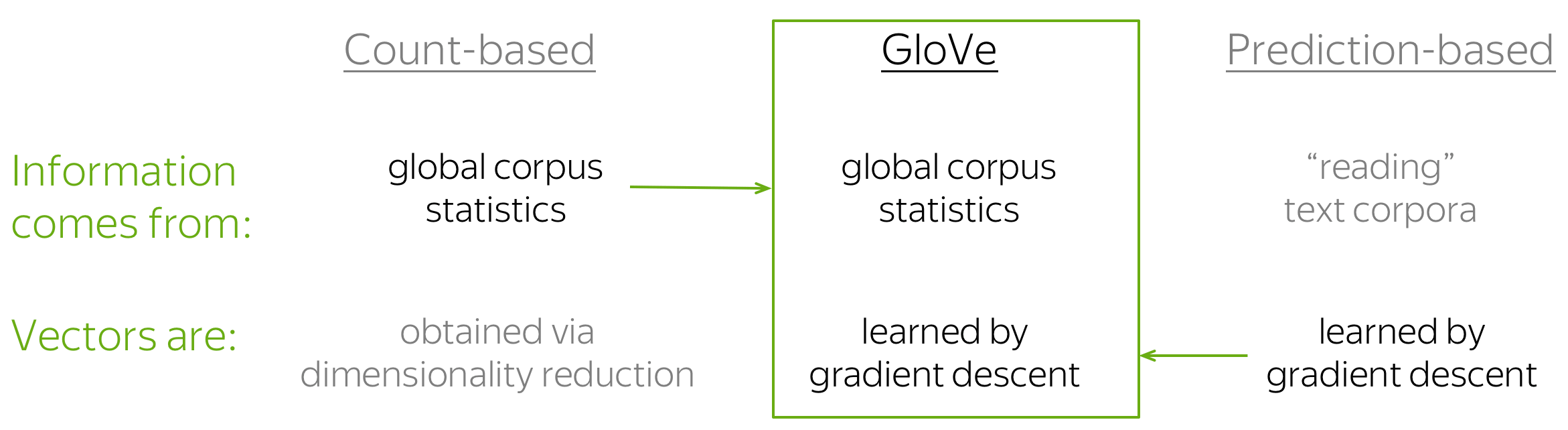

GloVe 模型是基于计数的方法和基于预测的方法(例如 Word2Vec)的组合。模型名称 GloVe 代表 Global Vectors,也体现了它的核心思想:利用语料库中的全局信息来学习词向量。

正如之前所见,最简单的基于计数的方法使用共现计数来衡量单词 w 和上下文 c 之间的关联:N(w, c)。类似地,GloVe 也使用这种计数来构建损失函数:

与 Word2Vec 类似,Glove 也有中心词向量和上下文词向量的区分,这二者构成了Glove的参数。 此外,该方法对每个词向量都引入了一个标量偏置项 (即上图的 b)。

有趣的地方在于,GloVe 控制了少见词和频繁词的影响:对每对 (w, c) 而言,损失将以如下方式加权:

- 对于罕见的 (w, c),损失会受惩罚,

- 对于频繁出现的 (w, c),损失也不会被过度加权。

6、词嵌入的评价

我们如何评价一种获取词嵌入的方法要比另一种更好呢?目前学术界有两种评估手段(不仅适用于词嵌入):内在评价和外在评价。

编者按:下文中我们使用词嵌入 (Word Embeddings) 来指代词向量 (Word Vectors),但实际上它们是一个东西。

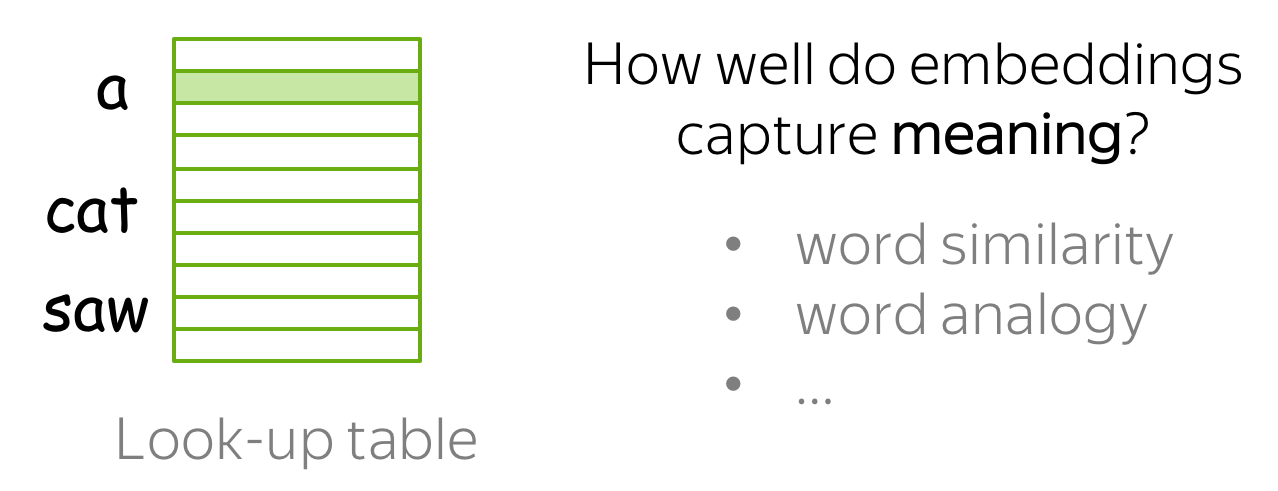

内在评价:基于内在属性

这种类型的评价着眼于词嵌入的内在属性,即它们捕捉单词“含义”的程度。在分析与解释部分,我们将详细讨论如何通过词相似性和词类比任务上评价词嵌入。

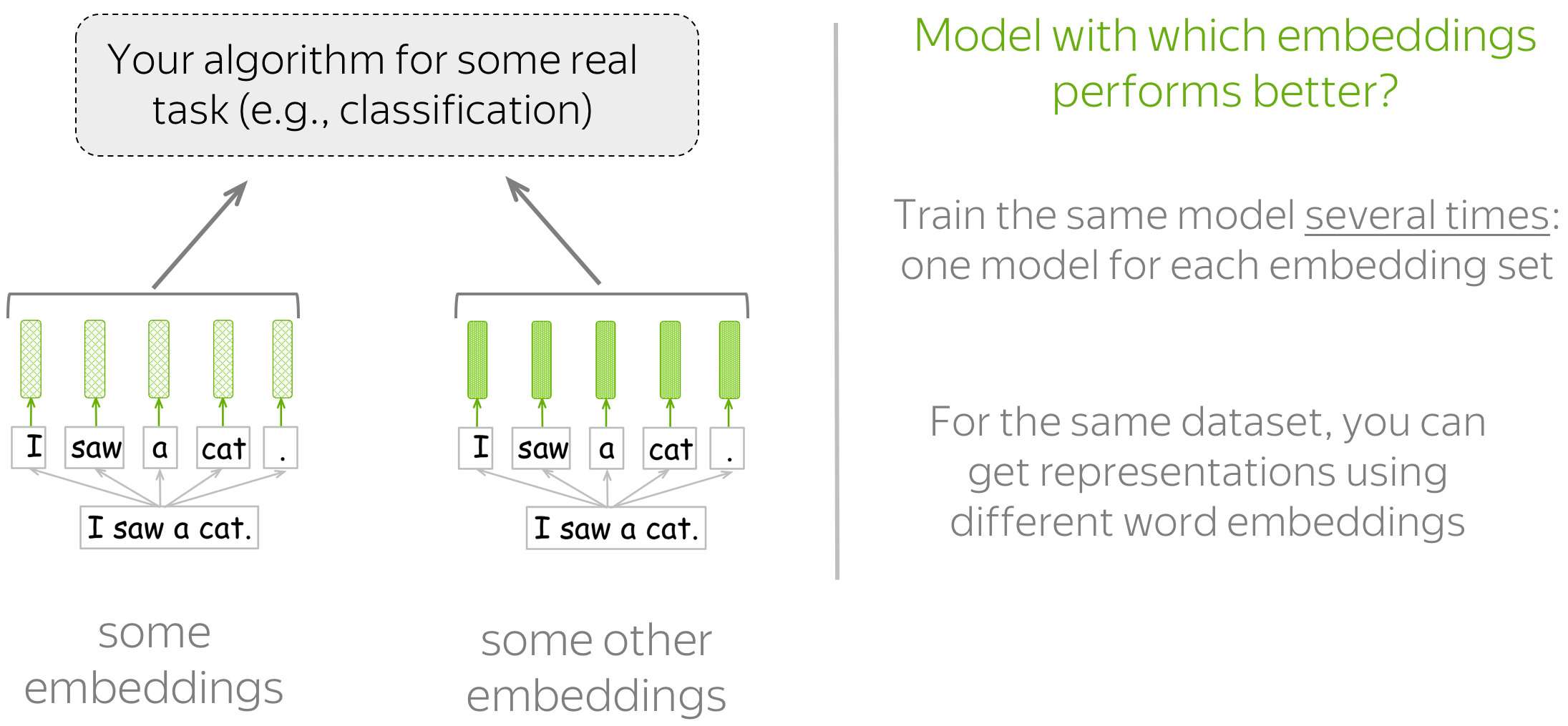

外部评价:基于下游任务

这种类型的评价会告诉读者哪些嵌入更适合读者真正关心的任务(例如,文本分类、指代消解等)。

在这种情况下,你必须为下游任务制定一个可以搭配不同词嵌入方法的模型。然后,通过模型的性能来确定哪些词嵌入方法更好。

如何选择

你必须要接受的是,没有完美的词嵌入,也没有适用于所有情况的词嵌入:它总是取决于很多事情。

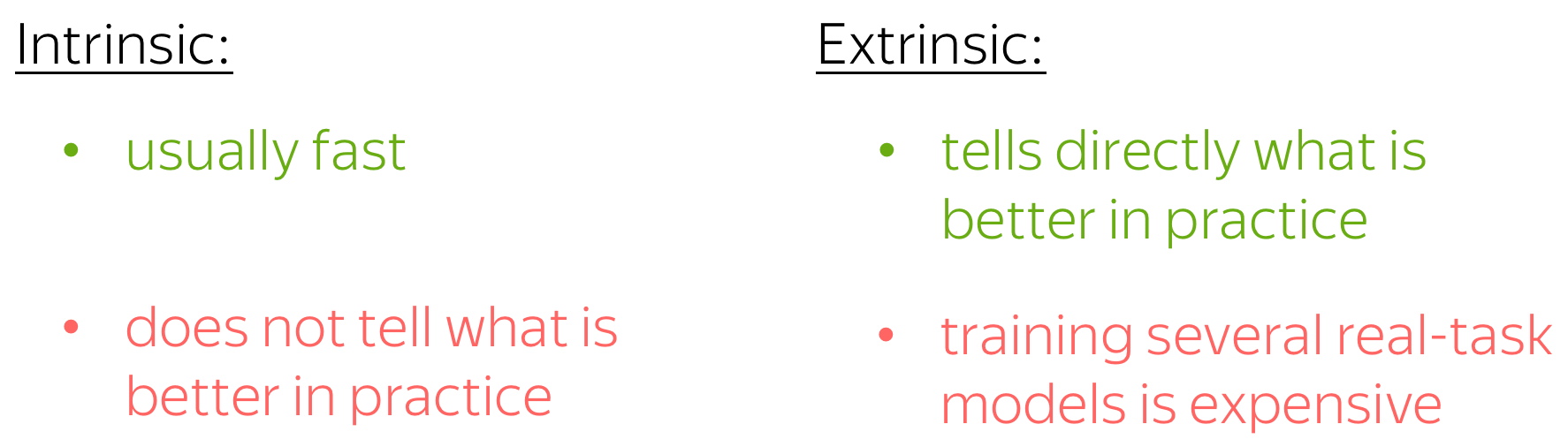

关于评价,您通常更关心下游任务本身的性能。 因此,读者可能会对外部评价更感兴趣。 然而,下游任务上的模型通常需要大量的时间和资源来训练,尤其是当你需要训练多个的时候,训练成本可能过于昂贵。

至于选择哪个词嵌入,最后还是要取决于读者自己

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。