- 1Hadoop项目实战3—招聘数据预处理_基于hadoop的招聘数据分析项目

- 2MySQL 之 InnoDB引擎 Log Buffer

- 3Windows —— SMTP服务器_iis搭建stmp服务器 win11

- 4【论文笔记】Skills Regularized Task Decomposition for Multi-task Offline Reinforcement Learning

- 5Flink 侧输出流(SideOutput)_flink侧输出流

- 6笔记:立体视觉涉及的相机模型、参数、3D坐标系、内外参计算等

- 7大语言模型与知识图谱的融合在心理学领域的应用_语言模型与知识图谱在心理学领域的应用

- 8IaC 管理新思路:Walrus 和 Terraform 的差异化探索

- 9【微软技术栈】使用(TAP)基于任务的异步模式_c#异步编程框架 tap

- 10RemoteApp服务器显卡的作用,windows 8 Ts RemoteApp的作用及范例

厂商踊跃、数据中心观望 液冷距离爆发还差一场风

赞

踩

近年来,液冷技术在数据中心领域的遭遇可以用一个词形容:又冷又热。

技术冷:作为冷却介质,液体的冷却效能远远高于空气,所以在冷却效果上比风冷更“冷”一筹。

关注热: 随着技术发展与产业环境、政策变化,液冷再度受到行业关注,且热度持续增加。

产品热:数据中心产业上游的设备厂商对液冷热情高涨,相关产品与研发层出不穷,产业下游的云厂商们也开展了不同程度的技术探索。

应用冷:产业中游的数据中心对液冷态度谨慎,尚无数据中心企业宣布液冷规模化部署计划。

液冷为何突然在数据中心领域热起来?产业“冷”“热”差别的原因何在?液冷技术在数据中心的应用离爆发还有多久?笔者试为你梳理解析这些问题,并给出个人判断。

液冷非一日之寒 计算愈来愈热

展开讨论前,先明确液冷的定义:液冷是使用液体作为热量传输的媒介,为发热部件换热带走热量,传递到远处再进行冷却,实现散热的技术。

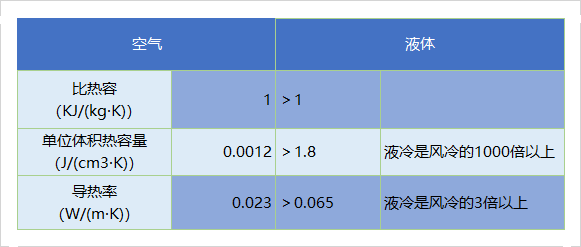

相较于风冷以空气为冷却媒介,通过风扇和压缩制冷,液体的比热容远高于空气,单位体积热容量是风冷的1000倍以上,热量传导效率更高。

液冷与风冷相关性能对比

液冷与风冷相关性能对比

这一原理很早就被发现,并被最早应用于工业、航天领域的散热,至今被使用的“冷板”一词据说就来源于阿波罗登月计划,将液冷用于宇航员体温控制。

在数据中心领域,液冷始终与计算产生的热量紧紧联系在一起。

萌芽:

上世纪60~90年代,数据中心还被称为“机房”,采用集成电路的大型主机进行高速数据处理时有过热宕机的风险,以IBM为首的厂商研发了液冷系统应用在大型主机,并取得显著效果,其中就包括著名的IBM360/91型計算机。

遇冷:

计算技术的迭代,使得液冷随后“遇冷”。

上世纪末,随着超大规模集成电路取代晶体管,在计算效率提升的同时,计算机和芯片产生的功耗、热量断崖式下跌,风冷的散热效率足以满足。在成本、安全顾虑、部署简易性等因素影响下,风冷超越液冷成为数据中心的主流散热技术。

兴起:

高密度计算兴起,液冷再受青睐。

后摩尔定律时代,芯片功耗与服务器功耗逐步上升,数据中心单机柜功率密度也不断增大, 2020年数据中心平均机柜功率已增长至8.5KW,传统风冷散热在换热性能及能耗上面临瓶颈。业内普遍认为,传统风冷已经无法满足高密度计算的发展需求,正如中国信通院云大所所长何宝宏表示“再大的风也吹不冷滚烫的‘芯’了”。

因此,液冷于近年来再度进入数据中心视野,逐渐受到业界关注。

液冷数据中心:更好散热 更低能耗

时移世易,面对当前计算技术与散热需求,在数据中心应用液冷技术的优势正日渐显现。

首先是散热效率。据绿色网格研究,每机柜 15-25 kW 的功率密度是“未使用背板换热器等其他制冷设备”的风冷解决方案上限,而液冷系统可以支持的机柜功率是两倍以上,甚至可以扩展到单机架超100kw。液冷可以支持数据中心高功率的散热,提高换热效率,且能减少服务器散热热点,有效抑制元件内部温度的瞬间提升,延长芯片寿命。

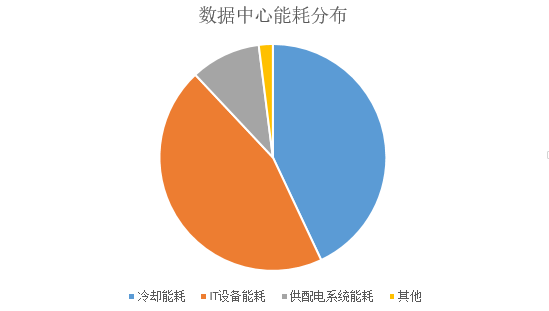

传统高耗能风冷数据中心各部分能耗占比

其次节能降耗。与传统风冷技术相比,液冷系统耗电量方面约比风冷系统节省电量30%-50%。要知道,在传统数据中心,制冷系统占数据中心整体能耗的40%以上。数据中心使用液冷可有效降低能耗,提高能源利用效率,降低PUE值和电力成本。

第三,提高计算密度,减少风扇震动噪音。相较于传统风冷,液冷数据中心去掉了空调系统和对应的风冷基础设施,也不需要设置冷暖通道,节省了大量空间可以容纳更多服务器,提高计算密度和可销售空间。不同液冷方式可减少或避免风扇的使用,有效降低震动和机房噪音,而震动会直接影响IT系统的稳定性和寿命。

综合来看,数据中心液冷技术,既契合了计算的未来高功率趋势,满足服务器芯片散热需求,又能实现数据中心节能降耗,正愈发受到数据中心产业的广泛关注。

产品与技术创新不断 上游设备厂商踊跃

近些年,很多企业展开液冷在数据中心应用的研发,形成了多种部署方式和产品。

部署最多、服务器不直接接触液体,不需要对数据中心机房进行重新改造的冷板式液冷。

将发热器件完全浸没在冷却液中,散热效率更高,实施难度更大需要对机房其他系统改造的浸没式液冷。

别具一格,将冷却液直接喷淋到发热器件表面进行热交换的喷淋式液冷。

不同液冷方式、代表产品及厂商,笔者一年前曾撰文《泡澡、淋浴、冷气片——数据中心液冷模式与应用一览》。

阿里云在IDCC大会现场展示的浸没式液冷模块

阿里云在IDCC大会现场展示的浸没式液冷模块

时隔一年,液冷在数据中心的热度更盛,各大设备厂商纷纷发力,有的首度推出液冷产品,有的将液冷上升为发展战略,上游产品、解决方案频出,各有侧重:

去年12月的“第十六届中国IDC产业年度大典”上,专注浸没式液冷进行多年自主研发的阿里云正式向业界发布行业首款单相浸没液冷解决方案——磐久液冷一体机系列Immersion DC 1000。据阿里云数据,该解决方案可在全球任何气象区域部署并可轻松实现极致PUE1.09。

2022年初,浪潮信息将“All in液冷”写入公司战略,全栈布局液冷,实现了全产品线支持冷板式液冷。浪潮信息表示,可以实现液冷从核心部件到整体解决方案全覆盖,提供液冷数据中心从规划咨询到设计施工的全生命周期交付。

2022年初,宁畅推出了新系列液冷服务器,该系列包含高密度、通用机架等多品类产品,可适用于众多IT应用场景。随后在液冷服务器基础上,推出全系统定制液冷方案,实现从需求梳理、架构设计、机房部署到运维服务的全系统定制。

2022年4月,新华三发布新一代冷板式液冷系统解决方案。该液冷系统由H3C UniServer R4900LC G5 液冷服务器、42U通用机柜、分布式CDU等部件组成,通过了中国计量科学研究中心的能源计量认证,夏季模式PUE可达1.047,整机全年平均PUE1.042。

今年下半年,科华数据陆续发布多款数据中心液冷产品:科华数能S³液冷储能系统、针对边缘计算中心和中小型中心节能改造的抽屉式水-风液冷CDU、板式液冷微模块数据中心。该微模块数据中心冷循环系统采用机柜式CDU-300KW,散热量可达300KW。

……

可以看出,过去一年中,数据中心液冷产品更加丰富,技术进一步加强,商业化进程加速。

顾虑几重 数据中心观望

如果只是一篇普通文章,写到这里,得出“数据中心液冷形势一片大好”的结论就足够了。

然而,笔者梳理过近两年来数据中心液冷领域的动作后发现,大部分来自产业上游的设备厂商,服务器、CDU(数据中心液冷分配装置)、TANK(机柜液冷柜)、CPU/GPU、冷却液、整体解决方案,尤以服务器厂商为甚。产业下游,也仅有以阿里云为首的几家云厂商,基于自身业务需求和技术先进性等因素,进行液冷研发与部署。

这其中,少了最不可或缺的产业中游——数据中心企业的身影。

据笔者了解,相较于上游厂商的踊跃态势,仅个别企业按客户需求提供了机房改造部署,大部分数据中心对液冷仍持观望态度:认可液冷的散热与节能优势,会主动了解液冷产品、技术细节,在内部做学习或小型探索,但无公开的大规模液冷部署行动和计划。

笔者收集了数据中心对液冷技术的诸多顾虑:

可靠性。数据中心第一要务是保障业务连续性,浸没和喷淋式会直接接触电子器件,是否会出现器件腐蚀情况,包括冷板式在内,冷却液泄露怎么办,服务器功能和使用寿命是否会受影响,液冷技术的可靠性是数据中心、用户的最大担忧。

部署难度。液冷不仅仅改变制冷系统,数据中心的服务器、网络设备、监控系统等都要随之改变,新建数据中心从设计到建设、调试运维都与此前不同,此前项目经验等无法复用,周期长难度大。存量数据中心的承重、管路等设计因循传统机架,如果进行液冷部署改造,同样会带来新增成本、部署难度问题。

运维与售后。无论冷板、浸没还是喷淋,液体进入到IT机柜内部,给建设、测试和运维带来新的挑战,目前缺乏成熟的运维经验和标准化要求。此外,有数据中心提出,液冷的服务器等产品售后维修政策也尚不成熟。

成本。虽然液冷能耗低所以数据中心OpEx降低,但前期CapEx明显高于风冷数据中心。哪怕忽视液冷服务器、CDU等设备的价格,单冷却液价格也并非小数目,阿里云就曾对外表示“使用的冷却液价格堪比茅台”。

除去上述疑虑,数据中心对液冷“谨慎”的最根本原因,在于液冷的市场接受度——数据中心的互联网、电商、视频、金融等用户大多尚不接受液冷。

液冷主流成必然 爆发尚欠一阵风

提高新技术的接受度是一个漫长的过程,如今政策为液冷按下了快进键。

由于用电量大,社会普遍将数据中心定义为高耗能产业,随着“2030年碳达峰、2060年碳中和” 战略目标提出,数据中心面临的能耗限制愈来愈严。

“

2021年7月,工信部印发的《新型数据中心发展三年行动计划(2021-2023年)》要求:“到2023年底,新建大型及以上数据中心PUE降低到1.3以下,严寒和寒冷地区力争降低到1.25以下。”

“

2021年12月,发改委等四部门发布的《贯彻落实碳达峰碳中和目标要求推动数据中心和 5G 等新型基础设施绿色高质量发展实施方案》表示“新建大型、超大型数据中心电能利用效率不高于 1.3,逐步对电能利用效率超过 1.5 的数据中心进行节能降碳改造。”

中央及各级主管部门政策对数据中心PUE考核提出更严要求,各地能评指标持续收紧,数据中心面临前所未有的能耗和散热挑战。多位数据中心企业高管向笔者表示,上述政策的出台,使得“液冷成为必然”,严格政策限制下“数据中心要想合规,PUE值再继续往下降,只能靠液冷了。”

过去一年以来,双碳政策助推下,液冷技术的研发投入加大、产品和技术成熟度不断提高,液冷在数据中心的发展前景毋庸置疑。

但要想实现液冷在数据中心的爆发,不仅仅欠缺全产业的共同努力,欠缺更多行业标准的制定与完善,还差一场风,一场拥有最强驱动力的风——市场需求。

从萌芽到如今再度兴起,液冷的发展始终源于计算的散热。

如今政策、技术条件都已经具备,当下一波海量数据计算爆发式增长,带动市场对数据中心的需求爆发时,液冷才将真正迎来在数据中心的爆发。

这个时间或许是两年后、四年后,又或许,很快来临。

| 文章来源:中国IDC圈

资料免费送(点击链接下载)

史上最全,数据中心机房标准及规范汇总(下载)加入运维管理VIP群(点击链接查看)

扫描以下二维码加入学习群