- 1计算机网络经典面试题30问_计算机网络技术面试会问什么

- 2信息系统项目管理笔记_信息系统项目管理中级笔记

- 3【PostgreSQL】在DBeaver中实现序列、函数、视图、触发器设计、数据结构新增(持续更新于20240426)_dbeaver创建触发器

- 4【安全】linux audit审计使用入门_audit权限

- 5【数据库原理及应用】期末复习汇总&高校期末真题试卷10_数据库原理与应用课程设计期末考试题

- 6Android解决报错 superclass access check failed: class_superclass access check failed: 好像在gradle.properti

- 7TCP协议详解(TCP报文、三次握手、四次挥手、TIME_WAIT状态、滑动窗口、拥塞控制、粘包问题、状态转换图)_tcp握手报文

- 8路由器重温——OSPF路由(很重要的协议)-2_type area interarea

- 9Centos8停止更新维护后源失效问题_cendos 维护过期

- 10用python编写用户登录界面,python编写登录窗口_python界面设计账号密码登录

Datawhale出品:《GLM-4 大模型部署微调教程》发布!

赞

踩

Datawhale开源

开源贡献:Datawhale self-llm团队

前言

就在昨天,智谱 AI 发布了最新开源模型 GLM4,通过 10T 高质量多语言数据与更先进的训练技术,达到了更加出色的生成效果。

在仅有 9B 参数的前提下,在中文能力、长文本能力以及工具调用等任务中达到了更加出色的效果。

更多测评细节详见:

GLM-4最新开源版本硬核测评!Datawhale成员万字测评(一)

开发者视角看GLM-4-9B!Datawhale成员万字测评(二)

教程介绍

秉承开源贡献的宗旨,Datawhale团队成员在模型发布 12 小时 之内,为 编写了GLM-4整套教学流程,包括:

模型 api 部署;

Langchain 接入;

WebDemo 部署;

vLLM 部署;

LoRA 高效指令微调。

教程除提供过程代码外,还贴心为学习者提供了训练数据与 Autodl 环境镜像,方便学习者一键运行!!

项目地址:

https://github.com/datawhalechina/self-llm/tree/master/GLM-4

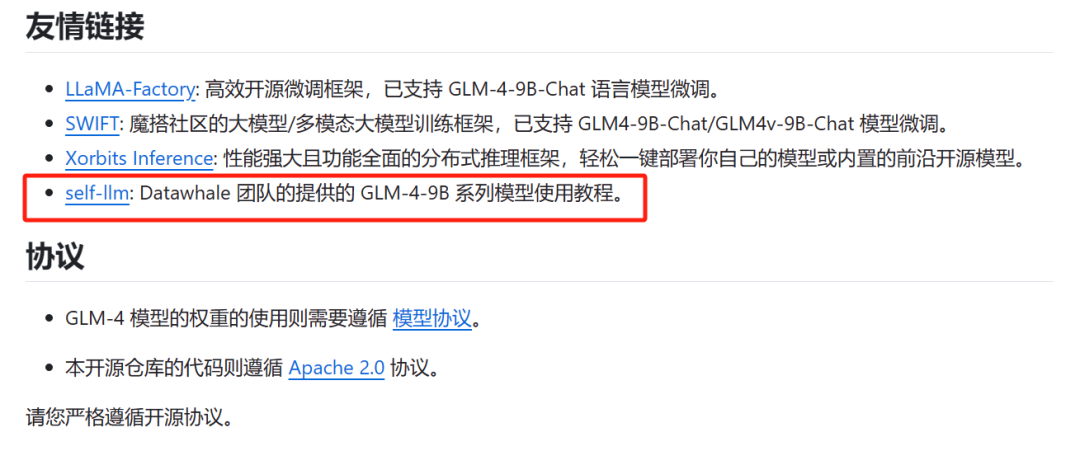

目前项目已被智谱官方推荐学习:

这里我们抽取一部分内容供大家了解本次教程~

LoRA 高效指令微调

首先通过分析子词嵌入模板,从而构造指令微调数据。教程通过对模板编码前后进行可视化复查,并逐一检查特殊子词编号,从而确保嵌入对应。

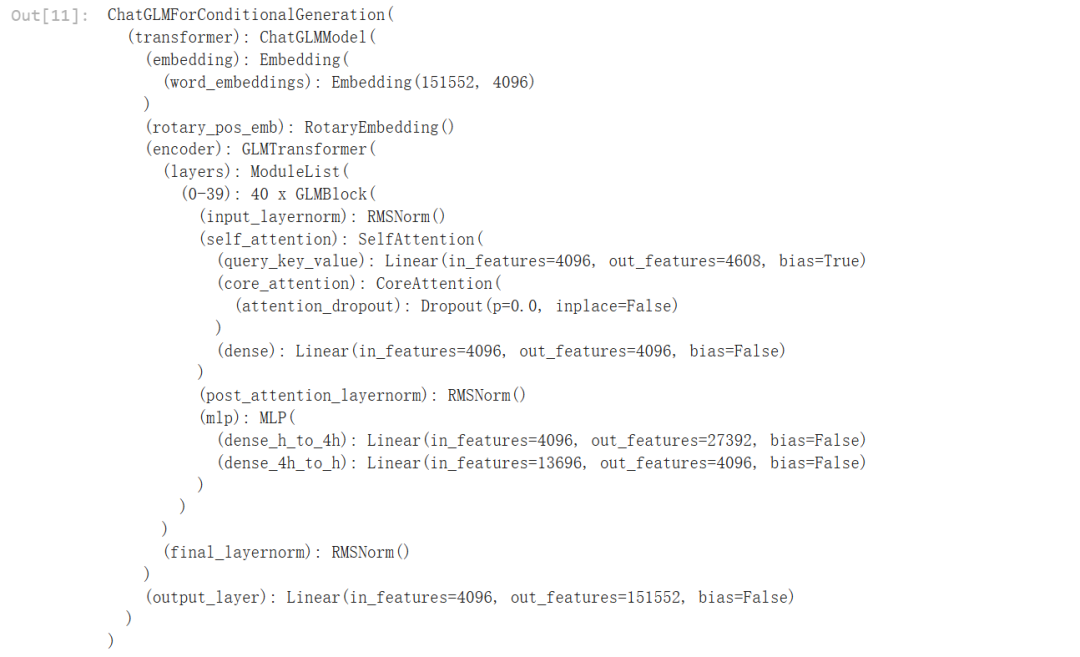

进而通过对模型层级分析,判断高阶矩阵位置,从而使用 PEFT 工具对低秩转换层进行指定,开启 LoRA 微调。

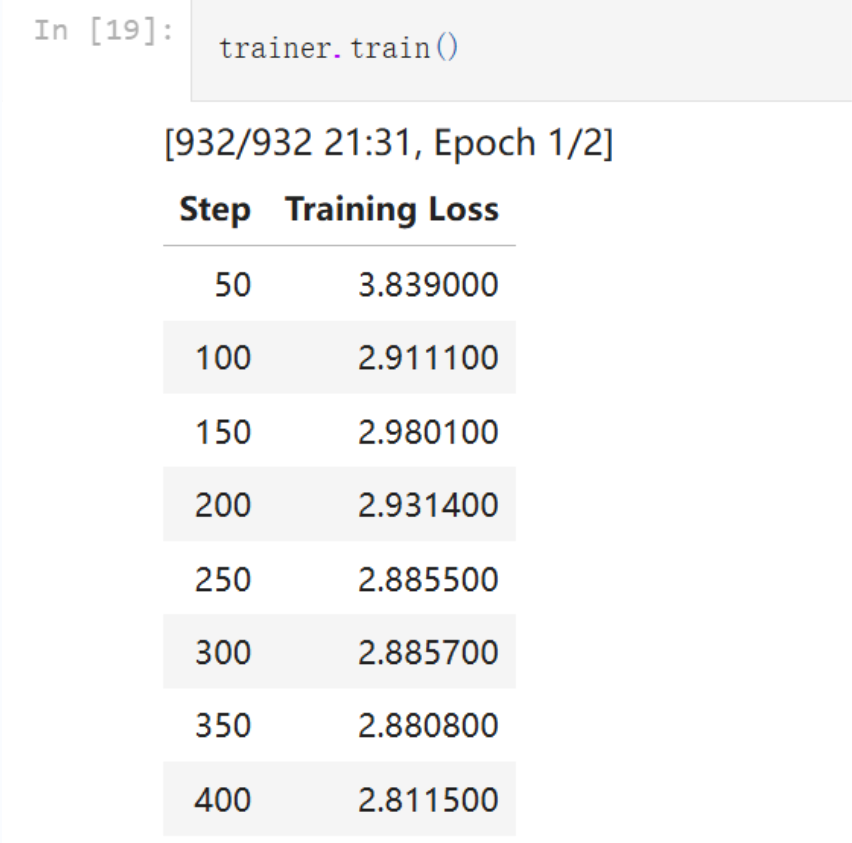

最终查看微调效果:

- User: 小姐,别的秀女都在求中选,唯有咱们小姐想被撂牌子,菩萨一定记得真真儿的——

-

- Assistant: 菩萨也会看错眼的时候。

项目介绍

《开源大模型食用指南》是一个围绕开源大模型、针对国内初学者、基于 AutoDL 平台的中国宝宝专属大模型教程,针对各类开源大模型提供包括环境配置、本地部署、高效微调等技能在内的全流程指导,简化开源大模型的部署、使用和应用流程,让更多的普通学生、研究者更好地使用开源大模型,帮助开源、自由的大模型更快融入到普通学习者的生活中。

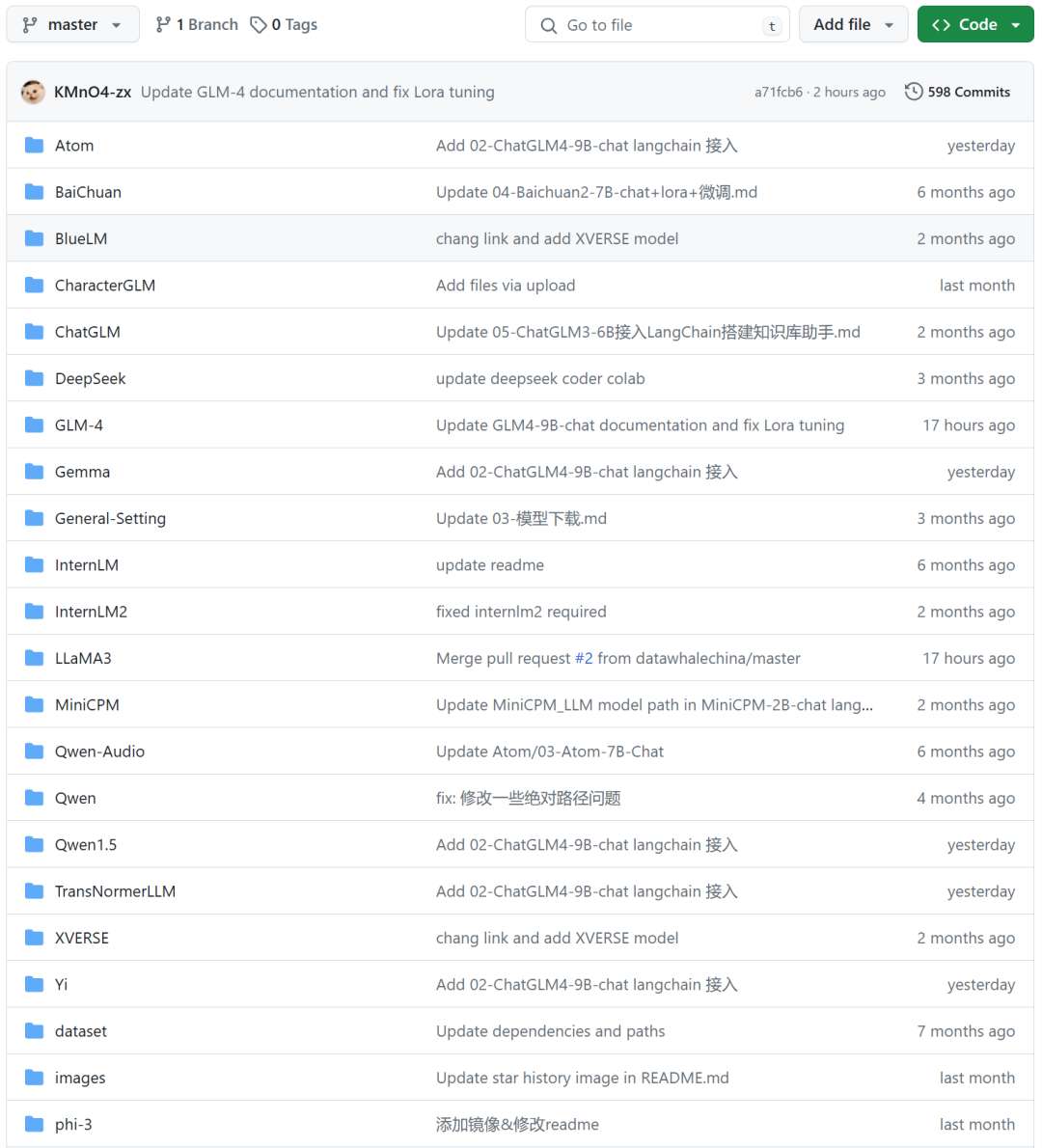

除 GLM4 外,项目已支持 LLama3, InternLM, Qwen1.5 等 20 项开源模型全流程教程,并且,本项目代码全部开源!!一并配置示例训练数据,AutoDL 环境镜像等,方便学习者使用!

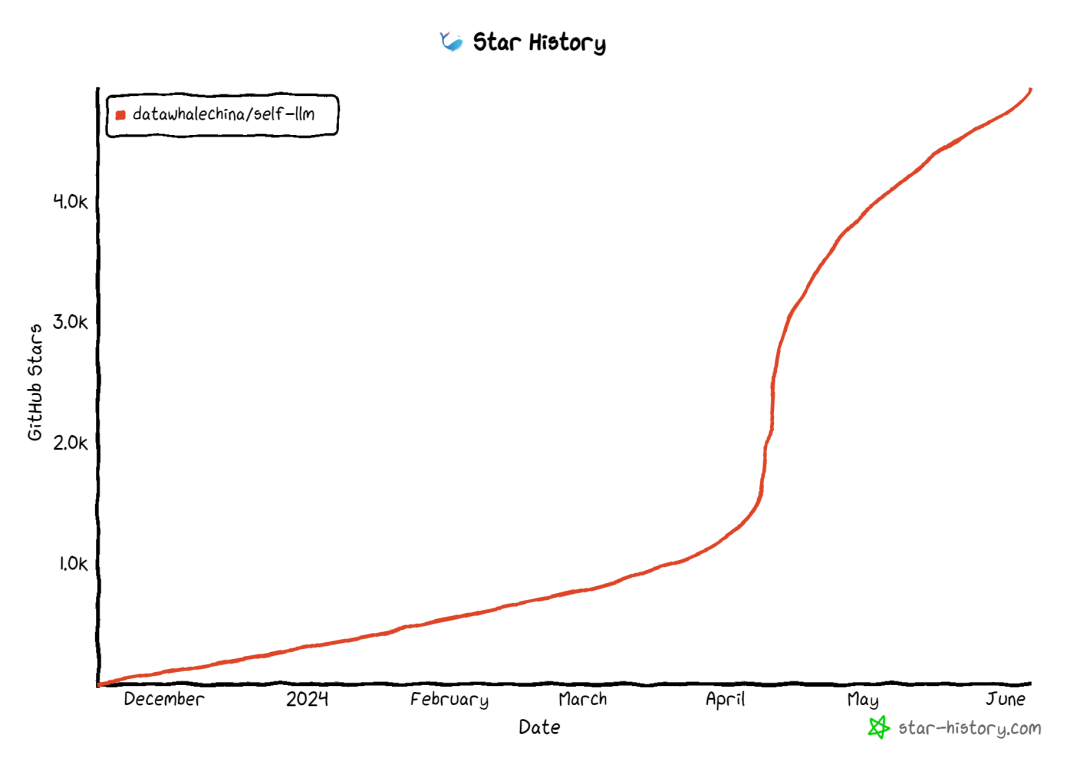

目前项目已经收获 4930 star~ 屡次登上 Github Trending 榜

如果喜欢的话也请给我们加一颗星,为开源助力(^▽^)

文章最后

最后,由于贡献者团队时间仓促、精力有限,教程难免有些疏漏甚至错误,我们期望学习者在学习的同时,也能积极给我们建议,或者直接对项目进行贡献,让我们共同打磨教程,为后面的学习者提供更好的内容。

项目地址:

https://github.com/datawhalechina/self-llm/tree/master/GLM-4

开源贡献,点赞在看↓