- 1支付宝小程序的开通流程_支付宝 小程序 教程

- 2Docker常见命令(以备不时之需)_docker 命令

- 3Android网络收集和ping封装库(1)_android ping

- 4Perl基础教程: 正则表达式_use not allowed in expression at

- 5基于GNURadio的USRP开发教程(2):深入认识USRP设备_usrp2954r

- 6字节跳动简历冷却期_【字节跳动招聘】简历这样写,才不会被秒拒

- 7Mybatis使用foreach标签实现批量插入_mybatis foreach批量insert

- 8轻松获奖五一数学建模和蓝桥杯_五一建模三等奖好得吗

- 9交易积累-量化交易

- 10Leetcode 238. 除自身以外数组的乘积

谁会成为第一个MoE大模型基座呢?重磅!Mixtral MoE 8x7B!!!_mixtral 7b 8 expert

赞

踩

谁会成为第一个MoE大模型基座呢?重磅!Mixtral MoE 8x7B!!!

话放这里,我敢说Mixtral MoE 8x7B!!!

将会是MoE技术路线上的基座模型 !!!

前言

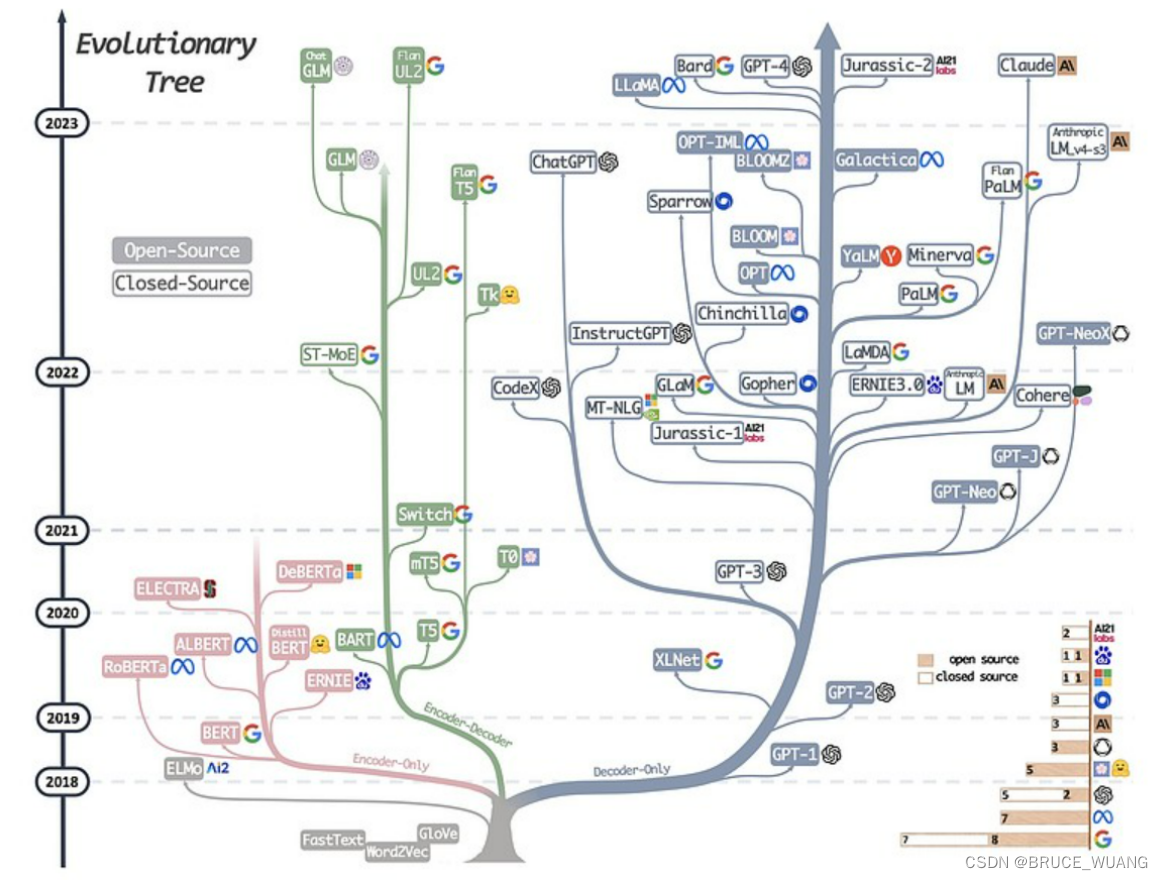

由Transformer衍生的大模型,主要有三条技术路线。

1、 Encoder-Only:以google的BERT为代表。

2、 Encoder-Decoder:以Meta的BART、清华大学的GLM、谷歌的T5、为代表。

3、 Decoder-Only:以OpenAI的GPT、谷歌的Bard、Meta的LLaMA等为代表

重磅!Mixtral MoE 8x7B!!!

那么就在刚刚,Mistral AI 发布了新的MoE技术路线的大模型MoE 8x7B!!!

MoE架构全称专家混合,也是GPT-4采用的方案,可以说这是开源大模型离GPT-4最近的一次了。

**没有发布会、没有宣传视频,只靠一个磁力链接!**感觉少了视频啊~

这个可比某歌在那发布的剪辑来剪辑去的视频要实在的多啊;狗头~~~

Mixtral是啥

Mixtral AI, 成立八个月,估值已达 20 亿欧元。 法国人工智能初创公司 Mistral AI 周日宣布已融资 3.85 亿欧元,主要来自美国集团,成为欧洲两大人工智能冠军之一。

Mistral AI 去年 5 月由三名法国人工智能专家联合创立,首席执行官 Arthur Mensch,31 岁!他们曾在 X 或 ENS 受过美国巨头聘用,但后来决定返回巴黎,目前拥有 22 名员工。

Mistral AI 在 6 月份已经筹集了 1.05 亿美元,在欧洲人工智能公司中,只有德国 Aleph Alpha 拥有如此多的资金,而在 11 月初筹集了近 5 亿欧元。

Mistral AI 的支持者包括软件发行商 Salesforce 等几家美国科技巨头,听说,还有全球超级计算机芯片专家 Nvidia 集团。

模型介绍

估计没啥人看,简单说两句吧~

Mixtral-8x7B-32K MoE模型主要由32个相同的MoEtransformer block组成。MoEtransformer block与普通的transformer block的最大差别在于其FFN层替换为了MoE FFN层。在MoE FFN层,tensor首先会经过一个gate layer计算每个expert的得分,并根据expert得分从8个expert中挑出top-k个expert,将tensor经过这top-k个expert的输出后聚合起来,从而得到MoE FFN层的最终输出,其中的每个expert由3个Linear层组成。值得注意的是,mixtral MoE的所有Norm Layer也采用了和LLama一样的RMSNorm,而在attention layer中,mixtral MoE的QKV矩阵中的Q矩阵shaoe为(4096,4096),K和V矩阵shape则为(4096,1024)。

具体介绍可以从这里获取!

模型结构长啥样?

表现如何?

性能数据:

- 所有数据来源自OpenCompass

Mistral-8x7B-MoE的具体性能数据未全部公开,社区评测显示,Mistral的表现超越了前身Mistral-7B,甚至在某些领域接近或超越了GPT-4。这一性能提升,OpenCompass 的最新基准测试结果显示 Mixtral-8x7B 超过 llama-2-70B,哟西~~~

| Datasets | Mode | Mistral-7B-v0.1 | Mixtral-8x7B | Llama2-70B | DeepSeek-67B-Base | Qwen-72B |

|---|---|---|---|---|---|---|

| MMLU | PPL | 64.1 | 71.3 | 69.7 | 71.9 | 77.3 |

| BIG-Bench-Hard | GEN | 56.7 | 67.1 | 64.9 | 71.7 | 63.7 |

| GSM-8K | GEN | 47.5 | 65.7 | 63.4 | 66.5 | 77.6 |

| MATH | GEN | 11.3 | 22.7 | 12.0 | 15.9 | 35.1 |

| HumanEval | GEN | 27.4 | 32.3 | 26.2 | 40.9 | 33.5 |

| MBPP | GEN | 38.6 | 47.8 | 39.6 | 55.2 | 51.6 |

| ARC-c | PPL | 74.2 | 85.1 | 78.3 | 86.8 | 92.2 |

| ARC-e | PPL | 83.6 | 91.4 | 85.9 | 93.7 | 96.8 |

| CommonSenseQA | PPL | 67.4 | 70.4 | 78.3 | 70.7 | 73.9 |

| NaturalQuestion | GEN | 24.6 | 29.4 | 34.2 | 29.9 | 27.1 |

| TrivialQA | GEN | 56.5 | 66.1 | 70.7 | 67.4 | 60.1 |

| HellaSwag | PPL | 78.9 | 82.0 | 82.3 | 82.3 | 85.4 |

| PIQA | PPL | 81.6 | 82.9 | 82.5 | 82.6 | 85.2 |

| SIQA | GEN | 60.2 | 64.3 | 64.8 | 62.6 | 78.2 |

可以白嫖吗?

MistralAI使用的是Apache-2.0开源协议,那就意味着Mistral-8x7B-MoE可免费商用!!

开源不仅降低了使用门槛,还促进AI领域的创新和发展,部署Mixtral 8x7B 大概需要 100G 显存,消费级显卡也能运行咯。

哪里可以获取?

1、 上面的磁力链接;

2、 科学上网这里;