热门标签

热门文章

- 1lua调用c#之Lua使用C#枚举_lua获取c#枚举

- 2速度起飞!AI大模型用OpenVINO优化响应速度的小妙招_openvino 加速

- 3mybatis-plus 中and()和or()连用_mybatisplus中 and or嵌套使用

- 4C语言中大小写字母的转化的方法

- 5CSS3计算样式 calc()_css样式计算

- 6使用kubeadm搭建高可用的K8s集群_certsans:可以不配置吗

- 7Day04 嵌入式---基本定时器

- 8AQS 源码解读系列--CyclicBarrier 篇_cyclicbarrier aqs

- 9国内GPT网站:应用场景、技术优势和未来发展

- 10Linux中的$符号的三种常见用法_linux $

当前位置: article > 正文

win10安装部署openvino详细记录_openvino 部署

作者:AllinToyou | 2024-02-28 20:20:54

赞

踩

openvino 部署

背景

众所周知,在 GPU 领域,NVIDIA 的 tensorrt 是一个很好的推理框架,效率和精度都能达到工业部署要求。而在 CPU 领域,也有成熟的推理框架,即 Intel 推出的 openvino。本文对 openvino 的安装配置做一个介绍,在后续的文章中,我会对该框架的使用方法进行详细的介绍。

安装步骤:

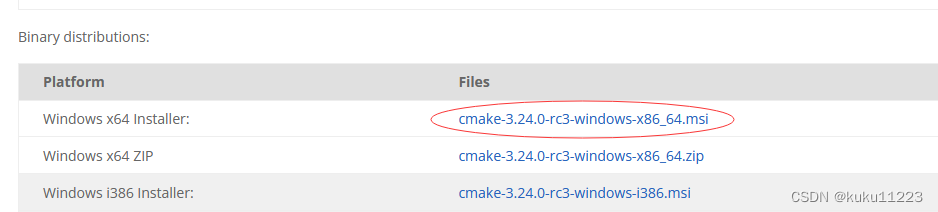

(camke安装最新版本就可以)

VS2017安装时需要勾选相应Cmake的组件:

以下cmake官网:

以下cmake官网:

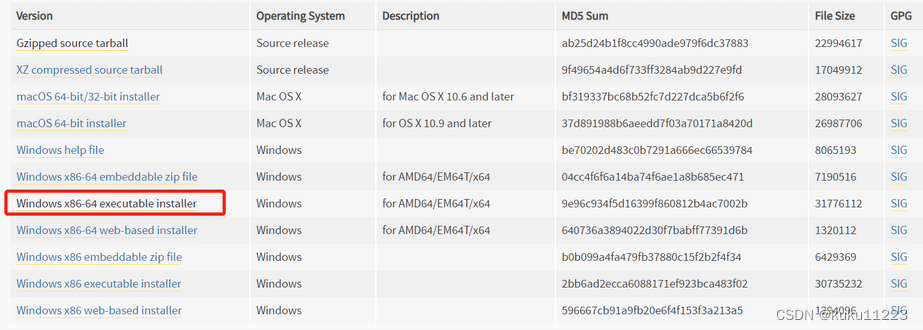

下载安装python3.6(正常安装后配置python的环境变量)

下载安装python3.6(正常安装后配置python的环境变量)

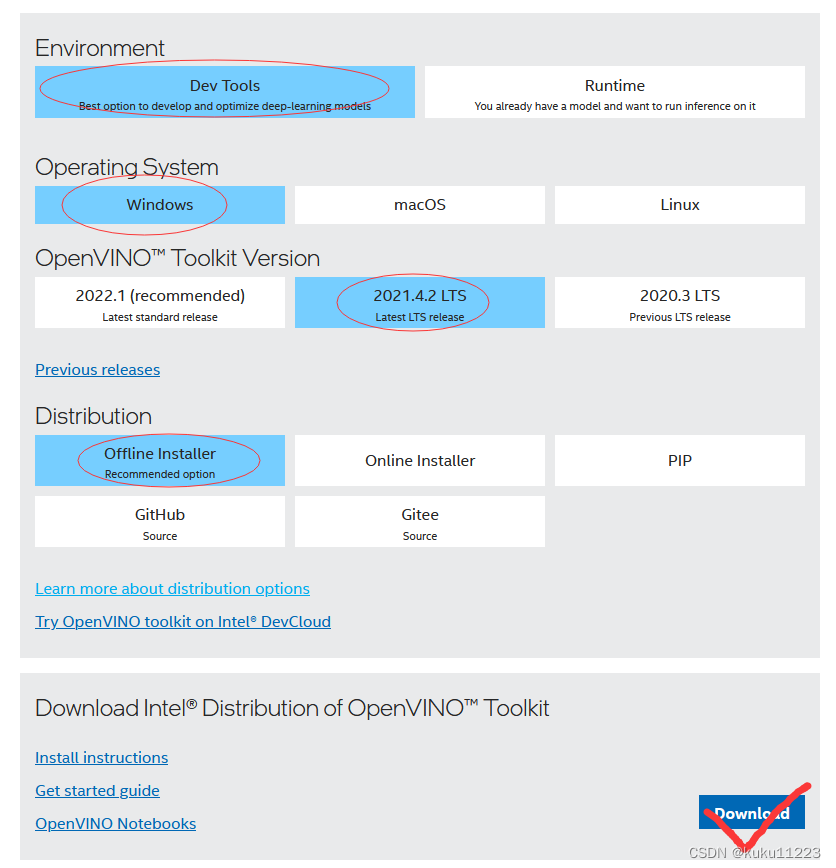

- 准备工作完成后即可下载安装openvino

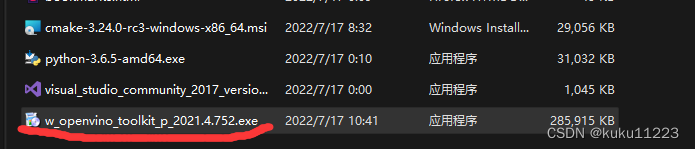

下载完成:

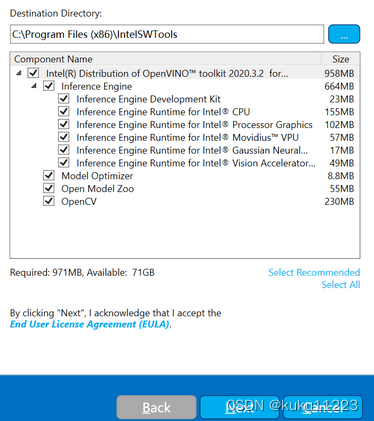

下载完成: 这里我选择自定义安装路径,注意路径中不要出现中文名和空格等内容

这里我选择自定义安装路径,注意路径中不要出现中文名和空格等内容

注意,如果你出现一些 warning,表明前边的依赖安装有问题,需要重新安装配置后再继续安装 openvino

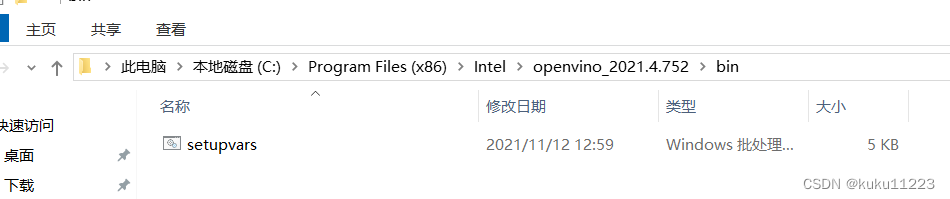

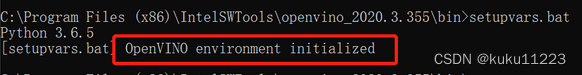

- 配置环境变量

为了能完整地使用 openvino 软件,需要配置环境变量,官方建议不要使用 Windows PowerShell,而是直接使用系统自带的 cmd 界面,运行 “C:\openvino\openvino_2020.3.355\bin\setupvars.bat” 文件,如下:

(注意:以上操作只是一次性的,下次打开还需要造次配置)

(注意:以上操作只是一次性的,下次打开还需要造次配置)

因此可以参考《为 Windows OpenVINO™ 10 永久设置工具套件®变量 》配置:

| 名字 | 价值 | 笔记 |

|---|---|---|

| INTEL_OPENVINO_DIR | C:\Program Files (x86)\IntelSWTools\openvino | OpenVINO™安装的路径 |

| INTEL_CVSDK_DIR | %INTEL_OPENVINO_DIR% | |

| OpenCV_DIR | %INTEL_OPENVINO_DIR%\opencv\cmake | |

| NGRAPH_DIR | %INTEL_OPENVINO_DIR%\deployment_tools\ngraph\cmake | |

| InferenceEngine_DIR | %INTEL_OPENVINO_DIR%\deployment_tools\inference_engine\share | |

| HDDL_INSTALL_DIR | %INTEL_OPENVINO_DIR%\deployment_tools\inference_engine\external\hddl | |

| PYTHONPATH | %INTEL_OPENVINO_DIR%\python\python3.6 | 检查您的 Python * 版本并调整 |

| 您还需要在系统变量下编辑Path变量,并添加以下条目: |

|---|

| %INTEL_OPENVINO_DIR%\deployment_tools\inference_engine\bin\intel64\Debug |

| %INTEL_OPENVINO_DIR%\deployment_tools\inference_engine\bin\intel64\Release |

| %INTEL_OPENVINO_DIR%\deployment_tools\inference_engine\bin\intel64\Debug |

| %HDDL_INSTALL_DIR%\bin |

| %INTEL_OPENVINO_DIR%\opencv\bin |

| %INTEL_OPENVINO_DIR%\deployment_tools\ngraph\lib |

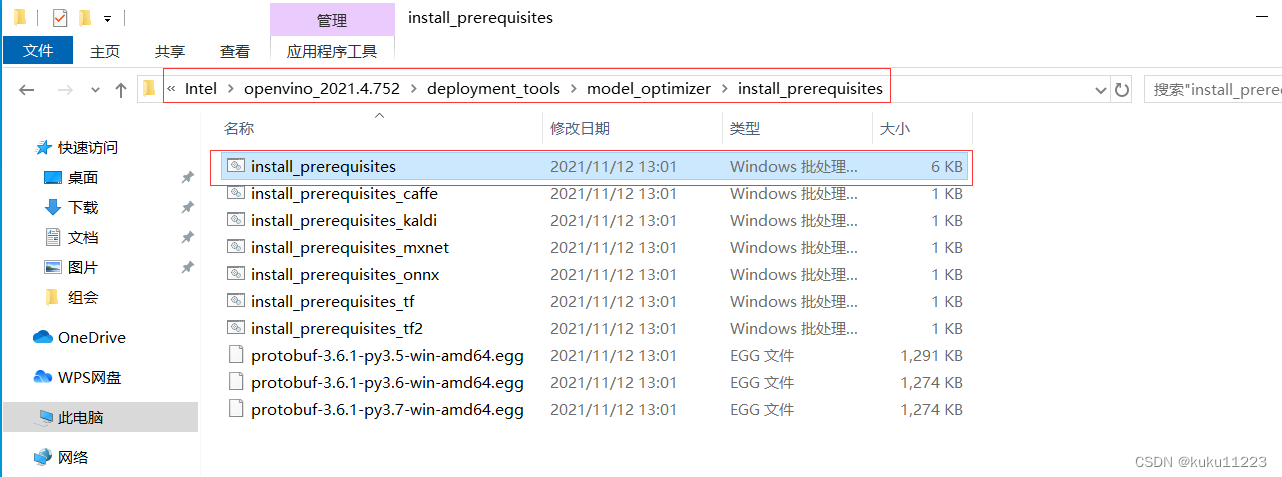

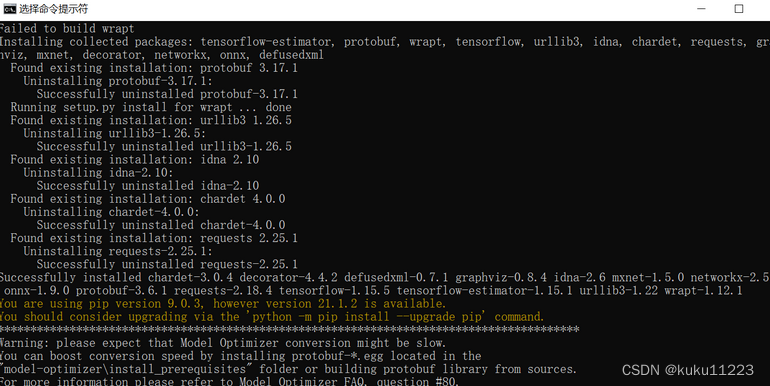

4.配置模型优化器

模型优化器 Model Optimizer 是 openvino 工具的核心组件,可以实现不同框架模型到 openvino 的转化,如 TensorFlow、MXNet、Caffe 等,而 openvino 部署时需要 IR 格式的模型,具体包含以下两部分

.xml 文件:描述网络拓扑结构

.bin 文件:包含网络权重的二进制文件

- 1

- 2

而 openvino 推理的过程,就是读取、载入 IR 文件的过程,通过通用 API 在 CPU、GPU 或 VPU 上进行推理。

你可以根据你的需求选择一次性配置支持多种框架(install_prerequisites.bat),也可以选择配置支持某一种框架(install_prerequisites_xx.bat)。

双击打开

双击打开

配置完成。

配置完成。

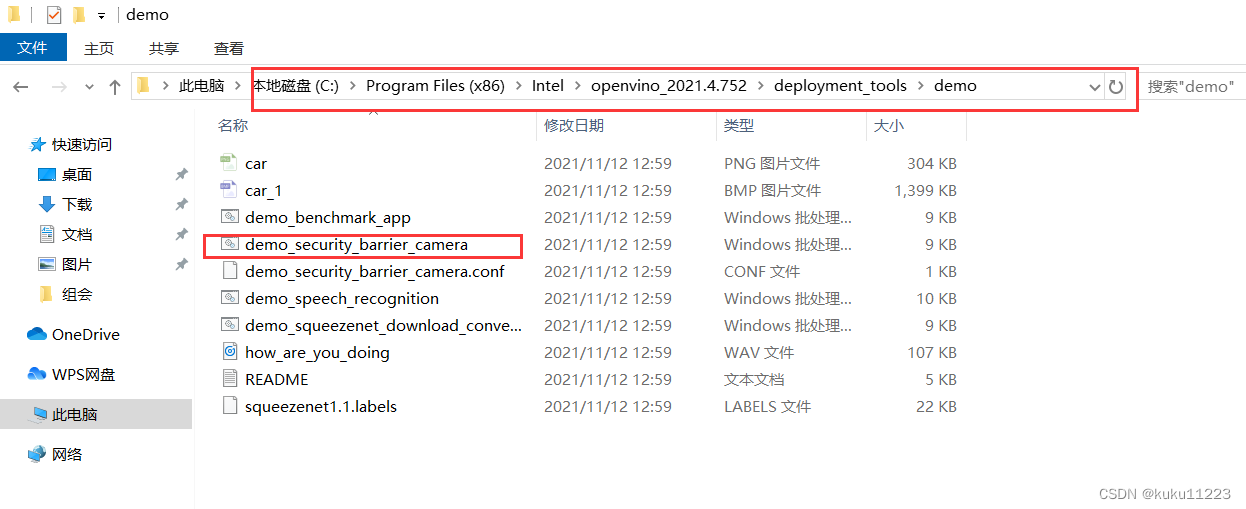

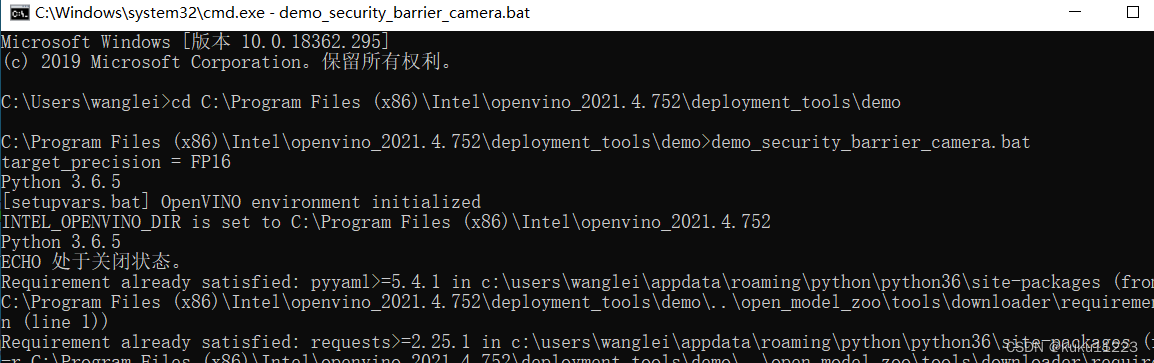

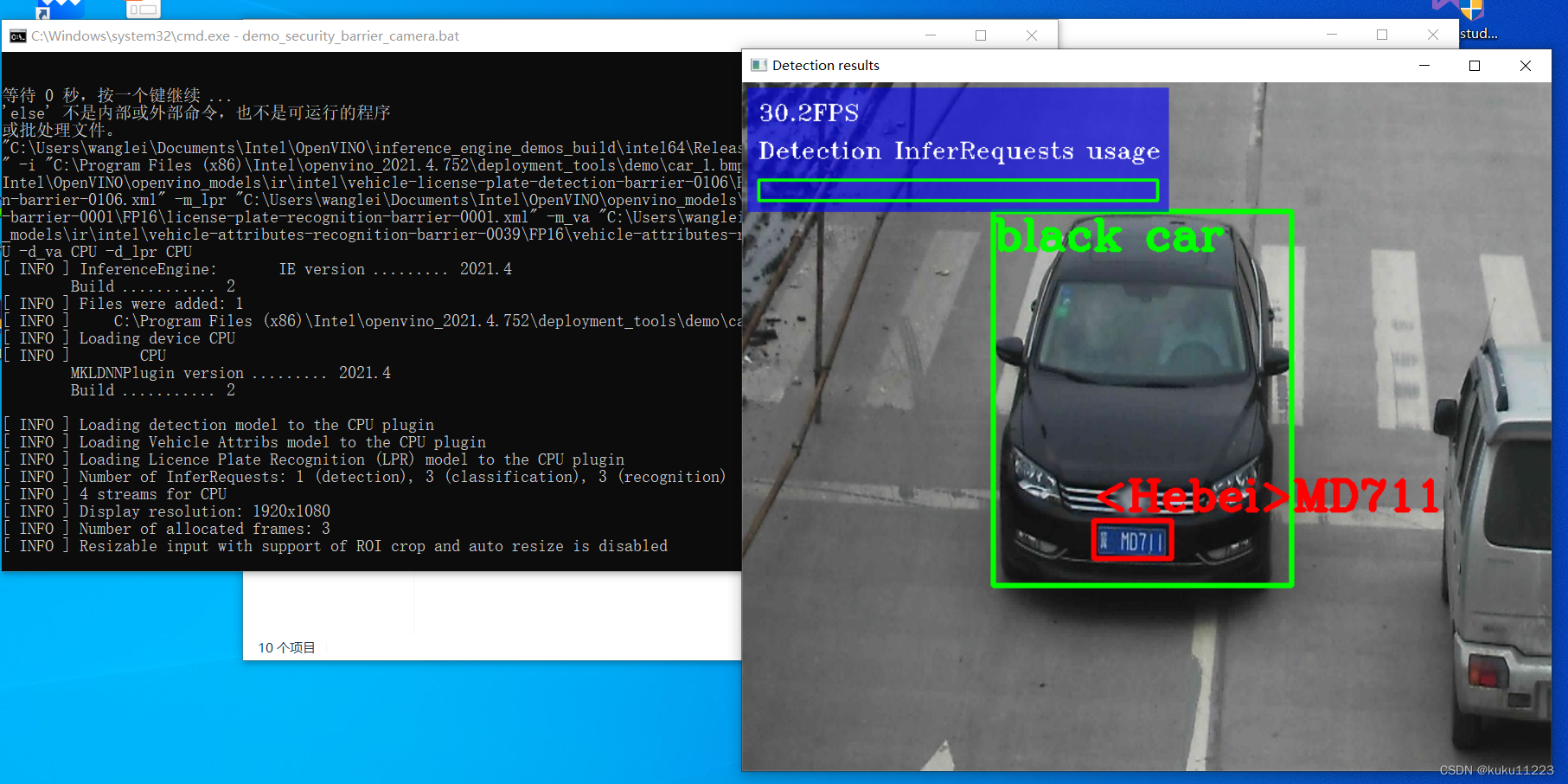

下面用cmd运行demo脚本试试看:

完成:

报错

VS2019不好用还是用VS2017吧

本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

推荐阅读

相关标签