- 1Android中的正则表达式_android matchresult

- 2Rust 实现摄氏度与华氏度相互转换——Rust语言基础10_rust adc read

- 3STM32 学习(系统滴答定时器)_stm32怎么看systick时钟频率

- 4Flutter 布局基础:Row && Column_flutter row占比

- 5微搭Weda - 自定义代码访问数据库wedaGetRecords_tcberror: 调用数据源user_zyc5tkx方法wedagetrecordsv2失败: u

- 6第3章 Kotlin语言基础 《Kotlin 极简教程》

- 7了解应用商店优化 (ASO)

- 8drawerlayout+tablelayout+fragment+轮播_android drawerlayout 加fragment加fragment

- 9SetBkMode函数理解

- 10苹果应用商店怎么搜不到tiktok,怎么下载呢

比LSTM更强-时间卷积融合注意力机制(TCN-Attention)预测程序代码!包含特征可视化,由Excel导入,直接运行!_tcn注意力机制

赞

踩

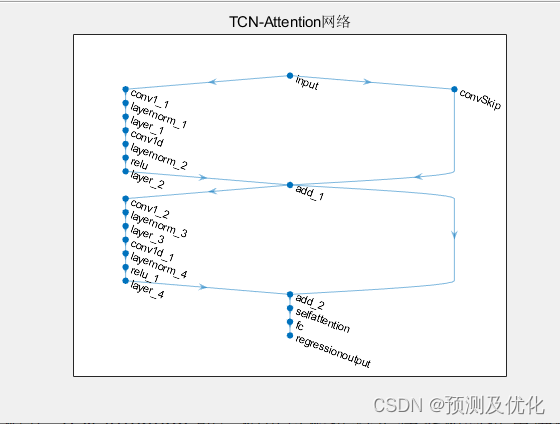

TCN-Attention是一种将Temporal Convolutional Network(TCN)与自注意力机制结合的深度学习架构,用于处理时间序列数据;适用平台:Matlab 2023及以上。以下是TCN-Attention的基本结构:

TCN层:TCN层是TCN-Attention的核心组件,用于处理时间序列数据。它通常由多个残差块(Residual Blocks)组成,每个块包括卷积层、层归一化(Layer Normalization)和激活函数(通常是ReLU)。

Attention自注意力层:在TCN-Attention中,自注意力层被嵌入到TCN层中,通常位于最上面的残差块。这个自注意力层用于捕捉时间序列数据中的全局依赖关系。自注意力机制允许网络在学习时动态地调整各个时间步的权重,以便更好地捕捉长期依赖和全局模式。

残差连接:残差连接用于构建深层网络。每个残差块包括了一维卷积层和层归一化层,这些卷积层的输出被添加到输入,从而构成了残差结构。这有助于减轻梯度消失问题并使网络更容易训练。

全连接层:在TCN-Attention的顶部,通常添加全连接层用于执行最终的任务特定预测,如时间序列预测、文本分类等。

TCN-Attention结合了TCN的局部特征捕获和自注意力机制的全局特征捕获,以提高时间序列建模的性能。这种结构允许网络在学习时既关注局部模式又能够有效地捕获时间序列数据中的长期依赖和全局模式。TCN-Attention的结构可以根据特定任务和数据集进行调整和优化,以获得最佳性能。

适用于,风速预测,光伏功率预测,发电功率预测,海上风电预测,碳价预测等等。它的创新点在于综合了膨胀因果卷积,使其适用于广泛的应用,从而提高了对序列数据的建模和分析能力。

程序出图:

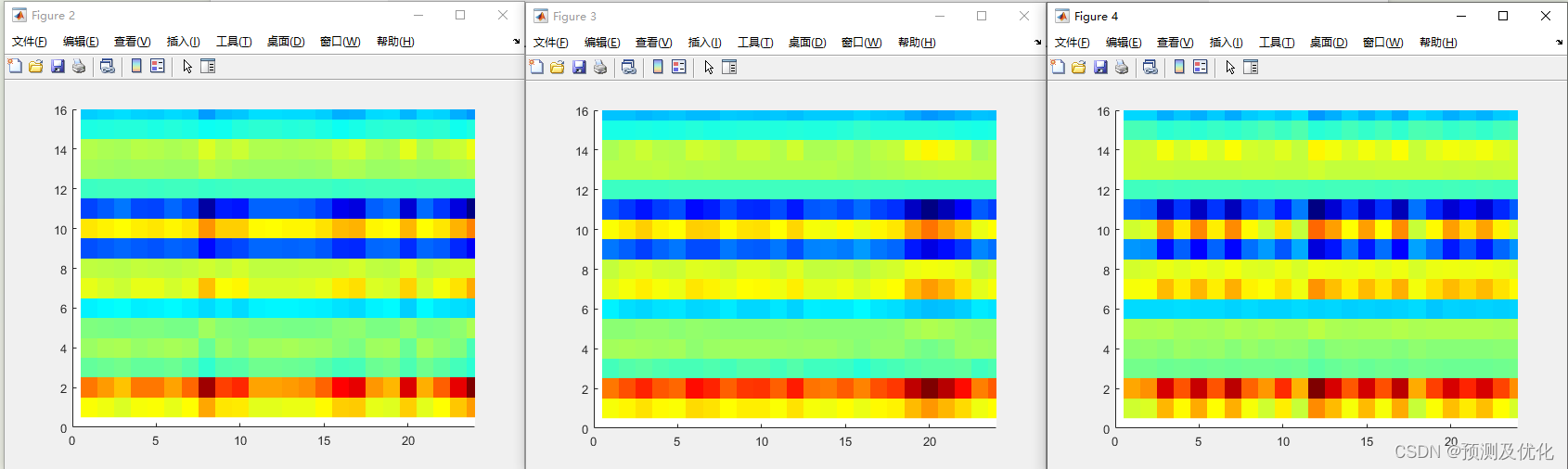

特征可视化:

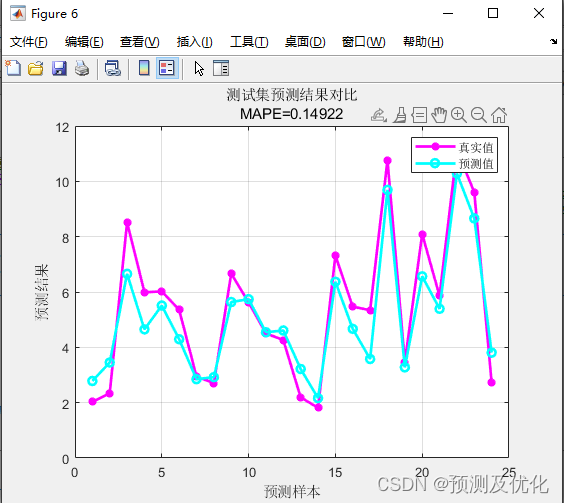

超前24步预测值与实际值对比:

部分程序:

- %% 清除内存、清除屏幕

- clc

- clear

-

- %% 导入特征数据、当天的风速数据

- data = xlsread('特征序列及实际值.xlsx');

- Features = data(1:18,:); %% 特征输入 :75天,每天24小时,每小时一个采样点,共计75*24=1800小时,18个特征数据

- Wind_data = data(19,:); %% 实际值输出:75天,每天24小时,每小时一个采样点,共计75*24=1800小时的风速数据

-

- %% 数据平铺为4-D

- LP_Features = double(reshape(Features,18,24,1,75)); %% 特征数据格式为18*24*1*75,分别对应18特征24小时,75天

- LP_WindData = double(reshape(Wind_data,1,24,1,75)); %% 实际数据格式为1*24*1*75 ,分别对应24小时,75天

-

- %% 格式转换为cell

- NumDays = 75; %% 数据总天数为 75天

- for i=1:NumDays

- FeaturesData{1,i} = LP_Features(:,:,1,i);

- end

-

- for i=1:NumDays

- RealData{1,i} = LP_WindData(:,:,1,i);

- end

-

- %% 划分数据

- XTrain = FeaturesData(:,1:73); %% 训练集输入为 1-73 天的特征

- YTrain = RealData(:,2:74); %% 训练集输出为 2-74天 的实际值

-

- XTest = cell2mat(FeaturesData(: , 74)); %% 测试集输入第 74 天的特征

- Ytest = cell2mat(RealData(: , 75)); %% 测试集输出为第 75天 的实际值

-

- %% 设置网络参数

- numFilters = 16; % 卷积核个数

- filterSize = 3; % 卷积核大小

- dropoutFactor = 0.05; % 空间丢失因子

- numBlocks = 2; % 残差块个数

- numFeatures = 18; % 特征个数

欢迎感兴趣的小伙伴关注并获取完整版代码哦~,小编会继续推送更有质量的学习资料、文章程序代码~