热门标签

热门文章

- 1tfidf和word2vec构建文本词向量并做文本聚类_tfidf向量

- 2【机器学习】推荐系统、机器学习面试题整理_交叉熵损失函数具有易于计算梯度

- 3nltk.download()报错getaddrinfo failed_nlgetaddrinfo failed

- 4看板的前世今生_中国古代看板管理

- 5【Bugs】openai.error.ServiceUnavailableError The server is overloaded or not ready yet_openai.error.serviceunavailableerror: the server i

- 6什么是 NLP (自然语言处理)

- 7petalinux定制ZYNQ的Linux操作系统

- 8BP神经网络的Matlab实现——人工智能算法

- 9信息管理毕设项目推荐_信管大学生做个项目

- 10中文情感分析——snownlp类库 源码注释及使用

当前位置: article > 正文

使用ollama + webui 运行任意大模型

作者:AllinToyou | 2024-03-26 02:11:15

赞

踩

使用ollama + webui 运行任意大模型

安装ollama

https://hub.docker.com/r/ollama/ollama

docker run -d -v ~/Documents/work/softs/docker/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

验证安装

- # 进入容器

- docker exec -it ollama bash

- # 运行大模型

- ollama run llama2

- # 发送请求(会有很多输出,一直到结束)

- curl http://localhost:11434/api/generate -d '{

- "model": "llama2",

- "prompt":"Why is the sky blue?"

- }'

-

可以选择其支持的模型列表GitHub - ollama/ollama: Get up and running with Llama 2, Mistral, Gemma, and other large language models.

安装webui

GitHub - open-webui/open-webui: User-friendly WebUI for LLMs (Formerly Ollama WebUI)

- # host.docker.internal == 127.0.0.1 主要是mac下docker 不支持127.0.0.1

- docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://host.docker.internal:11434 -v ~/Documents/work/softs/docker/open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

验证安装

访问http://127.0.0.1:3000,开始对话

构建自己的知识库(anything llm)

安装

Download AnythingLLM for Desktop

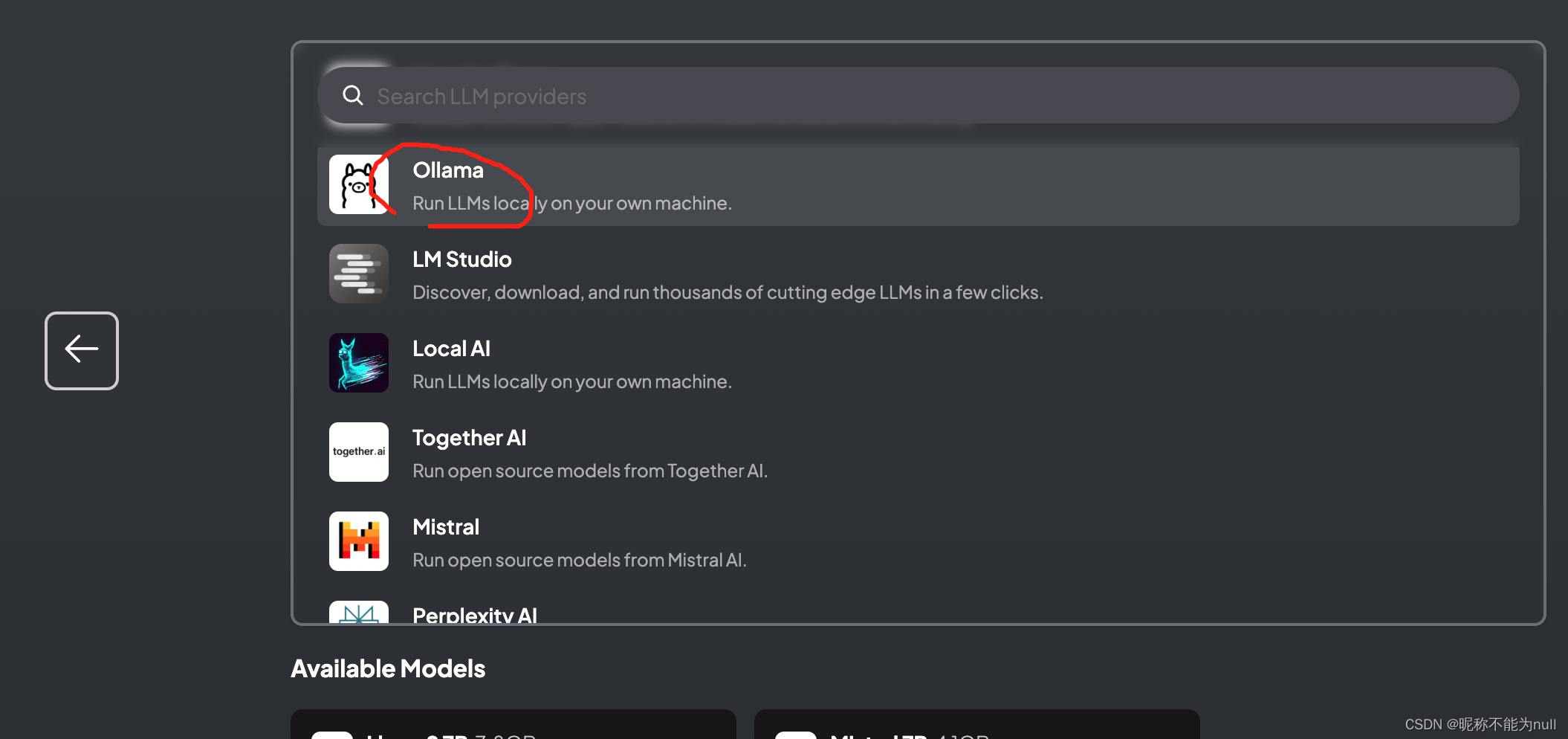

选择模型模型 ollama

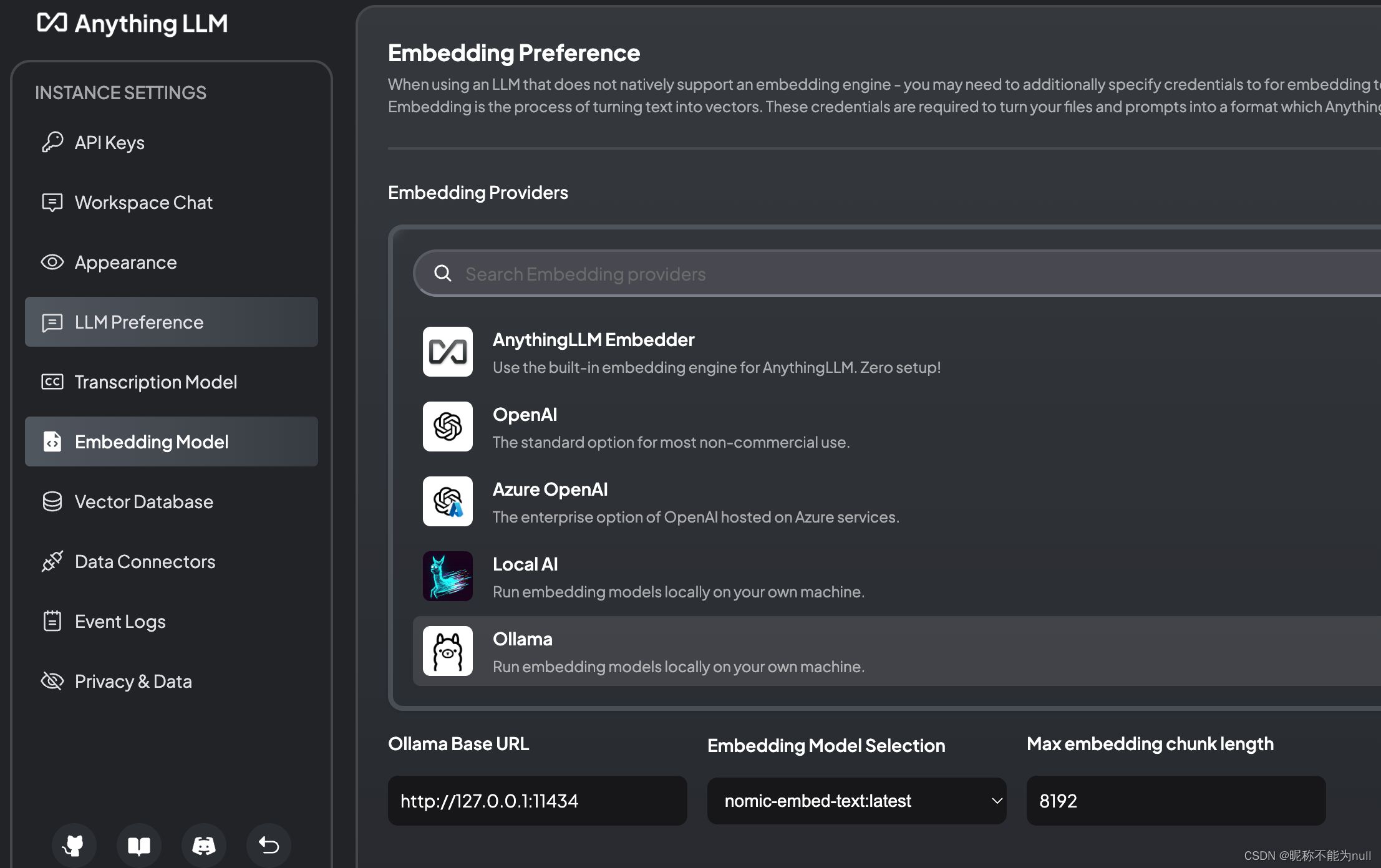

ollama pull nomic-embed-text 支持长文本的效果比较好。

最终的配置

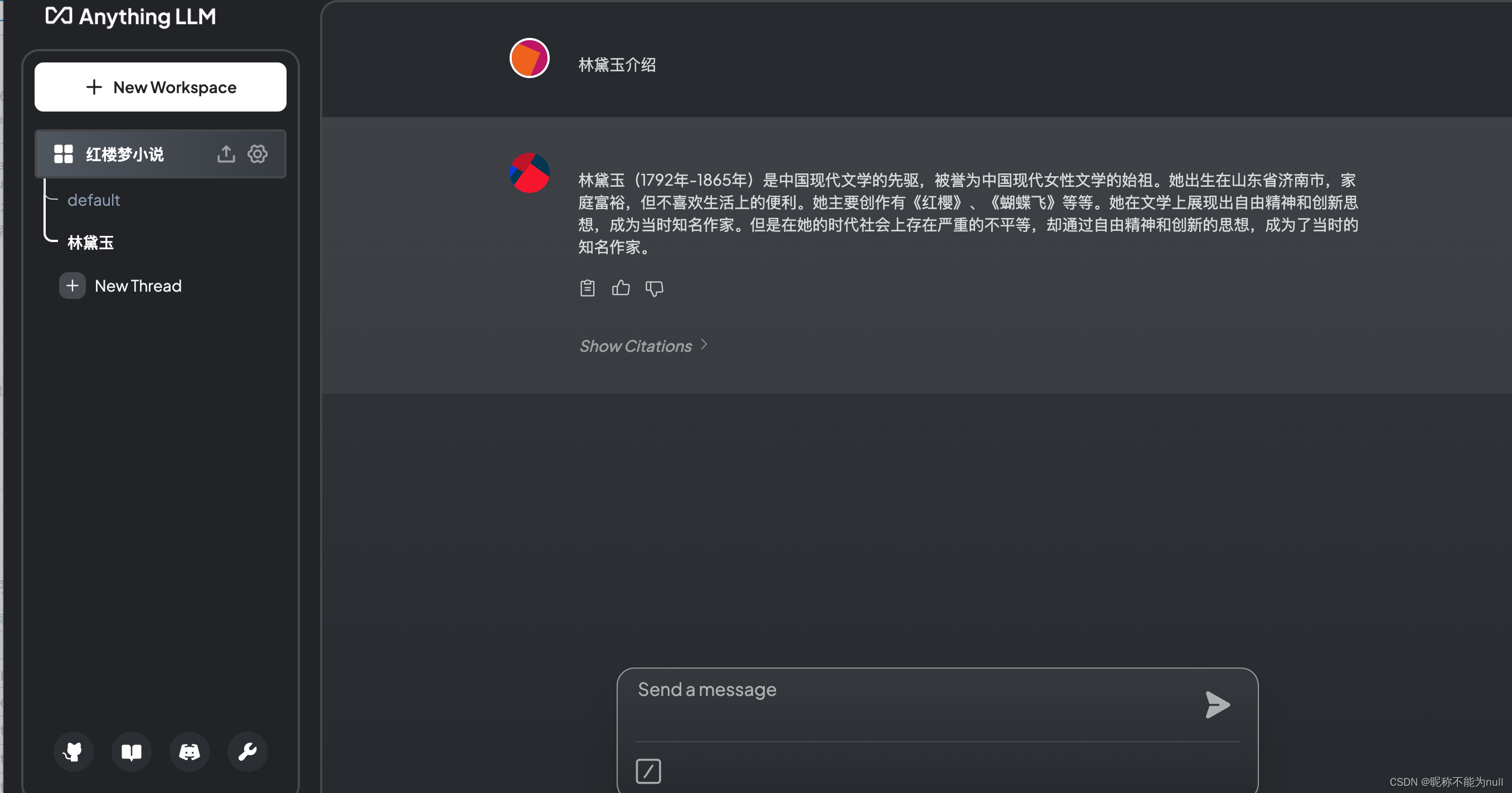

建立文档库

开始用自己的文档对话

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/AllinToyou/article/detail/313980

推荐阅读

相关标签