热门标签

热门文章

- 1论文阅读 - SegFormer_segformer结构

- 22022/12/10牛客网python专项练习学习笔记_在python中,vector3变量

- 3SpringBoot + Redis尝试实现外卖拼单(三)_基于springboot的外卖点餐小程序添加拼团

- 4volatile 关键字

- 546.在ROS中实现global planner(2)- A*规划算法预研_global_planner的两种算法

- 6猫头虎分享:什么是Promise异步编程

- 7wireless iwpriv

- 8使用 .NET的IO(5)_身io.5嗯 ◇.. .

- 9基于stm32单片机的信号发生器设计_基于stm32的信号发生器

- 10Playwright对比selenium_selenium被淘汰了

当前位置: article > 正文

Drag GAN 论文浅读_draggan

作者:AllinToyou | 2024-04-01 09:51:34

赞

踩

draggan

此论文为研究论文,入选 SIGGRAPH 2023(SIGGRAPH是计算机图像界最顶级会议)。

一作:潘新刚 现马克斯・普朗克计算机科学研究所博士后

论文:[2305.10973] Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold (arxiv.org)代码(据说6月开源):https://github.com/XingangPan/DragGAN

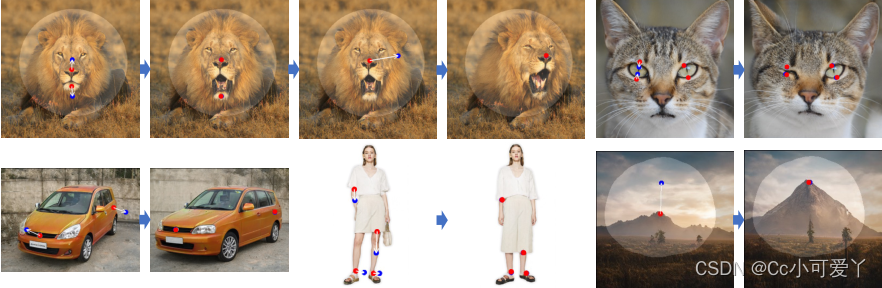

效果图:

相比于更易掌控的扩散模型,GAN通过单个向前传递生成图像,因此是更高效的。

为提高更加准确、灵活、通用的交互式图像处理工具,本文提出Drag GAN(高效交互、实时编辑、多次改变图像,不依赖于额外网络),其有两部分组成:

1)一种基于特征的运动监督,它驱动图像中的操纵点向目

推荐阅读

相关标签