- 1AI + SQL 所想即所得_ai sql

- 2第十四届蓝桥杯全国软件和信息技术专业人才大赛(Web 应用开发)_isbn 转换与生成 蓝桥杯

- 3基于STM32的多功能智能手环设计(可以当做毕设与简历项目)_智能手环系统作为毕业设计够么?

- 4Speech-Text Dialog Pre-training for Spoken Dialog Understanding with Explicit Cross-Modal Alignment

- 5softmax分类器_论文盘点:性别年龄分类器详解

- 6BPE系列之—— BPE算法

- 72024上半年软考中级《数据库系统工程师》报名考试全攻略_2024上半年数据库系统工程师考试时间

- 8“继承MonoBehavior的泛型单例“本质上是一个单例模板

- 9Python获取天气数据 并做可视化解读气象魅力_基于python爬虫的天气预报数据分析

- 10办公室分配方案python_Python自动化办公室(1),python,一

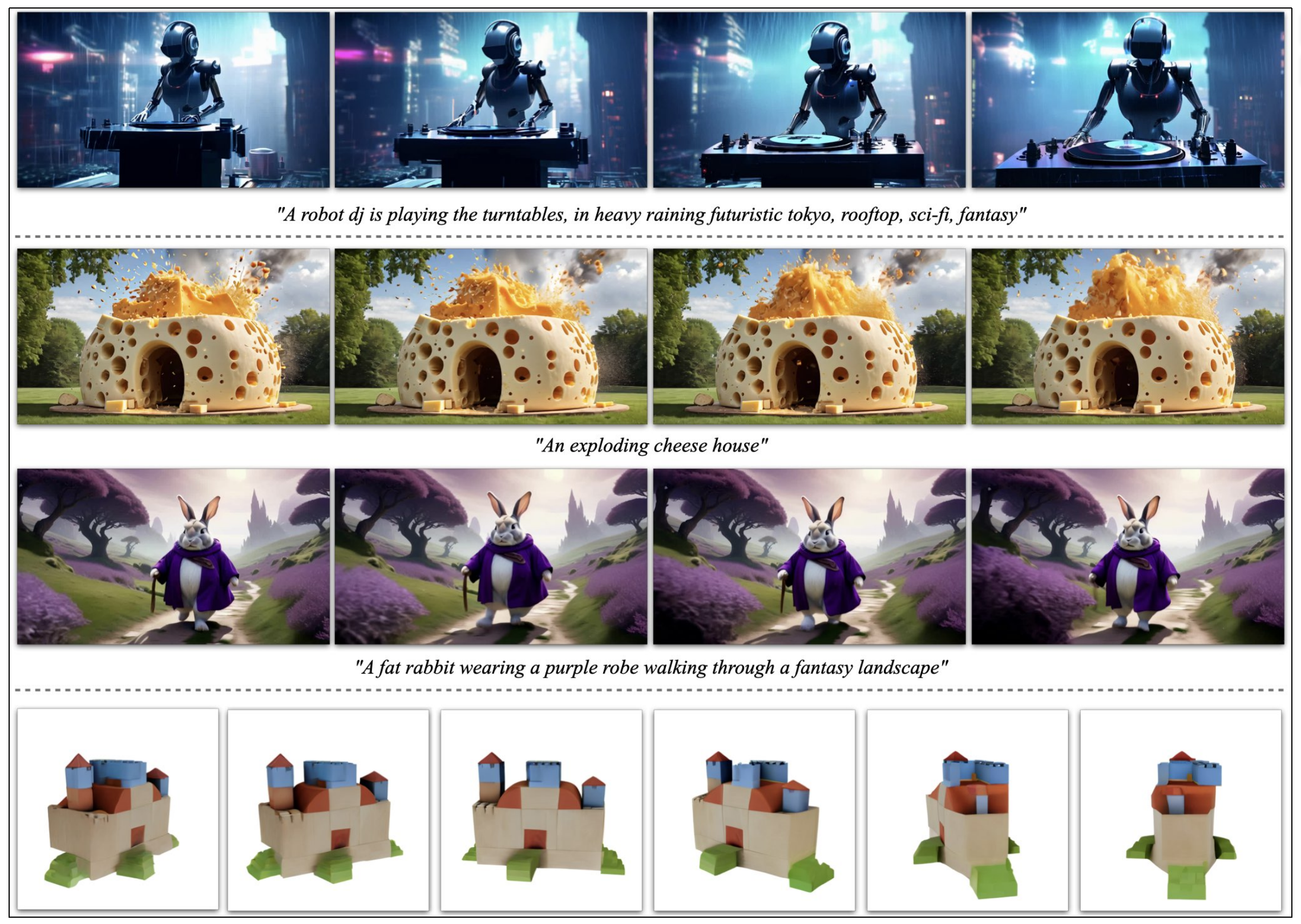

Sora之前的视频生成发展史:从Gen2、Emu Video到PixelDance、SVD、Pika 1.0_视频合成原理

赞

踩

前言

考虑到文生视频开始爆发,比如11月份就是文生视频最火爆的一个月

- 11月3日,Runway的Gen-2发布里程碑式更新,支持4K超逼真的清晰度作品(runway是Stable Diffusion最早版本的开发商,Stability AI则开发的SD后续版本)

- 11月16日,Meta发布文生视频模型Emu Video

- 11月18日,字节跳动半路杀出发布PixelDance

- 11月21日,开发并维护Stable Diffusion后续版本的Stability AI终于发布了他们自家的生成式视频模型:Stable Video Diffusion(SVD)

加之不止一个B端客户找到七月,希望帮其做文生视频的应用,故我司第一项目组准备在AIGC模特之后,做文生视频项目,最终把文生3D、文生数字人都串起来

当然,我司还是三大项目组

- 除了已经对外发布的AIGC模特生成系统外,文生图、文生视频、文生3D、数字人,都在第一项目组

- 论文审稿GPT(目前正在迭代第二版《七月论文审稿GPT第2版:从Meta Nougat、GPT4审稿到Mistral、LongLora Llama》),包括后续的AI agent商用项目,在第二项目组

- 企业多文档的知识库问答(目前正在解决各种已知问题中),则在第三项目组

第一部分 视频生成的iPhone时刻:Runway先后发布Gen-1、Gen-2

1.1 Gen-1:对现有的3D动画和手机视频进行AI编辑

今2023年2月,之前开发stable diffusion最初版本的Runway提出了首个AI编辑模型Gen-1,Gen-1可以在原视频的基础上,编辑出咱们想要的视频。无论是粗糙的3D动画,还是用手机拍出来的摇摇晃晃的视频,Gen-1都可以升级出一个不可思议的效果(当然,其背后原因是Gen1 trained jointly on images and videos)

比如用几个包装盒,Gen-1就可以生成一个工厂的视频,化腐朽为神奇,就是这么简单

1.1.1 Gen-1何以做到:给图像模型增加时间线,且对图像和视频做联合训练

Gen-1对应的论文为:Structure and Content-Guided Video Synthesis with Diffusion Models,顺带说一嘴,有的文章会把这篇论文混淆成Gen2的论文,但实际上,runway只对外发布了Gen-1的论文,2的论文在23年年底之前还没对外发,大家注意

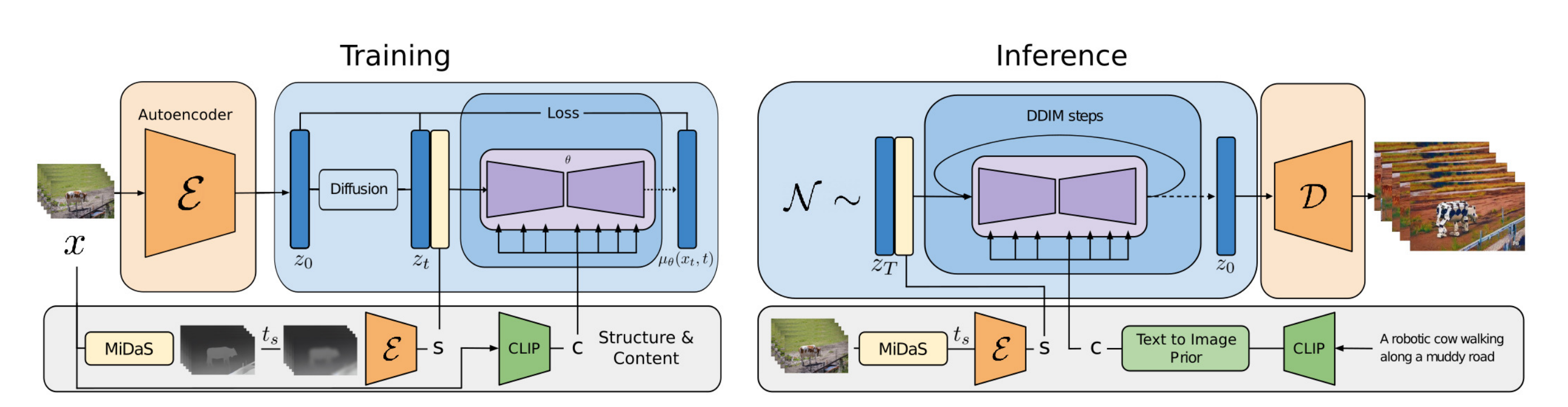

如下图所示,可以基于潜在视频扩散模型(latent video diffusion models),通过给定「下图中间部分」的原始输入图像,然后既可以通过如「下图左上角」的文字引导生成视频,也可以通过如「下图左下角」的图像引导生成视频

怎么做到的呢?

- 首先,视频之所以可以通过文字引导生成,离不开文字引导图像生成的那一系列前置工作(Text-conditioned models, such as DALL-E2 and Stable Diffusion,enable novice users to generate detailed imagery given only a text prompt as input)。毕竟潜在扩散模型提供了“在感知压缩空间高效合成图像”的方法

- 其次,通过引入带有时间线的预训练图像模型(temporal layers into a pre-trained image model),且在图像和视频上做联合训练「即在一个大规模的无字幕视频,和配对的“文本-图像”的数据集上进行训练( trained on a large-scale dataset of uncaptioned videos and paired text-image data)」,从而将潜在扩散模型扩展到视频生成

Gen1提出了一个可控的结构和内容感知的视频扩散模型(We propose a controllable structure and content-aware video diffusion model)

同时,在推理阶段可以修改由示例图像或文本引导的视频(意味着编辑视频的操作完全在推理阶段中执行,无需额外的针对每个视频的训练或预处理,即Editing is performed entirely at inference time without additional per-video training or pre-processing)

且选择用单眼深度估计的技术来表示结构,且由预先训练的神经网络预测嵌入表示内容(We opt to represent structure with monocular depth estimates and content with embeddings predicted by a pre-trained neural network,顺带解释下:单眼深度估计是一种计算机视觉技术,它旨在从仅使用单个摄像机拍摄的二维图像中推断出场景的三维深度信息) - 然后在视频生成的过程中提供了几种控制模式

首先,类似于image synthesis models,训练模型,使得其可以推断视频的内容,例如他们的外观或风格,及匹配用户提供的图像或文本提示

第二,受到扩散过程的启发,将information obscuring process应用到structure representation,以选择模型对给定结构的坚持程度(we apply an information obscuring process to the structure representation to enable selecting of how strongly the model adheres to the given structure)

最后,还对推理过程进行了调整,通过自定义指导方法,以及受classifier-free guidance的启发,以控制生成的剪辑的时间一致性(to enable control over temporal consistency in generated clips),相当于做到了时间、内容、结构三者在一致上的统一对齐

1.1.2 Gen1的训练过程、推理过程的详解

咱们模型的目标是保留视频结构的同时(结构一般指视频的几何、动力学的特征,比如对象的形状、位置以及他们的时间变化),编辑视频的内容(内容一般指的是视频外观及其语义的特征,比如对象的颜色、样式以及场景的光亮度)

为了实现这一目标,需要基于结构表示和内容表示

的基础上学习视频

的生成模型

,从而通过输入的视频推断出其结构表示

,然后根据编辑视频的描述文本

进行修改(modify it based on a text prompt c describing the edit),如下图所示

- 在上图左侧的训练过程中,输入的视频x用一个固定的编码器

编码到

,并扩散到

另一边,通过对“使用MiDaS获得的depth maps”进行编码,来提取一个结构表示,并通过使用CLIP对其中一个帧进行编码,来提取内容表示

(We extract a structure representation s by encoding depth maps obtained with MiDaS, and a content representation c by encoding one of the frames with CLIP. )

然后,在、

、以及通过交叉注意块提供的

的帮助下,模型学习在潜在空间中逆转扩散过程

- 在上图右侧的推理过程中,输入视频的结构

以同样的方式提供。为了通过文本指定内容,将CLIP文本嵌入转换为图像嵌入(To specify content via text, we convert CLIP text embeddings to image embeddings via a prior)

1.1.2.1 对潜在扩散模型的回顾

扩散模型的正向扩散过程被定义为

将符合正太分布的噪声缓慢添加到每个样本,得到

,该正向扩散过程模拟一个马尔科夫链,噪声的方差为

,而

至于逆向过程则根据以下公式定义

其中,方差是固定的,只需学习其中的均值

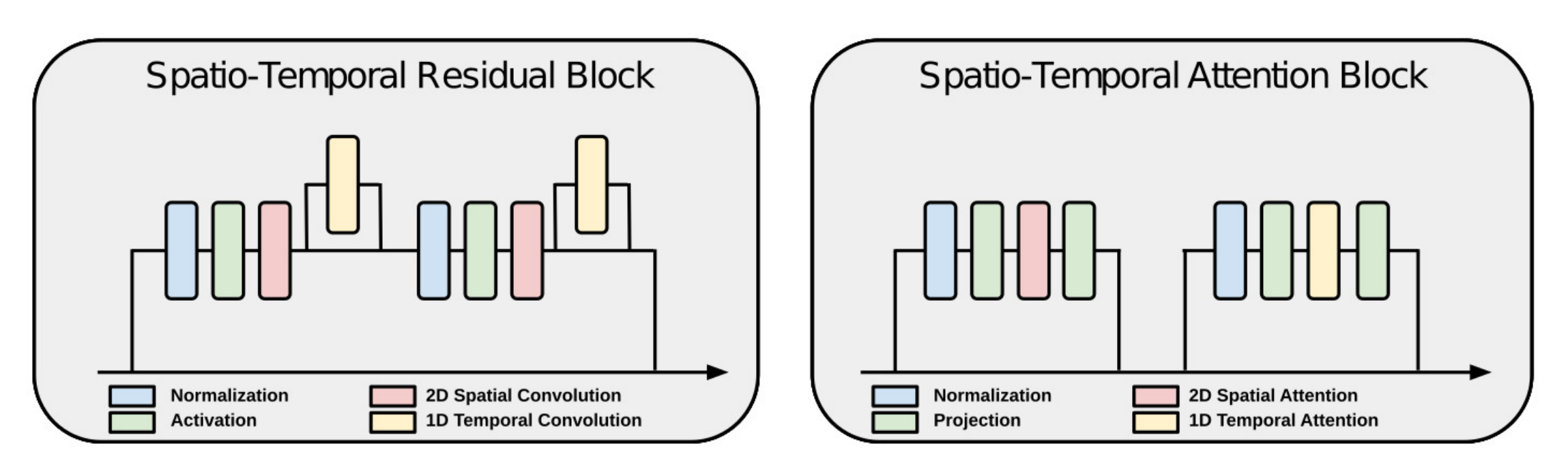

即可,我们需要优化目标的损失函数即为

最终转化为

友情提醒,如果你对上述扩散模型DDPM的推导有任何疑问,可参见此文的第二部分《AI绘画能力的起源:从VAE、扩散模型DDPM、DETR到ViT/Swin transformer》,对关于DDPM的每一步骤的推导都非常详尽

1.1.2.2 时空潜在扩散(Spatio-temporal Latent Diffusion)

为了可以正确的对视频帧的分布进行建模,需要做以下工作

- 引入时间层来扩展图像架构,且这些时间层仅对视频输入有效,另自动编码器保持固定并独立处理视频中的每一帧

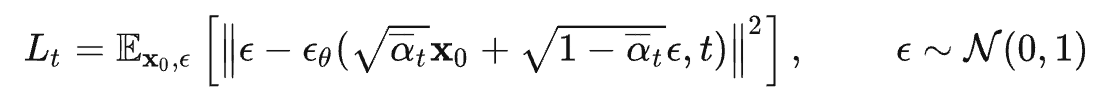

we extend an image architecture by introducing temporal layers, which are only active for video inputs. All other layers are shared between the image and video model. The autoencoder remains fixed and processes each frame in a video independently. - UNet主要由两个模块组成:残差块和transformer块,通过添加跨时间的一维卷积和跨时间的一维自注意力将它们扩展到视频(we extend them to videos by adding both 1D convolutions across time and 1D self-attentions across time)

在每个残差块中,如上图左侧所示,在每个2D卷积之后引入一个时间卷积(In each residual block, we introduce one temporal convolution after each 2D convolution)

同样的,如上图右侧所示,在每个2D transformer块后,都包含一个temporal 1D transformer block(which mimics its spatial counterpart along the time axis),且将learnable positional encodings of the frame index输入到temporal transformer blocks中

相当于在每个空间卷积之后添加一个一维时间卷积(注意,是空间卷积 VS 时间卷积)

在每个空间注意力层之后添加一个一维时间注意力层(注意,是空间注意力 VS 时间注意力)

- 最终实现时,将图像视为只有单帧的视频,以统一处理这两种情况

批量大小为b、帧数为n、通道数为c、空间分辨率为w ✖️ h,即形状为b × n × c × h × w的分批张量,被重新排列为「w × h (i.e. shape b × n × c × h × w) is rearranged to」

(b · n) × c × h × w for spatial layers, to

(b · h · w) × c × n for temporal convolutions, and to

(b · h · w) × n × c for temporal self-attention

//待更

1.1.2.3 结构与内容的表示(Representing Content and Structure)

扩散模型非常适合对等条件分布进行建模,由于大规模配对的视频-文本数据集比较缺乏,所以只能限制在无字幕的视频数据上进行训练

- 总之,我们的目标是根据用户提供的编辑视频的文本提示来编辑视频,但还是面临一个问题:即我们没有视频三元组的训练数据、编辑prompt、和生成的输出,也没有成对的视频和文本字幕(Thus, while our goal is to edit an input video based on a text prompt describing the desired edited video, we have neither training data of triplets with a video, its edit prompt and the resulting output, nor even pairs of videos and text captions)

- 因此,我们必须从训练视频

本身导出结构和内容的表示,即

、

,从而损失函数为

- 相反,在推理过程中,结构

和内容

分别来自输入视频

和文本提示

, edited version x of y通过对以

、

为条件的生成模型进行采样获得的

内容表示层面上

- 为了从文本输入x和视频输入x都可以推断出内容表示(content representation),他们利用CLIP的image embeddings来表示 represent content.

对于视频输入,他们在训练期间随机选择一个输入帧,类似于可以训练一个先验模型,该模型允许从text embeddings中采样image embeddings,这种方法可以通过图像输入而非文本来指定编辑This approach enables - 待更..

// 待更

1.2 Gen-2获得了史诗级的升级——可以从头开始生成视频

很多同学还没来得及体验Gen-1,没想到在2023年3月份,runway很快又推出了Gen-2的内测版本,并于6月份正式对外发布(这是runway对Gen-2介绍的页面:https://research.runwayml.com/gen2),相比Gen-1,Gen-2获得了史诗级的升级——可以从头开始生成视频。如果说去年发布的stable diffusion/midjourney是文生图的代表,那Gen2便是文生视频的第一个代表

- Gen-2刚开始发布时还只能生成4秒钟的视频,每个用户的免费试用额度为105秒,即可以生成约26个Gen2视频

- 到了8月份,生成视频的最大长度便从4s提升到了18s

- 9月,新增导演模式,可以控制镜头的位置和移动速度

1.2.1 基于Gen-2生成视频的8种模式

- Text to Video

- Text + Image to Video

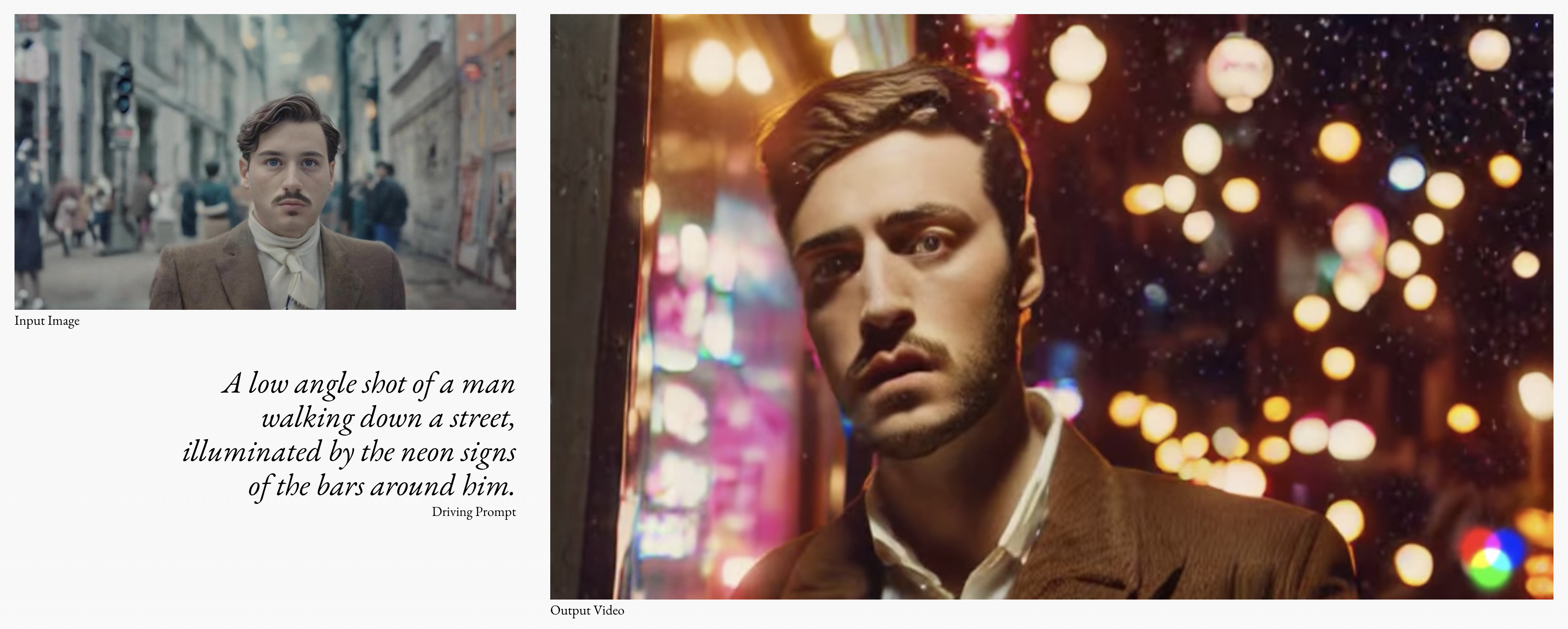

- Image to Video,比如输入下面这张图片

Gen-2便可以根据上面这张图片生成对应的视频

Gen2:Image to Video

- Stylization

- Storyboard

- Mask

- Render

- Customization

1.2.2 Gen-2在23年11月的更新:生成视频4K超高清且涂哪动哪

Gen-2在11月份连续推出2次重大更新

- 11月3日,Runway的Gen-2发布里程碑式更新,支持4K超逼真的清晰度作品

- 11月21日,上线“涂哪动哪”的运动笔刷新功能,直接标志出生成模型可控性上的一个重要里程碑

第二部分 Meta发布生成式视频模型:Emu Video

11月16日,Meta发布文生视频模型Emu Video,该模型既支持灵活的图像编辑(例如把「兔子」变成「吹小号的兔子」,再变成「吹彩虹色小号的兔子」),也支持根据文本和图像生成高分辨率视频(例如让「吹小号的兔子」欢快地跳舞)

那其背后的原理是怎样的呢?事实上,这其中涉及两项工作

- 灵活的图像编辑由一个叫「Emu Edit」的模型来完成。它支持通过文字对图像进行自由编辑,包括本地和全局编辑、删除和添加背景、颜色和几何转换、检测和分割等等

此外,它还能精确遵循指令,确保输入图像中与指令无关的像素保持不变,比如给鸵鸟穿裙子

- 高分辨率的视频则由一个名叫「Emu Video」的模型来生成。Emu Video 是一个基于扩散模型的文生视频模型,能够基于文本生成 512x512 的 4 秒高分辨率视频。且有人工评估表明,与 Runway 的 Gen-2 以及 Pika Labs 的生成效果相比,Emu Video 在生成质量和文本忠实度方面的得分可能更高。以下是它的生成效果:

在其官方博客中,Meta 展望了这两项技术的应用前景,比如让社交媒体用户自己生成动图、表情包,按照自己的意愿编辑照片和图像等等。当然,关于生成动图/表情包这点,Meta 在之前的 Meta Connect 大会上发布 Emu 模型时也提到过(参见:Meta 版 ChatGPT 来了:Llama 2 加持,接入必应搜索,小扎现场演示)

接下来,我们分别介绍下这两个模型

2.1 Emu Edit :精确的图像编辑

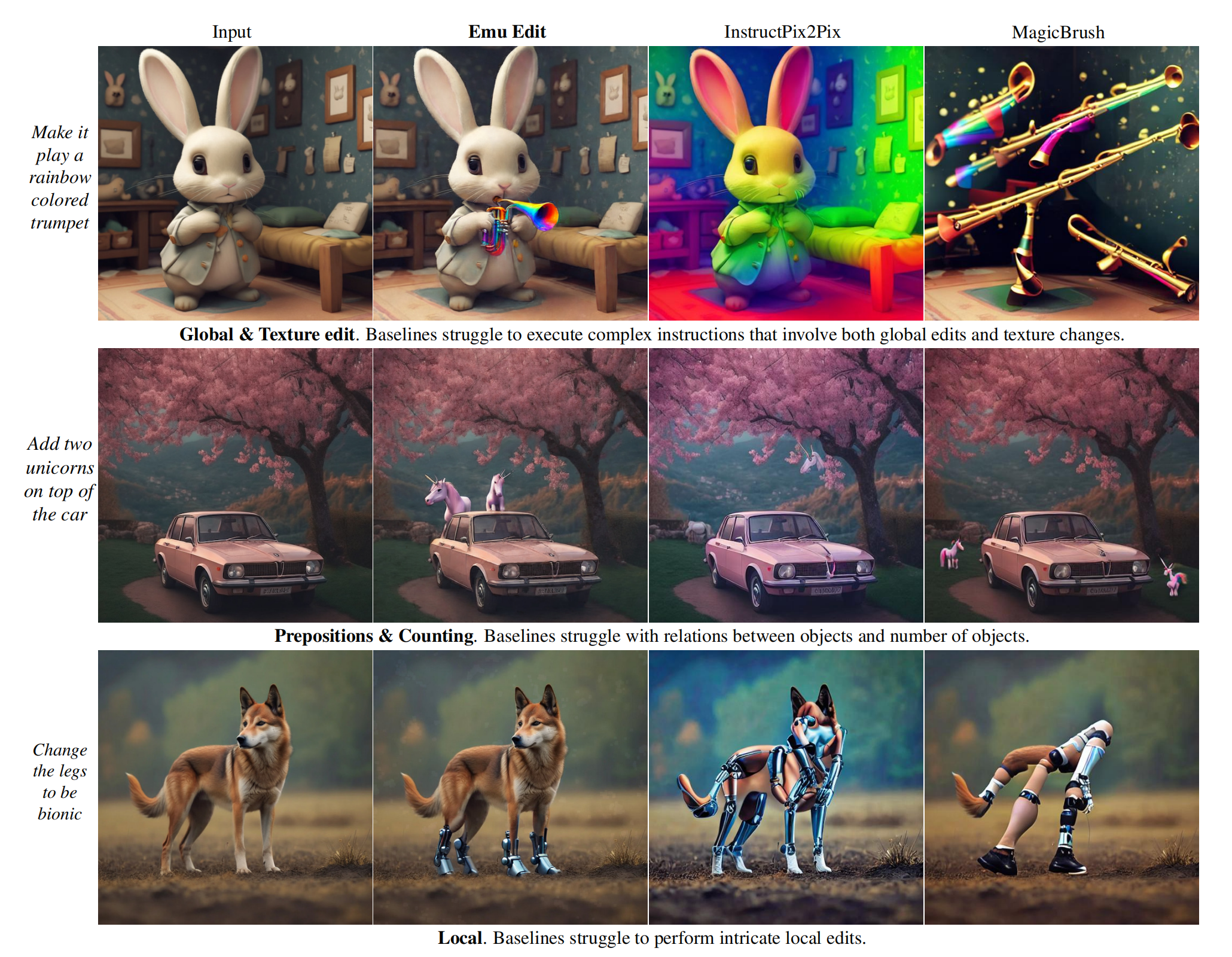

2.1.1 相比InstructPix2Pix的优势:更准确的执行指令

Emu Edit对应的论文为《Emu Edit: Precise Image Editing via Recognition and Generation Tasks》,其项目地址则为:https://emu-edit.metademolab.com/

如该论文中所说,如今每天都有数百万人使用图像编辑。然而,流行的图像编辑工具要么需要相当多的专业知识,使用起来很耗时,要么非常有限,仅提供一组预定义的编辑操作,如特定的过滤器

好在如今基于指令的图像编辑(Instruction-based image editing)试图让用户使用自然语言指令来解决这些限制。例如,用户可以向模型提供图像并指示其「给鸸鹋穿上消防员服装」这样的指令

然而,虽然像 InstructPix2Pix 这类基于指令的图像编辑模型可以用来处理各种给定的指令,但

- 它们通常很难准确地解释和执行指令

顺带说明下,instructable - pix2pix引入了一个可指导的图像编辑模型,他们通过同时利用GPT-3和Prompt-to-Prompt来开发这个模型,以生成一个用于基于指令的图像编辑的大型合成数据集,并利用该数据集来训练一个可遵循指令的图像编辑模型

与使用合成数据集的InstructPix2Pix不同,Mag-icBrush通过要求人类使用在线图像编辑工具,开发了一个人工标注的指令引导的图像编辑数据集,然后在此数据集上微调instructable - pix2pix可以提高图像编辑能力 - 此外,这些模型的泛化能力有限,通常无法完成与训练时略有不同的任务,例如下图,当让小兔子吹彩虹色的小号,其他模型要么把兔子染成彩虹色,要么是直接生成彩虹色的小号

为了解决这些问题,Meta 引入了 Emu Edit,这是首个在多样化的任务上训练而成的图像编辑模型,如前所述,Emu Edit 可以根据指令进行自由形式的编辑,包括本地和全局编辑、删除和添加背景、颜色改变和几何变换、检测和分割等任务。

与当今许多生成式 AI 模型不同,Emu Edit 可以精确遵循指令,确保输入图像中与指令无关的像素保持不变。例如,下图左侧,用户给出指令「将草地上的小狗移除」,移除物体后的图片几乎看不出来有什么变化,再比如下图右侧,移除图片中左下角的文本,再给图片换个背景,Emu Edit 也能处理得很好:

2.1.2 开发一个1000万规模的数据集,涵盖16个不同的任务

考虑到市面上已有的数据规模、多样性、质量都有限,故为了训练这个模型,Meta 开发了一个包含 16个不同的任务 和 1000 万个合成样本的数据集,每个样本都包含一个输入图像、对要执行任务的描述(即文本指令),以及目标输出图像、任务索引「Each example (cI , cT , x, i)in our dataset, contains an input image cI , a text instruction cT , a target image x, and a task index i (out of the sixteen)」,具体而言:

- 任务列表

这16个任务分为三个主要类别:基于区域的编辑、自由形式的编辑、视觉任务Region-Based EditingLocal : Substituting one object for another, altering an object’s attributes (e.g., “make it smile”)Remove: Erasing an object from the imageAdd: Inserting a new object into the image Texture : Altering an object’s visual characteristics with out affecting its structure (e.g., painting over, filling orcovering an object)Background: Changing the scene’s background Free-Form Editing Global : Edit instructions that affect the entire image, or that can not be described using a mask (e.g., “let’s see itin the summer”)Style: Change the style of an image Text Editing : This involves text-related editing taskssuch as adding, removing, swapping text, and altering thetext’s font and colorVision tasksDetect : Identifying and marking a specific object with in the image with a rectangle bounding boxSegment : Isolating and marking an object in the imageColor: Color adjustments like sharpening and blurring Image-to-Image Translation : Tasks that involve bi directional image type conversion, such as sketch-to image, depth map-to-image, normal map-to-image,pose to-image,segmentation map-to-image, and so on - 文本指令的生成

为了生成编辑指令,我们利用了对话优化的700亿参数Llama 2的变体,具体来说,我们为LLM提供了一个任务描述,一些特定于任务的范例,和一个真实的图像描述

为了增加多样性,我们对范例进行采样,并随机化它们的顺序。给定这样的输入,我们期望LLM输出:

(1)一个编辑指令

(2)一个理想输出图像的输出标题

(3)哪些对象应该被更新或添加到原始图像中

以下是他们设计的prompt- def get_content_instruction(new_prompt):

- optional_verbs = choice(["include", "place", "position", "set", "incorporate", "alongside",

- "give", "put", "insert", "together with", "with", "make", "integrate",

- "have", "append", "make", "add", "include"])

- # system message #

- system_message = (

- f"<<SYS>>\n"

- "You are an assistant that only speaks JSON. Do not write normal text. The assistant answer is "

- "JSON with the following string fields: 'edit', 'edited object','output'. Here is the latest "

- "conversation between Assistant and User.\n"

- "<</SYS>>"

- )

- # introduction message #

- intro_message = (

- f"[INST]User: Hi, My job to take a given caption ('input') and to output the following: an "

- f"instruction for {optional_verbs} an object to the image ('edit'), the object to {optional_verbs} "

- "('edited object'), and the caption with the object ('output'). Please help me do it. "

- "I will give you the 'input', and you will help. When you reply, use the following format: "

- "{\"edit\": '<instruction>', 'edited object': '<object>', 'output': '<caption>'}[/INST]\n"

- "Assistant: Sure, I'd be happy to help! Please provide the actual input caption you'd like me to "

- f"read and I'll assist you with writing an instruction to {optional_verbs} an object to the "

- "image, writing the added object and writing the caption with the object."

- )

- # shuffling #

- random.seed(torch.randint(1 << 32, ()).item())

- shuffle(few_shot_examples)

- few_shot_examples = few_shot_examples[:int(len(few_shot_examples) * 0.6)]

- prompt = system_message + intro_message + "".join(few_shot_examples)

- # add the test prompt #

- prompt += f"[INST]User: {new_prompt}[/INST]"

- return prompt

- 图像对生成(Image Pairs Generation)

在创建一对输入和编辑图像时,一个至关重要的先决条件是保证两个图像只在特定的元素或位置上不同,而在所有其他方面保持相同。以往基于指令的图像编辑方法依赖于Prompt-to-Prompt (P2P)来构建图像编辑数据集

A crucial prerequisite when creating a pair of input and edited images is to guarantee that the two images differ only in specific elements or locations, while remaining identical in all other aspects.

Previous instruct-based image editing methods [Instructpix2pix: Learning to follow image editing instructions] rely on Prompt-to-Prompt (P2P) to build an image-editing dataset.

P2P injects cross-attention maps from the input image generation to the edited image generation.

为了支持局部编辑,P2P还基于cross-attention maps去近似编辑部分的掩码,并将编辑限制在该局部区域

P2P依赖于输入图像标题和编辑图像标题之间的字对字对齐(比如“一只猫骑自行车”和“一只猫骑汽车”),来生成编辑图像对

然而,当没有单词到单词对齐时,由于依赖cross-attention maps,生成的掩码往往不精确

To support local edits, P2P additionally approximates a mask of the edited part,based on the cross-attention maps and constrains the edit to this local area.

P2P relies on word-to-word alignment between the input image caption and the edited image caption (e.g. "a cat riding a bicycle" and "a cat riding a car") to produce editing image pairs.

However, when there is no word-to-word alignment, the resulting mask tends to be imprecise due to its reliance on cross-attention maps.

此外,由于在大多数图像编辑任务中,单词到单词对齐不是一个实用的假设,这种方法通常无法保留structure and identity

为应对这一挑战,本文提出一种掩码提取方法,应用于编辑过程之前

我们的方法涉及:

(i)通过LLM从编辑指令中识别编辑区域,并在生成图像之前创建相应的掩码

以及(ii)在编辑过程中集成这些掩码,以确保编辑区域与原始图像的无缝融合

Furthermore, as word-to-word alignment is not a practical assumption in most of the image editing tasks, this approach often fails to preserve structure and identity.

To address this challenge, we propose a mask extraction method, which is applied before the editing process.

Our approach involves:

(i) identifying the edited areas from the editing instruction via an LLM and creating corresponding masks before image generation,

and (ii) integrating these masks during the editing process to ensure seamless fusion of edited regions with the original image. - 此外,还利用了包括膨胀和高斯模糊等技术,来完善蒙版

We utilize various tech-niques, including dilation and Gaussian blurring, to refinethe masks

且采用了一种全面的过滤方法来确保数据集的保真度(We employ a comprehensive filtering approachto ensure the fidelity of the dataset)

这包括:

(i)使用任务预测器,用应该属于另一个任务的指令重新分配样本,即us-ing the task predictor (Sec. 4.2) to reassign samples withinstructions that should belong to another task

(ii)应用CLIP滤波指标[2],即apply-ing CLIP filtering metrics [2]

(iii)基于输入图像的深度图和编辑图像之间的L1距离使用结构保留滤波,即employing structure pre-serving filtering based on the L1 distance between the depthmap of the input image and the edited image

(iv)应用图像检测器根据指令中指定的对象验证元素的存在(在Add任务中)、缺失(在Remove任务中)或替换(在Local任务中),即apply-ing image detectors to validate the presence (in Add task),the absence (in Remove task) or replacement (in Local task)of elements, according to the objects specified in the in-struction

这个过程过滤掉了70%的数据,产生了一个包含1000万个样本的最终数据集

2.1.3 模型架构:基于潜在扩散模型先预训练、后通过几千张带标注的图像做微调

和经典老方法一样,先做预训练,然后微调(The Emu model is a two-stage approach that begins with a pre-training phase and concludes with aquality fine-tuning stage)。该方法的关键在于,微调数据集相对较小,只包含几千张图像,但必须具有非凡的质量,通常需要人工标注

- Emu采用了潜在扩散模型架构[High-resolution image synthesis with latent diffusion models],支持高分辨率图像生成,并与编码器E和解码器d合并了一个16通道自动编码器

support high-resolution image generation and incorporated a 16-channel autoencoder with encoder E and decoder D. - 一个大型U-Net,ϵθ,包含28亿个参数,θ,来自CLIP ViT-L和T5-XXL的文本嵌入,以及包含11亿张图像的大量预训练数据集,促进了模型学习复杂语义和更精细细节的能力,噪声偏移策略(noise-offset strategy)有助于生成高对比度和美观的图像

A large U-Net, ϵθ, with 2.8 billion parameters, θ, text embeddings from CLIP ViT-L [18] and T5-XXL [19], and a substantial pre-training dataset of 1.1 billion images facilitate the model’s ability to learn complex semantics and finer details, with a noise-offset strategy contributing to high-contrast and aesthetically pleasing image generation. - Given the encoded latent of an image z = E(x), the diffusion process generates a noisy latent zt where the noise level increases over timesteps t ∈ T.

为了将Emu转换为基于指令的图像编辑模型,我们以要修改的图像cI和指令cT为条件(To convert Emu to an instructionbased image editing model, we condition it on the image to be modified cI and the instruction cT )

Emu Edit需要最小化下面的优化问题

其中∈N(0,1)是由扩散process和y =(cT,cI,x)是指令、输入图像和来自数据集的目标图像的三元组。在实践中,我们用Emu的权值来初始化Emu Edit的权值

where ϵ ∈ N(0, 1) is the noise added by the diffusion process and y = (cT , cI , x) is a triplet of instruction, input image and target image from the dataset. In practice, we initialize the weights of Emu Edit with the weights of Emu

2.1.4 训练的两个关键:多任务训练、通过交叉注意力融合任务嵌入向量和时间步嵌入

而在训练方法上主要有两个关键

- 首先,他们为16个任务的每个任务都开发了独特的数据管理pipeline,Meta发现,在所有任务上训练单个模型,比在每个任务上独立训练专家模型产生更好的结果。且随着训练任务数量的增加,Emu Edit的性能也会增加

- 其次,为了有效地处理各种各样的任务,引入了学习任务嵌入(learned task embeddings)的概念,用于引导生成过程朝着正确的生成任务方向发展

Second, to process this wide array of tasks effectively,we introduce the concept of learned task embeddings,which are used to steer the generation process toward the correct generative task.

具体来说,对于每个任务,都学习一个独特的任务嵌入向量,并通过交叉注意力交互将其集成到模型中,并将其添加到时间步嵌入中(we learn a unique task embedding vector, and integrate it into the model through cross-attention interactions, and by adding it to the timestep embeddings)

他们证明,学习到的任务嵌入显著增强了该模型从自由形式的指令中准确推断出适当的编辑意图并执行正确编辑的能力

在这个过程中,保持模型权重不变,并仅更新一个任务嵌入以适应新任务。实验表明,Emu Edit可以快速适应新的任务,如超分辨率

下面重点解释一下学习任务嵌入( Learned Task Embedding)

为了引导生成过程走向正确的发展方向,他们为数据集中的每个任务学习一个嵌入向量

- 在训练期间,给定我们数据集中的一个样本,我们使用任务索引

,从嵌入表中获取任务的嵌入向量

,并与模型权重联合优化它(we use the task index, i, to fetch the task’s embedding vector, vi, froman embedding table, and optimize it jointly with the modelweights)

- 具体而言,我们通过交叉注意交互将任务嵌入到U-Net中,并将其添加到时间步长嵌入中(We do so by introducing the task embedding vias an additional condition to the U-Net, ϵθ. Concretely,we integrate the task embedding into the U-Net via cross-attention interactions, and by adding it to the timestep em-beddings)

优化问题更新为

其中

是我们数据集中的任务总数,

是来自数据集中的输入图像、输入指令文本、目标图像和任务索引的四元组

// 待更

2.2 Emu Video:先生成图像,再通过图像和文本生成视频

2.2.1 EMU VIDEO:Factorizing Text-to-Video Generation by Explicit Image Conditioning

大型文生图模型在网络规模的图像-文本对上经过训练,可生成高质量的多样化图像,然问题是

- 虽然这些模型可以通过使用视频-文本对进一步适用于文本 - 视频(T2V)生成,但视频生成在质量和多样性方面仍然落后于图像生成

与图像生成相比,视频生成更具挑战性,因为它需要建模更高维度的时空输出空间,而能依据的仍然只是文本提示。此外,市面上现有的视频-文本数据集的规模通常比图像 - 文本数据集小一个数量级 - 视频生成的主流模式是使用扩散模型一次生成所有视频帧。与此形成鲜明对比的是,在 NLP 中,长序列生成被表述为一个自回归问题:以先前预测的单词为条件预测下一个单词

因此,后续预测的条件信号(conditioning signal)会逐渐变强。研究者假设,加强条件信号对高质量视频生成也很重要,因为视频生成本身就是一个时间序列

然而,使用扩散模型进行自回归解码具有挑战性,因为借助此类模型生成单帧图像本身就需要多次迭代

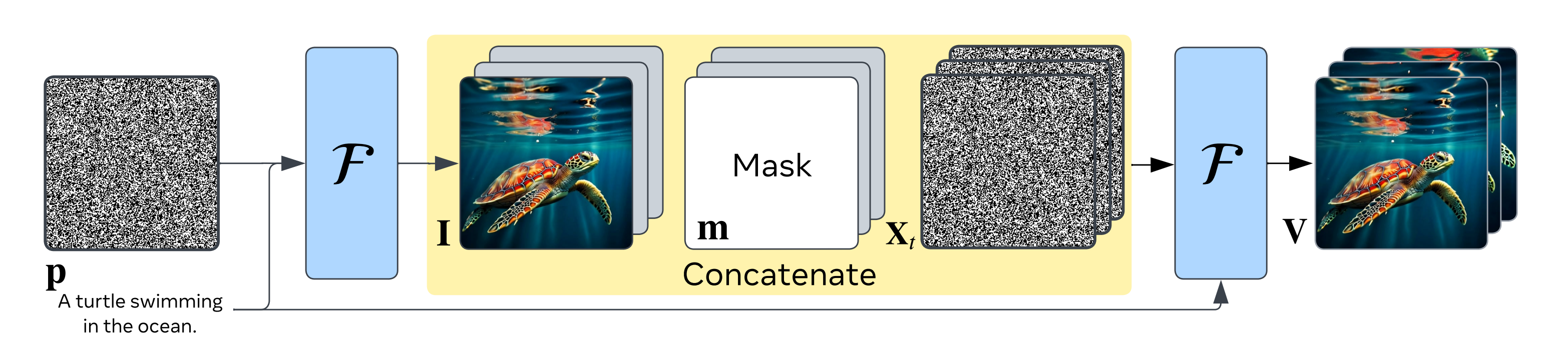

因此,Meta 的研究者提出了 EMU VIDEO,其论文为《EMU VIDEO:Factorizing Text-to-Video Generation by Explicit Image Conditioning》,其项目地址为https://emu-video.metademolab.com/,通过显式的中间图像生成步骤来增强基于扩散的文本到视频生成的条件

具体来说,他们将文生视频问题分解为两个子问题:

- 根据输入的文本提示

,生成图像

- 然后使用更强的条件:生成的图像和文本来生成视频

直观地说,给模型一个起始图像和文本会使视频生成变得更容易,因为模型只需预测图像在未来将如何演变即可

且,为了以图像约束模型,他们暂时对图像进行补零,并将其与一个二进制掩码(指示哪些帧是被补零的)以及带噪声的输入连接起来

那用什么样的文本到图像模型来做初始化呢?我们将文本到图像的U-Net架构用于我们的模型,并使用预训练的T2l模型初始化所有空间参数。该模型同时使用冻结的T5-XL和冻结的CLIP文本编码器从文本提示符中提取特征。U-Net中单独的cross-attention层负责每个文本特征。在初始化之后,模型包含2.7B被冻结的空间参数,以及1.7B被学习的时间参数

The model uses both a frozen T5-XL [15]and a frozen CLIP [58] text encoder to extract features fromthe text prompt. Separate cross-attention layers in the U-Net attend to each of the text features. After initialization,our model contains 2.7B spatial parameters which are kept frozen, and 1.7B temporal parameters that are learned

由于视频 - 文本数据集比图像 - 文本数据集要小得多,研究者还使用权重冻结的预训练文本 - 图像(T2I)模型初始化了他们的文本 - 视频模型

且他们确定了关键的设计决策 —— 改变扩散噪声调度和多阶段训练(adjusted noiseschedules for diffusion, and multi-stage training) —— 该方法支持直接生成 512px 的高分辨率视频,不需要先前方法中使用的一些深度级联模型(without requiring a deep cascade of models as inprior work)

再说一下更多细节

- 我们用预训练的文本到图像模型初始化F,以确保它能够在初始化时生成图像

由于是从预训练的T2I模型初始化并保持冻结状态的,因此我们的模型保留了从大型图像-文本数据集中学习到的概念和风格多样性,并使用它来生成i。这不需要额外的训练成本,而不像Imagen video那样对图像和视频数据进行联合微调以保持这种风格

Since the spatial layers are initialized from a pretrained T2I model and kept frozen, our model retains the conceptual and stylistic diversity learned from large image-text datasets, and uses it to generate I. This comes at no additional training cost unlike approaches [Imagen video] that do joint finetuning on image and video data to maintain such style

当然,许多直接的T2V方法[比如Align your latents: High-resolution video synthesis with latent diffusion models,再比如Make-a-video: Text-to-video generation without text-video data]也从预训练的T2I模型初始化,并保持空间层冻结。然而,它们没有采用我们基于图像的因子分解,因此不能保留T2I模型的质量和多样性Many direct T2V ap-proaches [7, 68] also initialize from a pretrained T2I modeland keep the spatial layers frozen. However, they do notemploy our image-based factorization and thus do not re-tain the quality and diversity in the T2I model

接下来,我们只需要训练F来解决第二步,即推断以文本提示和起始帧为条件的视频

我们通过对起始帧I进行采样,并要求模型同时使用文本提示pxw和图像I调节来预测T帧,从而使用视频-文本对来训练F- 由于使用潜在扩散模型,所以首先使用按帧应用的图像自动编码器将视频V转换为潜在空间X∈R T ×C×H×W,这降低了空间维度

再之后,利用自动编码器的解码器,可以将潜空间转换回像素空间(The latent space can be converted back to the pixel spaceusing the autoencoder’s decode)

视频的T帧被独立去噪,以产生去噪输入Xt,扩散模型被训练去噪(The T frames of the videoare noised independently to produce the noised input Xt,which the diffusion model is trained to denoise)- 我们使用预训练的T2I模型初始化潜在扩散模型F

像「上文1.1.2.2 时空潜在扩散(Spatio-temporal Latent Diffusion)」所述的一样,我们添加了新的可学习的时间参数:在每个空间卷积之后添加一个一维时间卷积

在每个空间注意力层之后添加一个一维时间注意力层

原始的空间卷积层和注意力层被独立应用到每个T帧上,并保持冻结

预训练的T2I模型已经是文本条件,结合上面描述的图像条件,F同时是文本和图像条件

The pretrained T2I model is already text conditioned and combined with the image conditioning described above,Fis conditioned on both text and image

最终如此操作带来的好处是

- 与直接用文本生成视频的方法不同,他们的分解方法在推理时会显式地生成一张图像,这使得他们能够轻松保留文生图模型的视觉多样性、风格和质量,如下图所示

这使得 EMU VIDEO 即使在训练数据、计算量和可训练参数相同的情况下,也能超越直接 T2V 方法

- 且比如通过多阶段的训练方法,文生视频的生成质量可以得到大幅提高

2.2.2 如何延长生成视频的时长

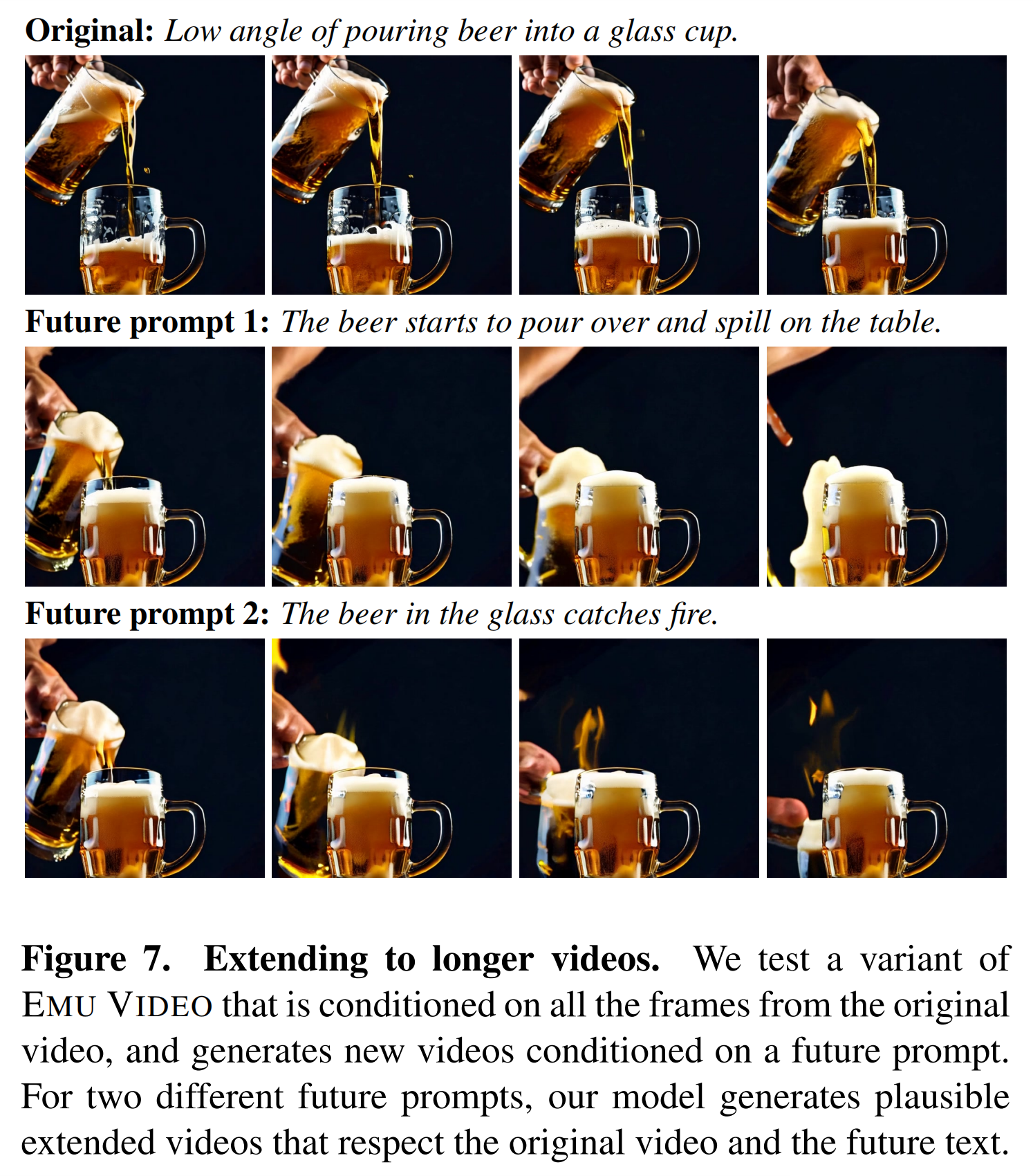

从展示的 demo 中可以看到,EMU VIDEO 已经可以支持 4 秒的视频生成。在论文中,他们还探讨了增加视频时长的方法

作者表示,通过一个小的架构修改,他们可以在 T 帧上约束模型并扩展视频。因此,他们训练 EMU VIDEO 的一个变体,以「过去」16 帧为条件生成未来 16 帧。在扩展视频时,他们使用与原始视频不同的未来文本提示,效果如图 7 所示。他们发现,扩展视频既遵循原始视频,也遵循未来文本提示。

第三部分 PixelDance:生成的视频极具动感

11月18日,字节半路杀出发布PixelDance

- 生成有高度一致性且有丰富动态性的视频,让视频内容真正地动起来,是目前视频生成领域中的最大挑战

- 在这方面,最新的研究成果 PixelDance 迈出了关键性的一步,其生成结果的动态性显著优于目前现有的其它模型,引起了业界的关注

3.1 PixelDance的两种视频生成模式

在官网(https://makepixelsdance.github.io)中,PixelDance 给出了两种不同的视频生成模式

3.1.1 基础模式:通过指导图片+文本描述生成视频

第一种是基础模式(Basic Mode),用户只需要提供一张指导图片+文本描述,PixelDance 就可以生成有高度一致性且有丰富动态性的视频,其中指导图片可以是真实图片,也可以利用现有的文生图模型生成。

从展示的结果来看,真实风格、动画风格、二次元风格、魔幻风格,PixelDance 通通都可以解决,人物动作、脸部表情、相机视角控制、特效动作,Pixeldance 也都可以很好的完成

3.1.2 高级魔法模式:通过两张指导图片+文本描述生成酷炫镜头

第二种是高级魔法模式(Magic Mode),给了用户更多发挥想象力和创造力的空间。在这种模式下,用户需要提供两张指导图片+文本描述,可以更好地生成更有难度的各种炫酷特效镜头

除此之外,官网还展示了完全使用 PixelDance 制作的 3 分钟故事短片

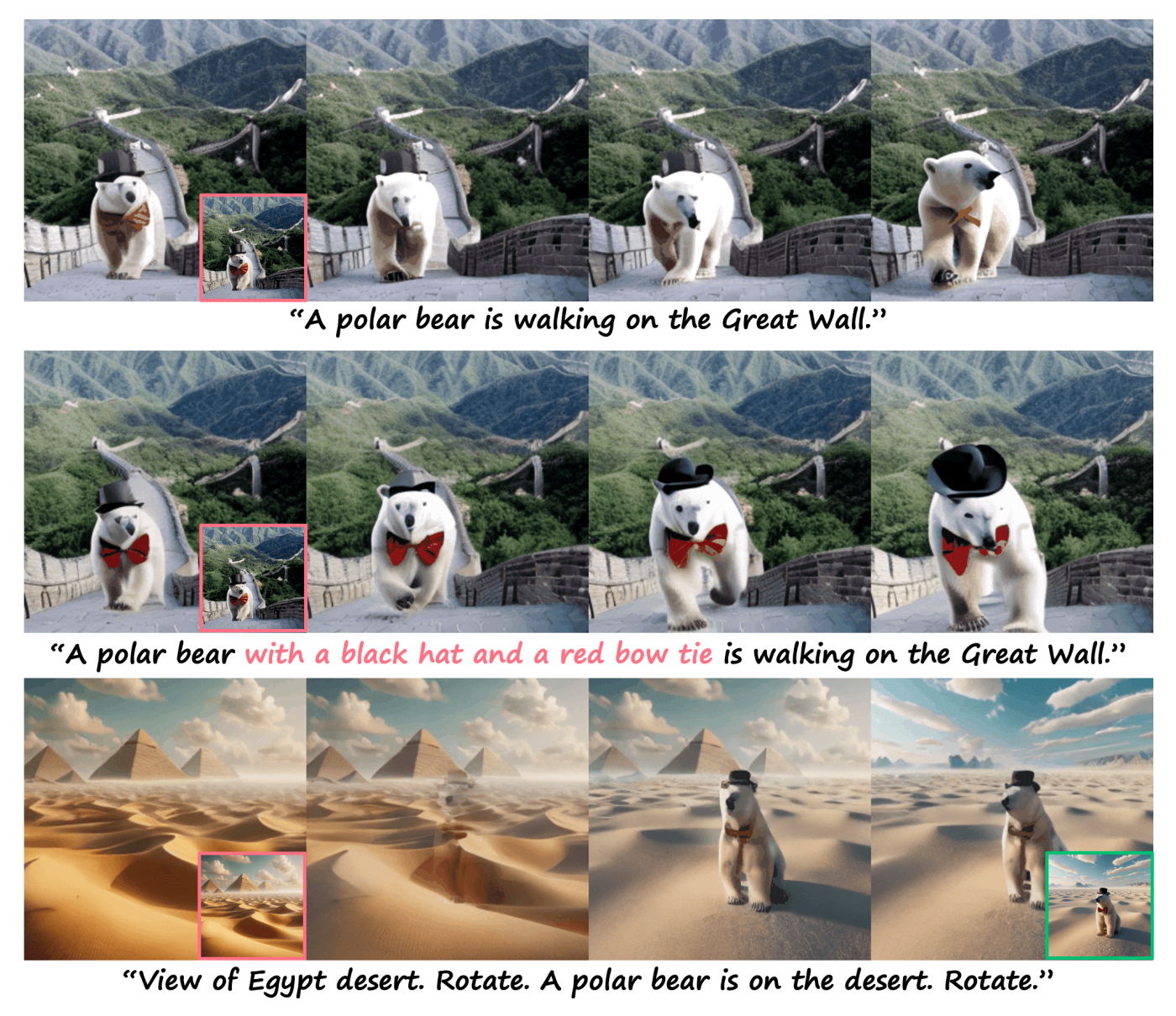

- 使用 PixelDance 能按照用户预想的一个故事,制作每一个场景和对应的动作。不管是真实场景(如埃及、长城等),还是虚幻场景(如外星球),PixelDance 都能生成细节丰富、动作丰富的视频,甚至各种特效镜头也不在话下

- 并且,主人公北极熊先生的黑色礼帽和红色领结形象,在不同的场景中都得到了很好的保持。长视频生成再也不是简单的拼凑弱相关的短视频片段了

而达到这样拔群的视频生成效果,并没有依赖复杂的数据集和大规模的模型训练,PixelDance 在公开的 WebVid-10M 数据集上仅用 1.5B 大小的模型就达到了上述效果

此外,还可以通过用户一个简单的草图作为视频的最后一帧指导视频生成过程(we take the image sketch as anexample and finetune PixelDance with image sketch [49]as the last frame instruction)

3.2 PixelDance的原理解析与其论文解读

3.2.1 PixelDance:基于潜在扩散模型 + <文本指令,第一帧指令,最后一帧指令>为条件

字节团队提出PixelDance的这篇论文《Make Pixels Dance: High-Dynamic Video Generation》中(论文地址:https://arxiv.org/abs/2311.10982,demo 地址:https://makepixelsdance.github.io),可读性非常高,我所看到的关键原因在于毕竟是咱们国人写的,值得反复品读

论文中指出了视频生成难以做出好效果的原因:相比于图片生成,视频生成具有特征空间显著更大、动作多样性显著更强的特点。这就导致了现有的视频生成方法难以学到有效的时域动作信息,生成的视频虽然图片质量较高,但动态性非常有限

而PixelDance是一种基于潜在扩散模型的视频生成方法,以<文本,第一帧,最后一帧>指令为条件(conditioned on <text,first frame,last frame> instructions)

- 文本指令由预训练的文本编码器编码,并与交叉注意力集成到扩散模型中

- 图像指令使用预训练的VAE编码器进行编码,并与perturbed video latents或高斯噪声连接,作为扩散模型的输入

The image instructions are encoded with a pretrained VAE encoder and concatenated with either perturbed video latents or Gaussian noise as the input to the diffusion model - 在训练中,我们使用(ground-truth)第一帧来强制模型严格遵守指令(For the firstf rame instruction, we employ the ground-truth first frame for training, making the model adhere to the first frame in-struction strictly in inference),保持连续视频片段之间的连续性。在推理中,这个指令可以方便地从T2I模型[32]中获得,也可以直接由用户提供

但最后一帧怎么获取呢?因为最后一帧跟第一帧不同,为此,他们开发了三种技术

- 首先,在训练中,从视频剪辑的最后三帧(ground-truth)帧中随机选择最后一帧指令

First, the last frame instruction is randomly selected from thelast three (ground-truth) frames of a video clip - 其次,在指令中引入噪声,以减轻对指令的依赖,并提升模型的鲁棒性

Second, we introduce noise to the instruction to mitigate the reliance onthe instruction and promote the robustness of model

相当于用噪声扰动图像指令的编码潜c image(we perturb the encoded latents cimage of imageinstructions with noise) - 第三,在训练中以一定的概率(例如25%)随机丢弃最后一帧指令。相应地,他们提出了一个简单而有效的推理采样策略

we randomly drop the last frame instruction with a certainprobability, e.g. 25%, in training.

在第一个去噪步骤中,利用最后一帧指令来指导视频生成朝着期望的结束状态发展

During the first τ denoising steps, the last frame instruc-tion is utilized to guide video generation towards the desiredending status.

然后,在剩余的步骤中,指令被丢弃,允许模型生成更多时间上连贯的视频(长达三分钟)。最后一帧指令的影响可以由调整

Then, during the remaining steps, the instruc-tion is dropped, allowing the model to generate more tem-porally coherent video. The impact of last frame instructioncan be adjusted by τ.

论文中讲到,之所以长视频为何不太好生成,原因在于长视频要求连续视频片段之间的无缝过渡以及场景和人物的长期一致性

一般有两种方法:

- 自回归方法(autoregressive methods)[15,22,41]采用滑动窗口来生成以前一片段为条件的新片段

1) autoregressive methods [15, 22, 41] employ a sliding window to generate a new clip conditioned on the previous clip

然而,自回归方法很容易受到质量退化的影响,因为随着时间的推移,误差累积- 分层方法[9,15,17,53]首先生成稀疏帧,然后插值中间帧

hierarchical methods [9, 15, 17, 53] generate sparse frames first, then interpolate intermediate frames

至于分层方法,它需要长视频进行训练,由于在线视频中镜头频繁变化,长视频很难获得

此外,跨更大的时间间隔生成时间上连贯的帧会加剧挑战,这往往会导致初始帧的质量较低,使得插值后期很难取得良好的效果最终,为了生成长视频,PixelDance被训练为严格地遵循第一帧指令,其中前一个视频片段的最后一帧(the last frame from preceding clip),被用作生成后续片段的第一帧指令(is used as the first frame instruction for generating the subsequent clip)

3.2.2 PixelDance的架构:基于2D UNet插入时间和文本指令 + 图像指令注入

我们采用广泛使用的2D UNet作为扩散模型,该模型由一系列空间下采样层和一系列插入跳跃连接的空间上采样层构成(We take the widely used 2D UNetas diffusion model, which is constructed with a series of spatial downsampling layers followed by a series of spatial upsampling layers with inserted skip connections)

- 具体来说,它是由两个基本块构建的,即2D卷积块和2D注意力块。我们通过插入时间层将2D UNet扩展到3D变体,其中2D卷积层之后是沿时间维的1D卷积层,2D注意层之后是沿时间维的1D注意层(此点和Edit video一样,都遵循「上文1.1.2.2 时空潜在扩散(Spatio-temporal Latent Diffusion)」的所述)

Specifically, it is built with two basic blocks, i.e., 2D convolution block and 2D attention block We extend the 2D UNet to 3D variant with inserting temporal layers [22], where 1D convolution layer along temporal dimension after 2D convolution layer, and 1D attention layer along temporal dimension following 2D attention layer. - 该模型可以与图像和视频联合训练,以保持空间维度上的高保真生成能力。对于图像输入,1D时序操作(1D temporal operations)是禁用的

我们在所有时间注意力层中使用双向自注意力,且使用预训练的CLIP文本编码器对文本指令进行编码,the embedding c text通过UNet中的交叉注意层注入,隐藏状态作为查询(query),c text作为键key和值value(hidden states as queries and c text as keys and values)

The model can be trained jointly with images and videos to maintain high-fidelity generation ability on spatial dimension. The 1D temporal operations are disabled for image input.

We use bi-directional self-attention in all temporal attention layers. We encode the text instruction using a pre-trained CLIP text encoder [30], and the embedding c text is injected through cross-attention layers in the UNet with hidden states as queries and c text as keys and values - 图像指令注入(Image Instruction Injection)

我们将第一帧和最后一帧的图像指令与文本指令结合在一起。我们利用ground-truth视频帧作为训练中的指令。

给定第一帧和最后一帧的图像指令,表示为,我们首先使用VAE将它们编码到扩散模型的输入空间中,得到

,其中

We incorporate image instructions for both the first and last frames in conjunction with text instruction. We utilize ground-truth video frames as the instructions in training.

Given the image instructions on the first and last frame, denoted as{If irst, Ilast}, we first encode them into the input space of diffusion models using VAE, result in {ff irst,flast} where f ∈ RC×H×W

为了在不损失时间位置信息的情况下注入指令,那么最终的图像条件被构建为(To inject the instructions without loss of thetemporal position information, the final image condition isthen constructed as):

where. The condition c image和noised latent

沿着通道维度(along the channel dimension)连接起来, 从而作为扩散模型的输入

3.2.3 数据处理与训练细节

最终他们在WebVid-10M上训练视频扩散模型,该模型包含约10M的短视频片段,平均时长为18秒,以分辨率336 ×596为主,可惜的是WebVid-10M有两个问题:

- 虽然每个视频都与一个配对的文本相关联,但该文本只提供了与视频内容弱相关的粗略描述

- WebVid-10M的另一个令人讨厌的问题是所有视频上的水印,这导致水印存在于所有生成的视频中

因此,我们用其他自收集的500K无水印视频片段来扩展我们的训练数据,这些视频片段描述了现实世界的实体,如人类、动物、物体和景观,并与粗粒度的文本描述配对。尽管只包含适度的比例,但将该数据集与WebVid-10M相结合进行训练可以确保PixelDance能够在图像指令不含水印的情况下生成无水印视频(we surprisingly find that combining this dataset with WebVid-10M for training ensures that PixelDance is able to generate watermark-free videos if the image instructions are free of watermarks)

PixelDance在「视频-文本数据集」和「图像-文本数据集」上进行联合训练(PixelDance is trained jointly on video-text dataset and image-text dataset),具体而言

- 对于视频数据,我们随机采样每个视频4 fps的16个连续帧。继之前的工作(Imagen video: High definition video generation with diffusion models),采用LAION-400M作为图像-文本数据集。图像-文本数据每8次训练迭代使用一次(Image-text data are utilized every 8 training iterations)

- 预训练的文本编码器和VAE模型的权重在训练过程中被冻结。他们采用T = 1000时间步长的DDPM进行训练。我们首先以256×256的分辨率训练模型,在32块A100 gpu上进行200K迭代,批大小为192

- 然后对该模型进行微调,以进行另一次更高分辨率的50K迭代,我们将ϵ-prediction[来自Denoising diffusion probabilistic models]纳入训练目标

3.2.4 模型的评估与效果展示

具体来说,我们利用了现有的T2I模型Stable Diffusion V2.1获取第一帧指令,并生成视频给出的文字和第一帧指令(generate videos given the text and first frame instructions)

根据之前的工作[7,44],我们随机选择每个示例中的一个提示符来生成总共2990个视频进行评估,并计算MSR-VTT数据集上的Fr响应视频距离(FVD)[40],和CLIP-similarity (CLIPSIM)[47]

- FID和FVD测量生成的视频和真实数据之间的分布距离

- IS评估生成的视频的质量

- CLIPSIM估计生成的视频和相应文本之间的相似性

MSR-VTT和UCF-101的Zero-short评价结果分别如下面两个表所示

- 与MSR-VTT上的其他T2V方法相比,Pixel-Dance在FVD和CLIPSIM方面实现了最先进的结果,展示了其生成高质量视频的卓越能力,与文本提示更好地对齐

- 值得注意的是,PixelDance的FVD得分为381,大大超过了之前最先进的Mod-elScope[43],另,在UCF-101基准上其FVD为550,PixelDance在各种指标上优于其他模型,包括IS, FID和FVD

如之前所述,他们的视频生成方法包含三个不同的指令:文本,第一帧和最后一帧指令

- 第一个帧指令通过提供更精细的视觉细节,显著提高了视频质量。此外,它是生成多个连续视频片段的关键。有了文本和第一帧指令,与现有模型相比,PixelDance能够生成更多动作丰富的视频,如下图所示

- 最后一帧指令,描绘了视频片段的总结状态,提供了对视频生成的额外控制。此外,我们可以使用last frame指令(下图的最后一个样本)生成一个自然的镜头(we can generate a natural shot transition using last frame instruction)

// 待更

第四部分 Stable Video Diffusion (SVD)

4.1 Stability AI发布生成式视频模型Stable Video Diffusion(SVD)

11月21日,开发并维护stable diffusion后续版本的Stability AI终于发布了他们自家的生成式视频模型Stable Video Diffusion(SVD),支持文本到视频、图像到视频生成,并且还支持物体从单一视角到多视角的转化,也就是3D合成:

4.2 SVD的训练三步骤:图像预训练、视频预训练、视频微调

SVD对应的论文为:《Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets》

论文中确定了训练SVD的三个步骤:

- 文本到图像的图像预训练(image pretraining),即2D文本到图像扩散模型,比如SDXL的工作:Improving Latent Diffusion Models for High-Resolution Image Synthesis

- 规模比较大但低分辨率的视频数据集上的视频预训练(video pretraining on a large dataset at low resolu-tion)

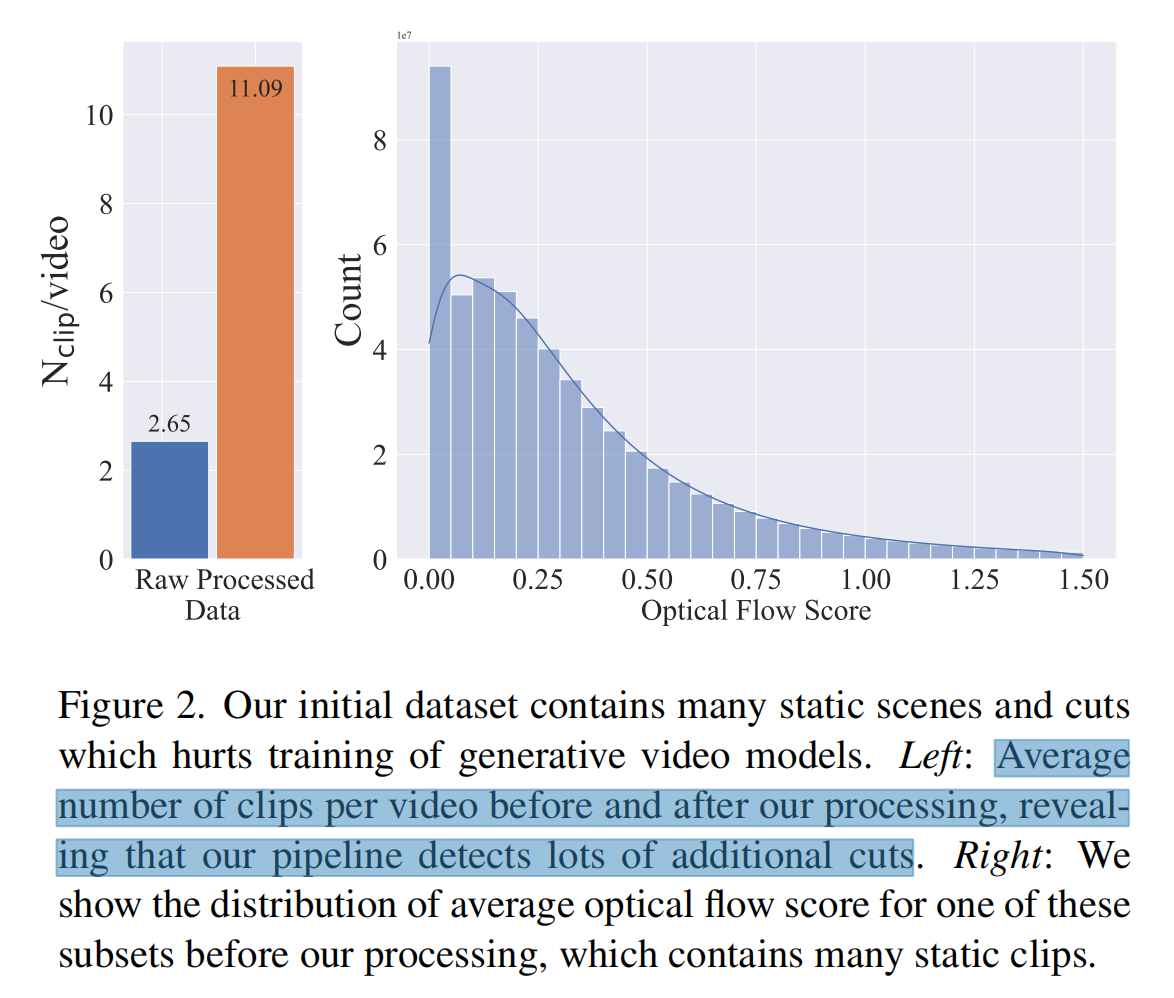

我们收集了一个长视频的初始数据集,它构成了我们的视频预训练阶段的基础数据。然后To avoid cuts andfades leaking into synthesized videos, we apply a cut detec-tion pipeline1 in a cascaded manner at three different FPSlevels. Figure 2, left, provides evidence for the need for cutdetection: After applying our cut-detection pipeline, we ob-tain a significantly higher number (∼4×) of clips, indicat-ing that many video clips in the unprocessed dataset containcuts beyond those obtained from metadata.

接下来,我们用三种不同的合成字幕方法注释每个剪辑:

首先,我们使用图像标题器CoCa来注释每个剪辑的中间帧

然后使用V-BLIP以获得基于视频的字幕

最后,我们通过对前两个字幕进行基于LLM的摘要来生成该剪辑的第三个描述

Next, we annotate each clip with three different syn-thetic captioning methods: First, we use the image captionerCoCa [103] to annotate the mid-frame of each clip and use V-BLIP [104] to obtain a video-based caption. Finally, wegenerate a third description of the clip via an LLM-basedsummarization of the first two captions.

由此产生的初始数据集,我们称之为大型视频数据集(LVD),由580M个带注释的视频片段对组成,形成了212年的内容 - 规模较小但具备高质量的高分辨率的视频数据集上的视频微调(high-resolution video fine tuning on a much smallerdataset with higher-quality videos)

具体而言,他们借鉴了潜图像扩散模型[12,60]的训练技术,并增加了训练示例的分辨率。此外,我们使用了一个小型微调数据集,其中包括250K高视觉保真度的预字幕视频片段

Here, we draw on training tech-niques from latent image diffusion modeling [12, 60] andincrease the resolution of the training examples. More-over, we use a small finetuning dataset comprising 250Kpre-captioned video clips of high visual fidelity

总之,SVD基于Stable Diffusion 2.1,首先用约6亿个样本的视频数据集预训练了基础模型(we apply our proposed curation scheme toa large video dataset comprising roughly 600 million sam-ples and train a strong pretrained text-to-video base model)

然后在较小的高质量数据集上对基础模型进行微调,用于高分辨率的下游任务(finetune the base model on a smaller, high-qualitydataset for high-resolution downstream tasks )

- 如文本到视频(下图,顶部行)

- 和图像到视频,其中我们从单个条件图像预测帧序列(参见下图,中间行)

第五部分 Pika Labs:推出电影特效级视频生成模型Pika 1.0

5.1 两位斯坦福美女博士的创业项目:Pika 1.0

斯坦福的一博士生郭文景(Demi Guo)曾在去年参加Runway的首届AI电影节,发现Runway和Adobe Photoshop的工具并不好用,自己所在团队的作品也并未获奖,于是导致了之后所发生的这一系列事

- 今年4月,郭文景决定从斯坦福退学,开发更好用的AI视频工具,Pika由此诞生(官网地址:https://pika.art),很快联合创始人Chenlin Meng加入

他俩,一个曾参与AlphaFold2的研究,一个则是DDIM论文的二作

- Pika成立后,到现在为止已经有了50万用户,他们每周都会制作数百万个视频

这种爆炸式增长,引起了硅谷投资人的兴趣,让Pika在三轮融资中筹集到了5500万美元(前两轮融资由前 GitHub 首席执行官CEO Nat Friedman领投,而最新一轮的3500万美元A轮融资由Lightspeed Venture Partners领投)

且让人颇受鼓舞的是,仅4人团队估值已超2亿美元 - 今年11月29日,正式发布Pika 1.0,打开了制作3D动画、动漫、卡通、电影等无限想象空间

Pika 1.0不仅能根据文字图片,流畅地生成一段视频,动静转换就在一瞬间:

而且可编辑性还特别强,指定视频中的任意元素,一句话就能实现快速“换装”:

此外,通过Pika 1.0生成的视频比较唯美,比如下面这个宫崎骏画风的视频,我自己还反复看了两三遍,^_^

总结一下,Pika 1.0的新功能包括:

- 文本生成视频/图像生成视频:输入几行文本或上传图像,就可以通过AI创建简短、高质量的视频

- 视频-视频不同风格转换:将现有视频转换为不同的风格,包括不同的角色和对象,同时保持视频的结构

- 扩展(expand):扩展视频的画布或宽高比,将视频从TikTok 9:16格式更改为宽屏16:9格式,AI模型将预测超出原始视频边界的内容,相当于先预测 后补全或填充所需的内容

- 更改:使用 AI 编辑视频内容,比如更换衣服、添加另一个角色、更改环境或添加道具

- 扩展(Extend):使用 AI 扩展现有视频剪辑的长度

- 全新Web界面:Pika 将在Discord和Web上提供

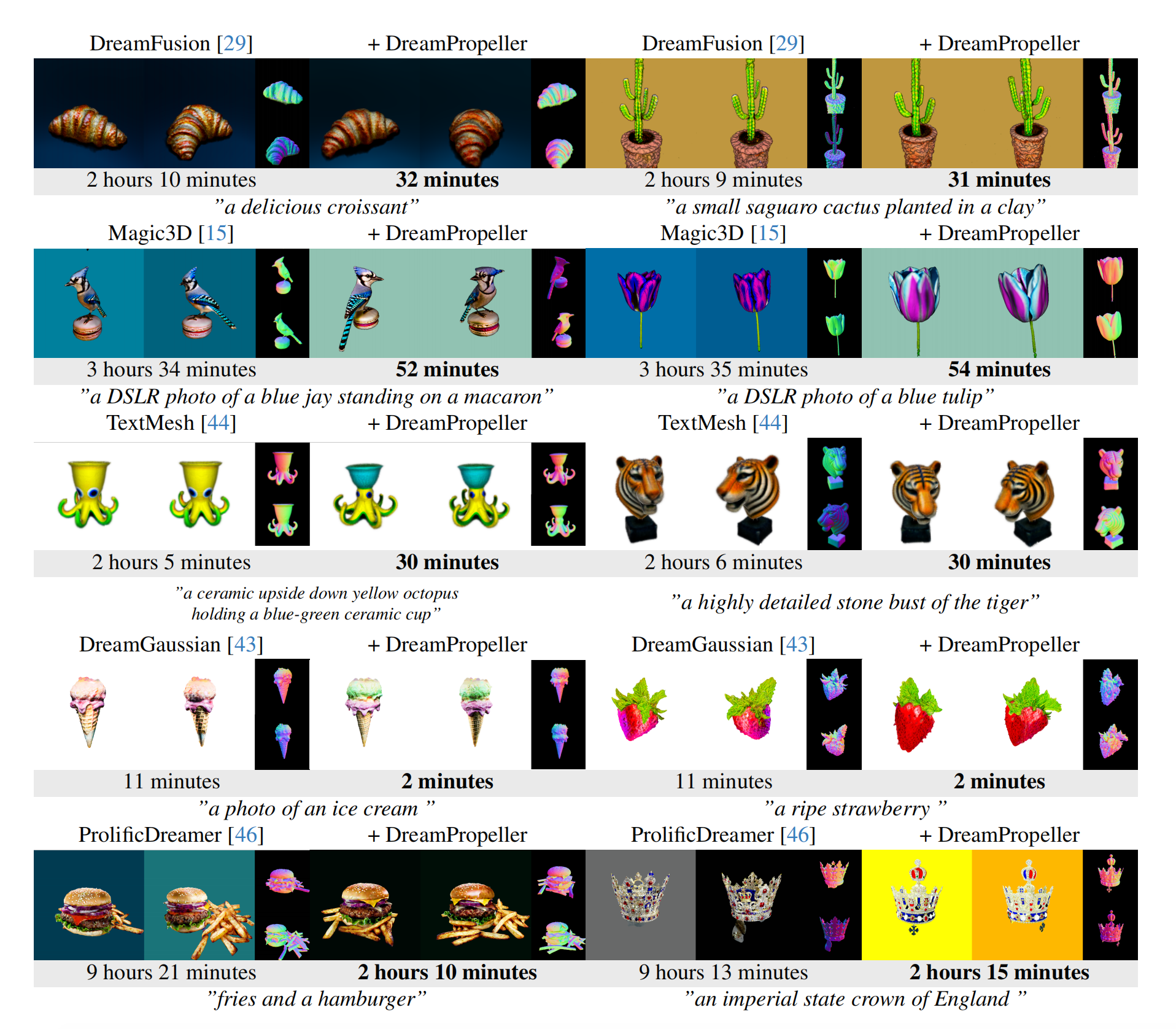

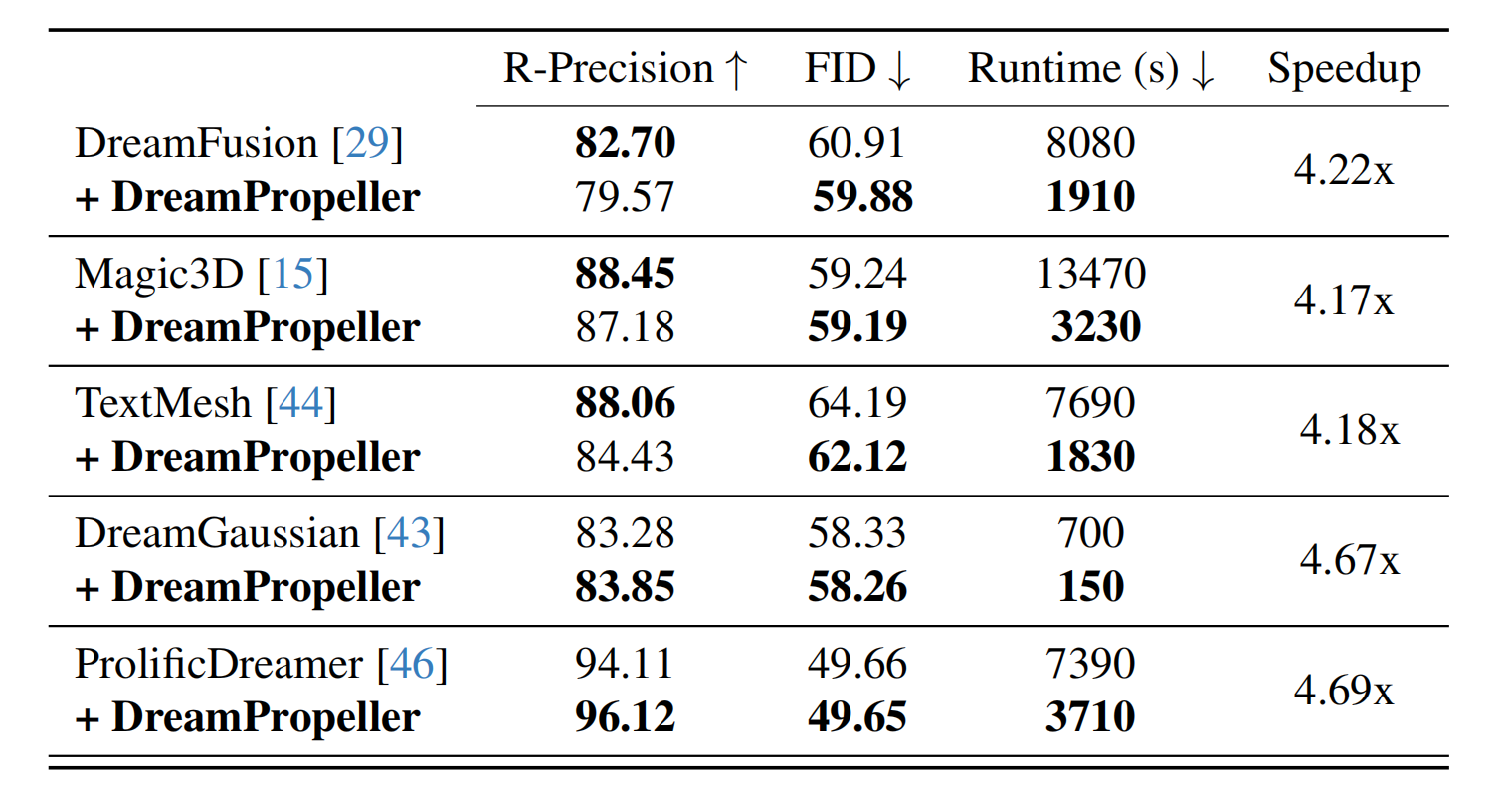

5.2 Pika 1.0技术细节:DreamPropeller通过基于分数蒸馏加速文本到3D的生成过程

以往,通过分数蒸馏,比如DreamFusion、ProlificDreamer等模型,进行文本到3D的生成质量虽高,但运行时间可能长达10个小时。

最新论文中,斯坦福和pika的研究人员通过此论文《DreamPropeller: Supercharge Text-to-3D Generation with Parallel Sampling》,联合提出了一种基于分数蒸馏的加速方法——DreamPropeller,能够将现有方法的速度提高4.7倍

DreamPropeller整体架构如下图所示

- 在每次迭代(k次)的开始,初始化一个由3D形状(用绿色表示)组成的窗口,然后,这些形状被分发到p个GPU上进行并行计算,在GPU上并行计算形状的SDS/VSD梯度

Starting from top left, for iteration k, we initialize a window of 3D shapes (in green) with dimension D and dispatch them to p GPUs for parallelly computing the SDS/VSD gradients, - 然后根据下述公式中的规则收集这些梯度「which are gathered for rollout using the rule in Eq. (9)」,并使用这些梯度对形状进行更新

- 将迭代k + 1得到的形状(橙色)与迭代k得到的形状进行比较,窗口向前滑动,直到该时间步的误差不小于阈值e,阈值e根据窗口的平均/中值误差进行自适应更新

The resulting shapes (in orange) for iteration k + 1 are compared to those in iteration k.

The window is slid forward until the error at that time step is not smaller than the threshold e, which is adaptively updated with the mean/median error of the window

另外,在VSD的情况下,研究人员会在所有GPU上保留LoRA diffusion的独立副本,这些副本会独立更新,无需额外通信

Optionally, in the case of VSD, we keep independent copies of LoRA diffusion on all GPUs which are updated independently without extra communication.

如下是与其他模型的可视化比较,可以看出,使用DreamPropeller的方法能以更短的运行时间实现同样高质量的生成

对DreamFusion图库中的30个提示进行量化评估。运行时间以秒为单位。最新研究的方法达到了具有竞争力的质量,同时速度提高了4倍以上

// 待更

参考文献

- 视频生成新突破:PixelDance,轻松呈现复杂动作与炫酷特效

- 一句话拍大片,导演末日来了?Runway发布文字生成视频模型Gen-2,科幻日系二次元统统拿捏

- 2023年11月 runway Gen2的更新

Gen-2颠覆AI生成视频!一句话秒出4K高清大片,网友:彻底改变游戏规则

文本生视频工具又迎来重大更新,Runway Gen-2 到底有多强? - Meta版ChatGPT来了:Llama 2加持,接入必应搜索,小扎现场演示,介绍了文生图模型Emu

- Meta生成式AI连放大招:视频生成超越Gen-2,动图表情包随心定制

- 斯坦福美女博士创业项目爆火!AI视频生成出道即顶流,半年融资5500万美元

斯坦福华人博士文生视频Pika 1.0爆火!4人公司估值2亿,OpenAI联创参投 - Pika 1.0首测:网友抢先体验电影级炸裂效果,背后技术细节首公开

- 视频生成可以无限长?谷歌VideoPoet大模型上线,网友:革命性技术

- ..

创作、修改、完善记录

- 11.28,一字一句读runway的Gen1论文,完善本文的第一部分

算新增一个新的研究方向:文生视频

我(们)将围绕文生视频,逐一发布一系列解读博客、公开课、课程、商用项目/解决方案等 - 11.29,开始读Meta发布的Emu Edit论文、EMU VIDEO论文,完善本文的第三部分

- 11.30,根据stable video diffusion论文,完善本文的第四部分

并更新第五部分 Pika 1.0相关的内容 - 12.1,通过阅读PixelDance的这篇论文《Make Pixels Dance: High-Dynamic Video Generation》,开始完善第三部分

话说,这篇论文的可读性真的非常好 - 12.2,通过再次回顾Meta的Emu Edit论文,新增一节“2.1.2 开发一个1000万规模的数据集,涵盖16个不同的任务”,以补充关于其数据集的描述

- 12.3,梳理全文 微调细节,最终形成本文的初稿状态

未来半个月还会不断修订、完善本文,且各模型或各技术如有比较关键且新的进展 也会添加至本文中 - 12.9,新增一节:“5.2 Pika 1.0技术细节:DreamPropeller通过基于分数蒸馏加速文本到3D的生成过程”

- 12.25,修订部分文字描述