热门标签

热门文章

- 1SQL之索引分类_sql索引类型

- 2Spring Boot配置devtools实现热部署_spring-boot-devtools compiler automake allow when

- 3Linux内核的GPIO子系统驱动框架详解以及基于pinctrl和gpio子系统的LED驱动程序_gpio驱动代码流程

- 4人工智能论文写作_ai论文写作

- 5git pull error: Pulling is not possible because you have unmerged files.hint: Fix them up in the ...

- 6Docker官方公共仓库Docker Hub被黑,涉及19万帐户,目前GitHub令牌被撤销且无法编译项目...

- 7vue3加ts构建项目步骤_vue3 创建项目生成ts

- 8二叉搜索树(BST),哈希表讲解及Java实现_在具有n个结点的bst中查找数据元素

- 9spark mllib机器学习之二 DecisionTree_"decisiontreeclassificationmodel \"graphvi\" 可视化 t

- 10在境内服务器、虚拟主机上运行未备案域名方法,cf worker反向代理

当前位置: article > 正文

微软开源 WizardLM-2,70B优于GPT4-0613,7B持平阿里最新的Qwen1.5-32B_wizardlm2

作者:AllinToyou | 2024-05-02 16:59:42

赞

踩

wizardlm2

当地时间4月15号,微软发布了新一代大语言模型 WizardLM-2,新家族包括三个尖端型号:WizardLM-2 8x22B, WizardLM-2 70B,和WizardLM-2 7B,作为下一代最先进的大型语言模型,它在复杂聊天、多语言、推理和代理方面的性能有所提高。

性能表现

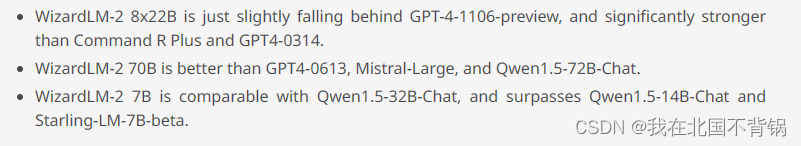

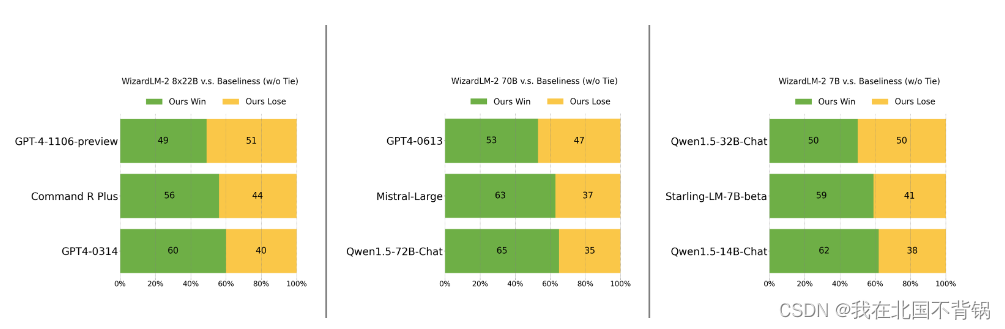

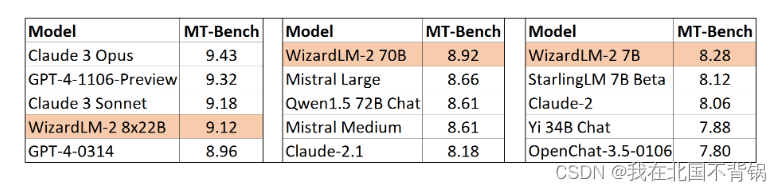

根据微软官方的描述,WizardLM-2展示出了极强的性能表现,7B模型表现与Qwen1.5-32B相当,70B模型超过了GPT4-0613。

- WizardLM-2 8x22B是最先进的型号,与那些领先的专有作品相比,表现出极具竞争力的性能,并且始终优于所有现有的最先进的开源模型,性能只是稍微落后于gpt -4-1106预览版,明显强于Command R Plus和GPT4-0314。

- WizardLM-2 70B达到了顶级的推理能力,是同尺寸的首选,优于GPT4-0613、Mistral-Large、Qwen1.5-72B-Chat。

- Wizardlm - 2 7B是最快的,并达到与现有的10倍大的开源领先模型相当的性能,与Qwen1.5-32B-Chat相当,超过了Qwen1.5-14B-Chat和Starling-LM-7B-beta。

训练方法

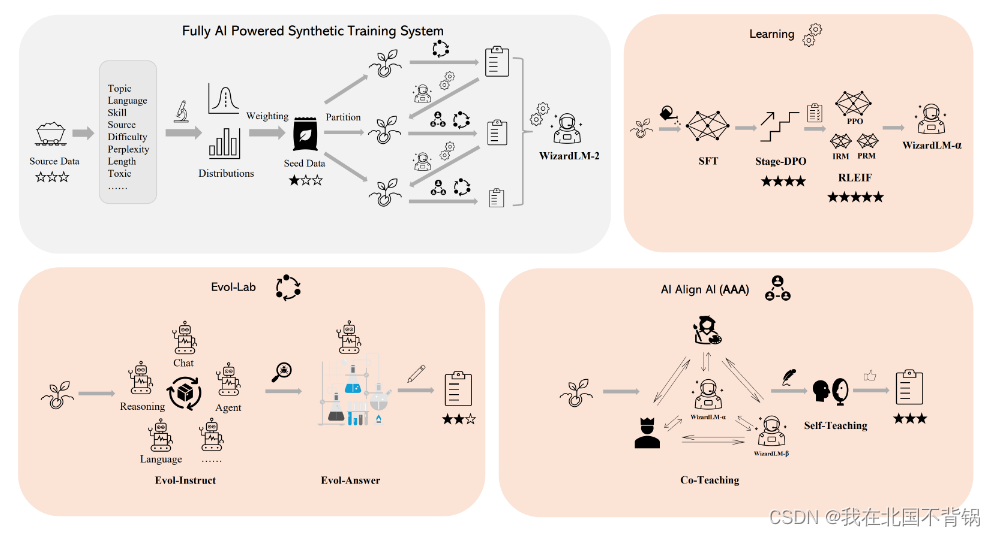

- 数据预处理:通过数据分析管道来获取数据源中不同属性的分布情况。

- 加权抽样:最佳训练数据的分布总是与人类聊天语料库的自然分布不一致; 因此,根据实验经验调整训练数据中各个属性的权重。

- 渐进式学习:与使用所有数据进行一次性训练的常见做法不同, 微软发现使用不同的数据分区和逐步训练可以在更少的数据下获得更好的结果。 在每个阶段,首先将数据片提供给后续的Evol Lab,以获得更多样化和复杂的[指令,响应]对。 利用一个名为“AI Align AI”(AAA)的新框架,可以将多个最先进的llm分组,以相互教学和改进。 最后,依次应用监督学习、Stage-DPO和RLEIF对每个变体进行优化。

- Evol Lab:

(1)Evol-Instruct:重新评估原始的evolution - directive方法中的各种问题 已启动初步修改。新方法使各种代理能够自动生成高质量的指令。

(2)Evolution - answer:指导模型多次生成和重写响应可以改进其逻辑性、正确性和亲和性。 - AI Align AI :

(1)Co-Teaching:收集WizardLMs,以及各种授权的开源和专有的最先进的模型,然后让它们共同教学并相互改进。 教学内容包括模拟聊天、质量评判、改进建议、缩小技能差距等。

(2)Self-Teaching:WizardLM可以生成新的进化训练数据用于监督学习和偏好数据用于强化学习。 - 监督学习和强化学习:

(1)Supervised Learning:使用监督学习来优化模型。

(2)Stage-DPO:为了更有效的离线强化学习,将偏好数据拆分为不同的切片,并逐步改进模型。

(3)RLEIF:采用教学质量奖励模型(IRM)和过程监督奖励模型(PRM)相结合的方法来实现在线强化学习的更精确的正确性。

模型使用

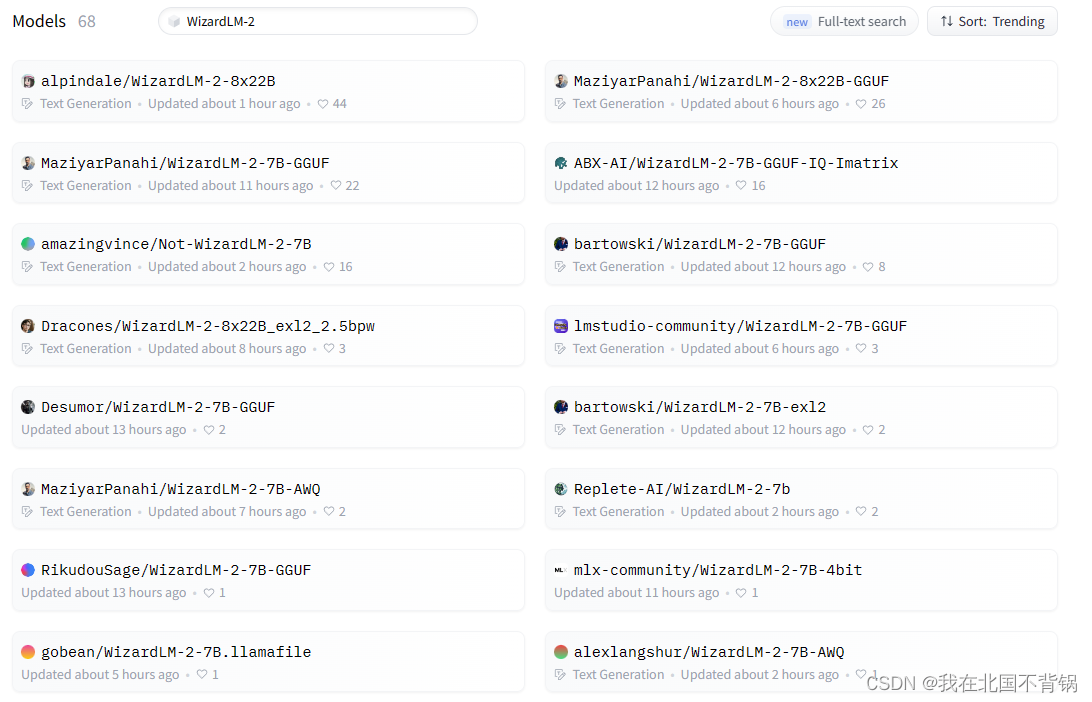

WizardLM-2 8x22B和WizardLM-2 7B的模型权重在Huggingface上共享, wizardlm - 270b以及所有模型的演示将在未来几天内提供。

WizardLM-2采用Vicuna的提示格式,支持多回合对话。

A chat between a curious user and an artificial intelligence assistant. The assistant gives helpful, detailed, and polite answers to the user's questions. USER: Hi ASSISTANT: Hello.</s>USER: Who are you? ASSISTANT: I am WizardLM.</s>......

- 1

开源资料

目前关于WizardLM2的资料还比较少,大家可持续关注GitHub和Huggingface平台。

github:https://github.com/microsoft/WizardLM2

huggingface:https://huggingface.co/microsoft

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/AllinToyou/article/detail/525143

推荐阅读

相关标签