- 1Leetcode 二叉树的前序遍历_二叉树前序遍历leetcode

- 2IntelliJ Plugin 开发之环境配置(一)_intellij platform plugin jdk 配置

- 3揭秘AI精准输出:如何构建完美的AIGC提示词?_aigc输出目标

- 4hbase 常用命令

- 5Java Spark读取Hbase数据,将结果写入HDFS文件_java spark读写hbase

- 6记录:remote: You are not allowed to push code to this project...【亲测有效】

- 7什么是真正的ChatGPT——ChatGPT的工作原理、优点和限制分析_chatgpt的算法优势

- 8Java中线程安全的集合类_java list线程安全集合

- 9Matlab绘制相关性矩阵热力图_matlab绘制线性相关热力图

- 10java 连接sqlserver_java连接sqlserver报错

基于 Flink CDC 构建 MySQL 到 Databend 的 实时数据同步_flink cdc 如何通过yaml执行任务

赞

踩

这篇教程将展示如何基于 Flink CDC 快速构建 MySQL 到 Databend 的实时数据同步。本教程的演示都将在 Flink SQL CLI 中进行,只涉及 SQL,无需一行 Java/Scala 代码,也无需安装 IDE。

假设我们有电子商务业务,商品的数据存储在 MySQL ,我们需要实时把它同步到 Databend 中。

接下来的内容将介绍如何使用 Flink Mysql/Databend CDC 来实现这个需求,系统的整体架构如下图所示:

准备阶段

准备一台已经安装了 Docker 和 docker-compose 的 Linux 或者 MacOS 。

准备教程所需要的组件

接下来的教程将以 docker-compose 的方式准备所需要的组件。

debezium-MySQL

docker-compose.yaml

- version: '2.1'

- services:

- postgres:

- image: debezium/example-postgres:1.1

- ports:

- - "5432:5432"

- environment:

- - POSTGRES_DB=postgres

- - POSTGRES_USER=postgres

- - POSTGRES_PASSWORD=postgres

- mysql:

- image: debezium/example-mysql:1.1

- ports:

- - "3306:3306"

- environment:

- - MYSQL_ROOT_PASSWORD=123456

- - MYSQL_USER=mysqluser

- - MYSQL_PASSWORD=mysqlpw

Databend

docker-compose.yaml

- version: '3'

- services:

- databend:

- image: datafuselabs/databend

- volumes:

- - /Users/hanshanjie/databend/local-test/databend/databend-query.toml:/etc/databend/query.toml

- environment:

- QUERY_DEFAULT_USER: databend

- QUERY_DEFAULT_PASSWORD: databend

- MINIO_ENABLED: 'true'

- ports:

- - '8000:8000'

- - '9000:9000'

- - '3307:3307'

- - '8124:8124'

在 docker-compose.yml 所在目录下执行下面的命令来启动本教程需要的组件:

ocker-compose up -d该命令将以 detached 模式自动启动 Docker Compose 配置中定义的所有容器。你可以通过 docker ps 来观察上述的容器是否正常启动。

下载 Flink 和所需要的依赖包

-

下载 Flink 1.16.0 并将其解压至目录

flink-1.16.0 -

下载下面列出的依赖包,并将它们放到目录

flink-1.16.0/lib/下: -

下载链接只对已发布的版本有效, SNAPSHOT 版本需要本地编译

编译 flink-connector-databend

- git clone https://github.com/databendcloud/flink-connector-databend

- cd flink-connector-databend

- mvn clean install -DskipTests

将 target/flink-connector-databend-1.16.0-SNAPSHOT.jar 拷贝到目录 flink-1.16.0/lib/ 下。

准备数据

在 MySQL 数据库中准备数据

进入 MySQL 容器

docker-compose exec mysql mysql -uroot -p123456创建数据库 mydb 和表 products,并插入数据:

- CREATE DATABASE mydb;

- USE mydb;

-

- CREATE TABLE products (id INTEGER NOT NULL AUTO_INCREMENT PRIMARY KEY,name VARCHAR(255) NOT NULL,description VARCHAR(512));

- ALTER TABLE products AUTO_INCREMENT = 10;

-

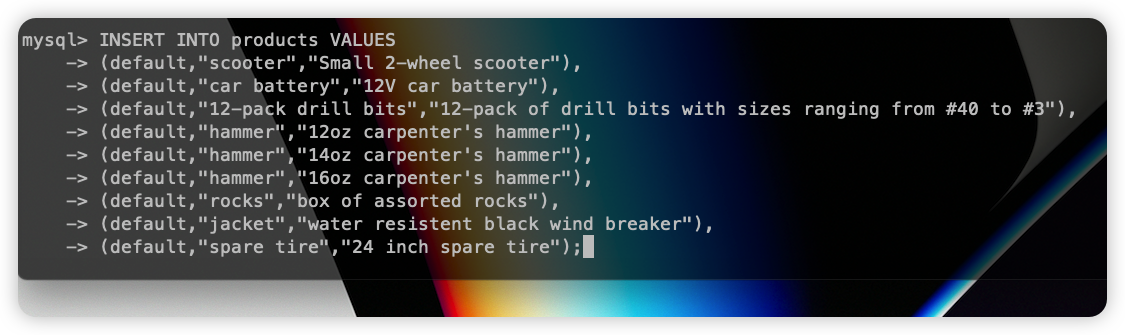

- INSERT INTO products VALUES (default,"scooter","Small 2-wheel scooter"),

- (default,"car battery","12V car battery"),

- (default,"12-pack drill bits","12-pack of drill bits with sizes ranging from #40 to #3"),

- (default,"hammer","12oz carpenter's hammer"),

- (default,"hammer","14oz carpenter's hammer"),

- (default,"hammer","16oz carpenter's hammer"),

- (default,"rocks","box of assorted rocks"),

- (default,"jacket","water resistent black wind breaker"),

- (default,"cloud","test for databend"),

- (default,"spare tire","24 inch spare tire");

Databend 中建表

CREATE TABLE bend_products (id INT NOT NULL, name VARCHAR(255) NOT NULL, description VARCHAR(512) );启动 Flink 集群和 Flink SQL CLI

使用下面的命令跳转至 Flink 目录下

cd flink-16.0使用下面的命令启动 Flink 集群

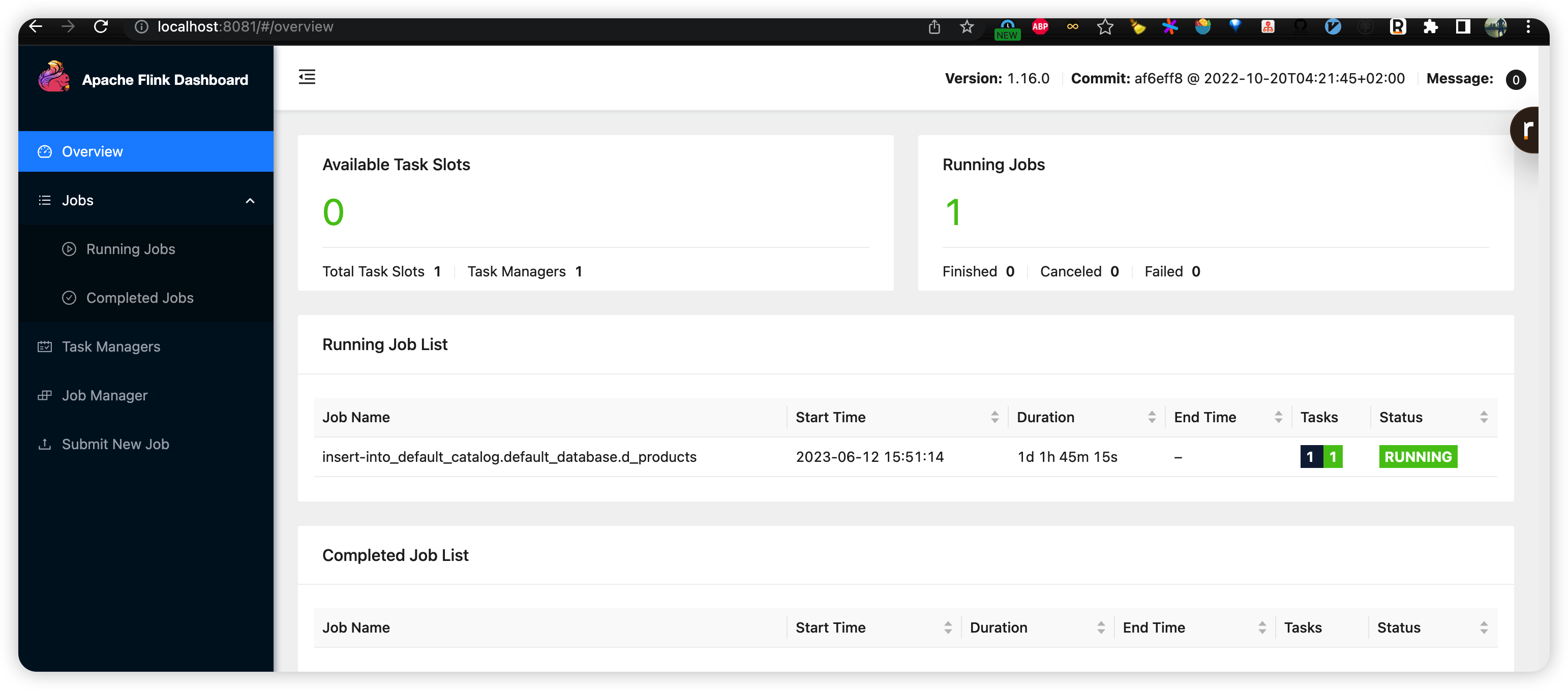

./bin/start-cluster.sh启动成功的话,可以在 http://localhost:8081/ 访问到 Flink Web UI,如下所示:

使用下面的命令启动 Flink SQL CLI

./bin/sql-client.sh

在 Flink SQL CLI 中使用 Flink DDL 创建表

首先,开启 checkpoint,每隔3秒做一次 checkpoint

- -- Flink SQL

- Flink SQL> SET execution.checkpointing.interval = 3s;

然后, 对于数据库中的表 products 使用 Flink SQL CLI 创建对应的表,用于同步底层数据库表的数据

- -- Flink SQL

- Flink SQL> CREATE TABLE products (id INT,name STRING,description STRING,PRIMARY KEY (id) NOT ENFORCED)

- WITH ('connector' = 'mysql-cdc',

- 'hostname' = 'localhost',

- 'port' = '3306',

- 'username' = 'root',

- 'password' = '123456',

- 'database-name' = 'mydb',

- 'table-name' = 'products',

- 'server-time-zone' = 'UTC'

- );

最后,创建 d_products 表, 用来订单数据写入 Databend 中

- -- Flink SQL

- create table d_products (id INT,name String,description String, PRIMARY KEY (`id`) NOT ENFORCED)

- with ('connector' = 'databend',

- 'url'='databend://localhost:8000',

- 'username'='databend',

- 'password'='databend',

- 'database-name'='default',

- 'table-name'='bend_products',

- 'sink.batch-size' = '5',

- 'sink.flush-interval' = '1000',

- 'sink.max-retries' = '3');

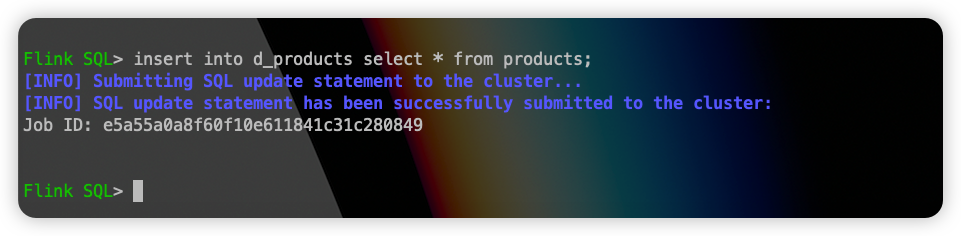

使用 Flink SQL 将 products 表中的数据同步到 Databend 的 d_products 表中:

insert into d_products select * from products;

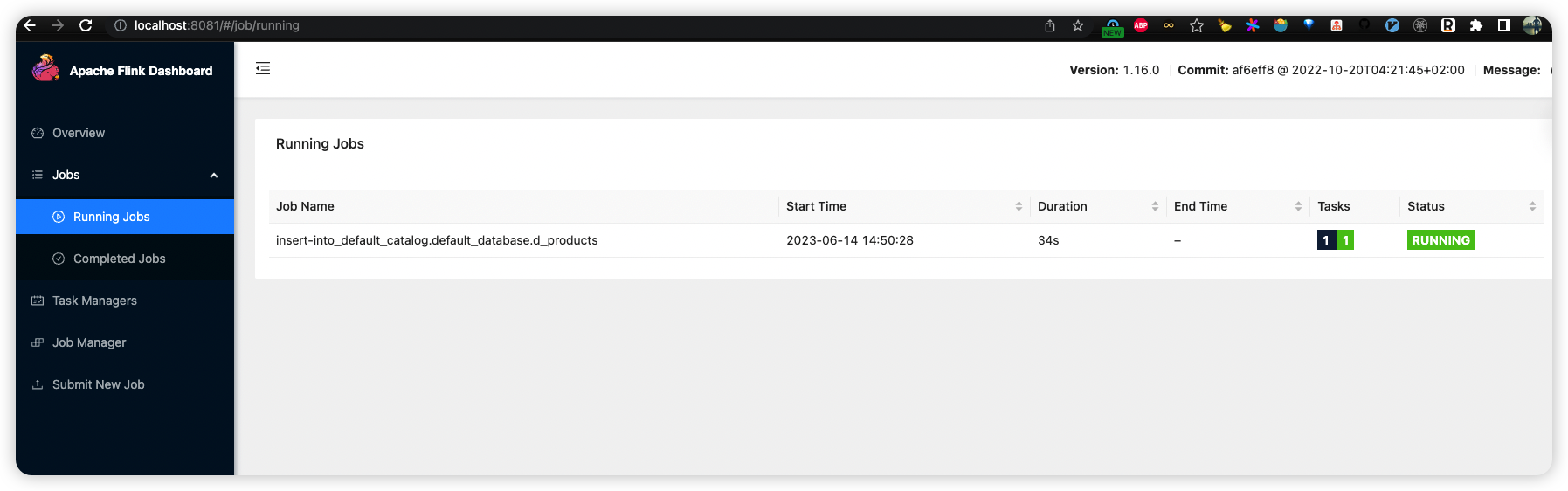

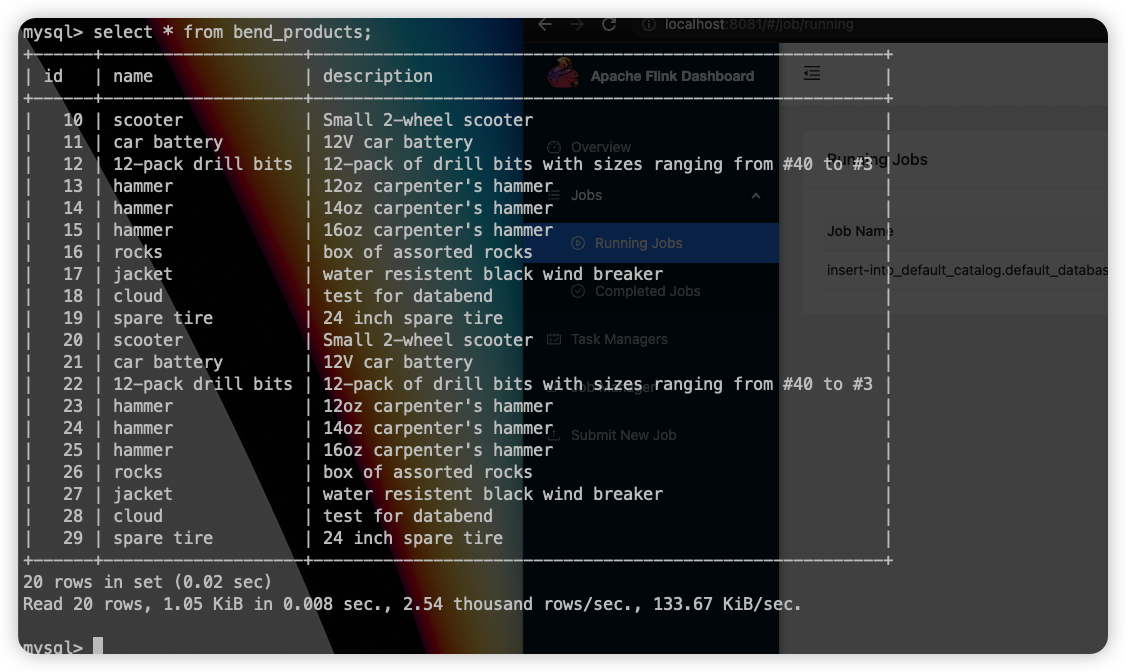

此时 flink job 就会提交成功,打开 flink UI 可以看到:

同时在 databend 中可以看到 MySQL 中的数据已经同步过来了:

同步 Insert/Update 数据

此时我们在 MySQL 中再插入 10 条数据:

- INSERT INTO products VALUES

- (default,"scooter","Small 2-wheel scooter"),

- (default,"car battery","12V car battery"),

- (default,"12-pack drill bits","12-pack of drill bits with sizes ranging from #40 to #3"),

- (default,"hammer","12oz carpenter's hammer"),

- (default,"hammer","14oz carpenter's hammer"),

- (default,"hammer","16oz carpenter's hammer"),

- (default,"rocks","box of assorted rocks"),

- (default,"jacket","water resistent black wind breaker"),

- (default,"cloud","test for databend"),

- (default,"spare tire","24 inch spare tire");

这些数据会立即同步到 Databend 当中。

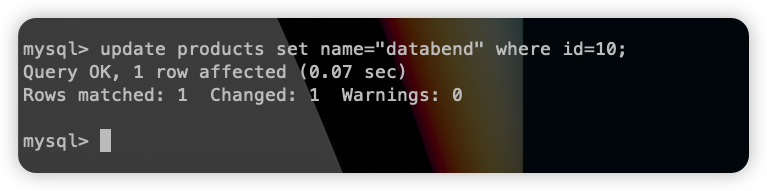

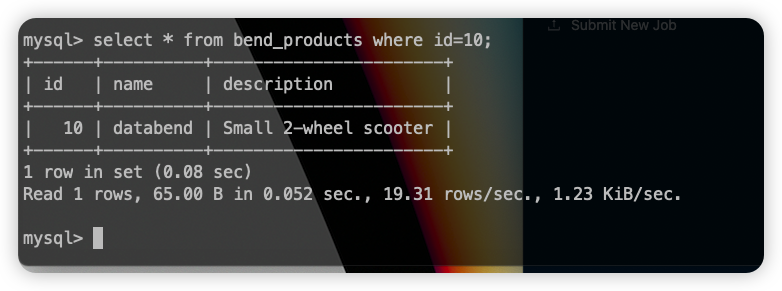

假如此时 MySQL 中更新了一条数据:

那么 id=10 的数据在 databend 中也会被立即更新:

环境清理

操作结束后,在 docker-compose.yml 文件所在的目录下执行如下命令停止所有容器:

docker-compose down在 Flink 所在目录 flink-1.16.0 下执行如下命令停止 Flink 集群:

./bin/stop-cluster.sh结论

以上就是基于 Flink CDC 构建 MySQL 到 Databend 的 实时数据同步的全部过程,通过 Flink CDC connectors 可以替换 Debezium+Kafka 的数据采集模块,实现 Flink SQL 采集+计算+传输一体化,减少维护的组件,简化实时链路,减轻部署成本的同时也能达到 Exactly Once 的语义效果。