热门标签

热门文章

- 1android 11 修改加了开机铃声 开机动画不能播放完_android 强制开机动画播完

- 2零基础学C++之高级篇四_ios::out

- 3荣耀可以升级鸿蒙系统的机型,华为公布鸿蒙升级计划:覆盖上百机型,五年前的老机也能升级...

- 4maven 打包时复制依赖的jar到指定的文件_maven打包时复制依赖的jar包到指定文件

- 5idea打开Android项目gradle版本遇到的问题_idea gradle android启动

- 6numpy创建三维数组

- 7javaweb课程设计之商品后台管理系统_商品目录管理web课程设计

- 8Neural Architecture Search for Deep Image Prior

- 9Zookeeper(五)Zokeeper 环境搭建与Curator使用

- 10Navicat Premium for Mac破解版操作流程_mac 版本navicat premium 15激活

当前位置: article > 正文

KenLM使用教程_kenlm.pyx", line 139, in kenlm.model.__init__

作者:Cpp五条 | 2024-04-04 02:40:13

赞

踩

kenlm.pyx", line 139, in kenlm.model.__init__

1. 安装

git clone https://github.com/kpu/kenlm.git

cd kenlm/

mkdir -p build

cd build

cmake ..

make -j 32

- 1

- 2

- 3

- 4

- 5

- 6

安装过程中可能会出现没有libboost库,engin3,执行命令:

sudo yum install boost-devel

sudo yum install eigen3

- 1

- 2

其他linux发行版,自行查找对应的安装方式。

测试安装是否成功,build/bin/lmplz,有显示则安装成功。 将bin目录加入PATH,这样在任意目录下都可以使用bin下面的命令。

2. 训练

基本用法:

lmplz -o N --verbose_header --text your_corpus --arpa model.arpa

- 1

将.arpa转成.bin效果是一样的,但是速度会更快。

build_binary -s test.arpa test.bin

- 1

参数解释:

(1) --vocab_estimate

为了在corpus count计算预分配内存,默认词表大小为1000000,可以根据实际的词表大小进行设置(稍大词表大小)

(2) --verbose_header

生成的arpa文件头部显示一些信息,如各个文法元组的个数

(3) --text

需要训练的文本,事先得预处理好,去标点,正则化等等,训练词级别的N-gram需要进行分词,字级别的N-gram,只要把各个字符用空格空开就可

(4) --arpa

生成的arpa文件的名称

(5) --prune

剪枝操作,使用方法如: --prune 1 1 3 4,首先这四个位置的数字表示对应元组词频的阈值,即小于这个词频的元组会被剪枝掉,如 4 表示4-gram中元组出现次数小于4的需要被剪枝。另外需要注意,这一串数字需要满足 非递减 。

(6) --limit_vocab_file

指定词表文件,不在词表的字都会被剪枝掉。词表的形式是,用空格隔开每个单元,如 我 你 他

(7) --discount_fallback

平滑操作

(8) --interpolate_unigrams

为了模拟srilm的实现,这个几乎用不上

3. Python接口

安装

pip install kenlm

- 1

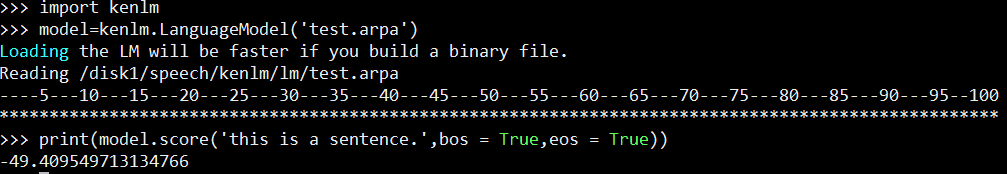

以 kenlm/lm/test.arpa为例:

import kenlm

model=kenlm.LanguageModel('test.arpa') # model=kenlm.LanguageModel('test.bin')一样的

print(model.score('this is a sentence.',bos = True,eos = True))

- 1

- 2

- 3

结果如下:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Cpp五条/article/detail/357119

推荐阅读

相关标签