目的:增加网站的阅读量

结果呈现:看网站上面的数字显示

【注:关于网站的收藏、点赞以及评论,需要用户登录,我没那么多账号进行测试....而且阅读量是不需要账号登录的,简单又方便~】

注:昨天下午,我刚在开源中国上发了博客,师弟就说:我给你增加点人气吧。然后师弟就点击进我的主页看我刚发的博客了。(我的内心OS:切,知道你是想膜拜大佬!~)。我和师弟说:等到我明年找工作,我就先去淘宝买点粉丝关注下我这个账号,再买点浏览量,这样我的账号看起来不那么可怜。师弟说淘宝有卖的,买粉丝估计贵一点,但是浏览量应该便宜的。

但是,熟悉我的人都知道,我是一个很抠的人啊!!!!!

所以,我就打算自己码代码,给自己的网站制造浏览量!!!!!毕竟穷人有穷人活法(╥╯^╰╥)

唠嗑完毕,开始工作

本人开源中国的网址:https://my.oschina.net/pansy0425

#下面为本实例的爬虫代码,若有问题可以给我留言,或者有更好的解决方法也可以私信我~

from multiprocessing.pool import Pool

from selenium import webdriver

import time

def view(i):

route='//*[@id="newestBlogList"]/div[1]/div[{}]/div/a'.format(i)

driver=webdriver.Chrome('D:\chromedriver.exe')

driver.get('https://my.oschina.net/pansy0425')

time.sleep(3)

for i in range(200):

try:

driver.find_element_by_xpath(route).click()

time.sleep(3)

except:

continue

if __name__ == '__main__':

pool=Pool()

pool.map(view,[i for i in range(1,12)])

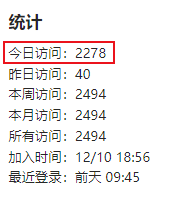

之前的访问量截图:

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

之前的访问量截图:---->PS:我是使用多线程,迭代了200次------->差不多每个都多了200的访问量(实在不好意思循环太多次,毕竟......)

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

yeah! 今日访问量破2000了呢!!(づ ̄3 ̄)づ╭❤~

今日访问量破2000了呢!!(づ ̄3 ̄)づ╭❤~

思考:

(1)因为该代码相当于不断打开Chrome浏览器,然后进行访问,重点是我还开了多线程,重点是我的电脑还在跑我CNN(卷积神经网络的模型)【深度学习的一种】,重点的重点是我的电脑是CPU,然后就很卡.......

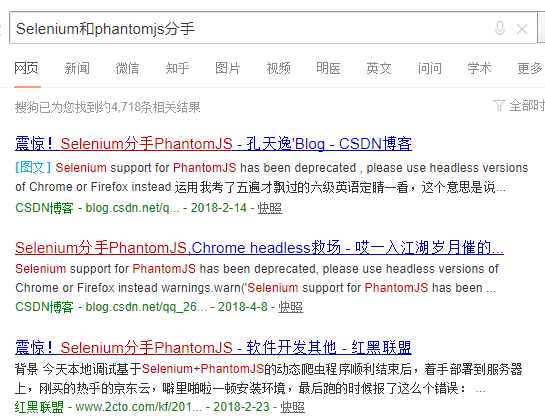

(2)有个问题:就是我采用Selenium+Chrome(显式浏览),使得我的浏览器一直在不同的打开,很影响我别的工作,于是我想采用Selenium+PhantomJS(隐式浏览器).....但是但是但是!!!!他们分手了!!!!!!!!!!

今日爬虫完成!【不知道算不算爬虫,但是就是很简单的例子啦~~~】

PS:【上有政策,下有对策】----->聪明机智的我~

之前我们学院有个在线学习的任务,在线学习打卡,且这个网站很坑,必须要每隔5分钟点击一下屏幕,显示你在学习,不然的话它的时间就卡在5分钟,就不往下计时了,然后我就利用自己的小知识,采用Selenium+Chrome写了一个简单的“打卡学习”的小代码,和今天的这个大同小异~

这个我就直接贴代码啦~

from selenium import webdriver

import time

class DKY:

def __init__(self):

self.xuehao = "***********" #学号

self.mima="*******" #密码

self.chrome = "D:\chromedriver.exe"

def login(self):

driver = webdriver.Chrome(executable_path=self.chrome)

driver.get("http://examsafety.nuist.edu.cn/")

time.sleep(5)

xh= driver.find_element_by_xpath('//*[@id="xuehao"]')

xh.send_keys(self.xuehao)

time.sleep(1)

mm= driver.find_element_by_xpath('//*[@id="article"]/div[2]/div[1]/div[2]/div[1]/form/input[2]')

mm.send_keys(self.mima)

time.sleep(1)

driver.find_element_by_xpath('//*[@id="article"]/div[2]/div[1]/div[2]/div[1]/form/div/input').click()

time.sleep(1)

driver.find_element_by_xpath('//*[@id="article"]/div[3]/div[2]/div/div[1]/ul/a[1]/li').click()

time.sleep(1)

driver.find_element_by_xpath('//*[@id="article"]/div[3]/div[2]/ul/li[1]/a[2]/h2').click()

time.sleep(1)

for i in range(100):

try:

driver.find_element_by_xpath('//*[@id="article"]/div[3]/div[2]/div[2]/a/font').click()

time.sleep(295)

except:

self.login()

dky=DKY()

dky.login()

然后,我这串小代码帮助机房的同学们,顺利的“完成”了“打卡学习”~٩(๑❛ᴗ❛๑)۶٩(๑❛ᴗ❛๑)۶٩(๑❛ᴗ❛๑)۶

PS:对于Selenium和Chrome的联合使用的小注意点:

(1)需要下载驱动chromedriver.exe,注意版本一致,Chrome的版本与chromedriver.exe的版本要一致。

Chrome的版本查看:在Google的设置中,找到“关于Google Chrome”就能查看你电脑上的Google Chrome的版本;

chromedriver.exe的下载网址:http://chromedriver.chromium.org/downloads

(2)有的时候的chromedriver.exe的路径也会有影响,若是怕出错,直接把chromedriver.exe放在python安装目录下的Scripts文件夹下。

若用的是Anaconda自带的python,所以就直接放在Anaconda下的Scripts文件夹下。

今日鸡汤:你想是怎样的人,你就是怎样的人;你想成为怎样的人,你就会离这个目标不会太远。

加油ヾ(◍°∇°◍)ノ゙