- 1stm32与51 Proteus仿真初体验之点灯大师

- 2xcode在应用市场不能直接更新时,可以用以下方法:_xcode15更新网站

- 3Python 将Influxdb时序数据写入mysql库时遇到的问题

- 4计算机应届生有没有必要参加IT培训?_应届生计算机培训有没有必要

- 5保姆级 -- Zookeeper超详解

- 6对泛型的认识_symbol: variable roundingmode where t is a type-va

- 7微星迫击炮b660m使用intel arc a750/770显卡功耗优化方法_native pcie enable

- 8Github 2024-02-08 开源项目日报 Top9_我的电视 github

- 9小程序backgroundAudioManager.pause()无法停止播放的原因_taro.stopbackgroundaudio不生效

- 10java+idea+mysql采用医疗AI自然语言处理技术的3D智能导诊导系统源码

共指消解(一)

赞

踩

摘要重点

- 共指消解旨在识别指向同一实体的不同表述

- 共指消解是一个NP-Hard的问题

- 共指消解的发展经历了基于规则、基于机器学习、基于全局最优化、基于知识库和基于深度学习的模型阶段

引言

共指消解(coreference resolution)技术同NER、RE。作为自然语言历届基础技术被广泛的应用于:文本摘要、机器翻译、自动问答和知识图谱等领域。

共指消解的提出是为了识别一段文本中指向同一实体的不同表述。

整个共指消解的过程可以理解为——判断一个表述是否指向另一个表述的过程。

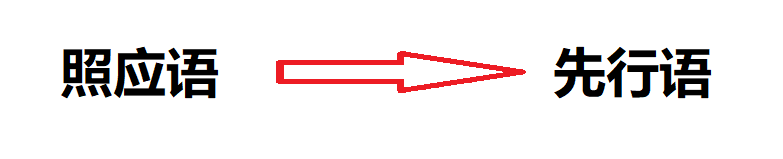

照应语(Anaphor):指出的表述。

先行语(Antecedent):指入的表述。

简化的判断可如下:

照应语指向先行语

根据照应语和先行语的位置不同可分为四种情况:

- 回指:先行语在照应语前,其中照应语为人称代词。

- 预指:先行语在照应语后,其中照应语为人称代词。

- 名词短语共指:先行语和照应语均为非人称代词的名词短语。

- 先行语分指:一个照应语对应多个先行语。

共指消解的难点在于:

- 共指消解是一个NP-Hard 的问题,在多项式时间内无法求得最优解。

- 自然语言的场景和句式多变,同一句话在不同语境下可表示不同的含义,不同的句子可能标识同样的含义。

- 语料质量较低,并且缺乏数据集。

基本概念

共指消解中的共指关系是一种等价关系。有如下性质:

- 自反性

- 对称性

- 传递性

实体解析(Entity Resolution)与共指消解的定义基本相同,实体匹配(Entity Matching)和实体对齐(Entity Alignment)主要侧重于不同的数据源之间是否指向同一实体。

共指消解可以作为实体链接的一部分:

step1:命名实体识别

step2:共指消解

step3:实体消歧

回指消解:考虑同一篇章红的照应语与上文中的先行语之间的语义关联性,不一定是等价关系。

共指消解的研究现状

基于规则的方法

Hobbs算法

Hobbs算法是在1978年提出的最早的共指消解算法之一。

Hobbs有两个不同的版本:

- 完全基于句法知识的——朴素Hobbs算法。

- 加入语义知识的——Hobbs算法的改进版。

Converse首次将Hobbs算法运用在中文共指消解中,并语句语法加入了额外的约束信息。

中心理论

中心理论的大致思路是跟踪文本中实体的焦点变化。

中心理论作为一种理论模型,实例化后的算法也是基于规则的,所以其缺乏泛化能力。此外其职能判断两个相邻表述是否共指,所以预测能力也较差。

基于机器学习的方法

监督学习

- 表述对模型(Mention-pair Model)

该模型将共指消解问题看作表述对的二分类模型。根据距离特征和上下文特征判定表述对是否共指。存在两个缺陷:(1) 只关注先行语和照应语之间的关系,忽略了先行语两两之间的相互关系。(2) 当特征不足以判断是否共指时,可能存在代词语义过空、表述性别难以分辨的问题。 - 表述排序模型(Mention-ranking Model)

该模型将共指消解问题看作是排序学习问题。模型考虑了多个先行语之间的排序关系,因此弥补了表述对模型的缺陷(1) - 实体表述模型(Entity-mention Model)

该模型将共指消解问题看作实体与表述的二元分类问题。其中实体为共指的先行语集合。一个实体包含多个共指先行语,其上下文的信息可以互补,所以弥补了表述对模型的缺陷(2) - 实体排序模型(Entity-ranking Model/Cluster-ranking Model)

该模型结合了表述排序模型和实体表述模型的优点。

无监督学习

相比于海量的无标注文本,由于人工成本的昂贵,所以标注数据往往规模较少。

所以有的学者利用无监督学习进行共指消解,比如聚类,EM算法,LDA算法。

半监督学习

介于监督学习和无监督学习之间的方法,既能利用带标注数据保证模型的精度,又可以通过无标注数据提升模型的泛化能力。

基于全局最优化的方法

基于机器学习的方法还有如下不足:

- 训练数据的特征往往是局部的,没有考虑全局的依赖关系和语义特征。

- 可能违背共指等价关系的传递性,“A与B共指,ByuC共指,则出现A与C不共指”

为了缓解这个问题,全局最优化方法被提出。

基于知识库的方法

人类的先验知识有利于共指消解的任务,而先验知识的获取较为困难,所以出现了利用知识库中的知识,提取额外的特征发现表述之间的隐含关系,从而提高模型的性能。

基于深度学习的方法

深度学习利用了word embedding、LSTM和Attention等方面的内容。进一步实现了end to end的模型,并且提升了整体的性能和泛化能力。

总结与展望

总结:

- 模型缺乏语义推理能力

- 缺乏共指消解的语料库

- 模型效果过于依赖前置模型的性能

展望:

- 采用知识图谱抽取开放特征

- 更为充分的利用无标注数据

- 利用好强化学习

- 更完备的end to end 模型