热门标签

热门文章

- 1Unity3D 游戏中的自动寻路有怎样的算法详解_unity 寻路算法

- 2AI辅写疑似度多少不通过?了解这7点让你避免被拒绝_疑似ai占比

- 3使用Docker部署PDF多功能工具Stirling-PDF_stirling pdf 离线 部署

- 4Hive 中的各种常用set设置_hive set engine

- 5Spring-Boot-操作-Redis,三种方案全解析!

- 6Transformer代码逐步解读(pytorch版本)Encoder部分_class encoderlayer(nn.module): def __init__(self,

- 7KAFKA 与RocketMQ对比_khtcrmq

- 8一台linux服务器做docker集群,使用docker快速搭建Spark集群的方法教程

- 9hive和hadoop版本对应关系_hadoop和hive版本

- 10Python 基础教程【2】:条件语句和循环语句_python 条件语句 写法

当前位置: article > 正文

【wails】(10):研究go-llama.cpp项目,但是发现不支持最新的qwen大模型,可以运行llama-2-7b-chat_llama-2-7b-chat.q3_k_s.gguf

作者:Cpp五条 | 2024-05-01 21:15:38

赞

踩

llama-2-7b-chat.q3_k_s.gguf

1,视频演示地址

2,项目地址go-llama.cpp

下载并进行编译:

git clone --recurse-submodules https://github.com/go-skynet/go-llama.cpp

cd go-llama.cpp

make libbinding.a

- 1

- 2

- 3

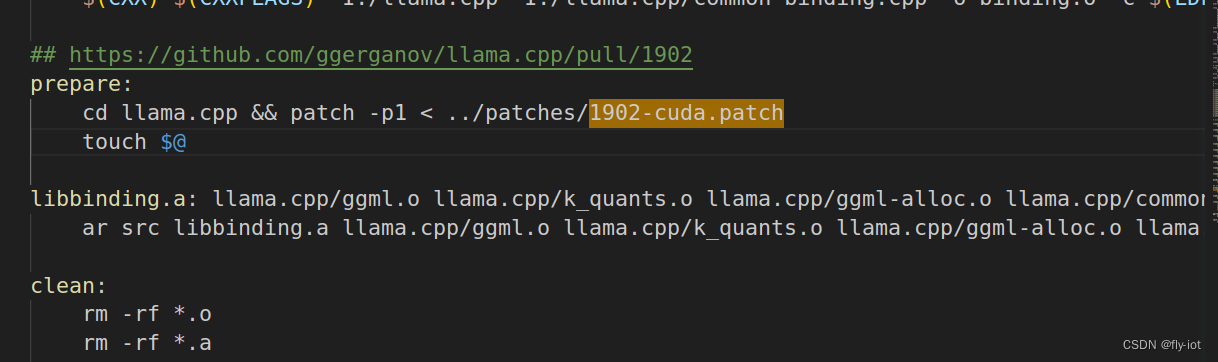

项目中还打了个补丁:

给

编译成功,虽然有一点 warning 警告信息,问题不大。

3,然后运行 llama-2-7b-chat 模型

LIBRARY_PATH=$PWD C_INCLUDE_PATH=$PWD go run ./examples -m "/data/home/test/hf_cache/llama-2-7b-chat.Q2_K.gguf" -t 14

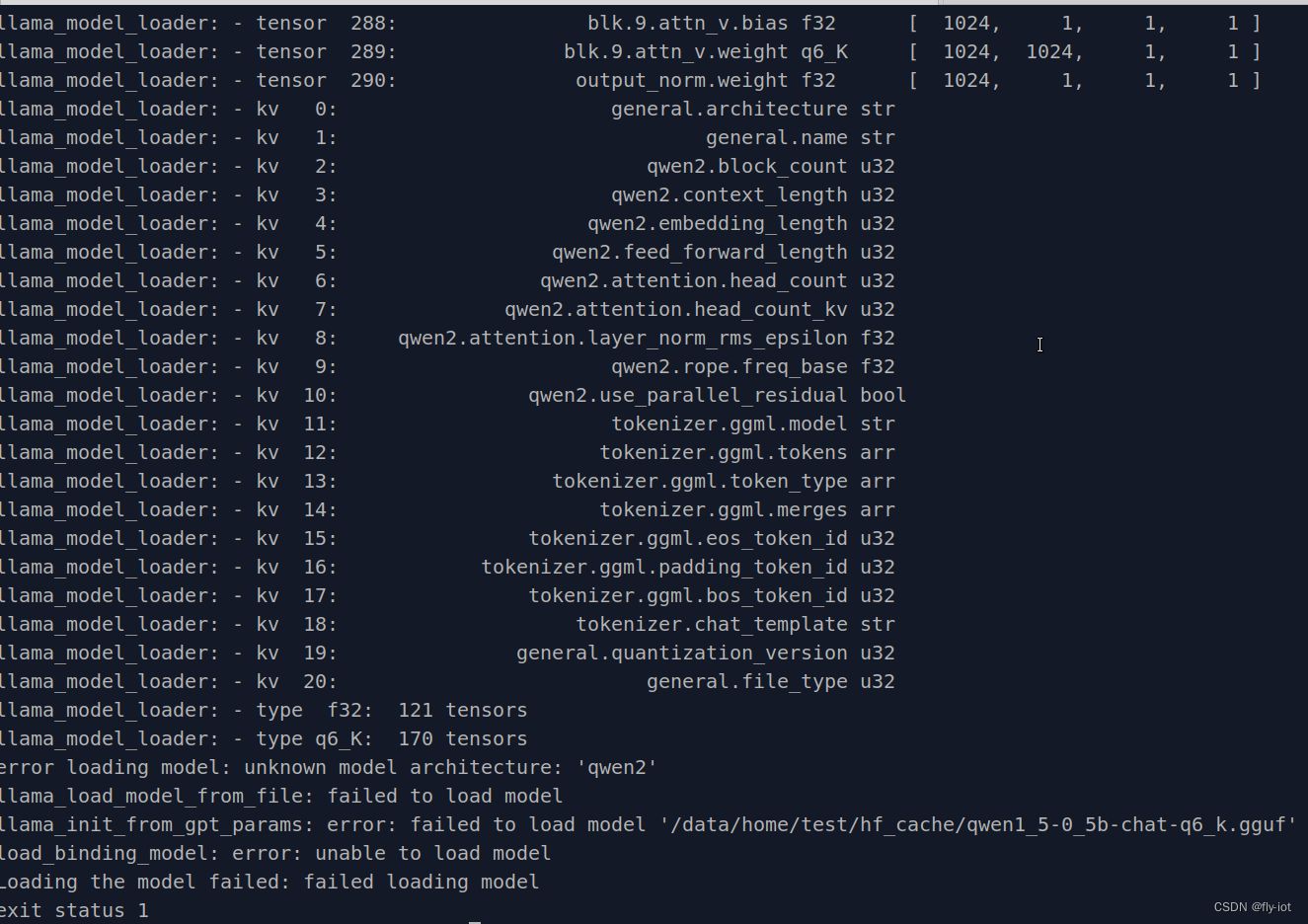

LIBRARY_PATH=$PWD C_INCLUDE_PATH=$PWD go run ./examples -m "/data/home/test/hf_cache/qwen1_5-0_5b-chat-q6_k.gguf" -t 14

- 1

- 2

- 3

- 4

- 5

error loading model: unknown model architecture: 'qwen2'

llama_load_model_from_file: failed to load model

llama_init_from_gpt_params: error: failed to load model '/data/home/test/hf_cache/qwen1_5-0_5b-chat-q6_k.gguf'

load_binding_model: error: unable to load model

Loading the model failed: failed loading model

- 1

- 2

- 3

- 4

- 5

- 6

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Cpp五条/article/detail/520755

推荐阅读

相关标签