- 1新魔百和M301H_关于CW代工_JL(南传)代工_zn及sm代工区分及鸿蒙架构全网通卡刷包刷机教程_m301h刷机

- 2ajax请求报parsererror错误_ajax parsererror是什么错误

- 3云端技术驾驭DAY15——ClusterIP服务、Ingress服务、Dashboard插件、k8s角色的认证与授权

- 4kubeCon2020重磅演讲:基于k8s构建新一代私有云和容器云_captain k8s

- 5HTML+CSS:3D轮播卡片

- 6Python+医学院校二手书管理 毕业设计-附源码201704_基于python的校园二手交易平台论文开题报告

- 7python函数递归求和详解_Python函数中多类型传值和冗余参数及函数的递归调用

- 8【毕业设计】ASP.NET 网上选课系统的设计与实现(源代码+论文)_aspnet毕业设计含代码

- 9Stable Diffusion提示词总结_stable diffusion 提示词详解

- 10玩转k8s:Pod详解_k8s pod配置文件查看

深度学习神经网络学习笔记-自然语言处理方向-论文研读-情感分析/文本分类-char_embedding_深度学习 语义 语表 语法

赞

踩

概念引入

逻辑回归

线性回归

时间序列分析

神经网络

self-attention与softmax的推导

word2evc

由来

词向量的学习在自然语言处理的应用中非常重要,词向量可以在空间上捕获词之间的语法和语义相似性。但是词向量机制中是假设词和词之间是独立的,这种独立性假设是有问题的,形式的一致性会导致功能的一致性。但这种形态和功能之间的关系有不是绝对的,为了学习这种关系,本文在字符嵌入上使用双向LSTM来捕捉这种关系。 本文的C2W模型能够很好地捕捉词之间的语法和语义相似度,并且在两个任务上取得最优的结果。

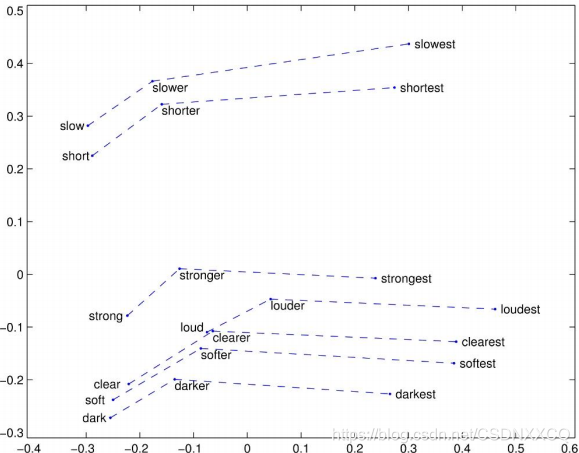

按照当时的方式像单词中的比较级与最高级这些,用词向量是推不出来的,比如slow的词向量没法推出slower

同时为了避免OOV(out of voacb)问题,我们只好使用更大的数据集训练,去构成一个更大的词表(每个词对应一个词向量),这无疑会增加计算负担

摘要大意

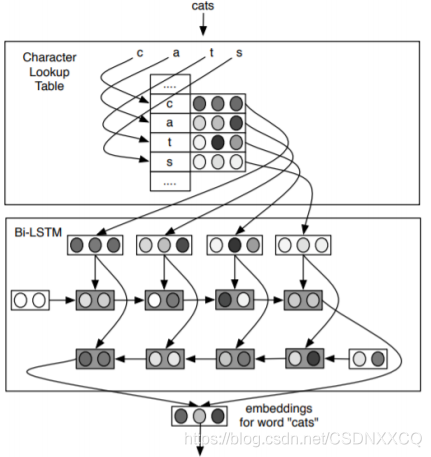

提出了一种新的使用字符和双向LSTM生成词表示的模型。相对于传统的词向量方法,我们的C2W模型需要的参数比较少,主要有两部分,一部分是字符映射成向量的参数,一部分是组合模块LSTM的参数。尽管模型参数少,且单词中的形式-功能关系很难学习,模型在语言模型和词性标注任务上取得最优的结果。这种优势在形态丰富的语言中更加明显。

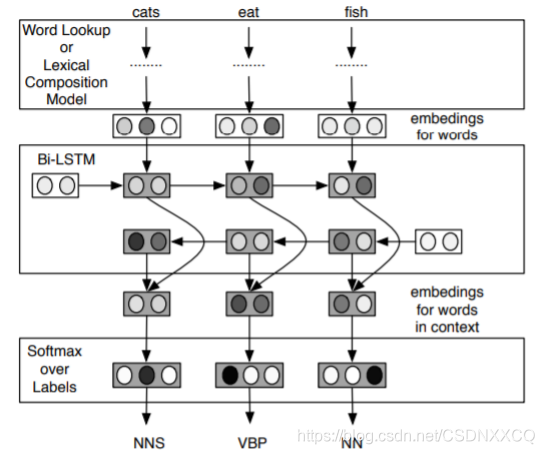

C2W模型

在本模型中,字符的向量是独立的,词向量不是独立的,而词由字符组成,故如果词之间有类似的字符结构,它们的表意就是相近的,从而解决了形式的一致性会导致功能的一致性的问题。

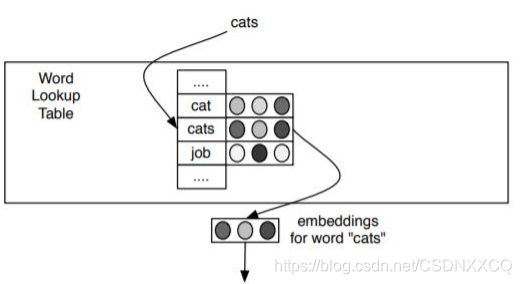

词嵌入模型

对于一个词嵌入来说,直接找它在词表中的位置就能得到一个对应的词向量

字符嵌入模型

对于一个字符嵌入来说,它要在词表中的位置找到对应的信息,然后再通过双向LSTM找到对应的词向量

劣势:

• 训练时还需要通过LSTM生成词表示,速度比词

向量机制慢

• 测试时虽然可以通过缓存的方法预先生成一些

词向量,但是对于OOV词的词表示的生成依旧速

度慢

优势:

• 能够解决OOV(out of voacb)词问题

• 能捕获字符间的结构信息

• 能推理出相似结果的词表示

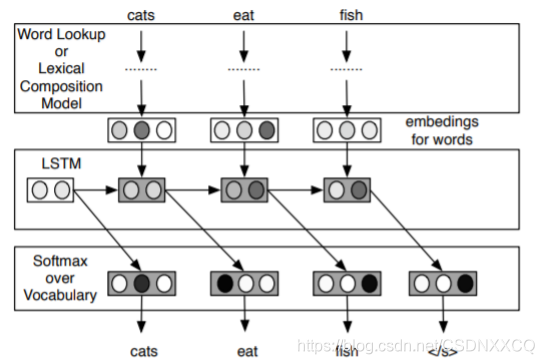

语言模型的训练流程

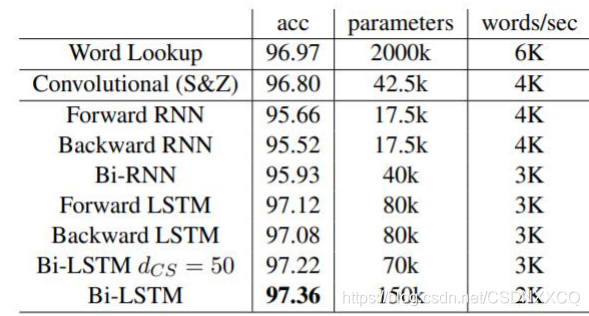

词性标注模型

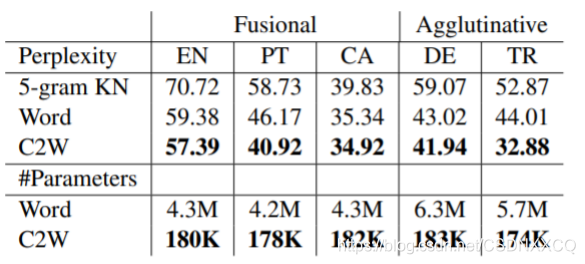

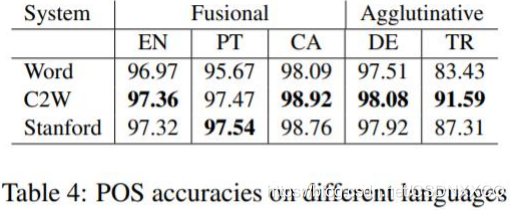

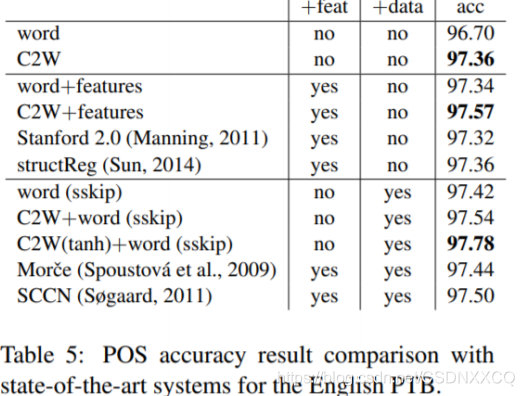

研究成果

在英语、葡萄牙语、加泰罗尼亚语、德语

和土耳其语五种语言的语言模型上均取得

最优的实验结果。

在英语的词性标注任务上取得最优的结果。

不同语言上的词性标注模型的训练结果

与词向量方法组合的词性标注实验

提供了一种新的训练词表示的方法,且首次学习词内部的形式。