- 1chrome插件开发流程(超全)_谷歌扩展mv3读取json文件内容

- 2想要做好自动化测试,离不开这5点!

- 3Linux 环境安装Nginx—源码和Dokcer

- 4专升本C语言_查找n在数组a中最后一次出现的位置(数组首元素的位置为零)。 输入5个整数,将它们

- 5详细解读Ian Goodfellow ICCV2017演讲PPT《解读GAN的原理与应用》_gan模型简单介绍ppt

- 6我看鸿蒙操作系统

- 7安防监控用品经营商城小程序搭建

- 8小米5G手机无法使用SA网络,用户只能买新的?_5g网络类型无法获取 小米

- 9计算机网络:传输控制协议(Transmission Control Protocol-TCP协议

- 10Vue(一)_使用vue制作一个可以添加项目的无序列表

NLP实战:快递单信息抽取-基于ERNIE1.0 预训练模型_ernie 实体识别

赞

踩

目录

一、介绍

命名实体识别(Named Entity Recognition,简称NER)是自然语言处理(NLP)中的一项任务,目的是识别文本中的命名实体并将其分类为预定义的类别,如人名、地名、组织机构等。命名实体通常指具有独特标识的实体,这些实体在文本中出现时通常会带有特殊的上下文信息。

命名实体识别在很多自然语言处理任务中都是非常重要的预处理步骤,如信息提取、机器翻译、问题回答等。通过对文本中的命名实体进行识别和分类,可以更好地理解文本的含义和结构,为后续的处理任务提供更多的语义信息。

常用的命名实体分类包括人名、地名、组织机构名、日期、时间、货币等,分类的具体数量和类别可以根据不同的应用场景进行调整。

本项目将演示如何使用PaddleNLP语义预训练模型ERNIE完成从快递单中抽取姓名、电话、省、市、区、详细地址等内容,形成结构化信息。辅助物流行业从业者进行有效信息的提取,从而降低客户填单的成本。

2017年之前,对文本处理主要依赖于序列模型Recurrent Neural Network (RNN).

基于BiGRU+CRF的快递单信息抽取项目介绍了如何使用序列模型完成快递单信息抽取任务。

随着深度学习的发展,模型参数数量迅速增加。为了训练这些参数,需要更大的数据集,但对于大部分NLP任务,构建大规模标注数据集很难且成本高。相反,大规模未标注语料库的构建相对容易。因此,我们可以利用这些数据先学习到好的表示,再将其用于其他任务中。最近的研究表明,基于大规模未标注语料库的预训练模型(Pretrained Models, PTM)在NLP任务中表现出色。现在,随着计算能力和训练技巧的提高,PTM也得以不断发展和进步。

本示例展示了以ERNIE(Enhanced Representation through Knowledge Integration)为代表的预训练模型如何Finetune完成序列标注任务。

二、代码

在百度飞桨平台的CodeLab跑就行,类似于Google的colab平台。

2.1前期准备

安装环境

pip install --upgrade paddlenlp

- # 下载并解压数据集

- from paddle.utils.download import get_path_from_url

- URL = "https://paddlenlp.bj.bcebos.com/paddlenlp/datasets/waybill.tar.gz"

- get_path_from_url(URL, "./")

-

- # 查看预测的数据

- !head -n 5 data/test.txt

- from functools import partial

-

- import paddle

- from paddlenlp.datasets import MapDataset

- from paddlenlp.data import Stack, Tuple, Pad

- from paddlenlp.transformers import ErnieTokenizer, ErnieForTokenClassification

- from paddlenlp.metrics import ChunkEvaluator

- from utils import convert_example, evaluate, predict, load_dict

2.2加载自定义数据集

推荐使用MapDataset()自定义数据集。

- def load_dataset(datafiles):

- def read(data_path):

- with open(data_path, 'r', encoding='utf-8') as fp:

- next(fp) # Skip header

- for line in fp.readlines():

- words, labels = line.strip('\n').split('\t')

- words = words.split('\002')

- labels = labels.split('\002')

- yield words, labels

-

- if isinstance(datafiles, str):

- return MapDataset(list(read(datafiles)))

- elif isinstance(datafiles, list) or isinstance(datafiles, tuple):

- return [MapDataset(list(read(datafile))) for datafile in datafiles]

-

- # Create dataset, tokenizer and dataloader.

- train_ds, dev_ds, test_ds = load_dataset(datafiles=(

- './data/train.txt', './data/dev.txt', './data/test.txt'))

- for i in range(5):

- print(train_ds[i])

每条数据包含一句文本和这个文本中每个汉字以及数字对应的label标签。

之后,还需要对输入句子进行数据处理,如切词,映射词表id等。

2.3数据处理

预训练模型ERNIE对中文数据的处理是以字为单位。PaddleNLP对于各种预训练模型已经内置了相应的tokenizer。指定想要使用的模型名字即可加载对应的tokenizer。

tokenizer作用为将原始输入文本转化成模型model可以接受的输入数据形式。

- label_vocab = load_dict('./data/tag.dic')

- tokenizer = ErnieTokenizer.from_pretrained('ernie-1.0')

-

- trans_func = partial(convert_example, tokenizer=tokenizer, label_vocab=label_vocab)

-

- train_ds.map(trans_func)

- dev_ds.map(trans_func)

- test_ds.map(trans_func)

- print (train_ds[0])

2.4数据读入

使用paddle.io.DataLoader接口多线程异步加载数据。

- ignore_label = -1

- batchify_fn = lambda samples, fn=Tuple(

- Pad(axis=0, pad_val=tokenizer.pad_token_id), # input_ids

- Pad(axis=0, pad_val=tokenizer.pad_token_type_id), # token_type_ids

- Stack(), # seq_len

- Pad(axis=0, pad_val=ignore_label) # labels

- ): fn(samples)

-

- train_loader = paddle.io.DataLoader(

- dataset=train_ds,

- batch_size=36,

- return_list=True,

- collate_fn=batchify_fn)

- dev_loader = paddle.io.DataLoader(

- dataset=dev_ds,

- batch_size=36,

- return_list=True,

- collate_fn=batchify_fn)

- test_loader = paddle.io.DataLoader(

- dataset=test_ds,

- batch_size=36,

- return_list=True,

- collate_fn=batchify_fn)

2.5PaddleNLP一键加载预训练模型

快递单信息抽取本质是一个序列标注任务,PaddleNLP对于各种预训练模型已经内置了对于下游任务文本分类Fine-tune网络。以下教程以ERNIE为预训练模型完成序列标注任务。

paddlenlp.transformers.ErnieForTokenClassification()一行代码即可加载预训练模型ERNIE用于序列标注任务的fine-tune网络。其在ERNIE模型后拼接上一个全连接网络进行分类。

paddlenlp.transformers.ErnieForTokenClassification.from_pretrained()方法只需指定想要使用的模型名称和文本分类的类别数即可完成定义模型网络。

- # Define the model netword and its loss

- model = ErnieForTokenClassification.from_pretrained("ernie-1.0", num_classes=len(label_vocab))

PaddleNLP不仅支持ERNIE预训练模型,还支持BERT、RoBERTa、Electra等预训练模型。 下表汇总了目前PaddleNLP支持的各类预训练模型。您可以使用PaddleNLP提供的模型,完成文本分类、序列标注、问答等任务。同时我们提供了众多预训练模型的参数权重供用户使用,其中包含了二十多种中文语言模型的预训练权重。中文的预训练模型有bert-base-chinese, bert-wwm-chinese, bert-wwm-ext-chinese, ernie-1.0, ernie-tiny, gpt2-base-cn, roberta-wwm-ext, roberta-wwm-ext-large, rbt3, rbtl3, chinese-electra-base, chinese-electra-small, chinese-xlnet-base, chinese-xlnet-mid, chinese-xlnet-large, unified_transformer-12L-cn, unified_transformer-12L-cn-luge等。

更多预训练模型参考:PaddleNLP Transformer API。

更多预训练模型fine-tune下游任务使用方法,请参考:examples。

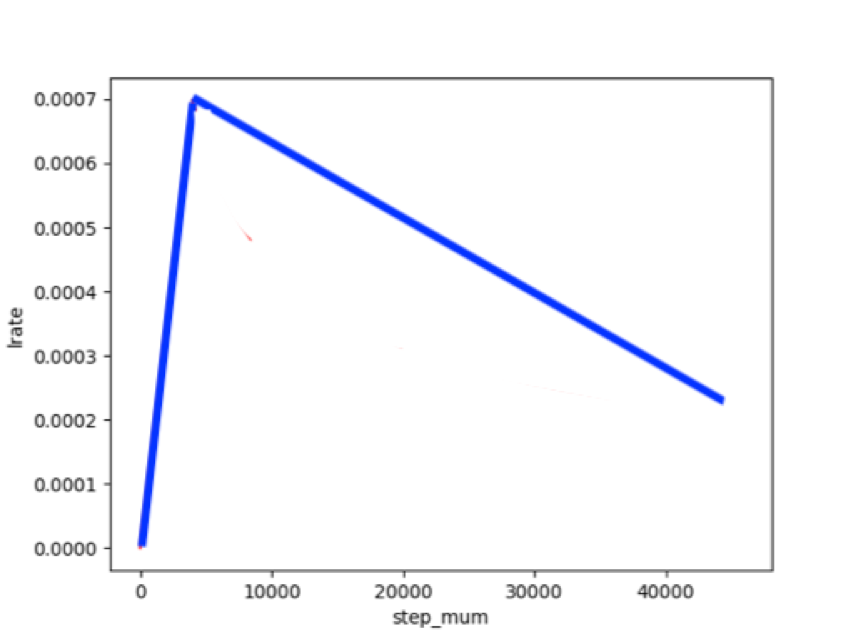

2.6设置Fine-Tune优化策略,模型配置

适用于ERNIE/BERT这类Transformer模型的迁移优化学习率策略为warmup的动态学习率。

- metric = ChunkEvaluator(label_list=label_vocab.keys(), suffix=True)

- loss_fn = paddle.nn.loss.CrossEntropyLoss(ignore_index=ignore_label)

- optimizer = paddle.optimizer.AdamW(learning_rate=2e-5, parameters=model.parameters())

2.7模型训练与评估

模型训练的过程通常有以下步骤:

- 从dataloader中取出一个batch data

- 将batch data喂给model,做前向计算

- 将前向计算结果传给损失函数,计算loss。将前向计算结果传给评价方法,计算评价指标。

- loss反向回传,更新梯度。重复以上步骤。

每训练一个epoch时,程序将会评估一次,评估当前模型训练的效果。

- step = 0

- for epoch in range(10):

- for idx, (input_ids, token_type_ids, length, labels) in enumerate(train_loader):

- logits = model(input_ids, token_type_ids)

- loss = paddle.mean(loss_fn(logits, labels))

- loss.backward()

- optimizer.step()

- optimizer.clear_grad()

- step += 1

- print("epoch:%d - step:%d - loss: %f" % (epoch, step, loss))

- evaluate(model, metric, dev_loader)

-

- paddle.save(model.state_dict(),

- './ernie_result/model_%d.pdparams' % step)

- # model.save_pretrained('./checkpoint')

- # tokenizer.save_pretrained('./checkpoint')

训练十轮,由于没有gpu所以有点慢运行的(6124秒hhh)。

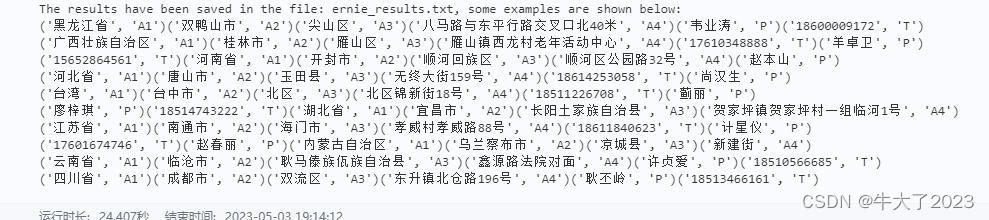

2.8模型预测

训练保存好的模型,即可用于预测。如以下示例代码自定义预测数据,调用predict()函数即可一键预测。

- preds = predict(model, test_loader, test_ds, label_vocab)

- file_path = "ernie_results.txt"

- with open(file_path, "w", encoding="utf8") as fout:

- fout.write("\n".join(preds))

- # Print some examples

- print(

- "The results have been saved in the file: %s, some examples are shown below: "

- % file_path)

- print("\n".join(preds[:10]))

三、总结

ERNIE是百度提出的一种基于持续学习技术的语义理解框架,该框架结合了大规模数据的预训练和多源知识的增强,能够不断吸收来自海量文本数据的语言信息,从而不断提升模型的效果。ERNIE在多个典型的NLP任务上取得了最好的结果,并在多个国际权威评测中获得了多项冠军。ERNIE技术获得了多个荣誉,包括中国人工智能学会优秀科技成果奖和世界人工智能大会最高荣誉SAIL奖。ERNIE在工业界也得到了广泛应用,例如搜索引擎、新闻推荐、广告系统、语音交互和智能客服等领域。全球顶级科技商业杂志《麻省理工科技评论》也报道了ERNIE相关的创新成果,相关技术也被国际顶级学术会议收录。

可以看出ernir1.0在实体抽取项目上准确率高达99%,看得出预训练模型将会是未来的主流。