热门标签

热门文章

- 1包里替换class文件_为了让Tomcat支持热替换,我直接修改了他的源码

- 2最好用的编辑器之一:Vim-Go环境搭建_vim golang

- 3解决:word打开后mathtype公式乱码、visio图乱码_office365查看visio出现乱码

- 4发布aar包到maven仓库_afterevaluate { artifact(tasks.getbyname("bundlere

- 5Python利用经纬度创建shpfile点图层并生成tif-问题_python gdal创建点shapefile

- 6华为手机如何升级鸿蒙系统_华为手机如何开启鸿蒙系统?

- 7通过View.post()获取View的宽高引发的两个问题:1post的Runnable何时被执行,2为何View需要layout两次;以及发现Android的一个小bug_view.post获取不到宽高

- 8ld: framework not found FileProvider

- 9今天聊聊基于神经符号的认知推理方法_符号神经推理

- 10P5963 [BalticOI ?] Card 卡牌游戏 贪心

当前位置: article > 正文

自然语言处理实战项目24-T5模型的介绍与训练过程,利用简单构造数据训练微调该模型,体验整个过程_t5微调训练

作者:Gausst松鼠会 | 2024-04-01 10:33:50

赞

踩

t5微调训练

大家好,我是微学AI,今天给大家介绍一下自然语言处理实战项目24-T5模型的介绍与训练过程,利用简单构造数据训练微调该模型,体验整个过程。在大模型ChatGPT发布之前,NLP领域是BERT,T5模型为主导,T5(Text-to-Text Transfer Transformer)是一种由Google Brain团队在2019年提出的自然语言处理模型。T5模型基于Transformer结构,可以执行多种自然语言任务,如翻译、摘要、问答、文本生成等。它不同于其他模型的地方在于,T5模型采用了统一的输入输出格式,并通过微调来适应不同的任务。

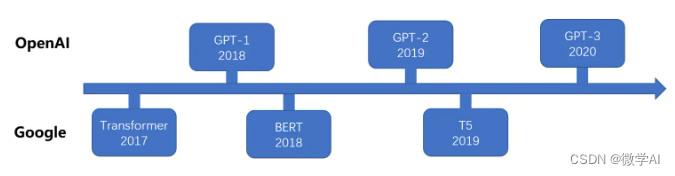

基于transformer大模型的发展过程

一、T5模型的介绍

T5模型基于Transformer结构,包含有编码器与解码器。编码器将输入语句转换成一组向量表示,而解码器则将向量表示转换成对应的输出。在T5模型中,编码器和解码器采用相同的transformer结构,并共享参数,这相当于在一个模型中同时学习多个任务。要训练T5模型,我们首先将大量的文本数据输入到模型中进行预训练,使得模型学习到了输入和输出之间的对应关系。而后,再利用有标注的数据对模型进行微调,以适应具体的任务需求。与其他自然语言处理模型相比,T5具备以下优势:

多任务学习能力强:同一个模型可以执行多种自然语言任务,只需要使用不同的微调方法即可。

零样本学习能力强:T5模型可以利用已有知识完成类似但未曾见过的任务。<

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Gausst松鼠会/article/detail/348485?site

推荐阅读

相关标签