- 1让 new bing 使用 GPT-4 编写一个令人满意的程序全过程赏析_bing写代码

- 2能用HTML/CSS解决的问题就不要使用JS_html点击导航栏切换内容不用js

- 3非计算机科班如何丝滑转码?小白我来说说看法_非科班计算机何去何从

- 4vue+Element实现静态旅游网站

- 5RHEL常用 Linux命令操作_用less命令分屏查看文件profile的内容,注意练习less命令的各个子命令,如b、p、q等

- 6Transformer 介绍_transformer有什么用

- 74G LTE 频率表_4g频段与band对照表

- 8随笔杂记(一)——小语种nlp文本预处理——数据清洗

- 9人工智能算法综述 (一)

- 10人工智能|机器学习——K-means系列聚类算法k-means/ k-modes/ k-prototypes/ ......(划分聚类)_kmeans聚类算法属于哪一门学科

AI版「女娲」来了!文字生成图像、视频,8类任务一个模型搞定

赞

踩

来源丨机器之心

作者丨陈萍、小舟

AI会是未来的「造物者」吗?

近来,视觉合成任务备受关注。几天前英伟达的 GauGAN 刚刚上新了 2.0 版本,现在一个新视觉合成模型 Nüwa(女娲)也火了。

相比于 GauGAN,「女娲」的生成模式更加多样,不仅有文本涂鸦生成图像,还能从文本生成视频。

随着 VQ-VAE 这种离散化 VAE 方案的出现,高效和大规模的预训练被逐渐应用于视觉合成任务,例如 DALL-E(图像)、GODIVA(视频)。这些模型虽然取得了巨大的成功,但仍然存在一些局限性——它们分别处理图像和视频,专注于生成其中一种,这限制了模型从图像和视频数据中受益。相比之下,「女娲」是一个统一的多模态预训练模型,在 8 种包含图像和视频处理的下游视觉任务上具有出色的合成效果。

论文地址:https://arxiv.org/pdf/2111.12417.pdf

GitHub 地址:https://github.com/microsoft/NUWA

模型概览

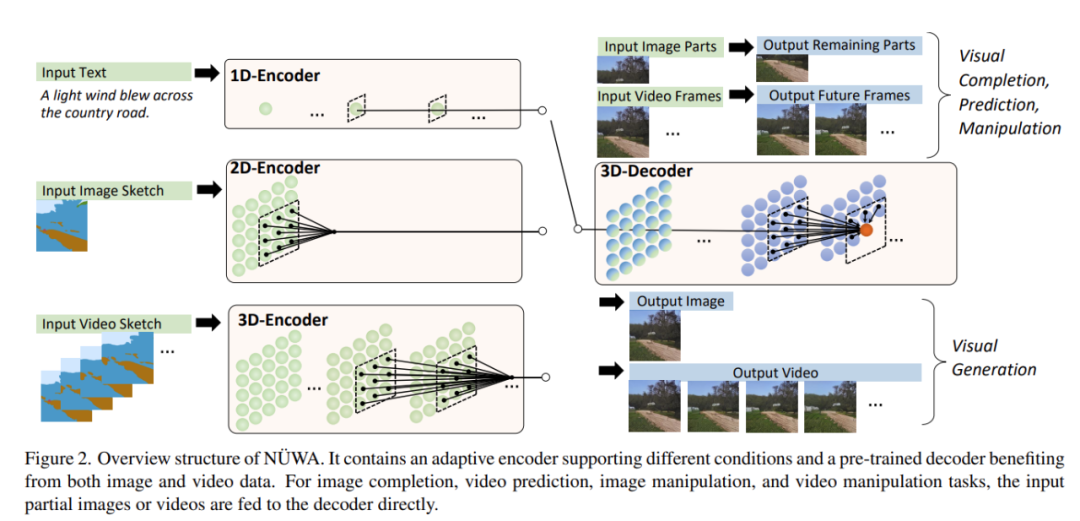

该研究提出了一个通用的 3D transformer——编码器 - 解码器框架(如下图所示),同时涵盖了语言、图像和视频,可用于多种视觉合成任务。该框架由以文本或视觉草图作为输入的自适应编码器和由 8 个视觉合成任务共享的解码器组成。

「女娲」整体架构图。

该框架还包含一种 3D Nearby Attention (3DNA) 机制,以考虑空间和时间上的局部特征。3DNA 不仅降低了计算复杂度,还提高了生成结果的视觉质量。与几个强大的基线相比,「女娲」在文本到图像生成、文本到视频生成、视频预测等方面都得到了 SOTA 结果。此外,「女娲」还显示出惊人的零样本学习能力。

「女娲」的 8 种跨模态合成模式分别是:

文本转图像:

涂鸦转图像:

图像补全:

根据文本编辑图像:

文本转视频:

视频预测:

涂鸦转视频:

根据文本编辑视频:

实验结果

还研究通过多项实验评估了合成结果。

首先研究者将「女娲」在三个数据集上进行预训练:用于文本 - 图像 (T2I) 生成的 Conceptual Captions,包括 2.9M 文本 - 图像对;用于视频预测 (V2V) 的 Moments in Time,包括 727K 视频;用于文本 - 视频 (T2V) 生成的 VATEX 数据集,包括 241K 文本 - 视频对。

与 SOTA 方法比较

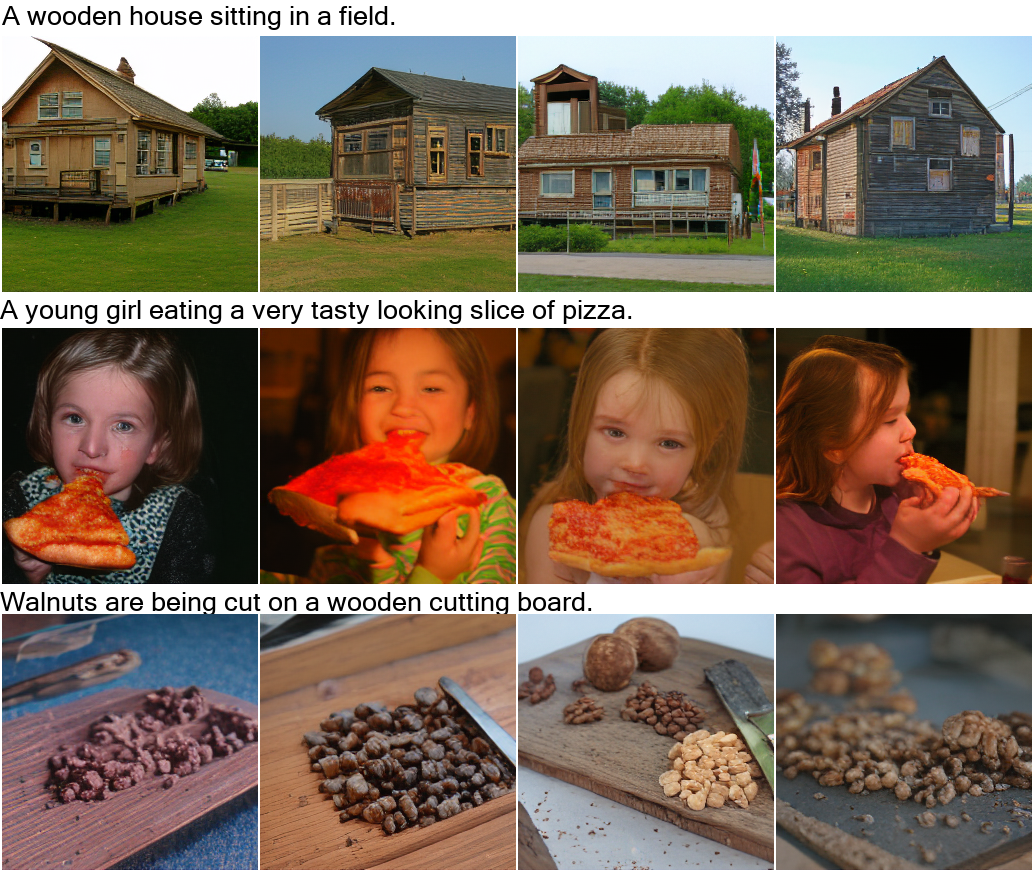

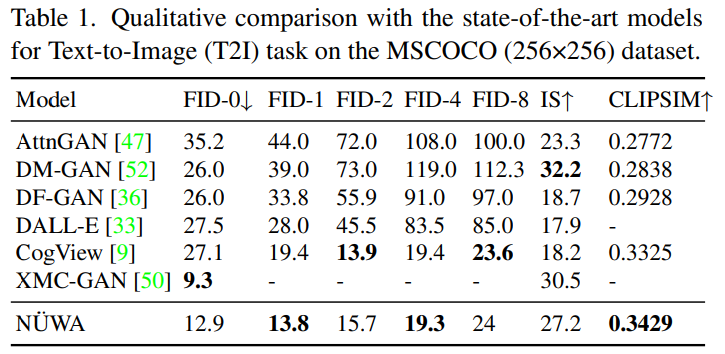

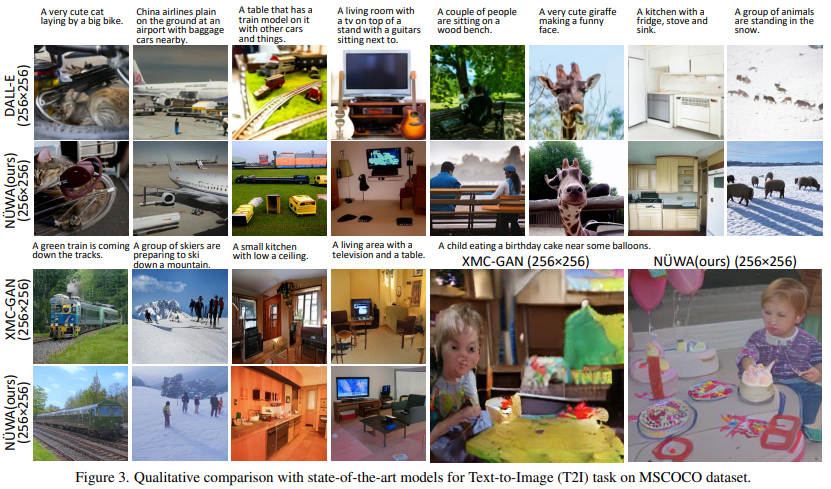

文本 - 图像 (T2I) 微调:该研究比较了「女娲」在 MSCOCO 数据集上的性能,如表 1 和图 3 所示:在表 1 中,「女娲」明显优于 CogView,其中 FID-0 为 12.9,CLIPSIM 为 0.3429 。尽管 XMC-GAN 的 FID-0 为 9.3,优于「女娲」,但「女娲」能生成更逼真的图像,如图 3 所示。特别是在最后一个例子中,「女娲」生成的男孩脸更清晰,并且男孩旁边的气球也很逼真。

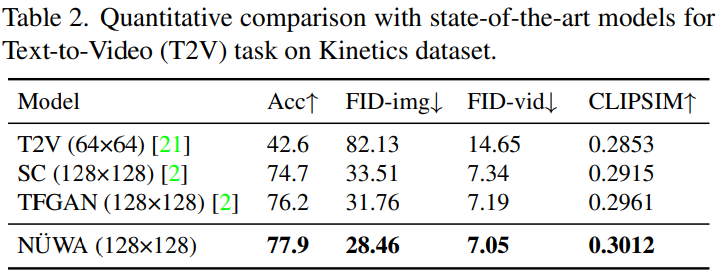

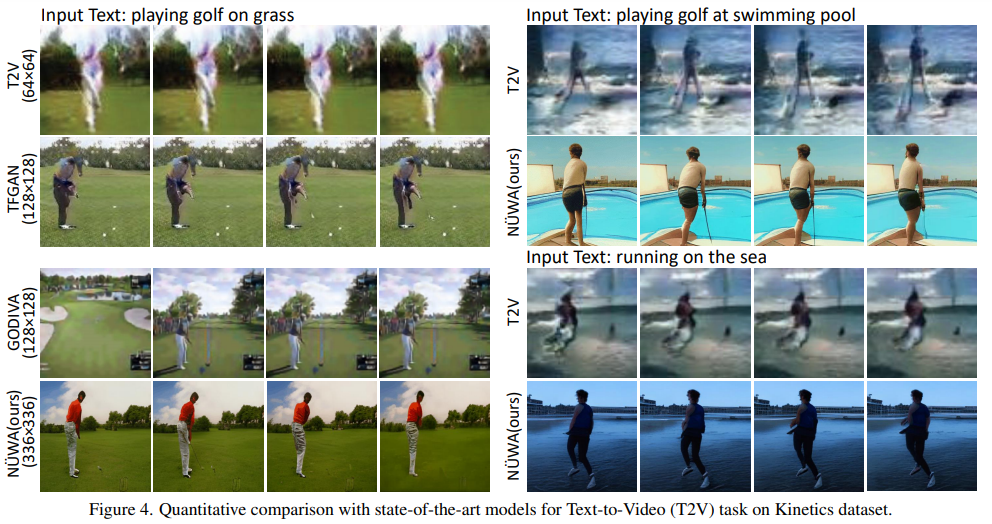

文本 - 视频 (T2V) 微调:该研究在 Kinetics 数据集上评估了「女娲」,结果如表 2 和图 4 所示。在表 2 中,「女娲」在所有指标上实现了最好的性能。

在图 4 中,该研究还展示了「女娲」强大的零样本生成能力,可以生成没见过的图像,例如:在游泳池里打高尔夫球,在海里奔跑:

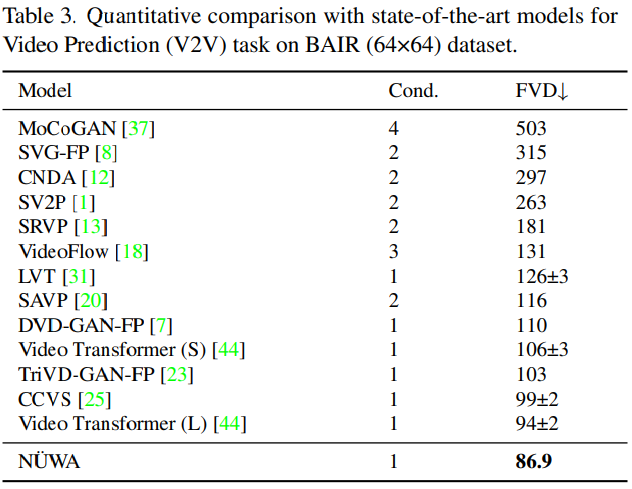

视频预测 (V2V) 微调:该研究在 BAIR Robot Pushing 数据集上对「女娲」和其他模型进行了比较,结果如表 3 所示:为了进行公平比较,所有模型都使用 64×64 分辨率。虽然只给出了一帧作为条件(Cond.),但「女娲」仍然将 SOTA FVD 得分从 94±2 降到 86.9 。

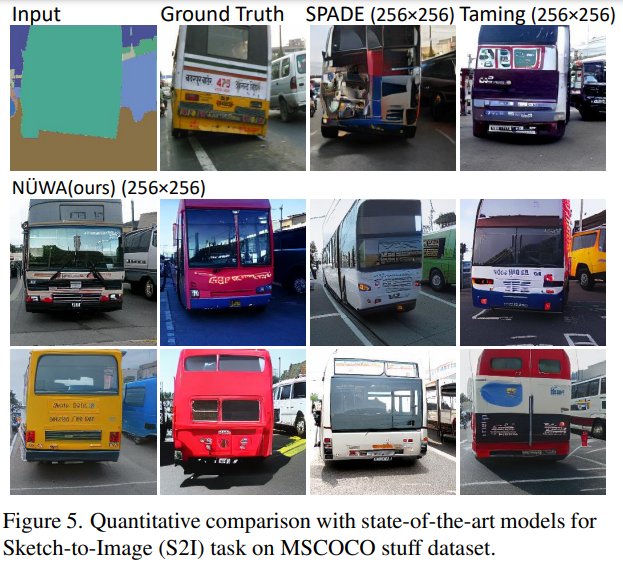

草图 - 图像 (S2I)微调:该研究在 MSCOCO stuff 上进行实验,如图 5 所示。与 Taming-Transformers 和 SPADE 相比,「女娲」生成了种类繁多的逼真汽车, 甚至巴士车窗的反射也清晰可见。

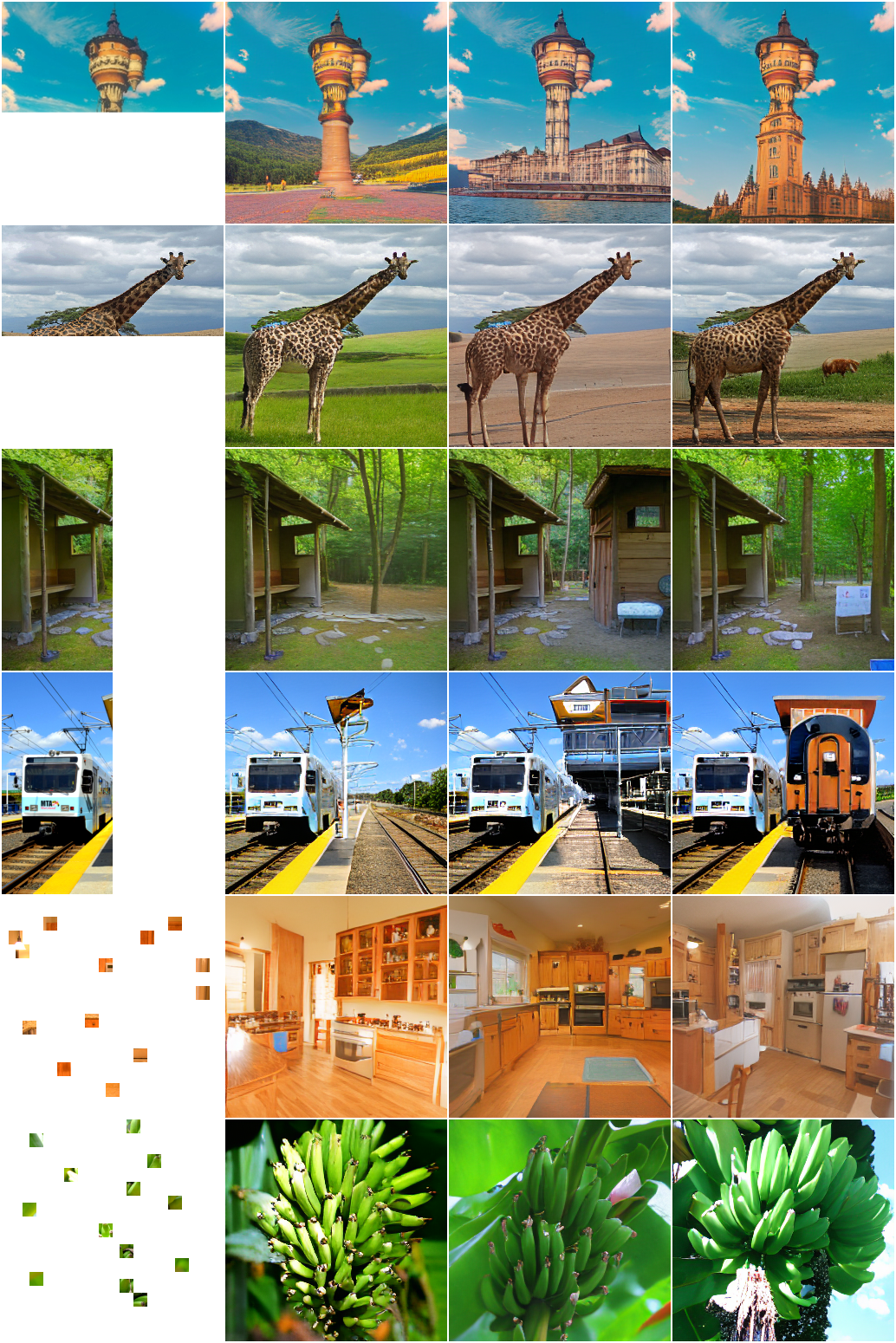

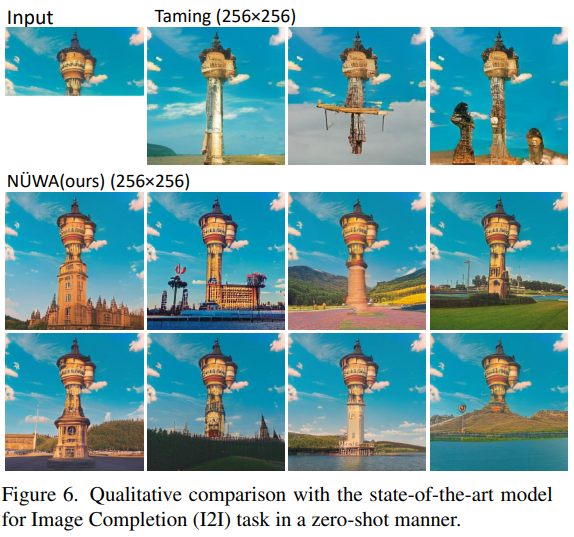

图像补全 (I2I) 零样本评估:给定塔楼的上部,与 Taming Transformers 模型进行比较,「女娲」可以生成对塔楼下半部分更丰富的想象,包括生成周围建筑物、湖泊、花草、树木、山脉等。

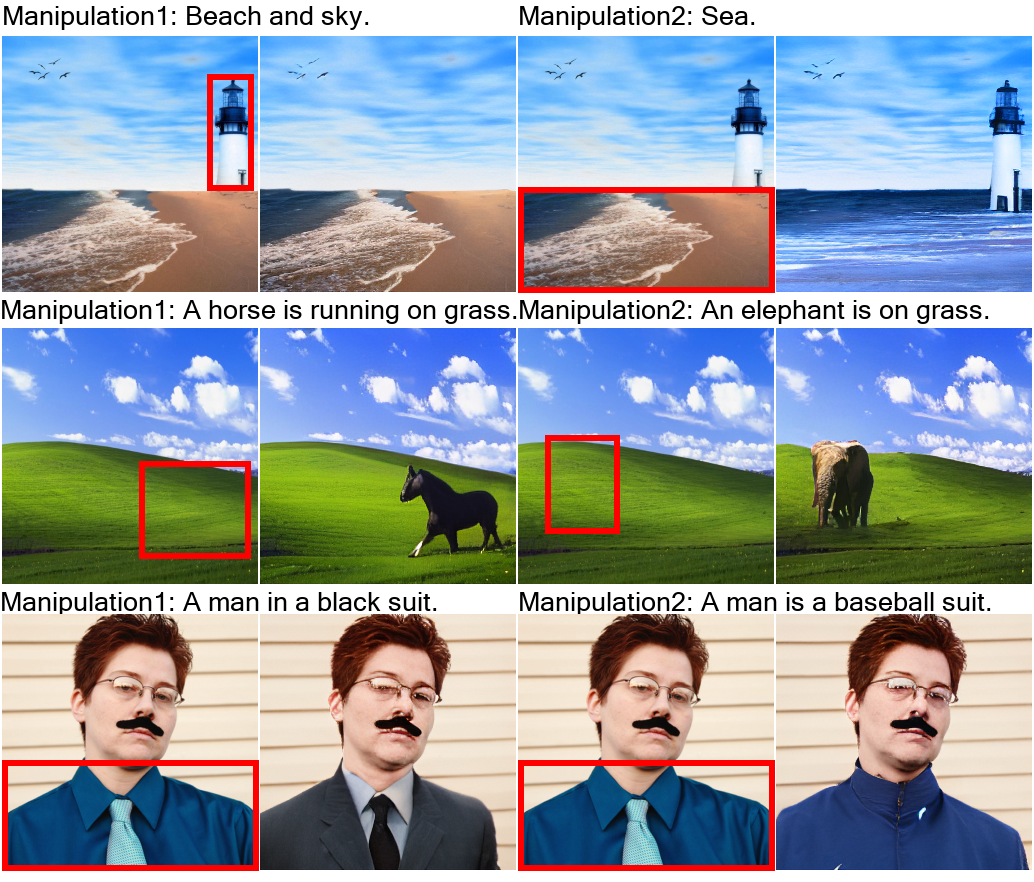

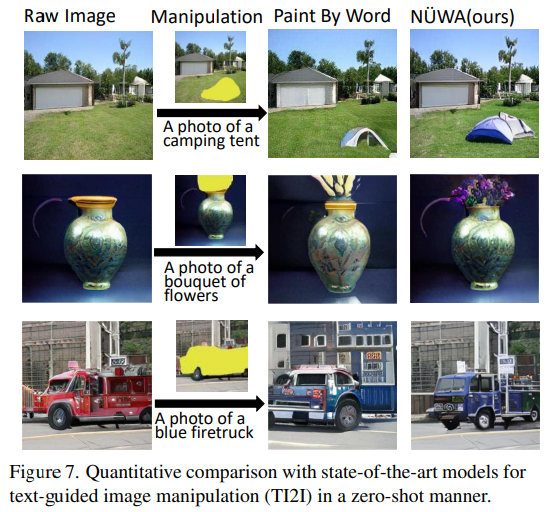

文本 - 指导图像处理 (TI2I) 零样本评估:「女娲」显示了其强大的处理能力,可以生成高质量的文本一致性结果,而不会改变图像的其他部分。

消融实验

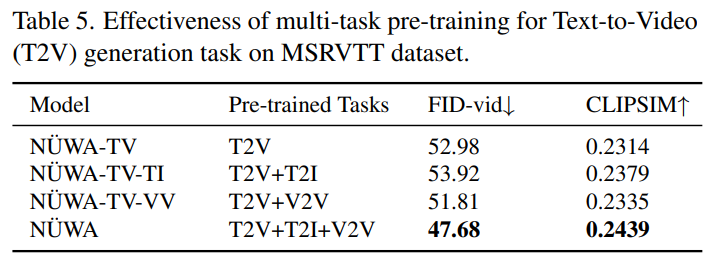

图 5 显示了文本 - 视频 (T2V) 生成任务中多任务预训练的有效性。该研究在具有挑战性的数据集 MSR-VTT(具有自然描述和真实视频) 上进行了实验。「女娲」FID-vid 为 47.68,CLIPSIM 为 0.2439。

图 9 显示了文本指导视频处理(TV2V)。第一行显示了原始视频帧,潜水员在潜水;第二行为潜水员正在向水面游;第三行显示可以让潜水员游到海底,如果我们想生成让潜水员飞向天空的图片?「女娲」可以实现,从图中可以看出,潜水员像火箭一样飞向天空。

本文仅做学术分享,如有侵权,请联系删文。

3D视觉精品课程推荐:

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

4.国内首个面向工业级实战的点云处理课程

5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~