- 1Hadoop简介和集群搭建测试(一)_hadoop 测试(一)

- 2docker报错error response解决方法_error response from daemon: network with name demo

- 3基于微信小程序麻将棋牌室预约系统设计与实现 毕业设计论文大纲提纲参考_小程序棋牌室论文

- 4vue3管理系统中后台返回pdf格式的文件流,前端如何预览?以及uniapp微信小程序中后台返回的base64位的pdf文件如何预览?_uniapp+vue3打开文件流

- 5Malloc,calloc,realloc函数的学习_ret[i] = malloc(sizeof(int) * (i + 1));

- 6RocketMQ中MessageExt属性

- 7电子烟方案|电子烟设计|电子烟芯片

- 8HR必备图表分析模板

- 9MATLAB CIC滤波器_cic滤波器 matlab

- 10代号:408 —— 1000道精心打磨的计算机考研题

Memorization Discrepancy:利用模型动态信息发现累积性注毒攻击

赞

踩

本文分享阿里妈妈外投算法团队与香港浸会大学可信赖机器学习和推理组(HKBU TMLR Group)合作在理论与实践上探索外投广告媒体等复杂场景下应对噪声信号进行模型训练的问题。基于该项工作总结的论文已发表在ICML 2023,欢迎阅读交流。

▐ 摘要

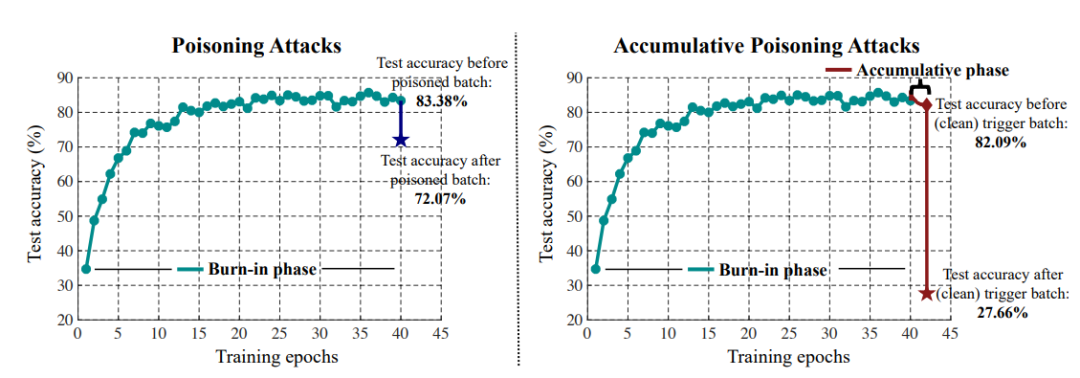

近期研究表明,对抗性注毒攻击(Poisoning attack)对各类机器学习应用会构成巨大威胁 [1,2]。有别于之前研究所关注的线下注毒设定,累积性注毒攻击(accumulative poisoning attack)[3] 是最近提出的一种模拟线上实时数据流设定下进行注毒攻击的方法。通过利用两阶段不同的注毒样本生成投放,累积性注毒攻击能够优化第一阶段中注毒样本的不可辨别性,以此实现更为隐匿的注毒攻击。并且,能够将第一阶段中的注毒效果累积至第二个触发阶段,达到在短时间内大幅降低模型性能的效果。

考虑到线上模拟实时数据流的学习设定,之前基于线下注毒攻击的防御算法或数据层面的检测方法由于信息的缺失无法应对这种新型的注毒攻击方法。然而,现有可能的防御方法例如对抗训练变体 [4] 及梯度截断 [5] 会导致对注毒数据与干净数据有无差别或过度纠正,进而对机器学习模型的性能有所影响。由于对在线数据流的数据检测相对困难,我们考虑到是否可以从模型的动态变化中挖掘对发现注毒攻击有用的信息来识别这种隐匿的累积注毒攻击。基于此,我们在本项工作中:

首次从模型动态变化的角度探索注毒攻击的发现;

提出了一种新的信息评价指标,记忆性差异,利用模型动态变化尝试分辨不可见的注毒样本;

基于新的信息评价指标提出了针对累积注毒攻击的防御学习算法。

接下来将简要地向大家分享我们近期发表在 ICML 2023 上的有关模型动态及注毒样本发现的研究结果,欢迎阅读交流。

论 文:Exploring Model Dynamics for Accumulative Poisoning Discovery

论文作者:Jianing Zhu, Xiawei Guo, Jiangchao Yao, Chao Du, Li He, Shuo Yuan, Tongliang Liu, Liang Wang, Bo Han

下 载:https://arxiv.org/abs/2306.03726

代码链接:https://github.com/tmlr-group/Memorization-Discrepancy

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。