热门标签

热门文章

- 1CSS 伪元素 content的特殊用法_css 伪类 content

- 2面经 阿里云算法工程师实习生(已拿offer)_阿里云人工智能算法工程师怎么样

- 3Vue实现的人事管理系统,高质量毕业论文范例,附送源码、数据库脚本,项目导入与运行教程,论文撰写教程_人事管理系统vue

- 4python写学生信息管理系统,python学生管理系统报告

- 5数据结构:链表详解 (c++实现)

- 6【ATT&CK】守株待兔式的水坑攻击_常见水坑攻击识别

- 7使用 ElementPlus 组件时,遇到的一些问题及解决方案_elementplustype "password" is not assignable to ty

- 8VHDL和Verilog中数组定义、初始化、赋值方法_verilog数组表示及初始化

- 9题库数据库设计

- 10Hexo+GitHub+Netlify:打造高效个性化博客的完整指南_netlify部署hexo博客

当前位置: article > 正文

人工智能-作业2:例题程序复现_人工智能误差修正规则例题

作者:Guff_9hys | 2024-07-10 21:53:29

赞

踩

人工智能误差修正规则例题

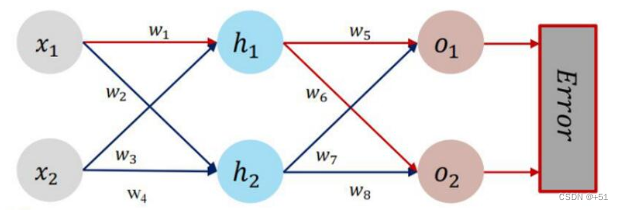

反向传播算法的原理是利用链式求导法则计算实际输出结果与理想结果之间的损失函数对每个权重参数或偏置项的偏导数,然后根据优化算法逐层反向地更新权重或偏置项,它采用了前向-后向传播的训练方式,通过不断调整模型中的参数,使损失函数达到收敛,从而构建准确的模型结构。

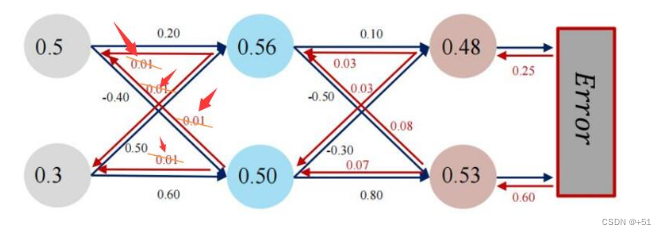

计算过程:

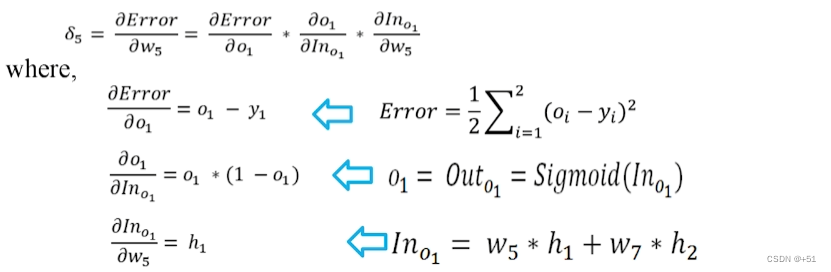

(w5~w8)以w5为例的梯度计算过程

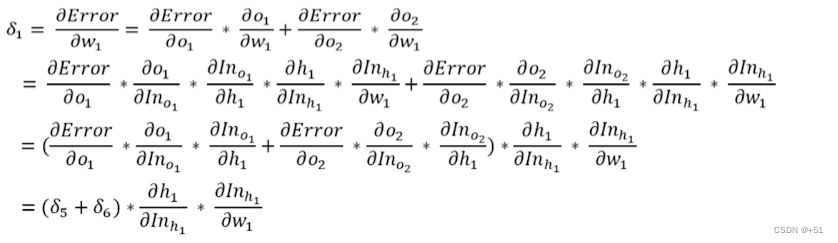

(w1~w4)以w1为例的梯度计算过程:

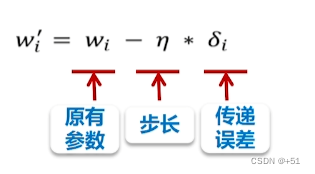

参数更新过程:

def update_w(w1, w2, w3, w4, w5, w6, w7, w8):

# 步长

step = 5

w1 = w1 - step * d_w1

w2 = w2 - step * d_w2

w3 = w3 - step * d_w3

w4 = w4 - step * d_w4

w5 = w5 - step * d_w5

w6 = w6 - step * d_w6

w7 = w7 - step * d_w7

w8 = w8 - step * d_w8

return w1, w2, w3, w4, w5, w6, w7, w8

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

重复计算可以不断修正w的值。

代码实现

import numpy as np def sigmoid(z): a = 1 / (1 + np.exp(-z)) return a def forward_propagate(x1, x2, y1, y2, w1, w2, w3, w4, w5, w6, w7, w8): in_h1 = w1 * x1 + w3 * x2 out_h1 = sigmoid(in_h1) in_h2 = w2 * x1 + w4 * x2 out_h2 = sigmoid(in_h2) in_o1 = w5 * out_h1 + w7 * out_h2 out_o1 = sigmoid(in_o1) in_o2 = w6 * out_h1 + w8 * out_h2 out_o2 = sigmoid(in_o2) print("正向计算:o1 ,o2") print(round(out_o1, 5), round(out_o2, 5)) error = (1 / 2) * (out_o1 - y1) ** 2 + (1 / 2) * (out_o2 - y2) ** 2 print

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Guff_9hys/article/detail/807852

推荐阅读

相关标签