- 1java MD5算法返回数字型字串_java md5加密并将结果用十进制表示

- 2C++初识--------带你从不同的角度理解引用的巧妙之处

- 3【送书福利-第三十期】《Java面试八股文:高频面试题与求职攻略一本通》_java面试八股文高频面试题与求职攻略电子书

- 4Windows中redis怎么设置密码_windows redis设置密码

- 5Vue中组件生命周期过程详解_vue 子组件生命周期

- 6树莓派安装python3.9以及pip换源_树莓派安装pip

- 7python无人机路径规划算法_无人机集群——航迹规划你不知道的各种算法优缺点...

- 8卓越体验的秘密武器:评测ToDesk云电脑、青椒云、天翼云的稳定性和流畅度_青椒云评价

- 9Mybatis 注解实现基本 CRUD_mybatis mapper 注解方式编程:针对模型类设计基本的 crud 功

- 10数据结构-----二叉排序树

OOTDiffusion:一个开源可控的虚拟服装试穿工具,效果接近商用!

赞

踩

目录

前言介绍

继谷歌推出了Tryon Diffusion,阿里推出了Outfit Anything, 亚马逊也推出了Diffuse to Choose。至此几大头部电商也都在虚拟试衣技术上完成了布局。基于扩散模型的技术基本已经成为现在主流应用的基石。

在之前的文章中已经详细的介绍了谷歌的Tryon Diffusion、阿里的Outfit Anything以及亚马逊的Diffuse to Choose,感兴趣的小伙伴可以点击下面链接阅读~

电商模特危机!谷歌最新模型Tryon Diffusion一键试衣,线上购物被革命_tryondiffusion-CSDN博客文章浏览阅读936次,点赞17次,收藏19次。谷歌的新AI模型TryOnDiffusion,直接解决了AI换装的两大难题——既保留衣服细节,又能随意换姿势。以后再剁手,恐怕要更容易了!你只要给它一张自己的全身照,和服装模特的照片,就能知道自己穿上这件衣服之后是什么样子了。一键换装,被谷歌给实现了!Try_tryondiffusionhttps://blog.csdn.net/xs1997/article/details/135784937?spm=1001.2014.3001.5501AI一键换衣,阿里Outfit Anyone来了,电商人的福音!_outfit anyone: ultra-high quality virtual try-on f-CSDN博客文章浏览阅读1.1k次,点赞17次,收藏18次。继谷歌推出Tryon Diffusion虚拟试穿后,国内的头部电商阿里也推出的Outfit Anyone虚拟试穿技术。该技术采用双流条件扩散模型,处理模特和服装数据,通过衣物图像实现逼真的虚拟试穿效果,结合Animate Anyone技术,轻松制作任意角色的换装视频。只需要一张人物照片和服装照片,就可以为不同的姿势和身体形状创建高质量的虚拟试穿。国内的电商革命也终于要到来了!_outfit anyone: ultra-high quality virtual try-on for any clothing and an

https://blog.csdn.net/xs1997/article/details/135816476?spm=1001.2014.3001.5501Diffuse to Choose亚马逊虚拟试衣终于来了,为网购客户提供身临其境的虚拟试穿服务-CSDN博客文章浏览阅读907次,点赞27次,收藏20次。亚马逊推出的Diffuse to Choose工具也是基于扩散模型改进,可以为网购客户提供身临其境的虚拟试穿服务。与扩散模型相比,Diffuseto Choose模型能更好地捕捉商品细节,保证与环境的高度融合。用户可以上传一张全身自拍照,测试不同服装的试穿效果,或者上传多张人物照片,测试同件服装的穿着效果。消费者还可以拍摄家中的场景,选择不同的家具来测试商品和家装氛围的契合度。

https://blog.csdn.net/xs1997/article/details/135991511?spm=1001.2014.3001.5501 遗憾的是这几项技术都没有开源,目前只开放了demo试用。然而今天向大家介绍东京大学刚开源的OOTDiffusion虚拟服装试穿工具,可根据不同性别和体型调整服装,支持半身和全身模型。利用先进技术生成高质量服装图像,用户可精细控制试穿细节,提升试穿体验。目前github项目已经开源,也提供在在线试玩的demo,效果基本上已经可以达到商用的水平。

借助OOTDiffusion,用户无需实际试穿即可预览上身效果,大大提升了消费者在网购过程中的体验感和决策效率。无论你是追逐潮流的年轻人,还是注重品质的都市白领,亦或是热爱DIY搭配的时尚达人,都可以利用此模型轻松探索自我风格,发掘无限可能。

主要功能

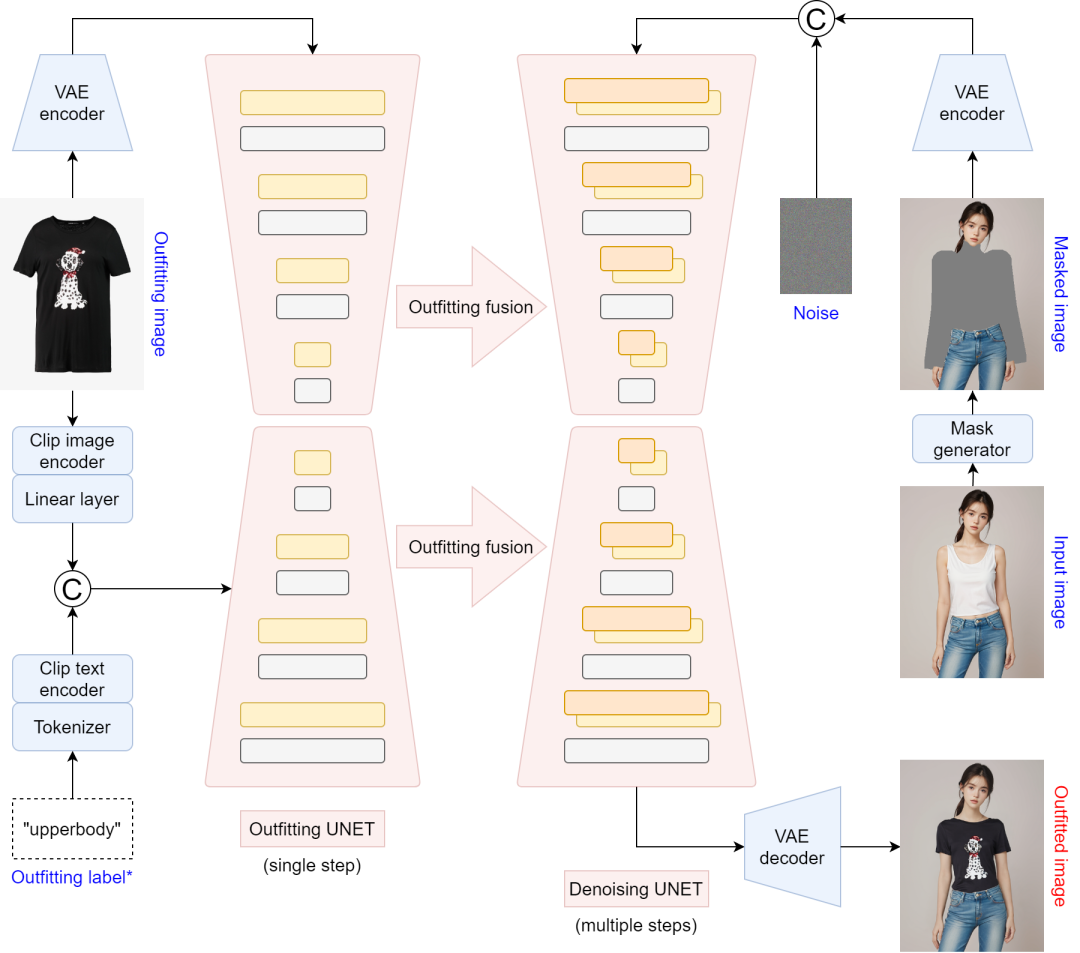

1、基于潜在扩散的装备融合:利用潜在扩散模型(latent diffusion models)的先进技术,OOTDiffusion实现了高质量的服装图像生成和融合,确保试穿效果自然且逼真。

2、半身和全身虚拟试穿:OOTDiffusion支持两种模式的虚拟试穿:半身模型:专为上半身的服装试穿设计,适合T恤、衬衫等上身服装。

3、全身模型:支持全身的服装试穿,包括上身、下身和连衣裙等服装类型。用户可以根据需求选择适合的模型进行虚拟试穿。

4、可控的试穿参数:你可以通过调整模型路径、服装路径、缩放比例和采样次数等参数,精细控制虚拟试穿的细节和效果,以满足不同的试穿需求和偏好。

5、自然融合与逼真效果:通过精心设计的算法OOTDiffusion能够将选定的服装自然且逼真地融合到用户提供的模型图像中,无论是纹理、光影还是服装的自然摆动都能精确呈现。

相关链接

项目地址:https://github.com/levihsu/OOTDiffusion

试用地址:https://ootd.ibot.cn/

安装部署

1.克隆存储库

git clone https://github.com/levihsu/OOTDiffusion

2.创建一个 conda 环境并安装所需的包

- conda create -n ootd python==3.10

-

- conda activate ootd

-

- pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 numpy==1.24.4 scipy==1.10.1 scikit-image==0.21.0 opencv-python==4.7.0.72 pillow==9.4.0 diffusers==0.24.0 transformers==4.36.2 accelerate==0.26.1 matplotlib==3.7.4 tqdm==4.64.1 gradio==4.16.0 config==0.5.1 einops==0.7.0 ninja==1.10.2

3.推理

3.1 半身模型

- cd OOTDiffusion/run

- python run_ootd.py --model_path <model-image-path> --cloth_path <cloth-image-path> --scale 2.0 --sample 4

3.2 全身模型

服装类别必须配对:0 = 上半身;1 = 下半身;2 = 连衣裙

- cd OOTDiffusion/run

- python run_ootd.py --model_path <model-image-path> --cloth_path <cloth-ima

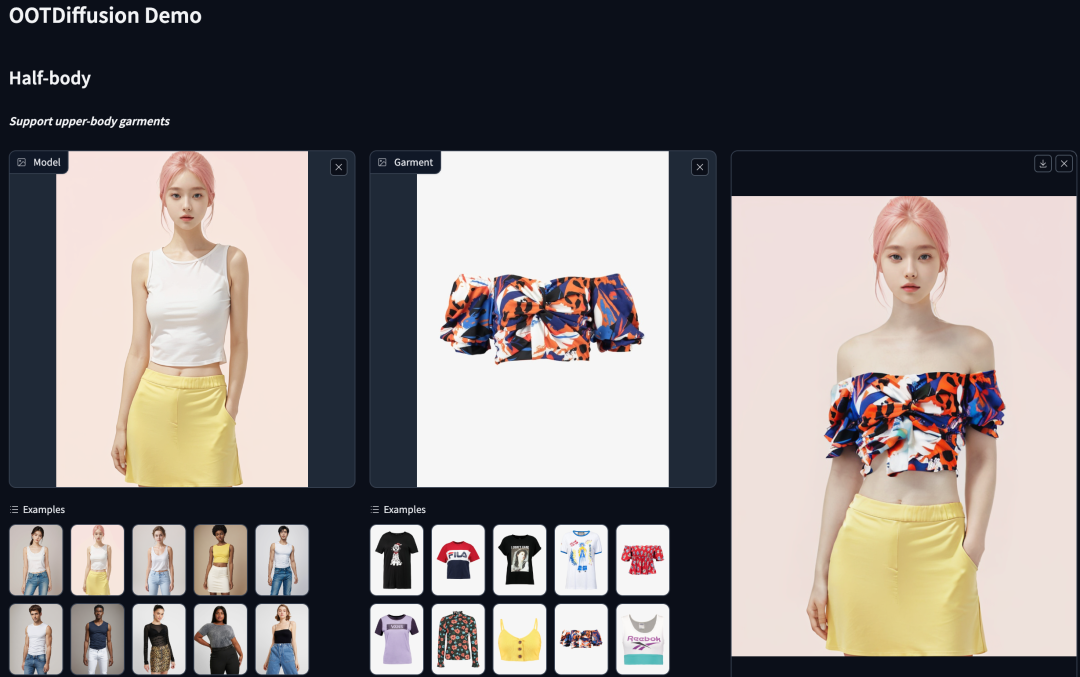

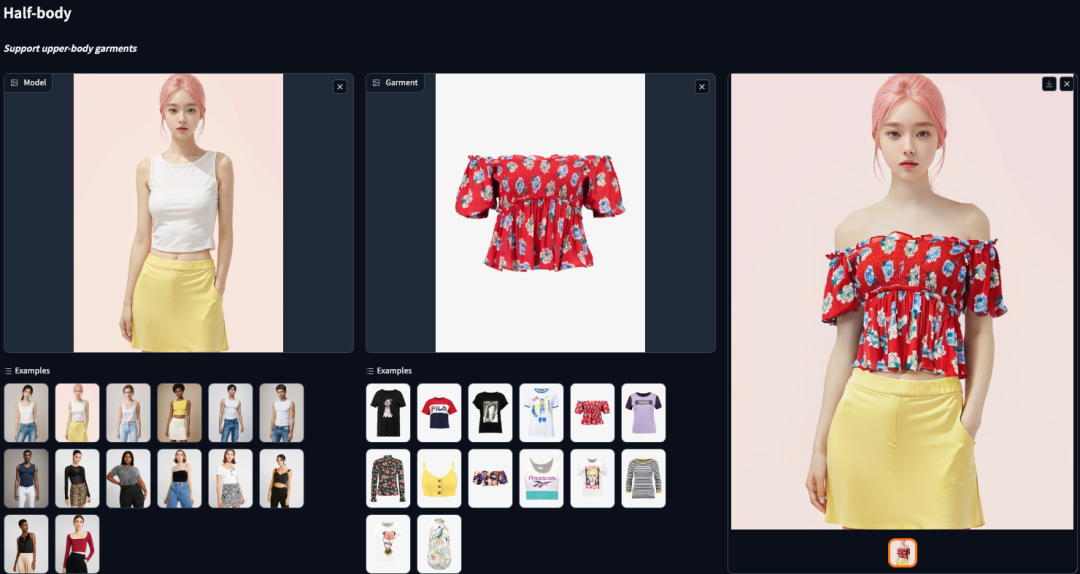

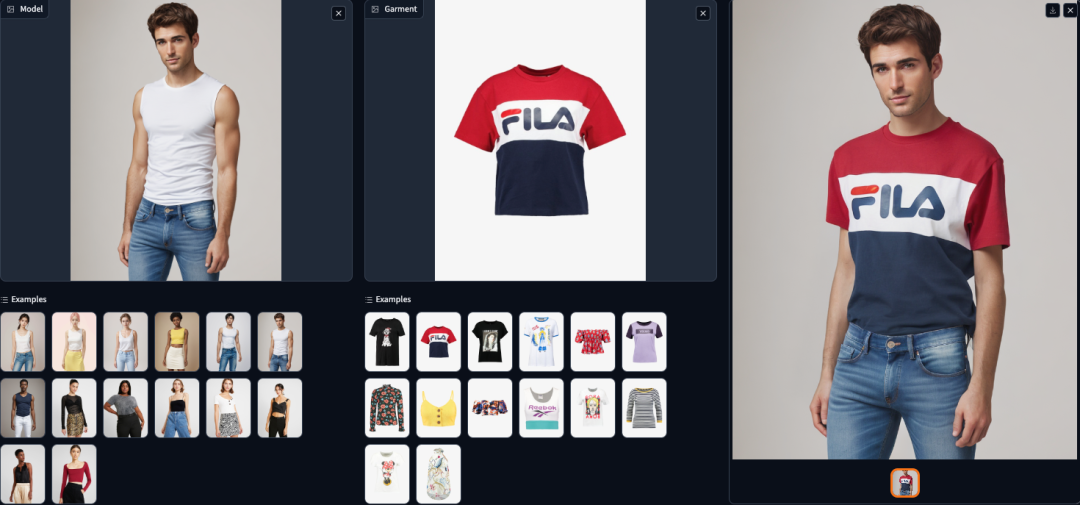

目前已经有了体验地址,效果还是挺惊艳的,相比于阿里的AnyDoor操作更便捷,不需要局部涂抹重绘,直接一键就可以完成换衣服操作。大家快去体验一下吧~

效果展示

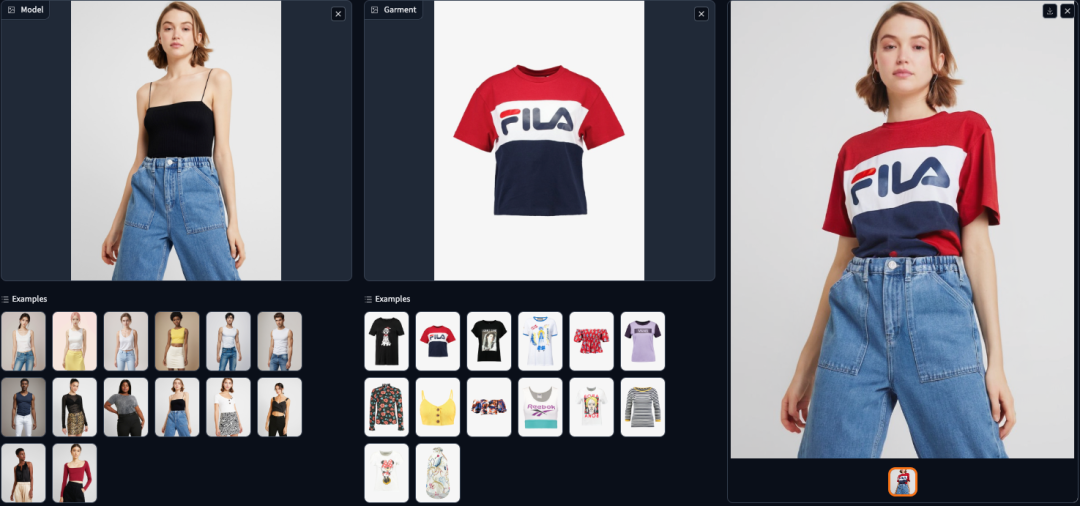

替换上衣效果:

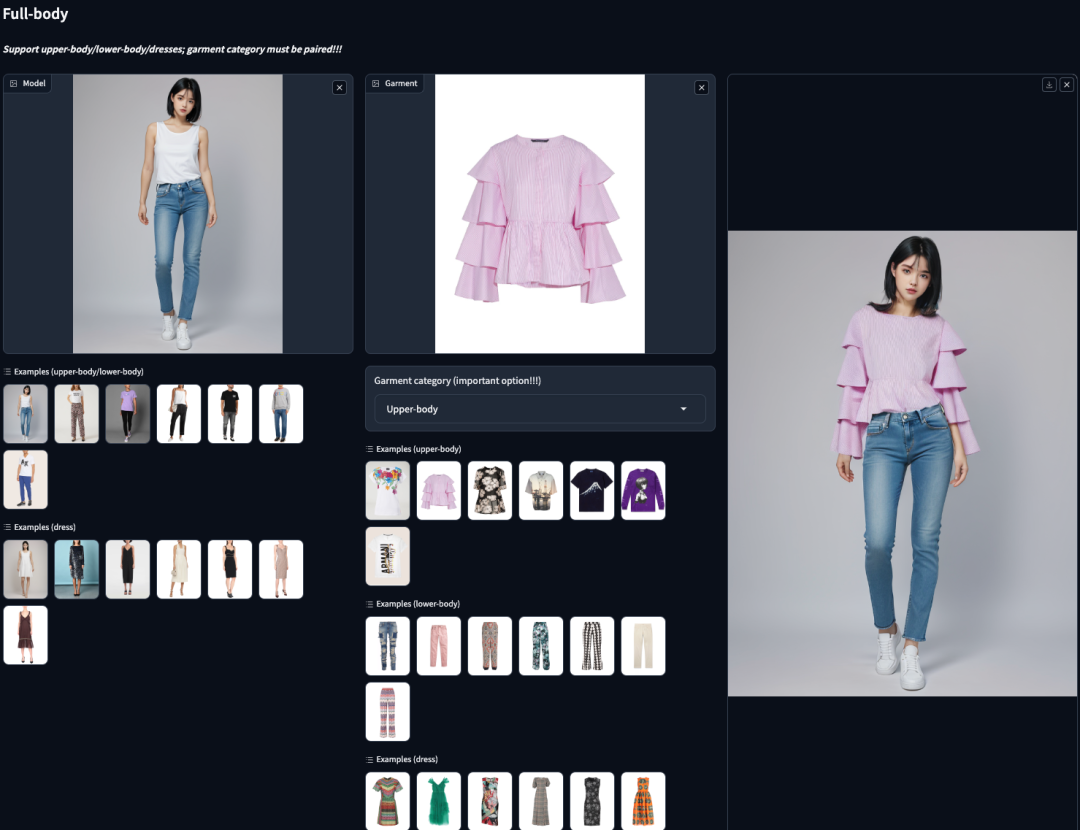

替换全身衣服效果:

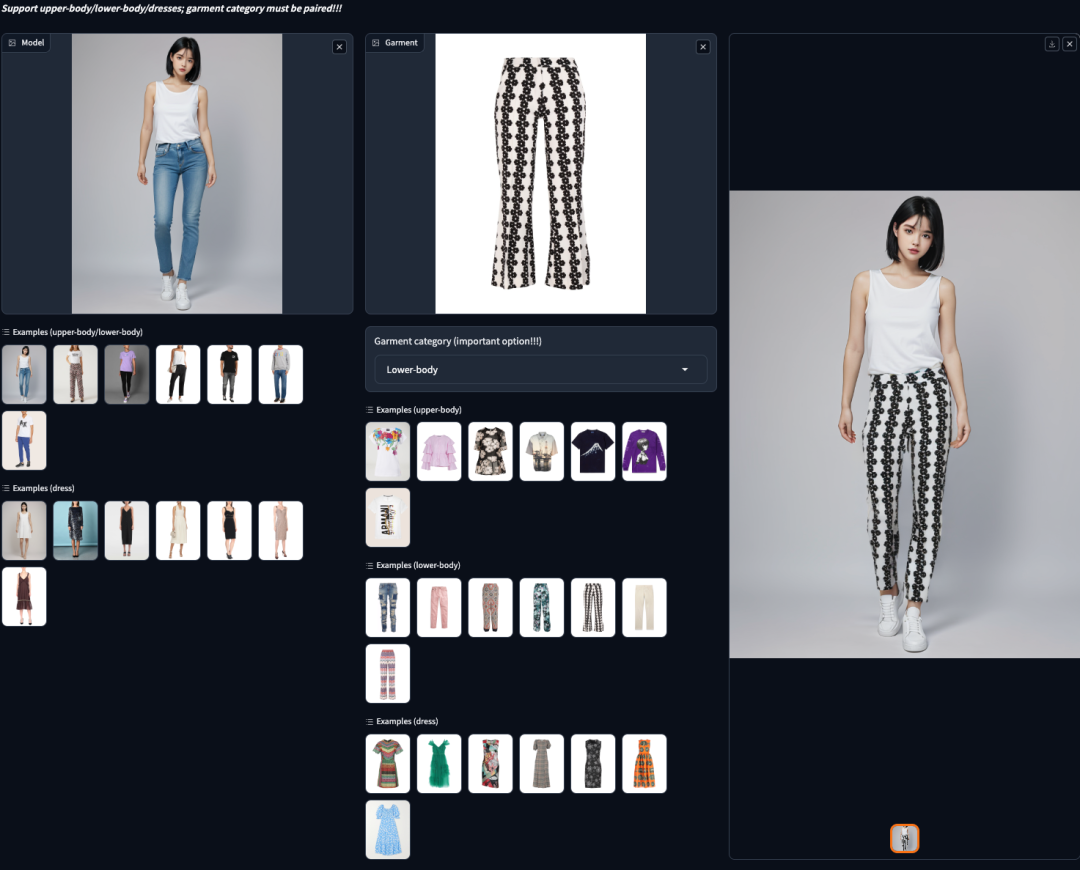

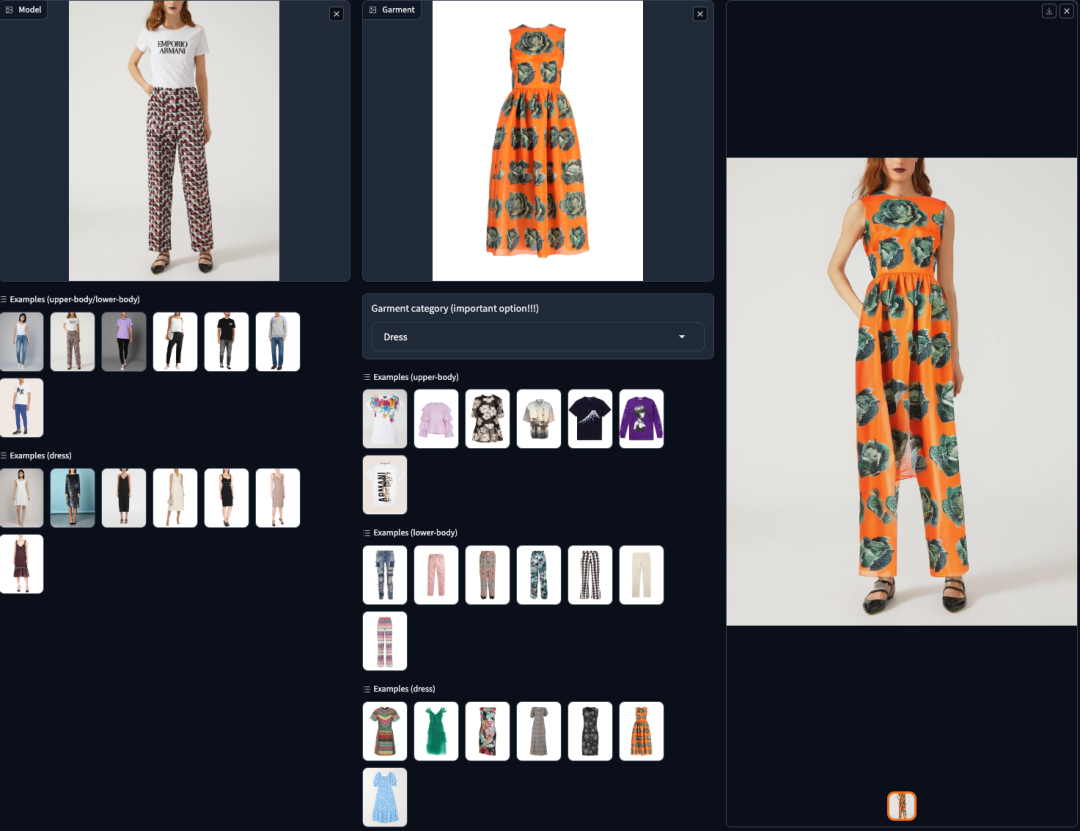

再来一个全身装替换:

感谢你看到这里,也欢迎点击关注下方公众号,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、Stable Diffusion等相关技术,欢迎一起交流学习

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。