热门标签

热门文章

- 1Swift 3.0中GCD的常用方法_swift group.notify主动退出

- 2春招复盘来了,腾讯,蚂蚁,百度等一线名企面试总结,大厂真没你想的那么难!_现在有一列火车,有10站,每站都有人上下车,设计数据结构,处理每个站的座位数

- 3解决安卓手机无法连接fastboot但是可以usb调试_fastboot连不上

- 4我的MYSQL学习心得(十) 自定义存储过程和函数

- 5HackingLab的一套渗透测试题_hackinglab题目

- 6Redis教程(十八):Redis的Redisson的看门狗机制_redis看门狗

- 7移动硬盘插入提示需要格式化RAW_Macbook无法识别移动硬盘?!不仅仅因为硬盘格式问题...

- 8jenkins svn插件_Jenkins+SVN

- 9【ESP32S3 Sense接入语音识别+MiniMax模型对话】_esp32语音识别

- 10web前端面试题整理(vue、uni-app、前端三件套、web基础)_前端uniapp面试题

当前位置: article > 正文

创造未来知识管理新篇章:Ollama与AnythingLLM联手打造个人与企业的安全知识库!_anythingllm ollama docker-compose

作者:IT小白 | 2024-06-09 23:11:18

赞

踩

anythingllm ollama docker-compose

一 Ollama

1.1 简介

Ollama是一个开源的大型语言模型服务工具,它帮助用户快速在本地运行大模型。通过简单的安装指令,用户可以执行一条命令就在本地运行开源大型语言模型,如Llama 2。Ollama极大地简化了在Docker容器内部署和管理LLM的过程,使得用户能够快速地在本地运行大型语言模型。

关于 Ollama 的详细介绍和安装使用请参考如下文章:

- 打造个性化聊天机器人:用Ollama和Open WebUI搭建你的私有ChatGPT!

- windows 下 docker compose 安装 ollama 和 open-webui ,打造私有GPT

1.2 打开ollama端口

Ollama其实有两种模式:

- 聊天模式

- 服务器模式

这里使用服务器模式,Ollama在后端运行大模型,开发IP和端口给外部软件使用。

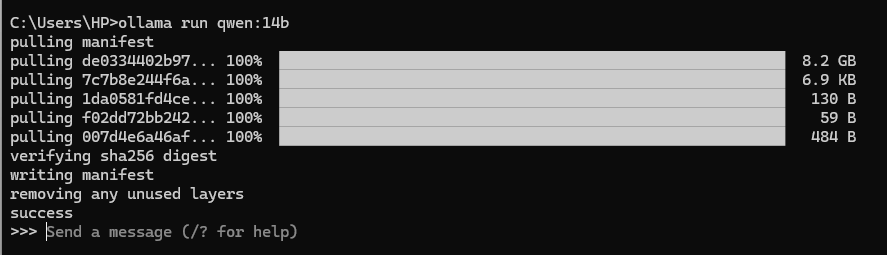

下载AnythingLLM之后开始进入启动的配置阶段,开始之前请确保 ollama serve 运行,或者终端执行 ollama run xxx(任何一个模型)。

通过终端或者命令行,访问 http://127.0.0.1:11434 进行验证:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/696165

推荐阅读

相关标签