热门标签

热门文章

- 1自然语言处理中的语言模型预训练方法--ELMO_elmo有预训练模型吗?需要自己搭建模型然后训练吗?

- 2计算机视觉(六)目标检测算法汇总:R-CNN、Fast R-CNN、Faster R-CNN、YOLO、SSD_视觉检测算法

- 3ICML/ICLR‘22 推荐系统论文梳理_iclr2022录用论文

- 4知攻善防应急响应靶机训练-Web3_应急响应靶场web3

- 5Redis数据结构

- 6【数字设计】澜起科技_笔试题目分享_澜起科技面试试题

- 7[Git]-如何提交 Pull Request(PR)_git push request

- 8C# | 上位机开发新手指南(十)加密算法——ECC_c# ecc

- 9深度解析电脑屏幕监控软件的特点|五款电脑监控软件全面测评

- 10Android期末大作业校园图书馆图书借阅系统_安卓图书管理app源码

当前位置: article > 正文

(PYTHON)selenium+post请求批量获取小红书图片并备注_selenium 小红书

作者:IT小白 | 2024-06-23 21:50:36

赞

踩

selenium 小红书

引言

小红书是一个集社区和电商于一体的平台,用户可以分享各类生活经验和商品推荐。对于数据分析师和市场研究员而言,从小红书抓取图片和相关内容可以为研究提供丰富的数据资源。本文将介绍如何使用Python脚本从小红书抓取图片,并对这些图片进行处理和保存。

环境准备

首先,确保你的开发环境中已经安装了以下Python库:

selenium:用于模拟浏览器行为。beautifulsoup4:用于解析HTML和XML文档。requests:用于发起网络请求。PIL(Pillow):用于图像处理。

selenium确实有点慢,但有时候为了不处理加密用它也省很多事。

一些防止指纹检测的基本配置,没什么好说的,每次用都带上得了。

格式化保留关键词的位置,然后因为cookie有加密

脚本功能概述

本脚本的主要功能是:

- 使用Selenium打开小红书网站,并搜索特定关键词。

- 模拟用户滚动页面以加载更多内容。

- 使用BeautifulSoup解析页面,提取图片链接。

- 使用requests库下载这些图片,并保存到本地。

详细步骤解析

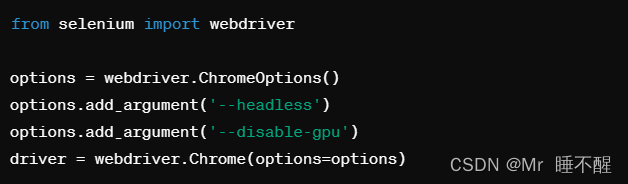

步骤1: 配置Selenium和WebDriver

首先需要配置Selenium的WebDriver,这通常涉及设置浏览器的参数,如是否以无头模式运行,以及如何处理网页上的图片加载等:

步骤2: 打开小红书并搜索关键词

通过Selenium打开小红书的搜索结果页面,输入用户提供的关键词:

步骤3: 页面滚动与数据加载

为了加载足够的内容,脚本将模拟用户滚动页面:

步骤4: 解析页面并提取图片链接

使用BeautifulSoup解析更新后的页面内容,并找出所有图片的链接:

步骤5: 下载并保存图片

提取到的链接将被用来下载图片,并使用PIL库保存到本地:

结论

通过本文的指导,你可以构建一个自动化工具来从小红书获取大量图片,这些图片可以用于后续的数据分析或机器学习项目。记得在使用爬虫技术时,要遵守目标网站的使用条款,合理合法地使用数据。

注意事项

- 需要考虑网站的反爬虫策略,合理设置请求频率和模式。

- 确保遵守数据的版权和隐私政策。

这篇文章提供了从小红书网站抓取图片的完整步骤和代码示例,可以帮助你开始你的数据采集项目。如果你有任何问题或需要进一步的帮助,请在评论区留言或直接联系我们。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/750820

推荐阅读

相关标签