热门标签

热门文章

- 1LeetCode刷题:字符串中的第一个唯一字符_已知s是字符串,则s0永远是字符串,第1位字符

- 2WIN7下运行hadoop程序报:Failed to locate the winutils binary in the hadoop binary path_failed to locate the winutis

- 3C语言枚举类型和联合体_c语言枚举类型实际上是int型吗

- 4AES加解密之C++实现_c++ aes加密解密

- 5使用Python进行自然语言处理(NLP):NLTK与Spacy的比较

- 6【Python】从基础到进阶:了解Python语言基础以及变量的相关知识

- 7关于分布式锁的几篇文章_分布式锁 论文

- 8Unity中使用Protobuf_unity protobuf

- 9探秘 PPet:一款强大的Python宠物框架,让开发更有趣

- 10Spring Cloud OAuth2 实现用户认证及单点登录_spring cloud2021 整合oauth2 单点登录

当前位置: article > 正文

信息熵的计算公式_知识卡片 信息熵

作者:IT小白 | 2024-06-27 21:52:11

赞

踩

数据底熵

前言:本文讲解了机器学习需要用到的信息论中关于信息熵的知识,并用代码演示如何计算信息熵和互信息。

信息熵 Information Entropy

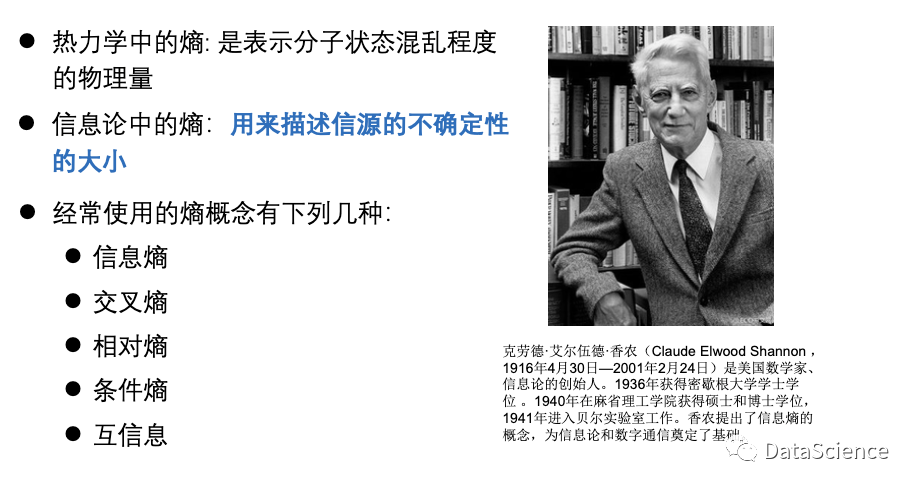

信息论中的熵(entropy)

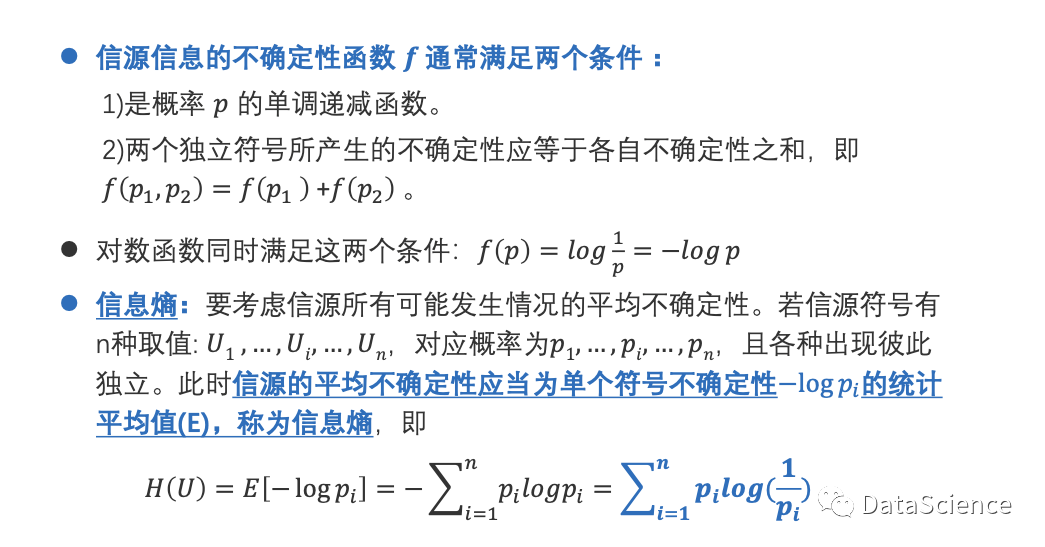

信息熵

log(1/p)的图像如下,是单调递减函数,不确定性越大,事件发生的概率越小。需要指出的是,H(U)式子中的对数是以2为底数,信息熵的单位是比特;在sklearn中,以自然对数e为底。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/763916

推荐阅读

相关标签