- 1ERROR: http://mirrors.aliyun.com/alpine/v3.9/community: temporary error (try again later) WARNING: I_from openjdk:8-jdk-alpine ignoring apkindex.2ac53f

- 2关于VMware的秘密,资深程序员聊天记录曝光

- 3美团/饿了么外卖CPS联盟返利公众号小程序核心源码代码_权益cps源码

- 4yum安装软件提示 cannot find a valid baseurl for repo:base/7/x86_64 的解决方法

- 5git远程分支强制覆盖本地分支_git 远程强制覆盖本地

- 6java项目之社区生活超市管理系统(ssm+mysql+jsp)

- 7mysql主从复制(一主一从)搭建(超详细)_一主一从在线

- 8『VulnHub系列』five86_1-Walkthrough_five86-2 is another purposely built vulnerable lab

- 9C语言数据结构--排序之直接插入排序、希尔排序、起泡排序、快速排序、简单选择排序和堆排序_利用随机函数产生50000个随机整数,分别用插入排序、希尔排序、起泡排序、选择排序

- 10Mac没有winnt格式_mac音频格式转换器哪个好?小编推荐这几款,总有一款适合你!...

【论文阅读】A CNN-transformer hybrid approach for decoding visual neuralactivity into text_acnn

赞

踩

题目:一种将视觉神经活动解码为文本的CNN-transformer混合方法

目录

The effects of different transformer layers

The effects of scaled positional encoding

The effects of 1D CNN in the feed-forward network

The effects of multi-layer connectivity

Comparison of decoding performance with different methods

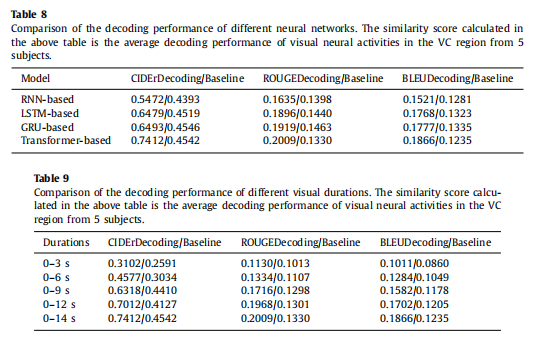

Comparison of decoding performance of different visual durations

Attention mapping of visual neural activities at different time points

Comparison of decoding performance of different visual regions

摘要

背景与目的:大多数研究利用语言刺激(如短语或句子)诱发的神经活动来解码语言结构。然而,与语言刺激相比,人脑通过自然图像等非语言刺激感知外部世界更为常见,因此仅依靠语言刺激无法完全理解人脑感知到的信息。为了解决这个问题,需要在非语言刺激引起的视觉神经活动和视觉内容之间建立一个端到端的映射模型。

方法:通过神经网络机器翻译中的transformer网络的成功和计算机视觉中的体积神经网络(美国有线电视新闻网)的启发,在此基础上构建一个端到端的美国有线电视新闻网transformer混合语言解码模型,以将由自然图像诱发的功能磁共振成像(fMRI)信号解码为关于视觉刺激的描述性文本。具体来说,该模型首先将两层一维CNN从多时间视觉神经活动中提取的语义序列编码为多层次抽象表示,然后逐步将该表示解码为英语句子。

结果:实验结果表明,解码文本在语义上与相应的基本真理注释一致。此外,通过改变编码和解码层,并对transformer的原始位置编码进行修改,我们发现在这项工作中需要ttransformer的特定架构。

结论:研究结果表明,该模型可以将自然图像诱发的视觉神经活动解码为以句子形式描述视觉刺激的文本。因此,它可能被认为是未来神经科学家了解人脑视觉信息处理的神经机制的潜在计算机辅助工具。

Introduction

神经科学的一个核心问题是如何读取人脑中编码的感知内容,即对神经活动的解码。通常,大脑解码是基于神经活动来恢复刺激信息[1]。在过去的几十年里,利用功能磁共振成像(fMRI)对大脑活动进行解码一直是一个热门话题[2,3]。早期,大多数研究侧重于基于分类的解码任务[4,5],该任务将诱发的功能磁共振成像反应中的特定刺激进行分类。此外,其他一些研究侧重于基于识别的解码任务[6,7],该任务识别了一种特定的刺激,解释了受试者大脑活动的模式。最近,深度学习的进展吸引了许多研究人员对人脑中存在的信息进行解码和可视化,即从视觉神经活动中重建视觉内容[8,9]。简而言之,基于功能磁共振成像数据的视觉刺激的分类、识别和重建已经取得了重大进展。

然而,随着大脑解码技术的深入发展,以单词或句子的形式对大脑活动中的语义内容进行解码已经成为神经科学家们研究的热点[10]。这里,我们称之为任务语言解码。这个解码任务是大脑阅读的直观和基础。特别是在脑机接口(BCI)中,如果语义内容可以从大脑活动中以单词或句子的形式解码,然后输入机器,就有可能实现脑机通信。传统的语言解码研究首先使用诸如短语[11]、感觉[12]和文本片段[13]等语言刺激来激活大脑皮层,然后使用解码模型从大脑活动中恢复语义和语法信息。然而,仅仅依靠语言刺激,人脑感知到的信息无法完全理解,因为人脑通过非语言刺激(如自然图像)感知外部世界更为常见。因此,在本文中,我们试图将非语言自然图像诱发的多时间视觉反应模式解码为关于视觉刺激的描述性文本。为了实现这一目标,我们利用视觉神经活动的句子形式的语义内容和神经机器翻译任务(NMT)之间的因果相似性来实现任务之间的相似性。从概念上讲,这两种情况的目标都是将源序列转换为目标序列。这两项任务之间的唯一区别是,NMT中的源序列来自自然语言,而语言解码中的源序列来自视觉神经活动。然而,神经机器翻译的体系结构直接从神经网络的数据中学习它们的特征,这表明神经机器翻译的学习算法也可以应用于语言解码[10 ]。尽管我们之前提出的PT-LDM[14]已经证明,通过采用两阶段训练策略,并将图像特征和功能磁共振成像特征作为输入,自然图像产生的视觉神经活动可以解码为语言,但PT-LDM每个训练阶段的训练目标是不一致的。每个训练阶段的训练目标可能会偏离解码模型的总体目标,因此训练后的解码模型很难最终达到最佳性能。因此,本文放弃了两阶段训练策略,试图建立一个端到端的语言解码模型,该模型只能以功能磁共振成像特征作为输入,直接学习视觉神经活动与语义内容之间的映射。此外,值得注意的是,随着最近自然语言处理(NLP)技术的发展,Transformer[15]在各种序列建模任务中取得了最新进展,如神经机器翻译[16]、文档生成[17]和问答[18]。然而,尽管基于转换器的体系结构代表了各种NLP任务的最新技术,但它们对大脑解码的适用性仍在很大程度上有待探索。主要原因可能是,现有功能磁共振成像数据的大小被认为不足以训练具有许多参数的复杂网络[19]。众所周知,大多数功能磁共振成像数据集仅限于几千个样本,因为一个人在核磁共振扫描仪上花费的时间是有限的[20]。因此,为了克服由于固有的训练数据不足而导致的过度拟合问题,在语言解码中需要特定的transformer结构。同时,随着计算机视觉(CV)的快速发展,卷积神经网络(CNN)已被证明是一种从低水平原始功能磁共振成像数据中学习特征的强大方法[21]。

在这里,我们提出了一个端到端的CNN Transformer混合语言解码模型,以研究自然图像诱发的多次视觉响应模式是否可以解码为以句子形式描述视觉刺激的文本。通过计算由我们的模型生成的解码文本与相应的基础真相注释之间的相似性,我们证明了解码文本与相应的基础真相注释在语义上是一致的。此外,通过修改转换器的体系结构,我们发现在语言编码中需要特定的转换器体系结构。此外,为了证明我们提出的解码模型的优势,我们比较了不同方法的解码性能。此外,为了研究功能磁共振信号的时间依赖性和注意映射,我们比较了不同视觉持续时间的解码性能,并评估了功能磁共振信号在不同时间点的注意权重。最后,为了理解不同视觉区域在大脑解码中的作用,我们还比较了不同视觉区域的解码性能。

Methods

在这里,提出了一种端到端CNN-transformer混合语言解码方法,将自然图像诱发的多时间响应模式解码为有关视觉刺激(自然图像)的描述性文本。如图1所示,所提出的CNN-transformer混合解码模型的整体图遵循编码器-解码器范式。首先,两层一维CNN将多时间视觉神经活动映射为低维语义特征;然后,Transformer的编码器将语义特征编码为多级抽象表示;最后,Transformer的编码人员通过我们的多层连接,一步一步地将这种表示解码为关于视觉刺激(自然图像)的描述性文本。在这项工作中,我们的见解是利用1D CNN和Transformer的优势:(1)使用1D CNN从含噪声的高维视觉神经活动中提取低维语义特征;(2) 使用Transformer学习parallel中的多级语义概念。接下来,我们将详细描述所提出的lan语言解码模型的每个组件。

Two-layer 1D CNN

我们使用两层一维CNN从低水平原始功能磁共振成像数据中提取低维均值语义特征。给定14个视觉反应模式fi(维度:2000),CNN将视觉神经活动映射到视觉神经活动的14个语义特征(维度:256),如下所示:

![]()

其中CNN代表两层卷积神经网络。

Transformer

transformer[15]的目的是将语义特征映射到文本句子。具体而言,编码器首先将合并特征(x1,…,xn)的输入序列映射到隐藏的表示(h1,…,hn)。给定(h1,…,hn),解码器然后一次生成一个元素的字符输出序列(y1,…,ym)。接下来,我们将在以下章节中描述transformer的核心模块。

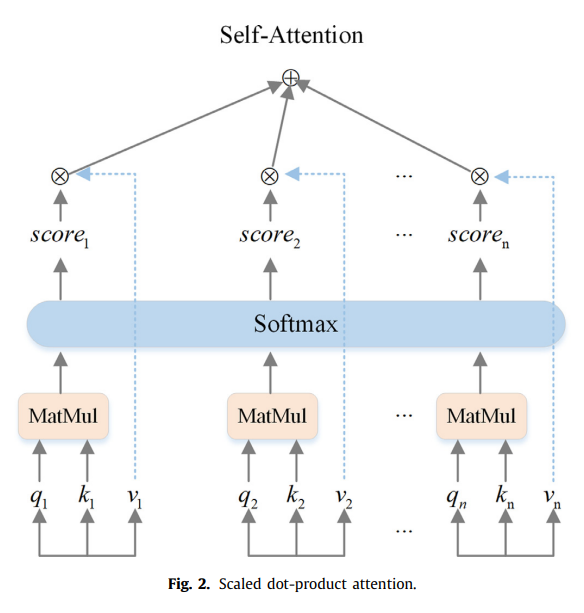

Scaled dot-product attention

自我注意,一种学习句子中单词依赖关系并捕捉句子内部结构的机制。如图2所示,输入由维度dk的查询(Q=q1,q2,…,qn)和键(K=k1,k2,…,kn)以及维度dv的值(V=v1,v2,…,vn)组成。14分(scorei,i=1,2,…,14)表示14秒视觉神经活动的自我注意权重,其中![]() 。我们计算输出自我关注的输出如下[15]:

。我们计算输出自我关注的输出如下[15]:

![]()

其中比例因子![]() 用于防止softmax功能进入坡度非常小的区域。

用于防止softmax功能进入坡度非常小的区域。

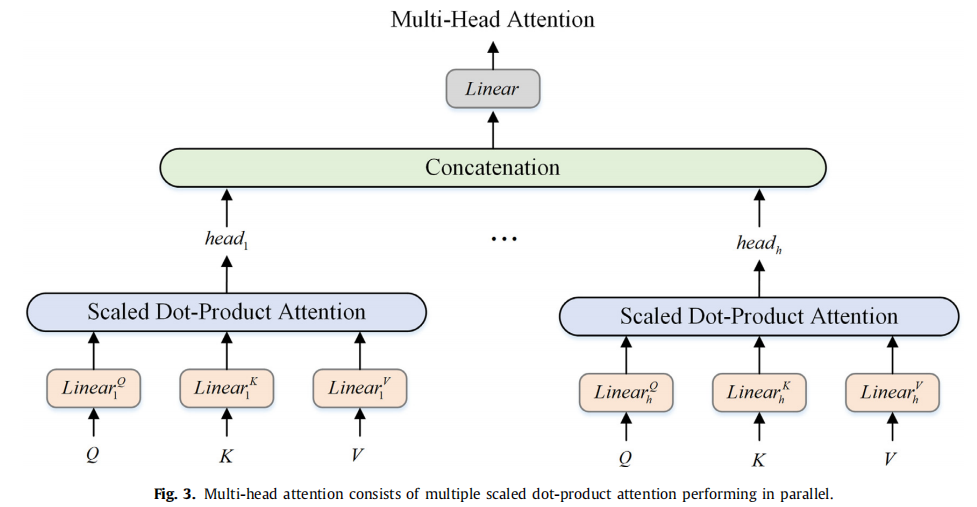

Multi-Head attention

多头注意是transformer的核心模块,它允许模型共同关注来自不同位置的不同代表子空间的信息。如图3所示,多头注意力计算h乘以缩放的点积注意力,其中每个缩放的点积注意力都可以计算出来,以获得相应的头部。在执行每个缩放点产品注意之前,有三个线性投影分别将查询(Q)、键(K)和值(V)转换为更具辨别力的表示。然后,将每个头部连接起来并输入另一个线性投影,以获得多头部注意的最终输出。整体公式如下[15]

其中参数矩阵![]() ,

,![]() ,

,![]() 和

和![]() ,, i = 1, ..., h,dk = dv = d mod el/h贯穿全文。dmod el表示变压器中所有子层的隐藏尺寸,h表示磁头数。dk表示查询和键的隐藏维度。dv表示值的隐藏维度。

,, i = 1, ..., h,dk = dv = d mod el/h贯穿全文。dmod el表示变压器中所有子层的隐藏尺寸,h表示磁头数。dk表示查询和键的隐藏维度。dv表示值的隐藏维度。

Multi-Layer connectivity

我们不再只关注编码器中最后一个编码层的输出,而是对编码器中所有编码层的输出执行多层连接。多层连接如图1所示。对于编码器,第i个编码层的输出Hi通过消耗输出Hi来计算− 1 com,由编码层i-1计算。每个编码层将产生一个输出,然后我们可以得到多级表示H(H1,…,HN),即编码器中所有编码层的输出集。对于解码器,通过消耗由编码器中的所有编码层计算的输出H(H1,…,HN)和输出Oi来计算第i解码层的输出Oi− 1由解码层i-1计算。与编码器中的标准注意机制不同,注意机制attention Multi− 解码器中具有多层连接的层被计算为N个标准注意机制注意(Q,K,V)的加权和,如下[22]:

其中,αi表示从先前解码器模块的输出Z和第i编码层的输出Hi计算出的标准注意机制注意(Q,K,V)的权重,Q=WqZ,K=WkHi,V=WvHi。[,]表示串联,σ是S形函数,Wq、Wk、Wv、Wi和bi是可学习的权重。

Feed-Forward networks

与原transformer前馈网络中的两层全连接网络不同,在该网络中,我们使用了一个两层1D卷积网络,中间有一个重新激活函数。

![]()

其中隐藏维度d mod el=256,内层维度dff=512。

Scaled positional encoding

如图1所示,为了利用序列的顺序,根据以下公式[15]将关于输入序列的相对或绝对位置的信息注入输入向量:

其中,pos是输入向量的时间步长索引,i是维数,PE是位置编码矩阵。位置编码矩阵PE的维数与输入向量相同,因此可以将两者相加。

与[23]类似,考虑到在语言解码中,源序列来自大脑中的视觉神经活动,而目标序列来自自然语言,因此使用固定位置嵌入可能会对解码模型施加严重约束,导致解码性能差。为了调整编码器和解码器在各自空间中的位置嵌入,我们使用两个不同的可训练位置权重λ和η来调整位置编码矩阵PE的比例。编码器席的输入向量和DE编码器Ii的输入向量计算如下:

其中λ和η为可训练位置权重。席是由两层1D美国有线电视新闻网网络从原始fMRI信号中提取的特征,Y i是由嵌入层从地面实况注解中提取的目标特征。N和M分别是语义特征席损坏的时间步长和目标特征Y i。席和易分别是编码器和解码器的输入向量。PE(i)表示位置编码矩阵PE的第i行。

Implementation details

Architectures

我们模型的架构如图1所示。对于编码器,它由N个相同的层堆叠。每层有两层子模块:第一个是多头自我注意机制,第二个是前馈网络,由两层1D卷积网络组成,中间有一个ReLU激活函数。与编码器一样,解码器由N个相同的层堆叠。每一层都有三个子模型:第一个是蒙面多头自我注意机制,它确保位置i的预测只能依赖于位置小于i的已知输出;第二种是具有多层连通性的多头注意力机制,第三种是由两层1D卷积网络组成的前馈网络,网络之间有一个ReLU激活函数。在编码器和解码器中,屏蔽的多头自注意机制、多头注意机制和前馈网络都包含残余连接和层规范化。值得注意的是,我们还为编码器和解码器的每一层添加了一层规范化,因为这种方法已被广泛证明是加速模型收敛的有效方法[24,25]。

Hyperparameter tuning

我们使用SGD优化器对我们的模型进行了300个阶段的训练,其中变压器层N=3,学习率为0.08。我们使用softmax交叉熵作为所提出的解码模型的损失函数。超参数d mod el设置为256,超参数h设置为8,超参数dk=dv=32。

Runtime

由于没有递归神经网络,所提出的解码模型可以并行训练。在我们的实验中,我们的CNN、Transformer混合语言解码模型使用单个NVIDIA GeForce 1080 Ti在大约30分钟内完成了训练。

Results

Datasets

我们使用了来自功能磁共振成像实验的数据,其中视觉刺激由2750张自然图像组成,这些图像是从ImageNet的五个类别中随机选择的[26]。这些自然图像来自五个类别,即“马”、“建筑”、“花”、“水果”和“景观”,每个类别有550个图像。本研究重复了我们之前研究[14,27]中进行的实验、心理范式、数据采集和预处理。

实验范式:进行了两种类型的实验来测量自然图像诱发的视觉神经活动,即视杆视网膜主题映射实验和视觉刺激实验。通过视网膜主题映射实验,将视皮层细分为V1、V2、V3、下视皮层视觉区域(LVC)、高水平视皮层(HVC)和整个视皮层(VC)[28]。LVC被定义为V1、V2和V3的组合区域。HVC被定义为从VC移除LVC后留下的区域。主题映射实验包括四次重复运行,每次运行176次试验。每个刺激试验都会闪现2秒,然后是下一个刺激试验。在每次跑步的开始(12秒)和结束(12秒)增加额外的休息时间。每次酒吧跑步持续6分钟16秒。视觉刺激实验是记录五名受试者在MRI设备上观看自然图像时的视觉神经活动。在视觉刺激实验中,每次跑步有50次刺激试验。在每项试验中,一幅自然图像闪烁2秒,然后是随机的4-8秒休息时间。在每次跑步的开始(12秒)和结束(8秒)增加额外的休息时间。共执行了55次,共2750张自然图像。在图像刺激出现后,通过功能磁共振成像测量14秒的视觉活动,每个视觉区域的体素数量统一为2000。

数据采集:MRI数据由中国科学院生物物理研究所的3-T Prismafit扫描仪使用20通道头颈线圈采集。一种交织多带T2∗-进行加权梯度回波EPI(梯度回波平面成像)扫描以获得功能图像。使用T1加权磁化制备的快速获取梯度回波(MP-RAGE)序列获取结构图像。

数据预处理:对每次运行的前12秒扫描进行分类,以避免MRI扫描仪不稳定。我们使用SPM8[29]对剩余数据执行切片定时校正和三维头部运动校正。然后将这些数据共同记录到切片的高分辨率解剖图像中,然后重新插入到3×3×3mm体素中。

一般来说,我们的数据集由2750个样本组成,每个样本包含一幅自然图像和相应的五个精确描述(由五名注释者描述)以及五名受试者的五个视觉神经活动。每个视觉神经活动都是一个14×2000(时间×体素)的矩阵。我们随机选取2500个样本作为训练集,剩下的250个样本作为测试集。

Decoding evaluation index

按照图像标题[30]或机器翻译[15]中的标准评估协议,我们选择了双语评估、derstudy(BLEU)[31]、以回忆为导向的替补评估(ROUGE)[32]和基于共识的图像描述评估(CIDEr)[33]来进行相似性评估。BLEU、ROUGE或CIDEr的分数越大,给定的两个文本在语义上就越相似。总的来说,我们在所有实验中计算了每个评价指标的两个相似性分数。第一个分数代表我们的解码模型获得的实际解码性能,该模型计算解码文本和测试集中相应的基本真相注释的相似性,第二个分数代表用作基线的随机解码性能,它计算测试集中解码文本和训练集中地面真相注释的相似性。

The decoded texts

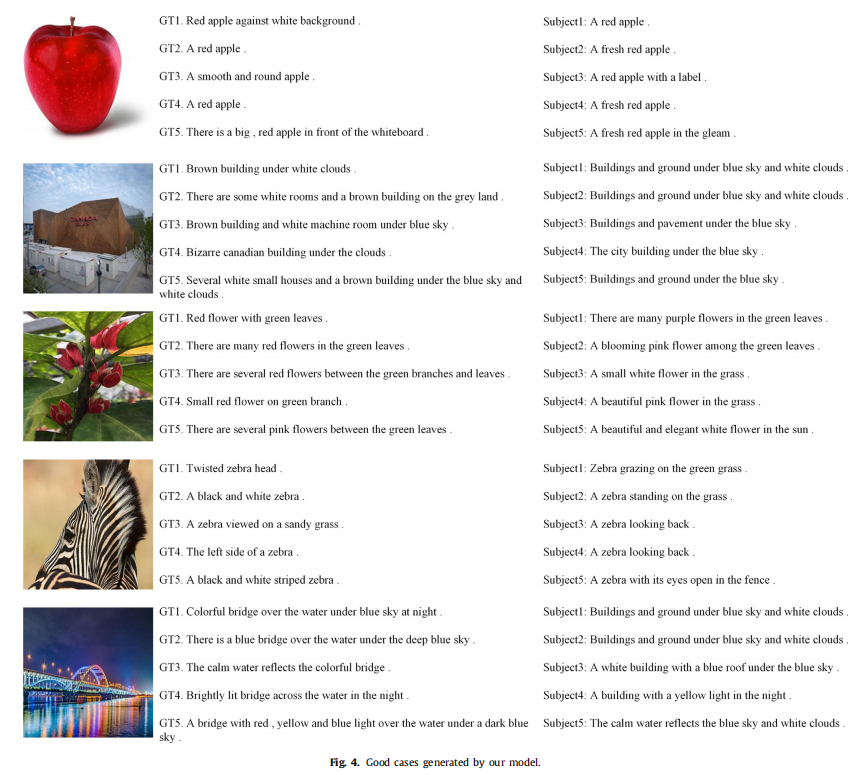

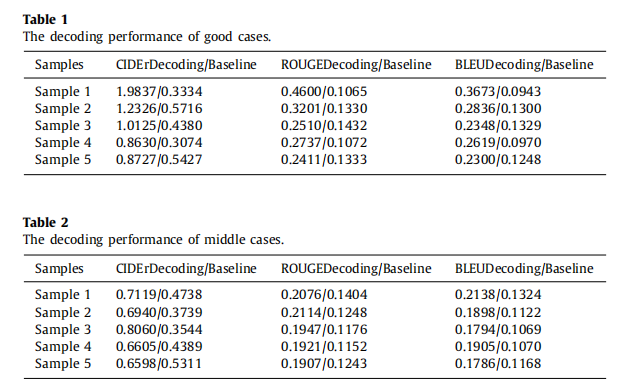

图4、图5和图6分别显示了解码结果中的好案例(五个样本)、中案例(五个样本)和坏案例(五个样本)。这些图中的每个样本结果都包含一幅来自我们之前工作[27]的自然图像、五个人类注释的基本事实,以及五个解码模型从五个主题生成的五个解码文本。此外,表1、表2和表3分别对好案例、中案例和坏案例的装饰性能进行了分析。通过应用三个评价指标(苹果酒、胭脂和BLEU),我们计算了测试集中解码文本的平均分数。苹果酒、胭脂和BLEU的平均得分分别为0.7412、0.2009和0.1866,这代表了平均解码性能。

如图4所示,解码文本(好的情况)几乎在语义上与相应的注释文本一致。此外,根据表1的计算,三个良好案例的评估指标的平均得分分别为1.1929、0.3092和0.2755,显著高于平均解码性能。直观地说,所提出的解码模型显示了自动组织视觉对象概念的能力,并隐式地学习大脑活动与描述性文本之间的关系。

为了了解提出的解码模型的整体解码性能,我们提供了几个代表平均解码性能的样本(中间情况)。如图5所示,除个别样本外,解码文本基本上与相应的注释文本在语义上一致。此外,根据表2的计算,中间案例的三个评估指标的平均得分分别为0.7064、0.1993和0.1904,接近平均编码性能。这一结果验证了我们提出的模型生成的解码文本的有效性。

为了研究所提出的解码模型的局限性,我们还提供了几个代表较差解码性能的样本(坏情况)。如图6所示,解码文本在语义上与相应的注释文本不一致。此外,根据表3的计算,中间案例的三个评估指标的平均得分分别为0.5507、0.1435和0.1297,显著低于平均装饰性能。这一结果表明,这些不良案例的局限性主要表现在难以区分不同的视觉对象、颜色和数量。

The effects of different transformer layers

尽管原始配置的转换器已成功应用于各种自然语言处理任务,但考虑到功能磁共振成像数据和文本的语义复杂性可能不一致,我们推测在语言解码中可能需要特定的配置。因此,我们评估了编码器和解码器层数对解码性能的影响。从表4中,我们观察到,与其他配置相比,使用三个编码层和三个解码层时,所有评估指标的解码性能都有显著改善(配对T检验,p<0.05),这导致五名受试者的平均年龄分数为0.7412苹果酒、0.2009胭脂和0.1866 BLEU。我们假设,这是由于训练集的大小减小,以及语言解码中视觉活动相对于这些语言中处于站立状态的文本的语义复杂性降低。根据这一发现,我们将在所有后续实验中使用三个编码层和三个解码层。

The effects of scaled positional encoding

为了验证在变压器中使用缩放位置编码代替原始固定位置编码的有效性,我们比较了缩放位置编码的解码性能,变压器的位置编码和原始固定位置编码。表5显示,与变压器的原始位置编码相比,缩放位置编码可以实现更高的解码性能,尤其是对于苹果酒指数(配对T检验,p<0.05)。我们推断这是因为可训练的位置权重可以放松对变压器的约束,从而使编码器和解码器能够在各自的空间中表现出更好的性能。

The effects of 1D CNN in the feed-forward network

为了评估将一维CNN应用于编码器和解码器的效果,我们重新设计了一个包含两层一维CNN的前馈网络(FFN)。从表6中,我们观察到1D CNN对原始变压器中致密层的解码性能产生了显著的积极影响(配对T检验,p<0.05)。我们推断这是因为1D CNN中存在的滑动窗口机制能够更好地聚集相邻特征,从而获得更好的解码性能。

The effects of multi-layer connectivity

为了验证多层连接的有效性,我们还评估了多层连接的解码性能。如表7所示,与使用原始变压器中最后一个编码器层的输出相比,使用多层连接方法可以显著提高解码性能(配对T检验,p<0.05)。这一结果表明,编码器的每个编码层都对语义特征进行了一定程度的编码,可以用来提高解码性能。

Comparison of decoding performance with different methods

为了证明所提出的基于变压器的解码模型在解码任务中的优势,我们比较了基于递归神经网络(RNN)、长短时记忆网络(LSTM)、选通递归单元(GRU)和变压器的解码模型的去编码性能。基于GRU的方法源自我们最近提出的PT-LDM[14],它采用了两阶段训练策略。在训练的第一阶段,PT-LDM将图像编码器提取的图像特征与功能磁共振成像编码器提取的功能磁共振成像特征相结合,并通过GRU解码器将视觉神经活动解码为文本;在训练的第二阶段,图像编码器被丢弃,PT - LDM仅使用功能磁共振编码器提取的功能磁共振特征,通过GRU 解码器将视觉神经活动解码为文本。这三种方法(基于RNN、LSTM和GRU)之间的唯一区别是使用不同的神经网络(RNN、LSTM和GRU)作为各自的解码器。基于RNN和基于LSTM的方法的训练策略与基于GRU的方法相同。从表8可以看出,我们基于变压器的方法的去编码性能显著(配对T检验,p<0.05)高于其他三种方法。

Comparison of decoding performance of different visual durations

正如[39]指出的,在特定的解码任务中可能需要特定的配置,我们试图评估变压器不同配置的解码性能。

首先,我们研究了编码器和反编码器层数对解码性能的影响。如表4所示,具有三个编码层和三个解码层的Trans former比其具有六层的原始配置实现了更高的解码性能。一般来说,在深度学习中,具有更多/更少网络层或模型参数的模型可以被视为具有更高/更低复杂度的神经网络,反之亦然。此外,高复杂度的神经网络通常在有限的训练数据集上存在过拟合问题[40],这将导致模型在训练集上表现良好,但在测试集上表现不佳。在深度学习中,我们通常可以使用网络缩减[41]或层裁剪[22]来解决过度拟合的问题。这些方法的实质是减少网络结构或模型参数,降低模型的复杂度,从而解决过拟合问题,最终获得更高的测试精度。然后,我们研究了我们采用的缩放位置编码的解码性能,该编码在编码器和解码器中使用可训练的位置权重来调整转换器的原始位置编码矩阵PE的缩放,以便编码器和解码器都可以在其域中学习合适的位置嵌入。如表5所示,与变压器的原始固定位置编码相比,缩放位置编码实现了更高的解码性能。我们认为这是因为缩放位置编码可以有效地放松变换器固定位置层叠对解码模型的约束,使位置信息更适合不同的语义空间,从而获得更好的解码性能。这个假设是合理的,因为源序列来自人脑中的视觉神经活动,而目标序列来自自然语言。固定位置嵌入的使用将在一定程度上对解码模型施加严重限制,这与之前的研究一致[23]。接下来,我们还探讨了前馈网络中的一维卷积网络对解码性能的影响。如表6所示,两层1D卷积网络比两层全连接网络具有更好的解码性能。事实上,正如之前的调查[42]所示,变压器中相邻的隐藏状态密切相关。然而,由于固有的计算方法,全连通层包含大量冗余信息,因此无法很好地提取序列的相邻语义特征。相比之下,进化神经网络(CNN)被证明是从功能磁共振成像数据中学习特征的有效方法,因为其固有的滑动窗口机制可以聚集相邻的特征[43,44]。因此,与两层完全连通层相比,两层1D卷积网络提取的语义特征在一定程度上包含了序列的更多相邻语义特征,从而实现了更好的解码性能。最后,与大多数基于转换器的模型[16–18]相比,在训练过程中只考虑最后一个编码层的输出,我们的模型通过采用多层连接方法来利用每个编码层的输出,该方法可以学习语义特征之间关系的多层次表示。如表7所示,当采用多层连接方法时,反编码性能可以显著提高。这一结果证实了每个编码层都能在一定程度上为语言解码提供潜在的语义信息。同时,这种多层连接性方法在一定程度上缓解了由较小的功能磁共振成像数据集引起的过拟合问题,因为它有效地利用了变压器编码器中编码的多级语义特征,这相当于一种用于解决过拟合问题的数据增强[41]方法。这些实验结果表明,通过找到合适的变压器方程组,可以提高译码性能。(2.1)–(2.9).

此外,为了研究所提出的解码模型是否可以利用时间依赖性来提高解码性能,我们比较了不同视觉持续时间(0-3、0-6、0-9、0-12和0-14s)的解码性能。表9的结果表明,0-14秒的视觉神经活动比较短时间的活动(0-3、0-6、0-9和0-12秒)具有更高的解码性能。一个可能的原因是,与其他较短时间的视觉活动相比,0–14s视觉神经活动包含的语义信息最多,因为它涵盖了从视觉刺激物出现到最强反应的整个时间过程。这一结果证明,所提出的译码模型可以充分利用时间相关性来提高译码性能。因此,通过建立适当的解码模型,充分利用神经活动的时间依赖性,可以提高解码性能。此外,鉴于功能磁共振成像信号是时间依赖性的,我们研究了解码过程中不同时间点视觉神经活动的贡献。图7的实验结果表明,不同时间点的视觉神经活动对解码过程的影响不同,最大的自我注意权重分布在第六个时间点附近。

我们的研究结果表明,视觉神经活动在一定程度上可以被视为一种抽象的大脑语言,通过建立语义内容与视觉神经活动之间的映射模型,可以将其编码为自然语言。我们的解码技术可以帮助更好地理解人脑的功能,找到脑机接口(BCI)的实用解决方案,或者开发精神疾病诊断技术。在脑机接口中,这种解码技术可以用来将大脑活动转化为计算机可以处理的信息,从而实现人脑和机器之间的通信。更重要的是,一旦大脑能够与计算机通信,计算机就可以依靠强大的通信能力来学习和模拟人脑的神经机制,最后,计算机可以像人脑一样思考,这也是人工智能的目标。此外,在精神疾病的临床诊断中,这种解码技术也有望通过解码视觉区域的神经信息来诊断人类大脑的视觉神经区域在面对外部刺激时是否受到阻碍。虽然我们的解码技术已经通过构建大脑解码模型取得了有希望的结果,这些模型是用单个受试者的功能磁共振数据训练的,准确解码(区分不同视觉对象、颜色和数量的能力)仍然具有挑战性,因为仅从单个受试者获取的功能磁共振成像数据具有一些不利特征,例如小样本、噪声性质和高维性[48]。最近的一些大脑解码方法[49,50]表明,提取多学科功能磁共振成像数据共享的潜在表征可以提高解码性能。因此,在我们未来的工作中,就像[39]为基于分类的解码提供了基线一样,我们将尝试研究受试者之间的关系,并利用从多受试者功能磁共振成像数据中获得的共享信息,开发一种通用解码方法,作为语言编码的基线

Conclusion

解码模型,使将自然图像诱发的视觉神经活动解码为有关视觉刺激的描述性文本成为可能。大量的分析证明了我们提出的CNN变压器混合解码模型的有效性。我们有希望的结果表明,人脑在视觉感知中的活动可以被解码并应用于自动匹配的视觉内容生成。未来,这种基于变压器的语言解码技术将帮助言语障碍者表达他们眼中看到的东西,甚至有望成为神经科学家了解人脑视觉信息处理神经机制的潜在计算机辅助工具。我们希望我们的工作能够激励更多的神经科学家探索大脑解码领域,这对促进神经科学的发展起着关键作用。