- 1【代码随想录训练营】【Day 41】【动态规划-1 and 2】| Leetcode 509, 70, 746, 62, 63

- 2拼写单词_有一个字符串数组words和一个字符串chars。 假如可以用chars中的字母拼写出words

- 3植物大战僵尸中文版修改器python实现_植物大战僵尸main修改

- 4给定平面上的n个点,求最多有多少个点共线_如何求共线次数

- 5失败了n次以后,我总结了5种Python爬虫伪装技巧!_python爬虫伪装成浏览器

- 6Java——TCP/IP超详细总结

- 7js日历库_js 计算日历的库

- 8【C/C++ 数据结构 】线索二叉树全解析:从数学原理到C++实现_索二叉树的应用场景 线索二叉树在需要频繁进行中序遍历的场景下非常有

- 9循环队列的定义,入队算法,出队算法,遍历算法,及其代码实现_循环队列入队和出队算法

- 10数据库课程设计(医院数据库系统)_医院管理系统数据库设计

Ollama在Windows11部署与使用QWen2模型_利用ollma部署qwen2

赞

踩

0,Ollama介绍

Ollama是一个开源项目,旨在让用户能够轻松地在其本地计算机上运行大型语言模型(LLM),是一个开源的大型语言模型服务。它支持各种LLM,包括Llama 3、Mistral和Gemma。提供了类似OpenAI的API接口和聊天界面,可以非常方便地部署最新版本的GPT模型并通过接口使用。支持热加载模型文件,无需重新启动即可切换不同的模型。

Ollama官网:https://ollama.com/

模型库:https://ollama.com/library

GIthub地址:https://github.com/ollama/ollama

1,下载与安装

访问Ollama官网,点击【Download】按钮进入下载页面,选择Windows版本下载

下载后直接运行安装包,进行安装

软件本身是没有图形化界面的,需要用终端运行,以Windows PowerShell为例,运行下面的指令进行测试

ollama list

其他常用命令:

- ollama serve 启动ollama

- ollama create 从模型文件创建模型

- ollama show 显示模型信息

- ollama run 运行模型

- ollama pull 从注册表中拉取模型

- ollama push 将模型推送到注册表

- ollama list 列出模型

- ollama cp 复制模型

- ollama rm 删除模型

- ollama help 获取有关任何命令的帮助信息

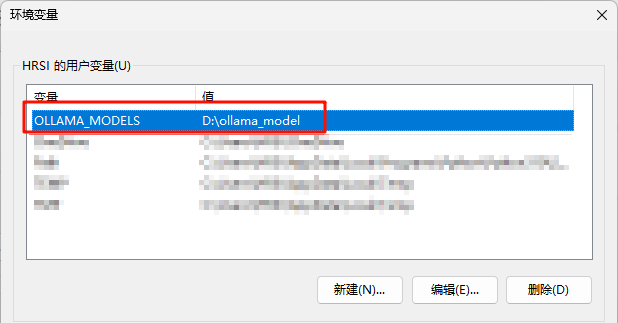

2,更改模型保存路径

默认的模型保存路径位于C盘,(C:\Users<username>.ollama\models),可以通过设置OLLAMA_MODELS进行修改,然后重启终端,重启ollama服务(需要去状态栏里关掉程序)

setx OLLAMA_MODELS "D:\ollama_model"

我们可以去电脑环境变量中查看是否改变成功

3,下载大模型

访问模型库,找到需要的模型,比如我打算使用qwen2,点进去可以选择参数量,以及查看模型介绍

比如我要下载qwen2的0.5B参数模型,在终端运行

ollama run qwen2:0.5b即可自动开始下载和加载

4,测试模型

直接在终端交流

至此,在Windows本地部署Ollama并运行qwen2模型已经完成,如果需要Web或者客户端支持,可以查看GitHub里的推荐

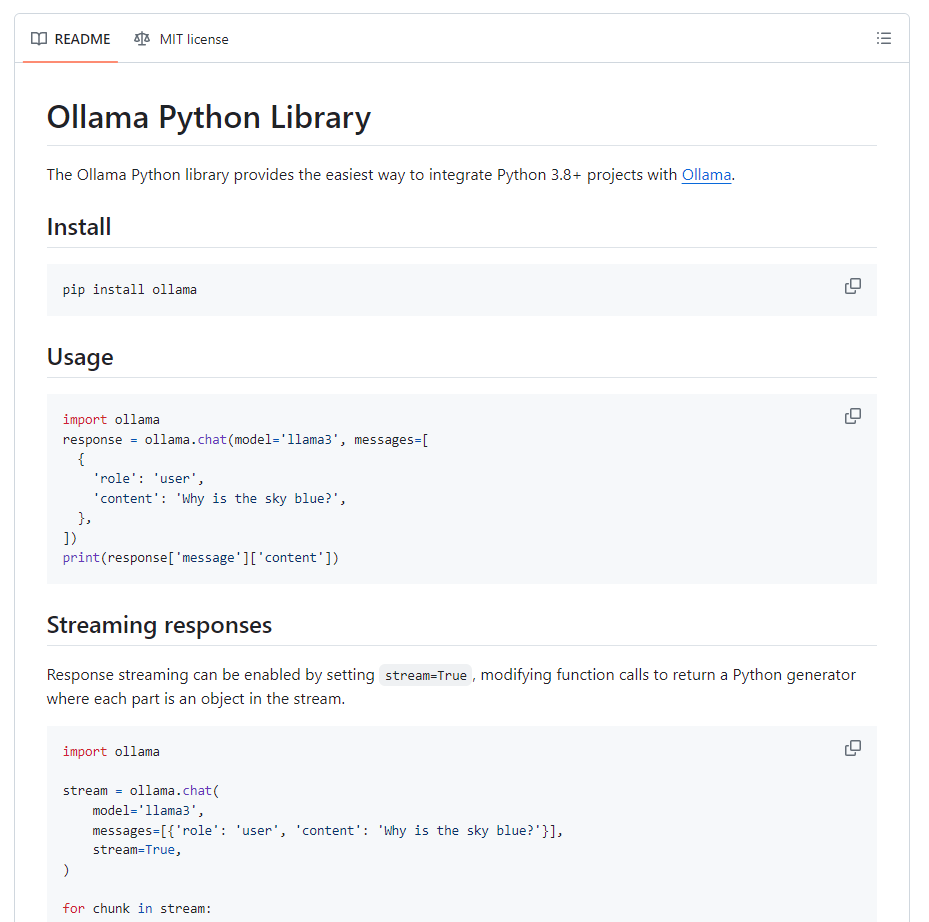

5,Ollama Python库

访问GitHub:GitHub - ollama/ollama-python: Ollama Python library

有详细的教程,关于如何用Python调用本地的Ollama