热门标签

热门文章

- 1基于JavaGUI+SqlServer的高校科研管理系统_某高校科研管理系统sql

- 2眼见不一定为实之MySQL中的不可见字符_mysql 不可见字符

- 3Apache doris使用问题记录_doris写入数据非常慢

- 4推荐一款开源差异比较和合并工具:WinMerge

- 5【Python数据增强】图像数据集扩充

- 6TortoiseGit 记住用户名和密码的方法_git如何在设置保存密码

- 7第二天运行项目 报错 import fitz not module named ‘frontend’_fitz frontend

- 8总结100+前端优质库,让你成为前端百事通

- 9期末救命-大数据技术原理及应用(林子雨版)(巧记知识点)_大数据对科学研究的影响有4种范式

- 10基于Django+Vue前后端分离环境监测数据分析可视化设计-计算机毕业源码设计_监控系统 vue django

当前位置: article > 正文

ollama模型CPU轻量化部署_ollama cpu

作者:Li_阴宅 | 2024-07-19 23:32:14

赞

踩

ollama cpu

一、定义

- ollama 定义

- 环境部署

- demo

- 加载本地模型方法

- 基本指令

- 关闭开启ollama

- ollama 如何同时 运行多个模型, 多进程

- ollama 如何分配gpu

- 修改模型的存储路径

二、实现

- ollama 定义

ollama 是llama-cpp 的进一步封装,更加简单易用,类似于docker.

模型网址:https://www.ollama.com/

部署网址:https://github.com/ollama/ollama

教程:https://github.com/ollama/ollama/releases - 环境部署

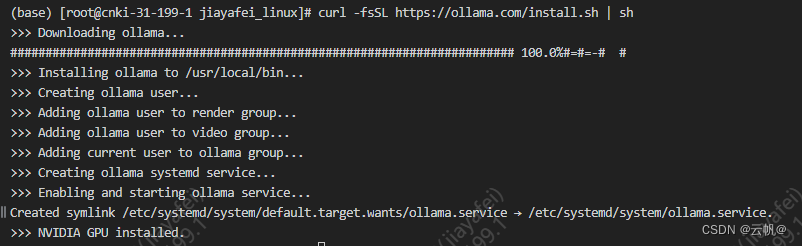

1. 宿主机安装

curl -fsSL https://ollama.com/install.sh | sh

curl http://localhost:11434 已经启动。

远程访问配置:

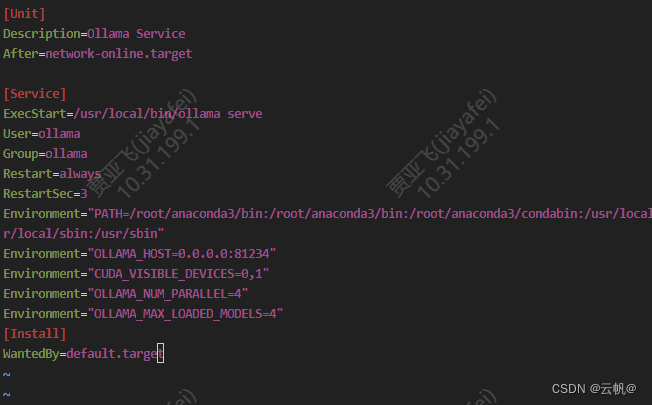

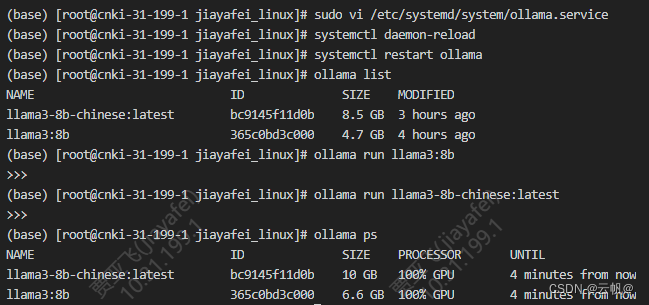

>>sudo vi /etc/systemd/system/ollama.service

对于每个环境变量,在 [Service] 部分下添加一行 Environment:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

保存并退出。

重新加载 systemd 并重新启动 Ollama:

>>systemctl daemon-reload

>>systemctl restart ollama

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

2. docker 模式安装

https://hub.docker.com/r/ollama/ollama

docker pull ollama/ollama

cpu:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

gpu:

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

- 案例

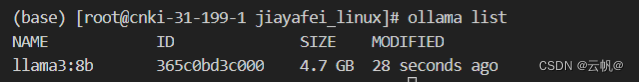

1.加载模型/运行模型

ollama pull llama3:8b

- 1

2. 调用模型

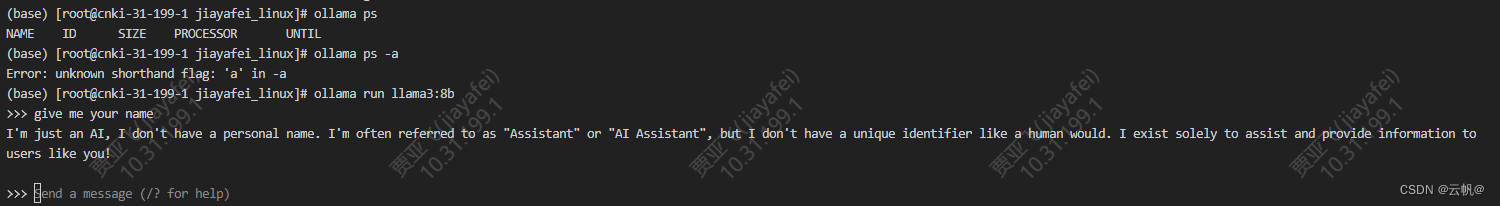

方式一、指令交互的方式进行调用

>>ollama run llama3

- 1

方式二、api 接口调用

curl http://localhost:11434/api/generate -d '{

"model":"llama3:8b",

"prompt": "请分别翻译成中文 -> Meta Llama 3: The most capable openly available LLM to date",

"stream": false

}'

- 1

- 2

- 3

- 4

- 5

方式三、 python 接口调用

pip install ollama-python

import ollama

response = ollama.run('llama3:8b', '你好,世界!')

print(response)

- 1

- 2

- 3

- 4

from openai import OpenAI client = OpenAI( base_url='http://localhost:11434/v1/', # 必需但被忽略 api_key='ollama', ) chat_completion = client.chat.completions.create( messages=[ { 'role': 'user', 'content': 'Say this is a test', } ], model='llama2', )

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 加载本地模型方法

具体看 官网

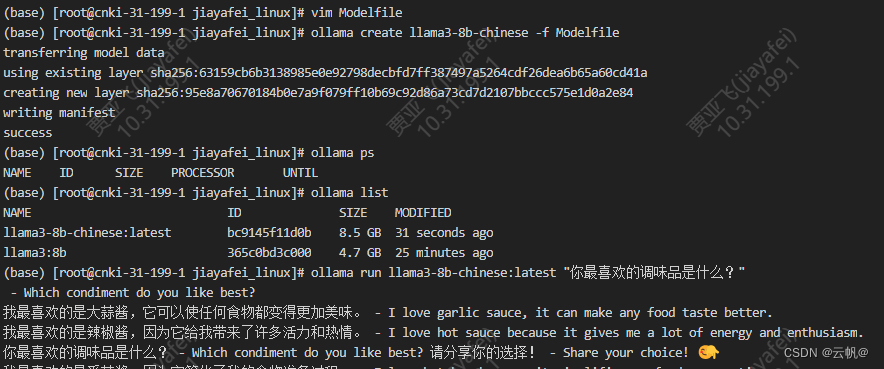

4.1 gguf 模型

1. 编写Modelfile 文件

FROM ./mistral-7b-v0.1.Q4_0.gguf

2. 创建模型

ollama create llama3-8b:0.001 -f Modelfile

3. 运行/ 测试

ollama run example “你最喜欢的调味品是什么?”

- 基本指令 : 和docker 指令类似,基本重合

journalctl -u ollama 查看日志

journalctl -n 10 查看最新的10条日志

journalctl -f 实时查看新添加的日志条目

- 1

- 2

- 3

ollama -h (base) [root@cnki-31-199-1 jiayafei_linux]# ollama -h Large language model runner Usage: ollama [flags] ollama [command] Available Commands: serve Start ollama create Create a model from a Modelfile show Show information for a model run Run a model pull Pull a model from a registry push Push a model to a registry list List models ps List running models cp Copy a model rm Remove a model help Help about any command Flags: -h, --help help for ollama -v, --version Show version information

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

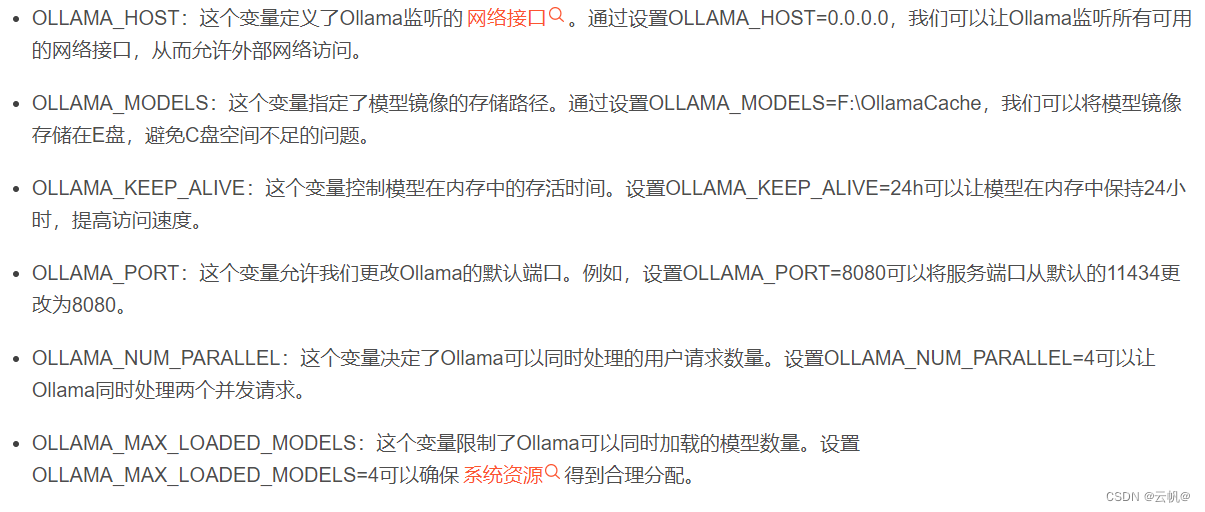

- ollama 如何同时 运行多个模型, 多进程

vim /etc/systemd/system/ollama.service

[Service]

Environment="OLLAMA_NUM_PARALLEL=4" #并行处理请求的数量

Environment="OLLAMA_MAX_LOADED_MODELS=4" #同时加载的模型数量

sudo systemctl daemon-reload

sudo systemctl restart ollama

加载一个模型

ollama run gemma:2b

加载另外一个模型

ollama run llama3:8b

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

7. ollama 如何分配gpu

本地有多张 GPU,如何用指定的 GPU 来运行 Ollama? 在Linux上创建如下配置文件,并配置环境变量 CUDA_VISIBLE_DEVICES 来指定运行 Ollama 的 GPU,再重启 Ollama 服务即可【测试序号从0还是1开始,应是从0开始】。

$sudo vi /etc/systemd/system/ollama.service

[Service]

Environment="CUDA_VISIBLE_DEVICES=0,1"

systemctl daemon-reload

systemctl restart ollama

- 1

- 2

- 3

- 4

- 5

- 修改模型的存储路径

mv ~/.ollama/models/* /Users/<username>/Documents/ollama_models 将以前的models移动到当前目录

- 1

看上文。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Li_阴宅/article/detail/854084

推荐阅读

相关标签