热门标签

热门文章

- 1大数据在医疗领域应用有哪些挑战?_大数据 医药行业 限制

- 2Metasploit渗透测试框架_metasploit图形界面

- 3AI伦理:Human VS AI(Human will be replaced by AI?)_will human be replaced by ai英文

- 4arm嵌入式linux计算器,ARM平台嵌入式Linux下使用3G/4G 模块

- 5基于springboot+vue.js+uniapp小程序的电影订票系统附带文章源码部署视频讲解等_uniapp 小程序 购票开源

- 601、DeepSpeech2在windows下的部署与测试

- 7精心推荐几个高质量人工智能方向的原创公众号

- 82023年信息素养大赛小学组C++智能算法复赛试题解析_信息素养大赛复赛考试内容

- 9安卓开发实例:高德地图_高德地图安卓开发

- 10TCP和UDP用Java实现_java tcp

当前位置: article > 正文

【ollama】(3):在linux搭建环境中,安装golang开发的ollama工具,并且完成启动下载gemma:7b和qwen:1.8b运行速度飞快,支持http接口和命令行模式_linux安装ollama

作者:小舞很执着 | 2024-07-19 14:08:10

赞

踩

linux安装ollama

1,视频地址

https://www.bilibili.com/video/BV19F4m1F7Rn/

【ollama】(3):在linux搭建环境中,安装ollama工具,并且完成启动下载gemma:7b和qwen:1.8b运行速度飞快,支持http接口和命令行

2,关于ollama项目

项目使用golang+llama.cpp 项目进行开发的。

简化了模型的安装,非常的方便。

3,安装软件启动

curl -fsSL https://ollama.com/install.sh | sh

- 1

- 2

然后因为是docker 虚拟环境,需要手动启动服务: ollama serve

# ollama serve

time=2024-03-12T08:41:45.937+08:00 level=INFO source=images.go:710 msg="total blobs: 12"

time=2024-03-12T08:41:45.938+08:00 level=INFO source=images.go:717 msg="total unused blobs removed: 0"

time=2024-03-12T08:41:45.938+08:00 level=INFO source=routes.go:1021 msg="Listening on 127.0.0.1:11434 (version 0.1.28)"

time=2024-03-12T08:41:45.938+08:00 level=INFO source=payload_common.go:107 msg="Extracting dynamic libraries..."

time=2024-03-12T08:41:50.551+08:00 level=INFO source=payload_common.go:146 msg="Dynamic LLM libraries [rocm_v5 cpu rocm_v6 cpu_avx cuda_v11 cpu_avx2]"

time=2024-03-12T08:41:50.551+08:00 level=INFO source=gpu.go:94 msg="Detecting GPU type"

time=2024-03-12T08:41:50.551+08:00 level=INFO source=gpu.go:265 msg="Searching for GPU management library libnvidia-ml.so"

time=2024-03-12T08:41:50.554+08:00 level=INFO source=gpu.go:311 msg="Discovered GPU libraries: [/usr/lib/x86_64-linux-gnu/libnvidia-ml.so.535.129.03 /usr/lib/x86_64-linux-gnu/libnvidia-ml.so.535.98]"

time=2024-03-12T08:41:50.581+08:00 level=INFO source=gpu.go:99 msg="Nvidia GPU detected"

time=2024-03-12T08:41:50.581+08:00 level=INFO source=cpu_common.go:11 msg="CPU has AVX2"

time=2024-03-12T08:41:50.587+08:00 level=INFO source=gpu.go:146 msg="CUDA Compute Capability detected: 8.6"

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

然后启动 gemma:7b

ollama run gemma:7b

即可

ollama run gemma:7b

>>> 北京景点

北京拥有众多各样的景点,每个景点都有其独特的魅力。以下列举了北京主要景点:

**历史文化景点:**

* **故宫博物院:** 世界上最大的古建筑群,包含皇帝的宫殿、殿宇和御用建筑等。

* **天安门广场:** 位于中央政府办公区,历史悠久的广场,拥有世界上最高建筑——国家领导人办公楼。

* **紫禁城:** 古代中国宫殿,为中国古代建筑的象征。

* **圆明园:** 元代皇家园林,包含众多古典建筑和雕塑。

* **北海寺:** 宏伟的佛教寺庙,拥有世界上最高佛塔。

**现代城市景观:**

* **天安门纪念堂:** 纪念中国共产党领导人毛泽东、朱列·刘备和马克思的纪念堂。

* **东方大厦:** 高度现代化的建筑,拥有世界上最高的摩天线。

* **国家博物馆:** 收藏中国古代艺术品和文物。

* **中国国家博物馆:** 展示中国古代艺术品的收藏。

**其他景点:**

* **国家森林公园:** 北京最大的公园,拥有美丽的自然风景和现代建筑。

* **华北新城:** 北京新开发的现代城市,拥有先进的科技和现代建筑。

* **北水库:** 位于北京北部的湖泊,拥有美丽的景色和完善的交通系统。

**建议的参观顺序:**

根据您的兴趣和时间,您可以根据以下顺序参观景点:

* 第一天:故宫博物院、天安门广场、紫禁城、北海寺。

* 第二天:圆明园、国家博物馆、中国国家博物馆。

* 第三天:国家森林公园、华北新城、北水库。

**注意事项:**

* 北京的交通系统比较便利,可以选择地铁、公交或出租车。

* 在参观景点时,建议提前购买门票,以节省时间和金钱。

* 北京的夏天比较热,建议在夏季穿轻便的衣服和使用防晒用品。

* 北京的冬天比较寒冷,建议在冬季穿保暖衣和使用保暖用品。

>>> Send a message (/? for help)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

可以发现 支持中文效果也不错。

# nvidia-smi

Tue Mar 12 08:44:02 2024

+---------------------------------------------------------------------------------------+

| NVIDIA-SMI 535.129.03 Driver Version: 535.129.03 CUDA Version: 12.2 |

|-----------------------------------------+----------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+======================+======================|

| 0 NVIDIA GeForce RTX 3080 On | 00000000:05:00.0 Off | N/A |

| 0% 26C P8 14W / 320W | 6865MiB / 20480MiB | 0% Default |

| | | N/A |

+-----------------------------------------+----------------------+----------------------+

+---------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=======================================================================================|

+---------------------------------------------------------------------------------------+

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

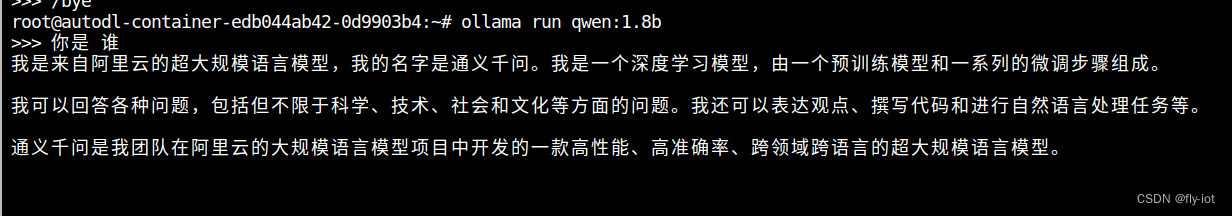

3,支持多个模型推理

有切换的时间,模型会重新载入到显存。

4,还支持接口访问

curl http://localhost:11434/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "qwen:0.5b","stream":true,

"messages": [

{

"role": "user",

"content": "你好"

}

]

}'

curl http://localhost:11434/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "qwen:1.8b","stream":true,

"messages": [

{

"role": "user",

"content": "你好"

}

]

}'

curl http://localhost:11434/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "gemma:7b","stream":true,

"messages": [

{

"role": "user",

"content": "北京景点"

}

]

}'

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

模型存放地址

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\<username>\.ollama\models

可以修改配置文件更改:

OLLAMA_HOST The host:port to bind to (default "127.0.0.1:11434")

OLLAMA_ORIGINS A comma separated list of allowed origins.

OLLAMA_MODELS The path to the models directory (default is "~/.ollama/models")

- 1

- 2

- 3

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小舞很执着/article/detail/851909

推荐阅读

相关标签