热门标签

热门文章

- 1利用Neo4j构建知识图谱_neo4j知识图谱

- 2Oracle中的分页查询_oracle分页查询

- 3Java防止Xss注入json_【快学springboot】15、SpringBoot过滤XSS脚本攻击

- 4uni-app简单介绍_uniapp是什么

- 5基于SpringBoot+Vue的房屋租赁系统 (源码+文档+包运行)_springboot+vue房产中介系统

- 6第七章:AI大模型的部署与维护 7.4 模型监控

- 7利用android studio制作简易的计算器_androidstudio做一个计算器使用tablelayout布局

- 8[PTA]实验11-2-1 建立学生信息链表

- 9高仿网易酷狗侧滑与QQ新界面侧滑_android 模仿酷狗(新版)滑动侧滑栏的效果

- 10yolo-mask的损失函数l包含三部分_IoU、GIoU、DIoU、CIoU损失函数的那点事儿

当前位置: article > 正文

推荐系统之GBDT+LR

作者:Monodyee | 2024-03-15 13:57:05

赞

踩

gbdt+lr

前言

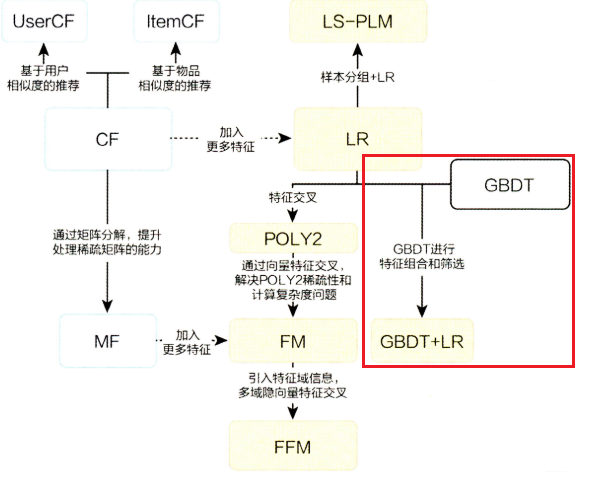

前面讲过的FM与FFM模型虽然增强了模型的交叉能力,但是不管怎样都只能做二阶的交叉,如果想要继续加大特征交叉的维度,那就会出大计算爆炸的情况。所以Facebook提出了梯度提升树(GBDT)+逻辑回归(LR)的模型,具体来说首先利用GBDT自动将特征进行筛选和组合,进而生成新的离散特征向量,然后再把特征向量当作LR模型输入,从而预估CTR。关于逻辑回归(LR)的部分前面已经讲过了,这里具体的讲一下GBDT这个大家伙。在讲解之前先看一章图来了解一下传统推荐模型的进化关系图,讲完这一章传统的推荐算法模型就基本告一段落了,这个图中出现的所有模型都已经一一被讲解过了,大家可以看我主页来进行了解。

一、GBDT模型

GBDT全称梯度提升决策树,在传统机器学习算法里面是对真实分布拟合的最好的几种算法之一,即可以用于分类也可以用于回归还可以筛选特征。这个算法非常重要, 现在机器学习算法最常用的XGBOOST,Lightgbm, catboost这几大巨头算法都是基于这个算法的基础上进行发展起来的。介绍GBDT之前我觉得有必要先介绍一些BDT,这是以CART决策树为基学习器的集成学习方法, 关于集成学习,我还会写文章来进行介绍。

(1)BDT

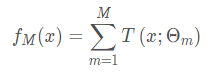

首先提升树模型可以理解为多个决策数的加法:

其中函数T()代表决策树,M表示树的个数,提升树采用的是向前分布算法,首先确定提升树![]() ,第m步的模型是:

,第m步的模型是:

![]()

通过将损失函数极小化来确定下一颗树的参数。在这里总结一下回归算法选择的损失函数一般是均方差或者绝对值误差;而在分类算法中一般的损失函数选择对数函数来表示。

这里借用一下一位大佬的总结:

boosting方法之前已经提到过, 是由多个弱学习器进行组合得到的一个

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Monodyee/article/detail/241452

推荐阅读

相关标签