- 1TPS,RPS,QPS,RT的区别_rps和qps

- 2阿里技术面都过了,薪资都谈好了21K*13结果还是被刷了,问HR原因是...._阿里面试通过到谈薪

- 3【深度学习(1)】研0和研1如何上手深度学习及定方向

- 4百度沈抖:智能,生成无限可能

- 5最长上升子序列_小明非常喜欢数列,于是他提出了一个关于数列的问题。他拿到一个长度为n的数列,之

- 6wcf托管在IIS上,提示未能加载

- 7用于复杂任务的 AI 编码引擎:多文件多步骤拆解实现 | 开源日报 No.239

- 8基于Spring Boot 3 + Spring Security6 + JWT + Redis实现接口资源鉴权_springboot3 security6 jwt4

- 9Spring Data JPA持久层中的一对一和一对多_@entity和@data

- 10hive的安装配置与常见问题~_9083端口

这个AI换衣项目也太惊艳了吧,看完我整个人都不好了!_ootdiffusion window

赞

踩

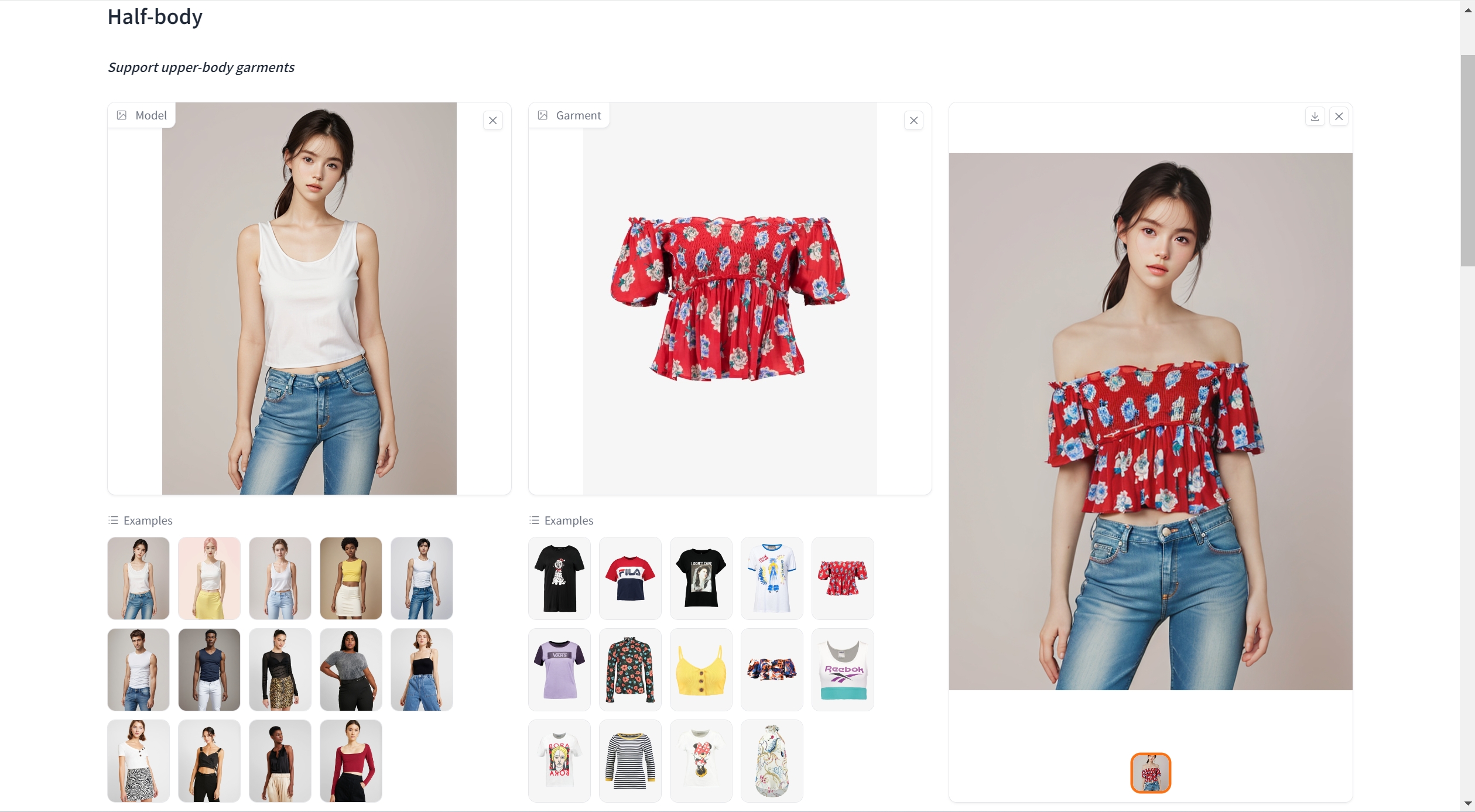

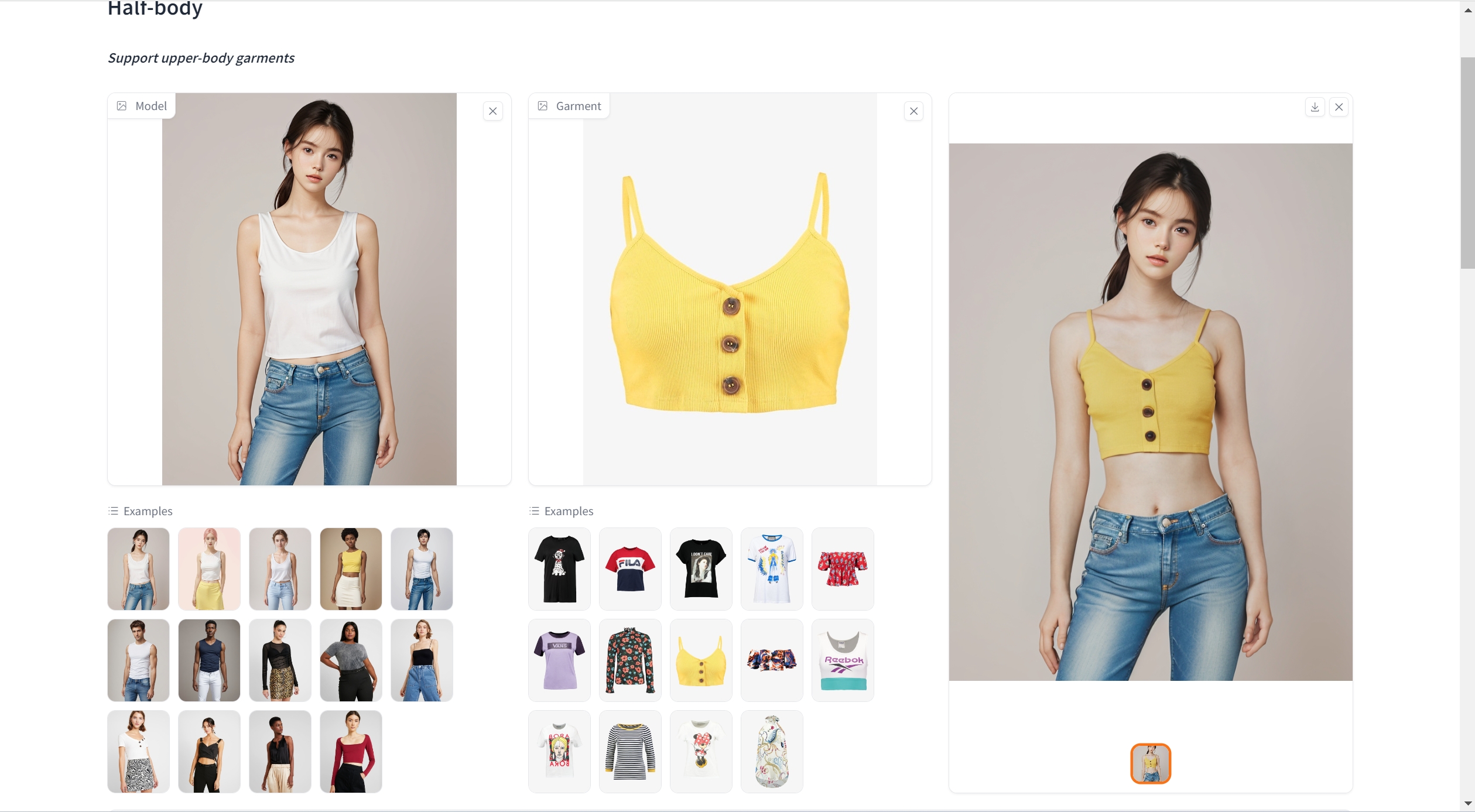

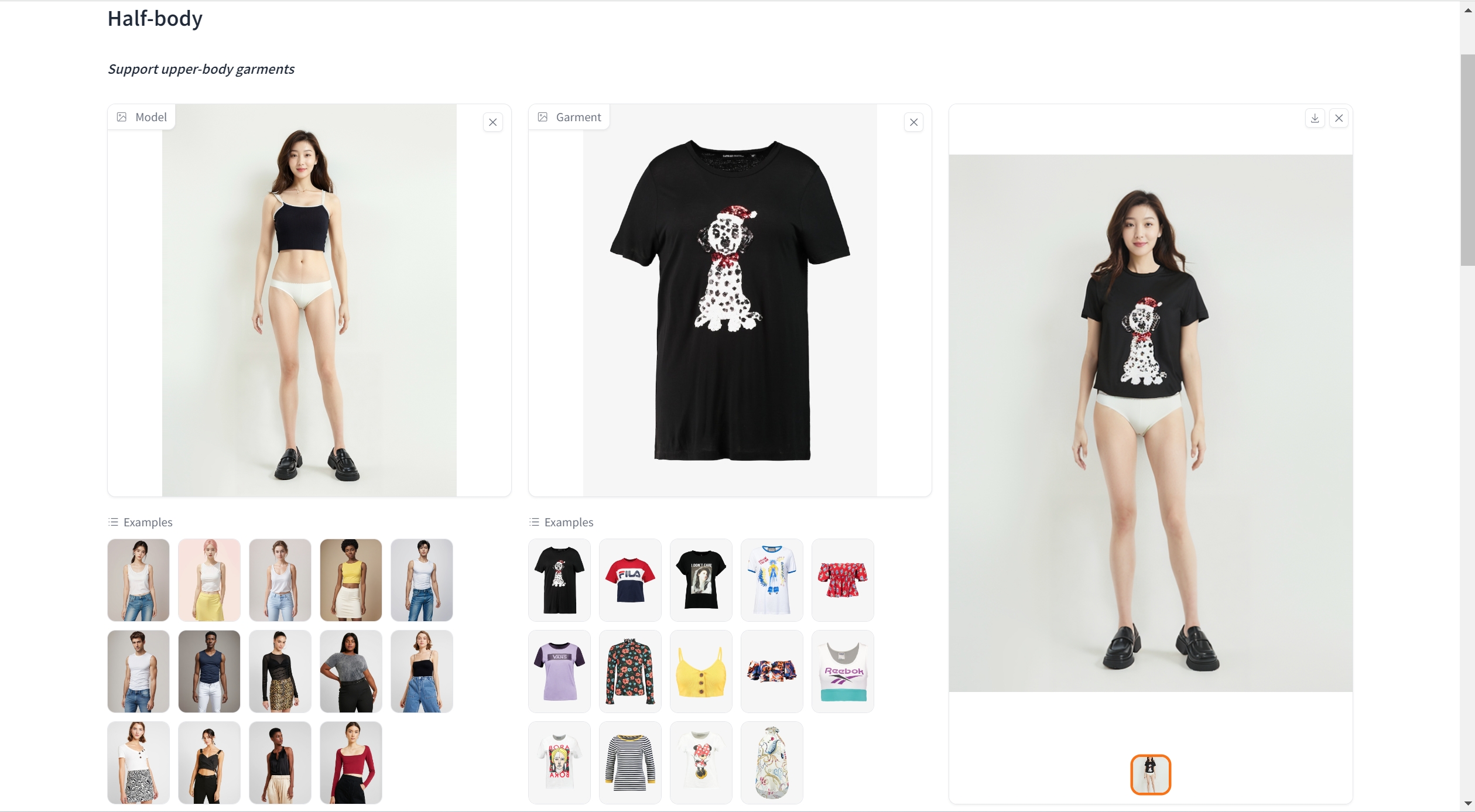

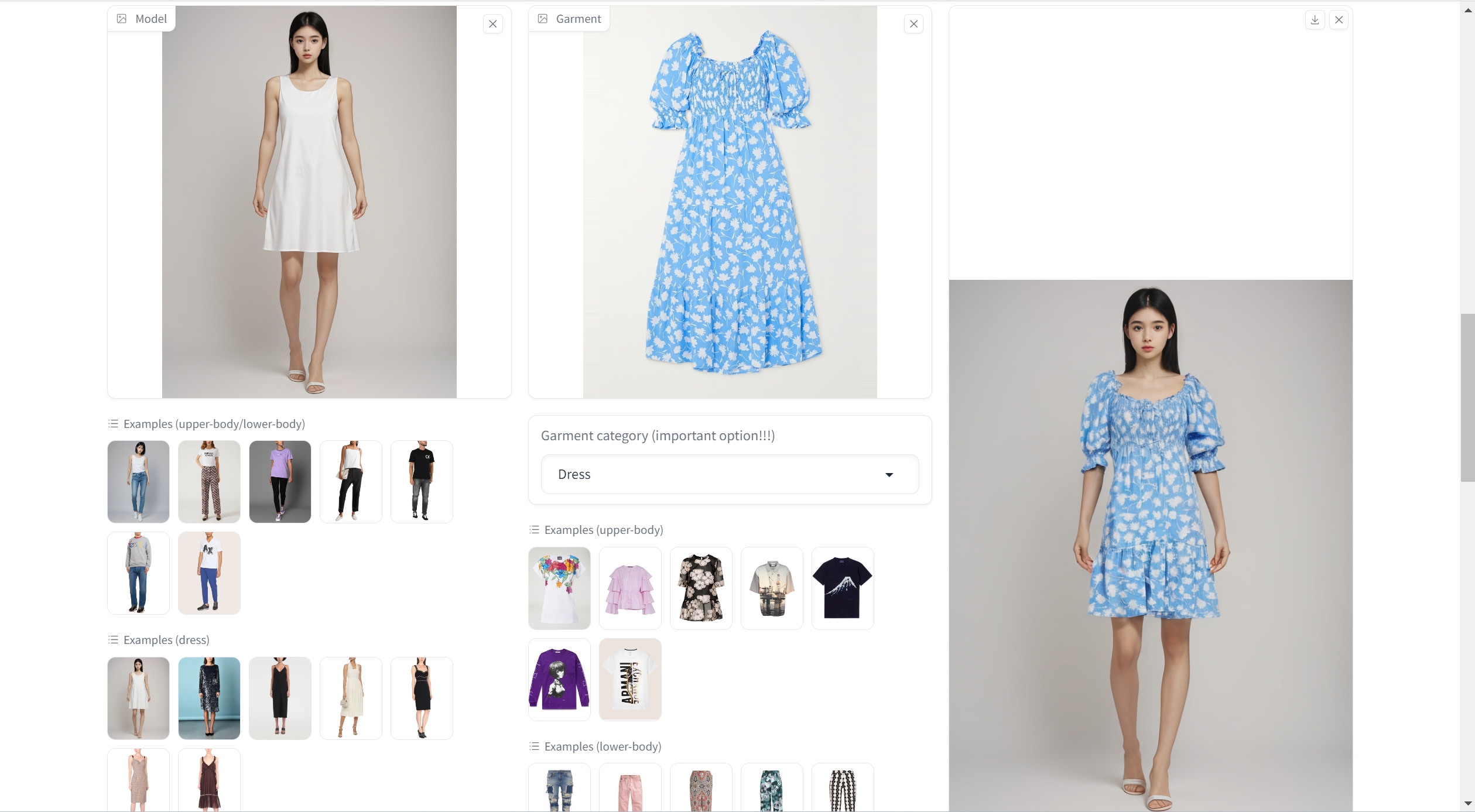

在这个科技飞速发展的时代,人工智能(AI)已经突破了传统的应用边界,从大语言模型如ChatGPT的出现,到AI绘画创作工具如Midjourney和Stable Diffusion的广泛应用,这些进步不仅展示了AI的强大潜力,也不断重塑着我们对艺术和创意表达的认识。但是,如果我告诉你,AI的魔力不止于此,它现在甚至能够帮助我们选择和搭配衣服,甚至在虚拟世界中为我们“换装”,你敢相信吗?最近,老秦发现了一个AI虚拟试穿项目,它的创新性和表现力让我整个人都不好了!

先看效果:

下面老秦就介绍下AI虚拟试穿技术以及OOTDiffusion项目的本地部署。

AI虚拟试穿技术的发展史

虚拟试穿技术的最初概念可以追溯到2000年代初期。那时,这项技术主要依赖于简单的2D图像处理和虚拟现实技术,用户可以在电脑上试穿虚拟服装。

随着智能手机和平板电脑的普及,以及图像处理技术和计算能力的显著提升,2010年代见证了虚拟试穿技术的重要进步。增强现实(AR)技术的应用使得用户能够通过设备摄像头实时看到自己穿着虚拟服装的样子。这一时期,多家初创公司和大型科技公司开始研发更高级的虚拟试穿解决方案,提高了用户交互体验的自然度和真实感。

近年来,随着人工智能(AI)和机器学习技术的飞速发展,虚拟试穿技术迎来了革命性的变革。AI不仅能够提高虚拟试穿的精确度和逼真度,还能够根据用户的体型、偏好以及历史数据推荐个性化的服装。深度学习算法使得虚拟试穿能够在复杂的背景下准确识别用户的身体轮廓,并实时渲染服装图像以适应不同的姿势和动作。

AI虚拟试衣最新技术成果

TryOnDiffusion

TryOnDiffusion 是由Google Research 与华盛顿大学联合研发。可以通过将两张图片融合起来,让模特无须重新拍摄就可以展示出不同服装的上身效果。传统的合成方法通常只能接受造型区别不大的两张图片,否则合成出来的新图片会出现服装变形严重的情况。而 TryOnDiffusion 基于并行 UNet 的扩散式架构打造,能够在保留更多细节的情况下让服装和真人模特相结合,呈现出自然的服装效果。

项目地址:

https://github.com/tryonlabs/tryondiffusion

- 1

论文地址:

https://arxiv.org/pdf/2306.08276.pdf

- 1

Diffuse to Choose

Diffuse to Choose 是由亚马逊推出的,也是基于扩散模型改进,可以为网购客户提供身临其境的虚拟试穿服务。与扩散模型相比,Diffuse to Choose模型能更好地捕捉商品细节,保证与环境的高度融合。用户可以上传一张全身自拍照,测试不同服装的试穿效果,或者上传多张人物照片,测试同件服装的穿着效果。消费者还可以拍摄家中的场景,选择不同的家具来测试商品和家装氛围的契合度。

项目地址:

https://diffuse2choose.github.io/

- 1

论文地址:

https://arxiv.org/pdf/2401.13795.pdf

- 1

Outfit Anyone

Outfit Anyone 是由阿里推出的虚拟试穿技术。该技术采用双流条件扩散模型处理模特和服装数据,通过衣物图像实现逼真的虚拟试穿效果,结合Animate Anyone技术,轻松制作任意角色的换装视频。只需要一张人物照片和服装照片,就可以为不同的姿势和身体形状创建高质量的虚拟试穿。

项目地址:

https://github.com/HumanAIGC/OutfitAnyone

- 1

论文地址:

https://humanaigc.github.io/outfit-anyone/

- 1

体验地址:

https://huggingface.co/spaces/HumanAIGC/OutfitAnyone

- 1

该项目疑似空壳开源,口碑和画风不好,并且该组织下的好几个项目都是空壳,github的issues下基本都是国粹精华,感兴趣的可以自行去吃瓜。

该项目对应的商业产品地址:https://outfitanyone.app,按月订阅是每月29美刀,只对国外开放,该产品页下方声明了与阿里巴巴公司无关,具体详情老秦无从考证。

OOTDiffusion

OOTDiffusion 是由东京大学的几位博士开源,基于Stable Diffusion模型微调,用于实现现实且可控的基于图像的虚拟试穿(VTION)。该方法利用预训练的潜在扩散模型,并设计了一个outfitting UNet来学习服装细节特征。通过在去噪UNet的自注意力层中引入outfitting融合,可以精确地将服装特征与目标人体对齐,而无需冗余的变形过程。为了进一步增强可控性,作者还引入了outfitting dropout到训练过程中,以调整服装特征的强度。实验结果表明,在VITON-HD和Dress Code数据集上,OOTDiffusion能够高效地生成高质量的试穿效果,不仅具有更高的真实性和可控性,而且取得了令人印象深刻的突破。

项目地址:

https://github.com/levihsu/OOTDiffusion

- 1

论文地址:

https://arxiv.org/pdf/2403.01779.pdf

- 1

体验地址:

https://huggingface.co/spaces/levihsu/OOTDiffusion

- 1

该项目模型和权重已经开源,在huggingface上可以下载,但是目前还没有开放训练代码,并且该项目使用的是“知识共享 署名-非商业性使用-相同方式共享 4.0 国际许可协议”,故不能用作商业目的。

OOTDiffusion本地部署

作者只在Linux(Ubuntu 22.04)系统上测试过代码和模型,如果使用的是Linux系统,按照项目github仓库给出的部署方式即可,这里老秦是在个人的windows电脑上部署的,显卡是 RTX 2062S,出图大概在一分钟左右,效果也还可以。

在部署之前我们需要先确保我们电脑已经安装了基础的环境,比如 conda 包管理工具, 既然是机器学习项目,python环境是少不了的,这里老秦不在赘述,请自行google,老秦也推荐一款AI搜索引擎-Perplexity AI(www.perplexity.ai)。

安装

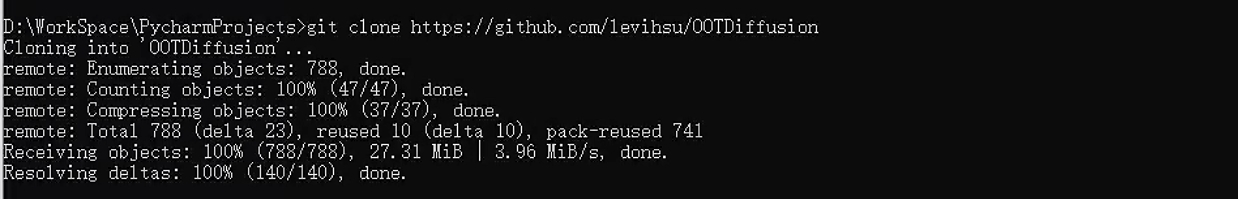

1.克隆仓库

git clone https://github.com/levihsu/OOTDiffusion

- 1

2.创建conda环境并安装所需的包

conda create -n ootds python==3.10

conda activate ootds

pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2

pip install -r requirements.txt

- 1

- 2

- 3

- 4

对于Windows用户,除了上述步骤,确保nvcc编译器安装正确也是必要的。这通常通过安装cuda-nvcc包来完成:

conda install cuda-nvcc -c nvidia

- 1

3.配置 MSVC

由于在windows系统上部署需要C++编译环境支持,所以需要配置配置 MSVC。

首先是 nvcc 安装(确保 VIRTUAL_ENV/bin/nvcc 存在):

conda install cuda-nvcc -c nvidia

- 1

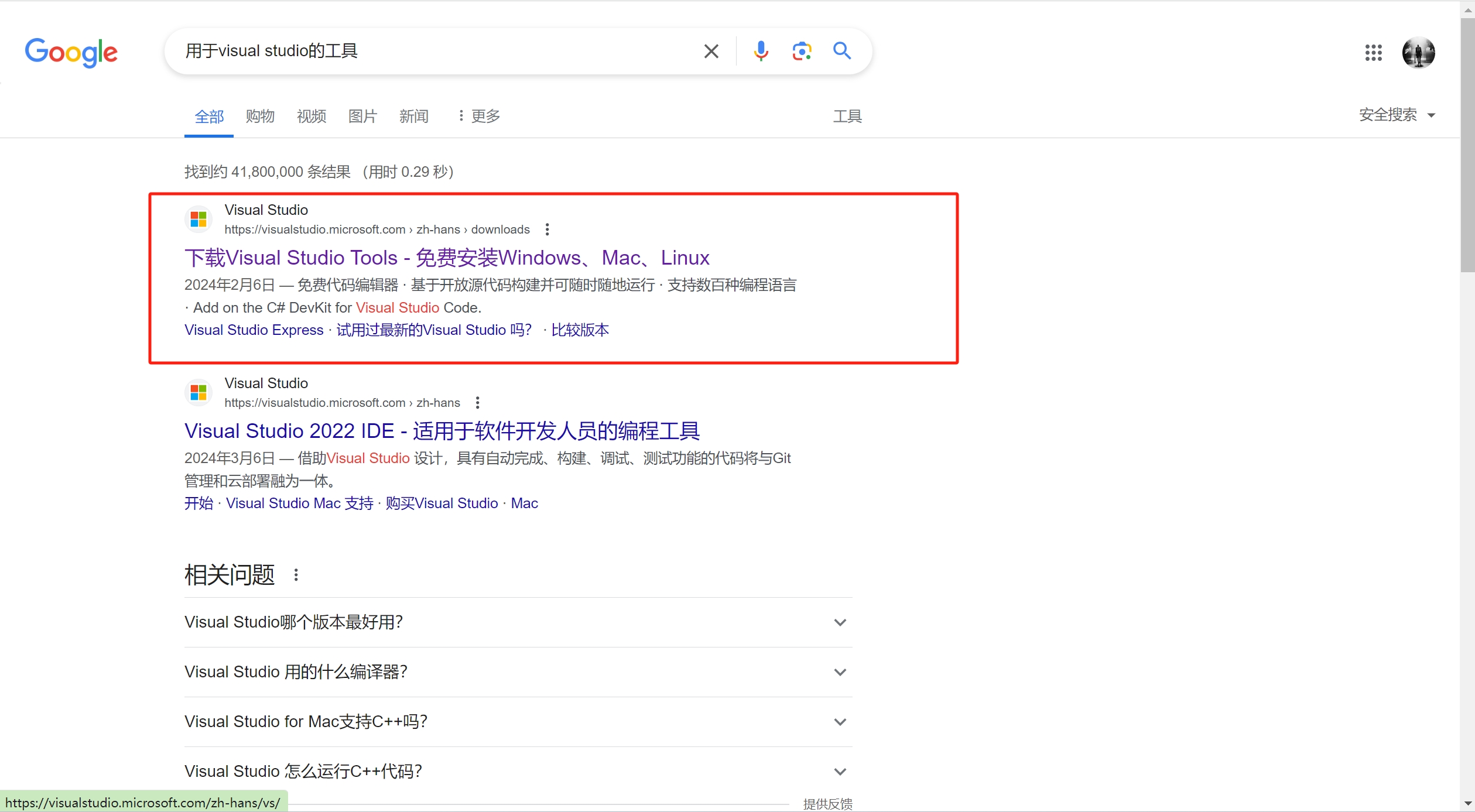

在搜索引擎搜索 “用于visual studio的工具”:

下载 Visual Studio 生成工具并安装:

根据自己的操作系统版本,只需要安装下图的三个即可:

注意:不要从 Installer 点击启动 terminal。

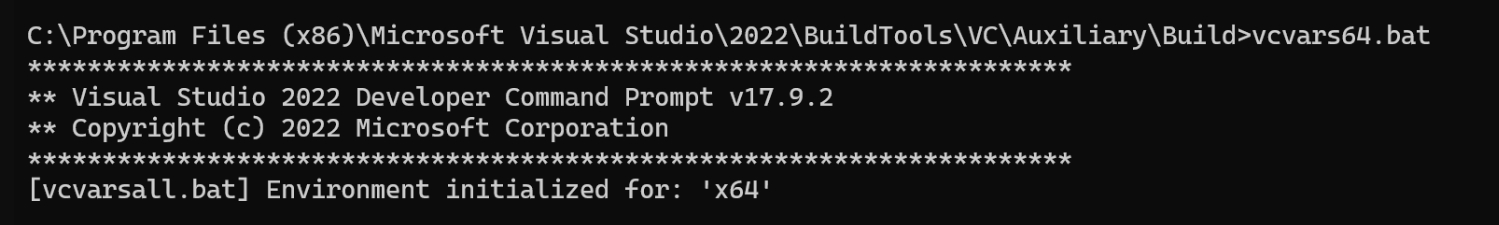

进入:

C:\Program Files (x86)\Microsoft Visual Studio\2022\BuildTools\VC\Auxiliary\Build 目录

- 1

右击进入 terminal,注意要用 CMD 不要 powershell。

启动 native x64 target x64 的编译环境变量(兼容环境下 nvcc 编译会报错):

vcvars64.bat

- 1

4.下载模型

上huggingface下载模型:

(https://huggingface.co/levihsu/OOTDiffusion)

- 1

模型检查点目录有如下四个目录:

5.修改run目录下的gradio_ootd.py文件

因为该文件中设定了默认使用2个GPU,老秦的电脑只有一个GPU,所以需要改下如下代码:

openpose_model_hd = OpenPose(0)

parsing_model_hd = Parsing(0)

ootd_model_hd = OOTDiffusionHD(0)

openpose_model_dc =openpose_model_hd

parsing_model_dc = parsing_model_hd

ootd_model_dc = ootd_model_hd

- 1

- 2

- 3

- 4

- 5

- 6

- 7

6.启动gradio ui

cd run

python gradio_ootd.py

- 1

- 2

如下,说明启动成功:

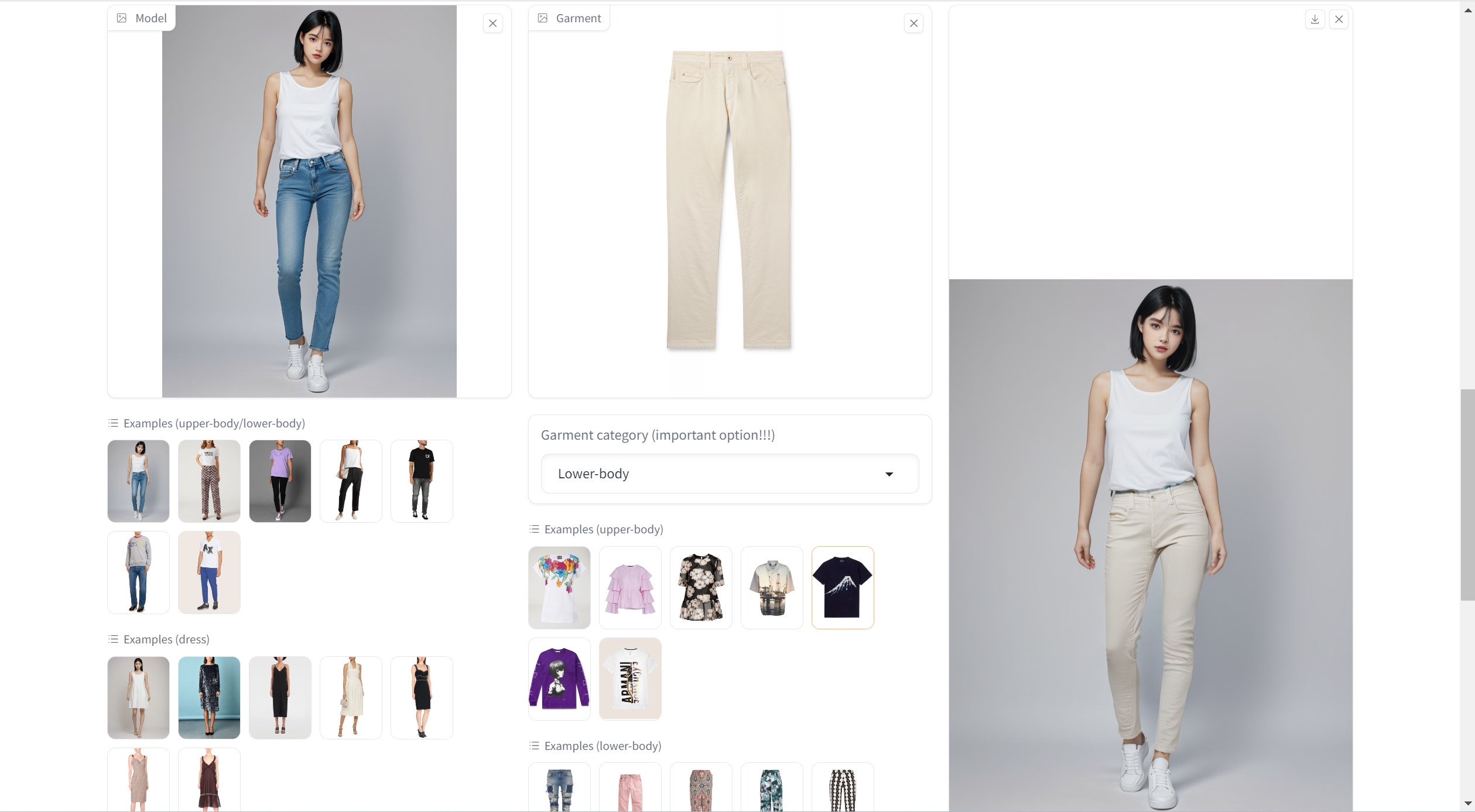

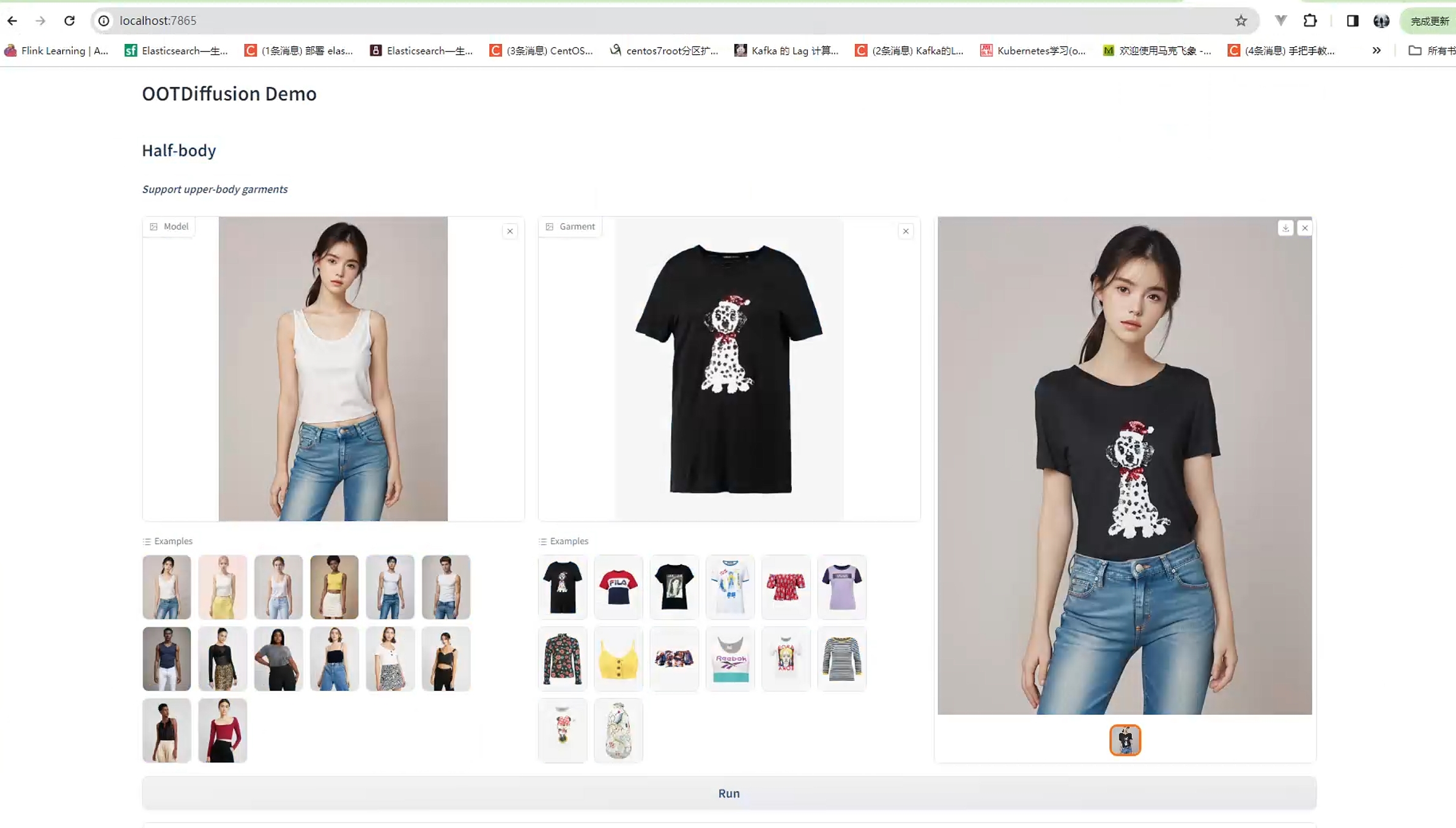

访问localhost:7865,可以看到gradio页面了:

接下来就可以给模特换个衣服了:

大概用了不到1分钟出图。

7.问题解决

如发生AttributeError异常:

AttributeError: module 'torch._C' has no attribute '_cuda_setDevice'

- 1

可能是版本问题,执行下如下命令:

conda install pytorch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 pytorch-cuda=11.7 -c pytorch -c nvidia

- 1

如果发生ImportError异常:

ImportError: cannot import name 'COMMON_SAFE_ASCII_CHARACTERS' from 'charset_normalizer.constant'

- 1

需安装chardet

pip install chardet

- 1

总结

以上老秦介绍了AI虚拟试衣技术和OOTDiffusion的本地部署,老秦之前就部署过,也踩了一些坑,所以这次部署比较顺利,如果大家遇到问题,可以加下老秦的AI闲聊群,有空可以帮大家看下问题。