热门标签

热门文章

- 1CleanMyMac X2024绿色百度网盘下载链接_2024百度网盘下载

- 2数据分析报告编写规范_数据分析报告的质量要求中不包括()。a 结构合理,逻辑清晰实事求是,反映真相c

- 3Crossover24新版发布!搭载Wine9提升Mac游戏体验!

- 4springboot+vue断点续传_springboot vue 断点续传

- 5unixodbc的配置(下载安装详细步骤)_odbcinst: error while loading shared libraries: li

- 6数据结构和算法的区别_数据结构算法和机器学习算法有什么区别

- 7串的数据结构表-----顺序串与链式串_p->ch是什么意思

- 8量子计算(十二):量子线路与测量操作

- 9千里之行始于足下梦开始的地方——A+B problem C++史上最详解,氵题一道,109 种解法!(附加多种语法的代码)

- 10Spark-机器学习(8)分类学习之随机森林

当前位置: article > 正文

人工智能论文:BERT和GPT, GPT-2, GPT-3 的简明对比和主要区别

作者:Monodyee | 2024-05-03 16:09:30

赞

踩

人工智能论文:BERT和GPT, GPT-2, GPT-3 的简明对比和主要区别

在BERT的论文里面: 2018.10 BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding,BERT已经解释了BERT,GPT,ELMo的区别。

*ELMo为双向RNN,请忽略。

主要区别:

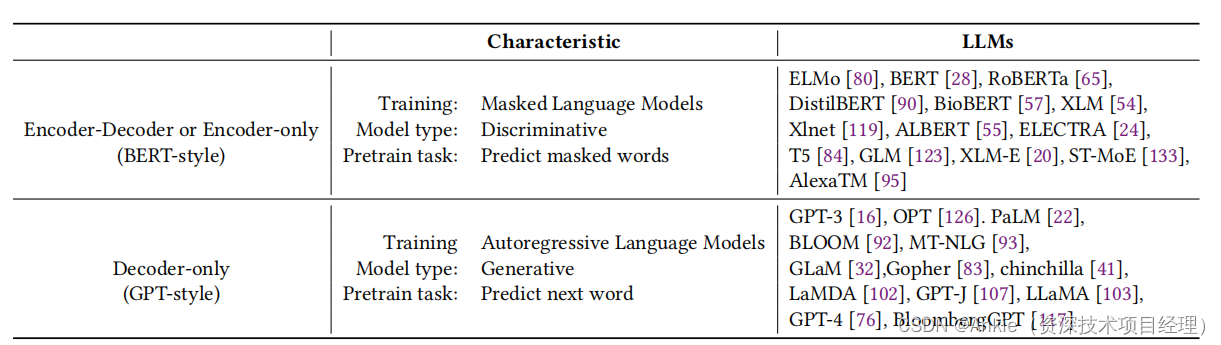

- BERT使用的是transformer的encoder,双向,专注于完形填空。对于缺失的内容和应试内容比较擅长。

- GPT使用的是transformer的decoder,单向,专注于预测,因为decoder看不到后面的字符,训练GPT的预测性能。

- BERT和GPT-1都使用了微调,以应对各种考试。而后期GPT-2,GPT-3抛弃微调,专注于通用人工智能。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Monodyee/article/detail/530467

推荐阅读

相关标签