- 1Git 安装和使用(非常详细教程)_git 7676900

- 2论文学习笔记08:IMT_primt

- 3标记垃圾,有三种色彩:四千长文带你深入了解三色标记算法

- 4Unity微信小游戏使用微信云开发排行榜_微信小游戏排行榜怎么做

- 5《计算机视觉教程》第三版_部分课后习题个人参考答案_计算机视觉教程第三版课后答案

- 6PostGIS实现叠加分析之-Clip_postgis 叠加分析

- 7新手小白菜初学自动化测试,关于Appium的安装配置(有一些段落板块非原创,只是发现很多文章写得不细,摸索了半天添加自己的问题和解决方法))_appium中platformversion的值是填安卓手机的哪一个值

- 8Vue学习笔记总结_vue总结 笔记

- 9关于 GPT必须知道的10 个认知!_gpt的本质

- 10Rust中的系统编程:超越安全_rust dpdk

企业级数据中台应用架构和技术架构_应用架构结合技术架构

赞

踩

一、什么是数据中台

数据中台是一种将企业沉睡的数据变成数据资产,持续使用数据、产生智能、为业务服务,从而实现数据价值变现的系统和机制。通过数据中台提供的方法和运行机制,形成汇聚整合、提纯加工、建模处理、算法学习,并以共享服务的方式将数据提供给业务使用,从而与业务联动。再者,结合业务中台的数据生产能力,最终构建数据生产一消费一再生的闭环。

数据中台与大数据、数据仓库、数据湖、 商业智能BI有什么区别,请参考本博客的另外一篇文章。

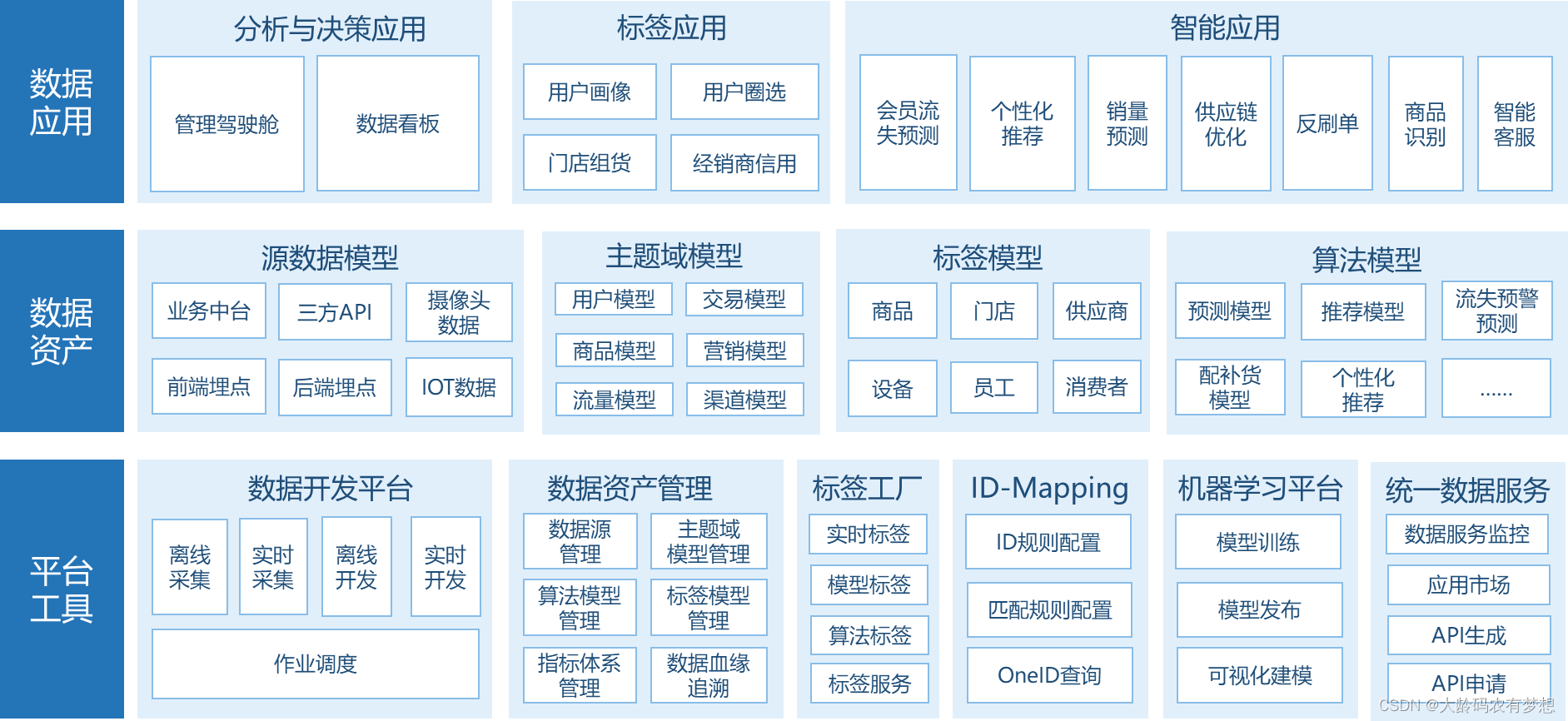

二、数据中台功能架构

数据中台建设是一个宏大的工程,涉及整体规划、组织搭建、中台落地与运营等方方面面的工作,本文重点从物理形态上讲述企业的数据中台应该如何搭建。一般来讲,企业的数据中台在物理形态上分为三个大层:工具平台层、数据资产层和数据应用层。

2.1.工具平台层

工具平台层是数据中台的载体,包含大数据处理的基础能力技术,如集数据采集、数据存储、数据计算、数据安全等于一个的大数据平台;还包含建设数据中台的一系列工具,如离线或实时数据研发工具、数据联通工具、标签计算工具、算法平台工具、数据服务工具及自助分析工具。以上工具集基本覆盖了数据中台的数据加工过程。

(1)数据开发平台

大数据的4V(Volume 数据量大、 Variety类型繁多、Velocity 速度快效率高、 Value价值密度低)特征决定了大数据处理是一个复杂的工程。建设数据中台需要搭建数据中台的基建工具,要满足各种结构化、非结构化数据的采集、存储与处理,要根据场景处理离线和实时数据的计算与存储,要将一个个数据处理任务串联起来以保障数据的运转能赋能到业务端。

(2)数据资产管理

数据中台建设的成功与否,与数据资产是否管理有序有直接关系。数据中台是需要持续运营的,随着时间的推移,数据不断涌人数据中台,如果没有一套井然有序的数据资产平台来进行管理,后果将不堪设想。

数据资产管理工具既能帮助企业合理评估、规范和治理信息资产,又可以发挥数据资产价值并促进数据资产持续增值。对于数据资产管理,不推荐事后管理,而要与数据研发的过程联动。也就是说,当数据经过数据开发平台加工的链路时,数据资产管理平台就已经无声无息地介入了。数据资产管理的首要任务是管理好进入数据中台的元数据,这里的元数据包括数据源、构建的各种模型、通过模型拆解出来的指标与标签。有序管理这些数据资产的元数据是前提条件,只有做好了这一步,才能继续对数据流向的追溯,对指标、标签体系的生命可期进行管理。

(3)标签工厂

标签工厂又称标签平台,标签建设是数据中台走向数据业务化的关键步骤,严格来说标签工厂也属于数据开发平台的一部分。一个强大的标签工厂是数据中台价值体现的有力保障,标签的使用场景丰富,标签与业务结合得非常紧密。标签工厂致力于屏蔽底层复杂的大数据框架,面向普通开发人员、数据分析师、运营人员提供友好的界面交互配置,完成标签的全生命周期管理;同时,对上层业务系统提供自身 API 能力,与各业务系统形成数据闭环。

标签工厂按功能一般分为两部分:底层的标签计算引擎与上层的标签配置与管理门户。标签计算引擎一般会使用 MapReduce 、 Spark 、 Flink 等大数据计算框架,而计算后的标签存储可采用 Elasticsearch 或者 HBase ,这样存储的好处是便于快速检索。而标签配置与管理门户则支持通过配置标签规则提交到标签计算引擎,就能定时算出所需要的标签。标签配置和官理户还提供标准的标签服务申请与调用。通过标签工厂,数据中口团队可减少大量的数据开发工作。

(4) ID - Mapping

ID - Mapping 又称 ID 打通工具,是数据中台建设的可选项,可选不代表不重要,在一些多渠道、多触点的新零售企业,离开这个工具,数据质量将大打折扣。ID - Mapping 功能的建设一般会利用强大的图计算功能,通过两两之间的关系实现互通,目动高效地将关联的身份映射为同一身份即唯一 ID 的数据工具。它能大幅度降低处理成本,提高效率,挖掘更多用户信息,形成更完整的画像,大大利于数字营销的推进。另外, ID - Mapping 工具也可用于企业主数据治理。

(5)机器学习平台

在整个机器学习的工作流中,模型训练的代码开发只是其中一部分。除此之外,数据准备、数据清洗、数据标注、特征提取、超参数的选择与优化、训练任务的监控、模型的发布与集成、日志的回收等,都是流程中不可或缺的部分。机器学习平台支持训练数据的高质量采集与高效标注,内置预训练模型,封装机器学习算法,通过可视化拖曳实现模型训练,支持从数据处理、模型训练、模型部署为在线预测服务,通过 RESTful API 的形式与业务应用集成,实现预测,打通机器学习全链路,帮助企业更好地完成传统机器学习和深度学习的落地。

(6)统一数据服务

统一数据服务旨在为企业搭建统一的数据服务门户,帮助企业提升数据资产的价值,同时保证数据的可靠性、安全性和有效性。统一数据服务支持通过界面配置的方式构建 API 和数据服务接口,以满足不同数据的使用场景,同时降低数据的开发门槛,帮助企业实现数据应用价值最大化。统一数据服务作为唯一的数据服务出口,实现了数据的统一市场化管理,在有效降低数据开放门槛的同时,保障了数据开放的安全。

2.2.数据资产层

数据资产层是数据中台的核心层,它依托于工具平台层,具体内容因企业的业务与行业而异,但总体来讲,可以划分为主题域模型区、标签模型区和算法模型区

(1)主题域模型

主题域模型是指面向业务分析,将业务过程或维度进行抽象的集合。业务过程可以概括为一个个不可拆分的行为事件,如订单、合同、营销等。为了保障整个体系的生命力,主题域即数据域需要抽象提炼,并且长期维护和更新,但是不轻易变动。在划分数据域时,既要涵盖当前所有业务的需求,又要保证新业务能够无影啊地被包含进来。

(2)标签模型

标签模型的设计与主题域模型方法大同小异,同样需要给日业务过程进行设计,需要充分理解业务讨程。标签一般会涉及企业经营过程中的实体对象,如会员、商品、门店、经销商等,这些主体一般来说都穿插在各个业务流程中,比如会员一般都穿插在注册、登录、浏览、下单、评价、服务等环节。那么在设计标签系统的时候就而要充分理解这此业务流程,在流程中发现标签的应用点,结合这些应用点来搭建企业的标签系统。设计标签模型时非常关键的要索是标签模型一定要具有可扩展性。毕竟标签这种数据资产是需要持续运营的,也是有生命周期的,在运营的过程中随时可能增加新的标签。

(3)算法模型

算法模型更加贴近业务场景。在设计算法模型的时候要反复推演算法模型使用的场景,包括模型的冷启动等问题。整个模型搭建过程包含定场景、数据源准备、特征工程、模型设计、模型训练、正式上线、参数调整7个环节。以新零售企业为例,常用的机器学习算法有决策树、神经网络、关联规、聚类、贝叶斯、支持问量机等。这些算法已经非常成熟,可以用来实现商品个性化推荐、销量预测、流失预测、商品组货优化等新零售场景的算法模型。

2.3.数据应用层

数据应用层严格来说不属于数据中台的范畴,但数据中台的使命就是为业务赋能,几乎所有企业在建设数据中台的同时都已规划好数据应用。数据应用可按数据使用场景来划分为以下多个使用领域。

(1)分析与决策应用

分析与决策应用主要面向企业的领导、运营人员等角色,基于企业的业务背景和数据分析诉求,针对客户拉新、老客运营、销售能力评估等分析场景,通过主题域模型、标签模型和算法模型,为企业提供可视化分析专题。用户在分析与决策应用中快速获取企业现状和问题,同时可对数据进行钻取、联动分析等,深度分析企业问题及其原因,从而辅助企业进行管理和决策,实现精准管理和智能决策。

(2)标签应用

标签旨在挖掘实体对象(如客户、商品等)的特征,将数据转化成真正对业务有价值的产物并对外提供标签数据服务,多应用于客户圈选、精准营销和个性化推荐等场景,从而实现资产变现,不断扩大资产价值。标签体系的设计立足于标签使用场景,不同使用场景对你签需求是不同的,警如在客户个性化推荐场景下,需要客户性别、近期关注商品类型、消费能力和消费习惯等标签。因此,在标签体系设计前,需要先基于业务需求分析标签的使用场景,再详细设计标签体系和规则。

(3)智能应用

智能应用是数智化的一个典型外在表现。比如在营销领域,不仅可实现千人千面的用户个性化推荐,如猜你喜欢、加购推荐等,还可借助智能营销工具进行高精准度的用户触达。除了传统统计分析、机器学习之外,还可以融入深度学习,自然语言处理等,满足更多智能化应用场景。

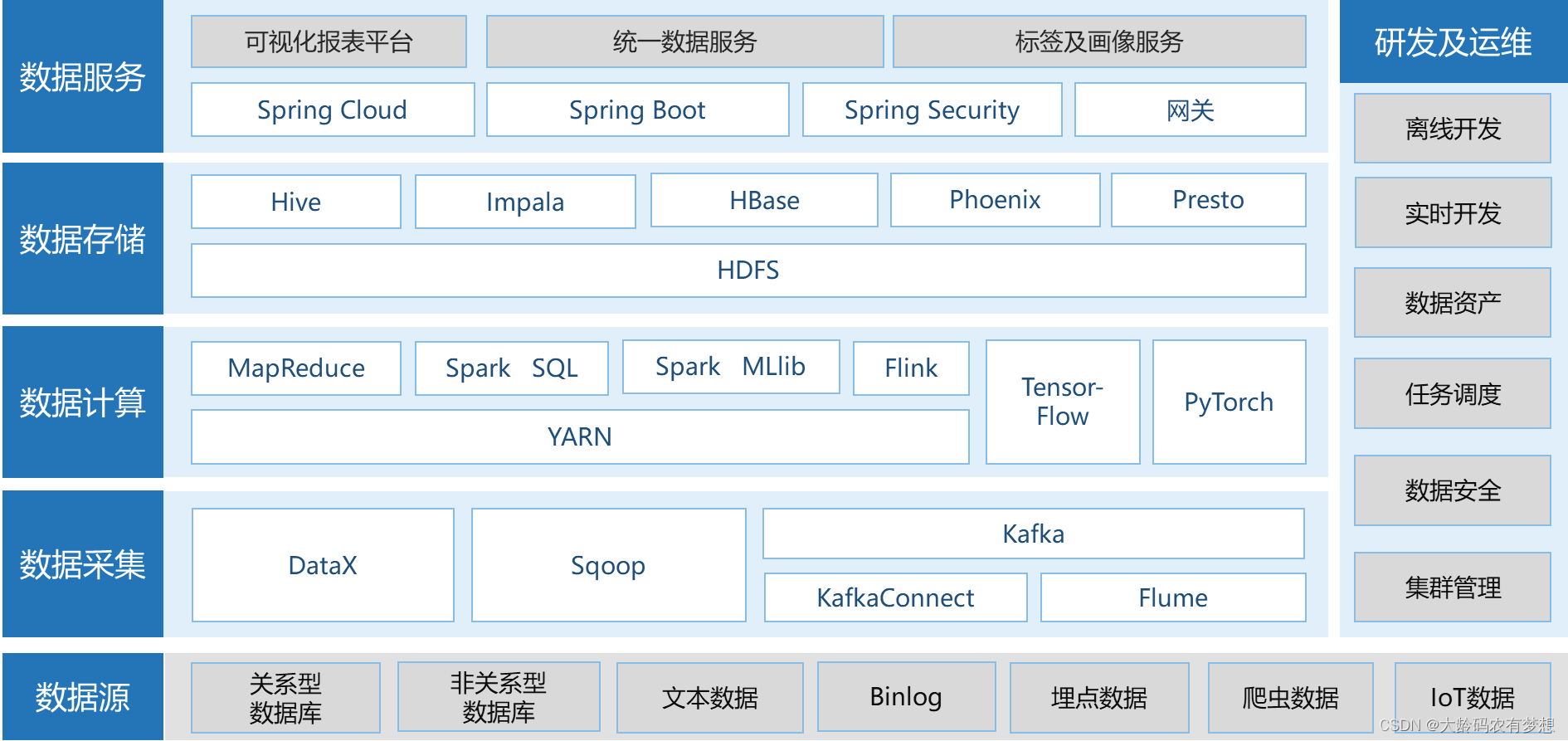

三、数据中台技术架构

随着大数据与人工智能技术的不断迭代以及商业大数据工具产品的推出,数据中台的架构设计大可不必从零开始,可以采购一站式的研发平台产品,或者基于一些开源产品进行组装。企业可根据自身情况进行权衡考虑,但无论采用哪种方案,数据中台的架构设计以满足当前数据处理的全场景为基准。

以开源技术为例,数据中台的技术架构如下图所示,总体来看一般包含以下几种功能:数据采集、数据计算、数据存储和数据服务;在研发、运维和公共服务方面包括离线开发、实时开发、数据资产、任务调度、数据安全、集群管理。

3.1.数据采集层

按数据的实时性,数据采集分为离线采集和实时采集。离线采集使用 DataX 和 Sqoop ,实时米集使用 Kafka Connect 、 Flume 、 Kafka。 在离线数据采集中,建议使用 DataX 和Sqoop相结合。 DataX 适合用在数据量较小且采用非关系型数据库的场景,部署方式很简单。 Sqoop 适合用在数据量较大且采用关系型数据库的场景。在实时数据采集中,对于数据库的变更数据,如 MySQL 的 binlog 、 Oracle 的OGG,使用 Kafka Connect 进行数据的实时采集。对于其他数据,先将数据实时写成文件,然后采用 Flume 对文件内容进行实时采集。将实时采集后的数据推送到 Kafka ,田 Flink 进行数据处理。

3.2.数据计算层

数据计算采用 YARN 作为各种计算框架部署的执行调度引擎,计算框架有 MapReduce 、 Spark 及 Spark SQL 、 Flink 、 Spark MLlib 等。 MapReduce 是最早开源的大数据计算框架,虽然性能相当较差,但它的资源占用比较小,尤其是内存方面。因此在部分数据量过大,而其他计算框架由干硬件资源的限制(主要是内存限制)无法执行的场景,可以将 MapReduce 作为首选框架。 SparK 及 Spark SQL 是在批处理方面拥有出色的性能技术方案,适合大部分的离线处理场景。Flink 是实时数据处理方面的首选,在处理的时效性、性能和易用性方面都有很大优势。

机器学习一般采用 Spark 家族的 Spark MLlib 为技术底座。 Spark MLlib 内置大量的常规算法包,如随机森林、逻辑回归、决策树等,可以满足大部分数据智能应用场景。同时,数据中台不断进化,也还新融人 AI 能力。如人脸识别、以图搜图、智能客服等能力的实现就需要 AI 平台。目前较为成熟的 AI 平台有 TensorFlow 及 PyTorch 。

3.3.数据存储层

数据存储层所有的存储引擎都基于 Hadoop 的 HDFS 分布式存储,从而达到数据多份冗余和充分利用物理层多磁盘的 I / O 性能。在 HDFS 上分别搭建 Hive 、 HBase 作为存储数据库,在这两个数据库的基础上再搭建 Impala 、 Phoenix 、 Presto 引擎。

Hive 为大数据广泛使用的离线数据存储平台,用于存储数据中台的全量数据,在建模阶段可以使用 Hive SQL 、 Spark SQL 进行数据处理和建模。 HBase 为主流的大数据 NoSQL ,适合数据的快速实时读写。在实时数据处理时,可将数据实时保存到 HBase 中,并且可以从 HBase 中实时读取数据,从而满足数据的时效性。 Impala 可以对 Hive 、 HBase 等大数据数据库进行准实时的数据分析,能满足对分析结果速度有一定要求的场景。

Phoenix 是构建在 HBase 上的一个 SQL 层,能让我们用标准的 JDBC API 而不是 HBase 客户端 API 来创建表、插人数据和对 HBase 数据进行查询。 Presto 是一个开源的分布式 SQL 查询引擎,适用于交互式分析查询。 Presto 支持 Hive 、 HBase 、 MySQL 等多种关系型和大数据数据库的查询,并且文持 join 表。对于对接自助分析和统一数据服务的场景,可以通过 Presto 来统一访问具体存储的数据库,从而达到语法统一和数据源统一。

3.4.数据服务层

数据服务层采用的技术与业务应用类似,主要基于开源 Spring Cloud 、 Spring Boot 等构建,使用统一的服务网关、低代码平台来构建。