- 1从唐僧师徒四人性格特点看团队结构的组成_唐僧师徒四人的个性特点与团队建设

- 2C语言“学生信息管理系统”功能详解及代码展示2023级慕课版_c语言学生管理系统人民邮电大学

- 3Docker Dockerfile构建文件生成镜像_docker build -f -t

- 4【AI学习指南】七、PaddlePaddle自然语言处理-PaddleNLP的基础使用/中文分词/词性标注/实体识别/依存句法分析_词性标注 paddlenlp

- 5C语言小项目:学生信息管理系统(超详细)_教师、学生管理系统c语言项目研究

- 6前端AI工具Vercel V0初体验

- 7Hadoop3.1.3之完全分布式模式环境搭建

- 8今日必读的8篇大模型论文_大模型相关论文

- 9Move or commit them before Pull_idea 提示move or commit them before pull

- 10电脑硬盘分区表的两种格式:MBR 和 GPT

从大咖视角窥探Sora六大技术创新_sora怎么限制创新

赞

踩

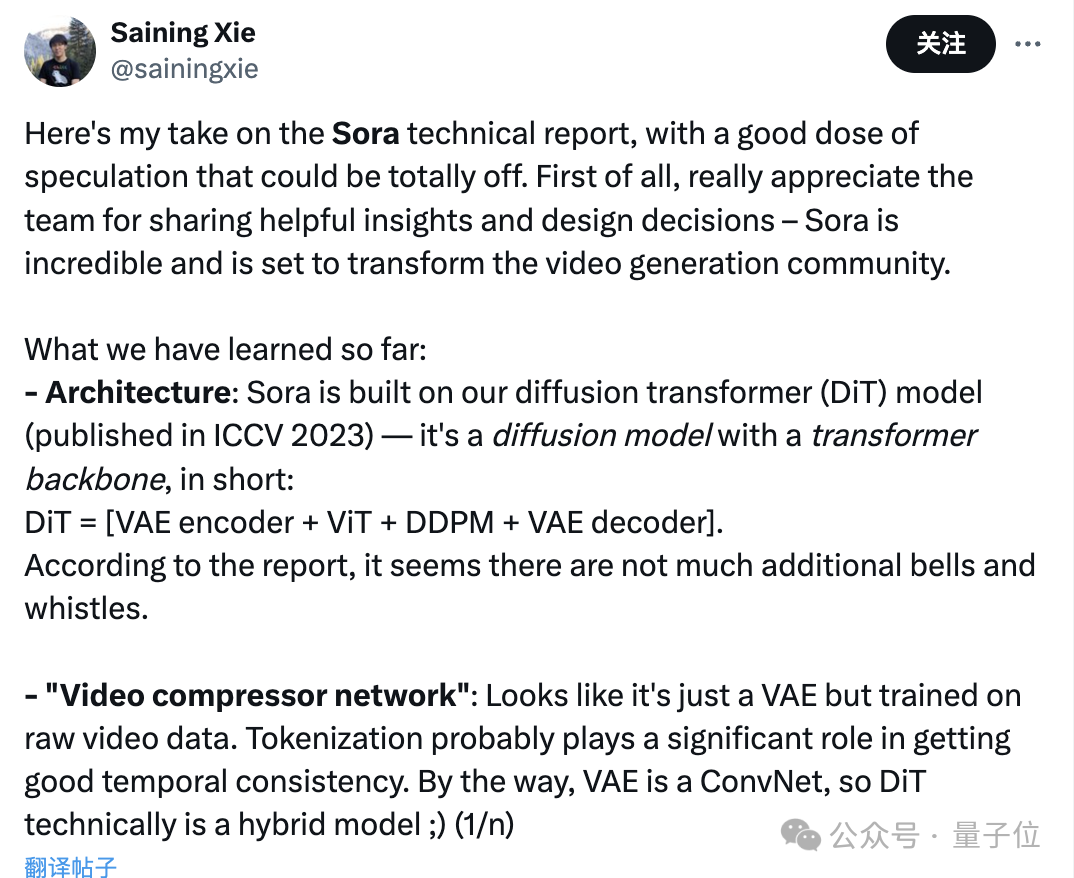

谢赛宁

纽约大学助理教授谢赛宁(ResNeXt的一作)直言,Sora将改写整个视频生成领域。

1、Sora应该是建立在DiT这个扩散Transformer之上的。即DiT是一个带有Transformer主干的扩散模型,它= [VAE 编码器 + ViT + DDPM + VAE 解码器]。

2、关于视频压缩网络,Sora可能采用的就是VAE架构,区别就是经过原始视频数据训练。

而由于VAE是一个ConvNet,所以DiT从技术上来说是一个混合模型。

3、Sora可能有大约30亿个参数。

Jim Fan

1、视频生成的GPT-3时刻

2、Sora应该是一个数据驱动的物理引擎。

3、Sora是对现实或幻想世界的模拟,它通过一些去噪、梯度下降去学习复杂渲染、“直觉”物理、长镜头推理和语义基础等。

Jim Fan分析,Sora首先要提供两个3D资产:不同装饰的海盗船;必须在潜在空间中解决text-to-3D的隐式问题;并且要两艘船避开彼此的路线,兼顾咖啡液体的流体力学、保持真实感、带来仿佛光追般的效果。

4、Sora还无法取代游戏引擎开发者

因为它对于物理的理解还远远不够,仍然存在非常严重的“幻觉”。

六大技术创新

Sora是一个在不同时长、分辨率和宽高比的视频及图像上训练而成的扩散模型,同时采用了Transformer架构,也就是一种“扩散型Transformer”。

1.将视觉数据转化为补丁(Turning visual data into patches)

在较高层面上,我们首先将视频压缩到较低维的潜在空间,19 然后将表示分解为时空补丁,从而将视频转换为补丁。

2.视频压缩网络(Video compression network)

训练了一个降低视觉数据维度的网络。该网络将原始视频作为输入,并输出在时间和空间上压缩的潜在表示。 Sora 在这个压缩的潜在空间中接受训练并随后生成视频。 还训练了相应的解码器模型,将生成的潜在表示映射回像素空间。

3.空时潜在补丁(Spacetime latent patches)

给定一个压缩的输入视频,我们提取一系列时空补丁,充当变压器令牌。 该方案也适用于图像,因为图像只是具有单帧的视频。 我们基于补丁的表示使 Sora 能够对不同分辨率、持续时间和长宽比的视频和图像进行训练。 在推理时,我们可以通过在适当大小的网格中排列随机初始化的补丁来控制生成视频的大小。

4.用视频生成的可伸缩的转换器(Scaling transformers for video generation)

Sora 是扩散模型; 给定输入噪声补丁(以及文本提示等调节信息),它被训练来预测原始的“干净”补丁。 重要的是,Sora 是一个扩散转换器。Transformer 在各个领域都表现出了卓越的缩放特性,包括语言建模、计算机视觉、和图像生成。

在下面的例子中,可以发现可伸缩的转换器也可以有效地缩放为视频模型。 本例,展示了训练过程中具有固定种子和输入的视频样本的比较。 随着训练计算的增加,样本质量显着提高。

5.可变的持续时间、分辨率、宽高比(Variable durations, resolutions, aspect ratios)

过去的图像和视频生成方法通常会将视频调整大小、裁剪或修剪为标准尺寸,例如 256x256 分辨率的 4 秒视频。 我们发现,对原始大小的数据进行训练有如下优点。

1)采样灵活

Sora 可以采样宽屏 1920x1080p 视频、垂直 1080x1920 视频以及介于两者之间的所有视频。 这使得 Sora 可以直接以其原生宽高比为不同设备创建内容。 它还使我们能够在以全分辨率生成之前快速以较低尺寸制作原型内容 - 所有这些都使用相同的模型。

2)改善帧和构图

我们根据经验发现,以原始长宽比对视频进行训练可以改善构图和取景。 我们将 Sora 与将所有训练视频裁剪为正方形的模型版本进行比较,这是训练生成模型时的常见做法。 在方形作物(左)上训练的模型有时会生成仅部分可见主体的视频。 相比之下,Sora(右)的视频的取景效果有所改善。

6.语言理解Language understanding

训练文本到视频生成系统需要大量带有相应文本字幕的视频。 我们将 DALL·E 3中引入的重新字幕技术应用于视频。 我们首先训练一个高度描述性的字幕生成器模型,然后使用它为训练集中的所有视频生成文本字幕。 我们发现,对高度描述性视频字幕进行训练可以提高文本保真度以及视频的整体质量。

与 DALL·E 3 类似,我们还利用 GPT 将简短的用户提示转换为较长的详细字幕,然后发送到视频模型。 这使得 Sora 能够生成准确遵循用户提示的高质量视频。

GPT-4 Turbo也大幅降低速率限制,提高TPM(每分钟最大token数量),较上一次实现2倍提升。