- 1Swift 结构化并发之全局 Actor 趣谈_swift mainactor

- 2大模型微调技术(Adapter-Tuning、Prefix-Tuning、Prompt-Tuning(P-Tuning)、P-Tuning v2、LoRA)_adapter tuning

- 3docker总结_代码部署在docker上会比虚拟机稳定吗/

- 4实验案例二:配置路由器实现互通

- 5使用 Github 学生包授权 Termius Pro_termius学生认证

- 6本地搭建mysql_本地mysql

- 7flink1.13 sql基础语法(二)join操作_flink look up join

- 8Android - 进度条的使用_android 进度条

- 9100M服务器能同时容纳多少人访问?_100m宽带支持多少并发用户

- 101441_TC275 DataSheet阅读笔记2

大模型之路3:趟到了Llama-Factory,大神们请指点_llamafactory导出模型很慢

赞

踩

各种AI工具和框架层出不穷,为开发者和研究者提供了前所未有的便利。当然了,也有困扰。尤其是对于动手能力越来越弱的中年油腻老程序员来说,更是难上加难。据说,嗯,据师弟说,说LlamaFactory凭借其独特的功能和优势,在AI领域(他所下载的代码和工具里),引起了广泛的关注(能够调试通过的)。当然,由于硬件环境的缘故,他的3个6000卡不好用,可能是有点老了吧,导致虽然能调试通过,但是运行一个开始就完了。

今天,我在自己这边的环境上,也尝试了,感觉还可以。有坑是自然的。

1、优点

一、高效的模型训练与调优

LlamaFactory在模型训练方面表现出了极高的效率。的确是快,比我用代码行和bash、jupyter都快多了。通过其提供的丰富的预训练模型和调优工具,用户可以快速地搭建起适用于自己任务的AI模型。在实际应用中,我发现LlamaFactory的训练速度明显快于之前的手搓方式,这主要得益于其界面上的组织。当然,底层优化的算法和高效的并行计算能力我还没完全体会到。(代码方式我是体会到了)。此外,按理说的,LlamaFactory还支持多种硬件平台,包括CPU、GPU和TPU等,进一步提升了训练的灵活性和效率。但是我没有运行成功。这个就比较扯。

语言栏里,有中英(俄?),中英文切换一下,对于去代码里手搓还是有帮助的,可以更好的理解。反正我目前对于这所谓的适配器还没理解到位,希望大神能指点一下,谢谢。

二、灵活的模型定制与扩展

除了高效的训练性能,LlamaFactory还提供了灵活的模型定制和扩展功能。用户可以根据自己的需求,轻松地调整模型的参数和结构,以适应不同的应用场景。据说,LlamaFactory能够成为了一个强大的“瑞士军刀”,无论是文本生成、图像识别还是语音识别等任务,都能通过简单的配置和调整实现出色的性能。但是我这么一个新新手,还没了解那么深刻。

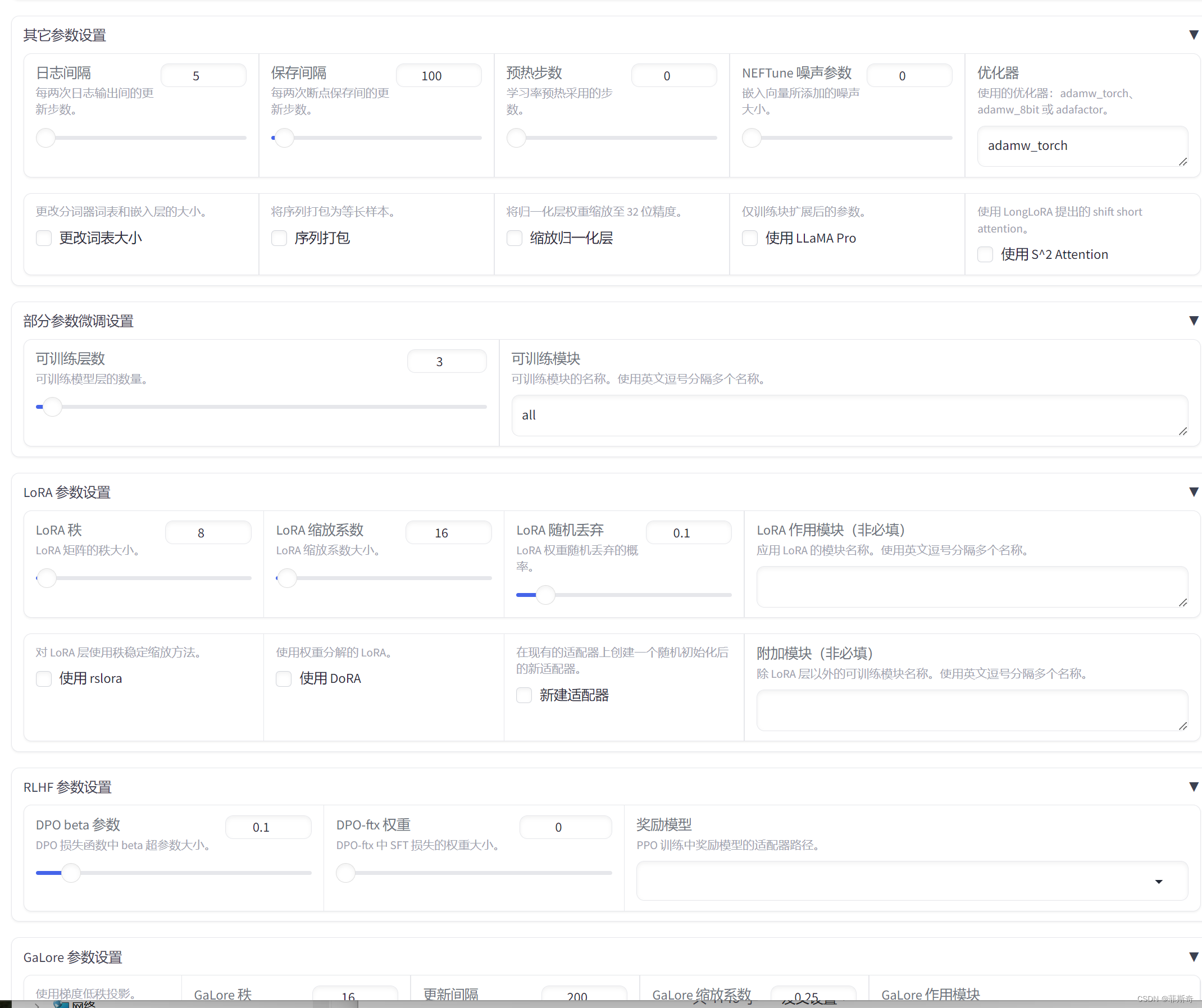

就这些设置,我都已经眼花缭乱了。

三、创新的Adapter技术

值得一提的是,LlamaFactory引入了创新的Adapter技术,这是一种轻量级的模型调整方法,可以在不改变原有模型结构的情况下,通过添加额外的网络层来适应新的任务。这种技术不仅保留了原有模型的泛化能力,还大大降低了模型调优的复杂度和成本。据说,Adapter技术显著提升了模型在新任务上的表现,能让人深刻体会到其实用性。但是我还是没搞明白。

比如配合着预览命令,我一下就明白了,之前的手搓bash就是这样的,但是问题在于,这个输出路径我大概看明白了,就是之前微调的时候输出的那个目录。那么,adapter的路径...又迷糊了,我也不会编辑Adapter啊。那,看来是要额外添加网络层的,这个其实更适合我来做后续的东西。加油吧。我的理解可能是这样,如果不对,大神请纠正。至于怎么用adapter,学习过程中希望大神们指点。再谢谢。

四、友好的用户界面与社区支持

LlamaFactory在用户体验方面也做得非常出色。其提供了直观易用的图形化界面,使得用户无需深入了解复杂的底层技术,就能轻松上手并享受AI带来的便利。我现在就只是看的官方介绍,是从gitee上看的 grang/LLaMA-Factory。

2、修改数据集

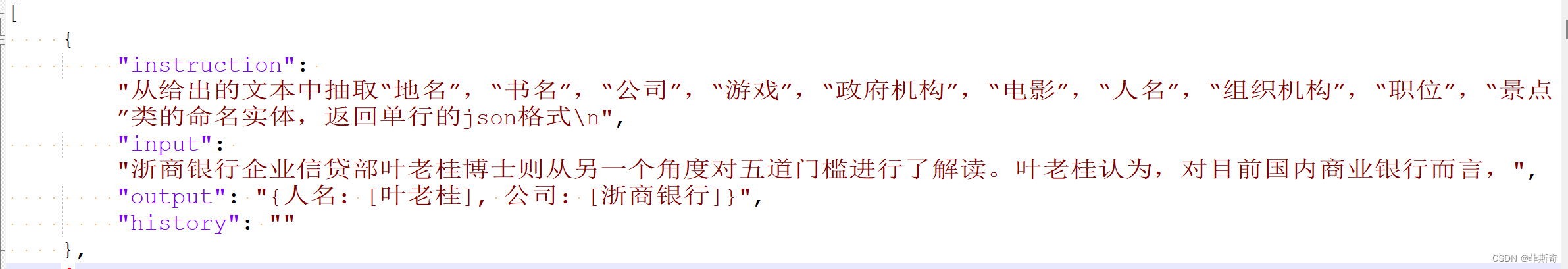

主要就是数据集的设置,按照readme的介绍,修改就好了,主要就是dataset的json文件

因为大模型的确不是很好去看效果,我才开始就弄错了,但是也没有发现。

有一个地方,就是数据集要写成下面这样

我开始的时候用python写这个数据集文件,把output也写成了json,然后就出错了(我用的是cmd conda 运行的方式,原因也正是下面求助所示)

3、求助

如上面所看到的,我进行配置后,按理说应该是可以了。那么点“start”以后就应该可以跑起来了。事实上,并没有。

很礼帽的给我干出来一个警告。但是我并没有感觉哪个地方需要设置多GPU啊。

而且,我手搓Bash的时候,single和mul 是两个不一样的sh,我翻了翻后面的代码,也没看明白应该在哪里去设置。希望路过的大神驻足,请指点迷津,谢三次

最后,我还是把那个预览代码拷贝到服务器上手动执行的,才成功。很奇怪,超出了我的学习范围。

祝大家天天都开心。。。。