- 1mysql 除法和四舍五入_mysql除法

- 2Docker Alpine安装oracle客户端_alpine linux loading shared library libnsl.so.1: n

- 3JAVA基础篇--JVM--7对象的垃圾回收器_jdk7默认回收器

- 4Docker 学习笔记(七):介绍 Dockerfile 相关知识,使用 Dockerfile 构建自己的 centos 镜像

- 5小程序 wx.getStorageSync 读取数据

- 63.2万美元造成的斯坦福双臂机器人爆红后,项目负责人亲自发翻车视频

- 7从零开始的PICO教程(2)--实时预览应用场景_pico unity integration sdk 开发

- 8【BART】_bart模型架构

- 9NLP机器翻译全景:从基本原理到技术实战全解析_机器翻译基于规则的

- 10基于CameraX完成拍照和拍视频_camerax 拍照以后上传

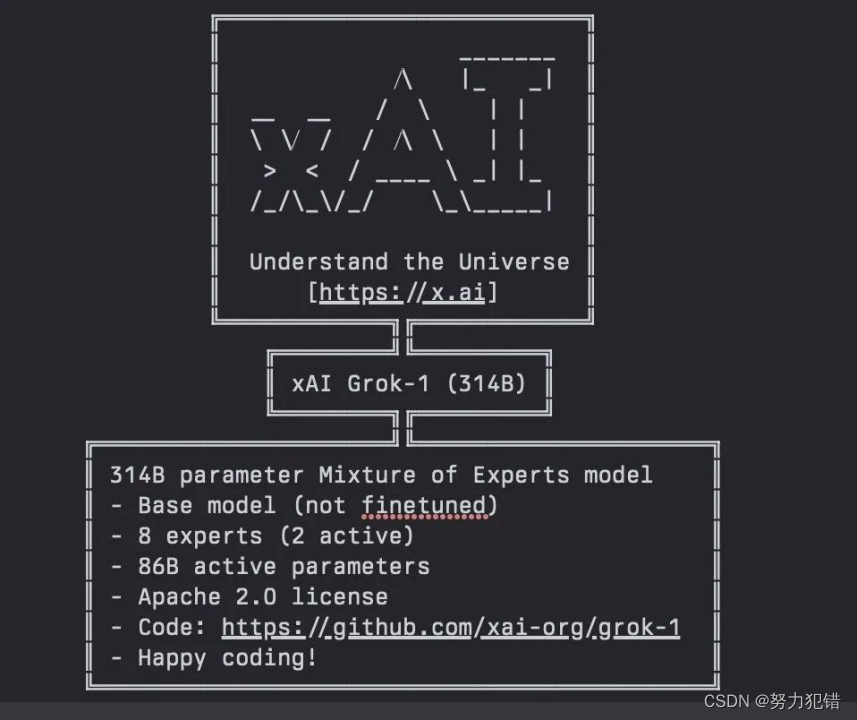

马斯克全面开源Grok,3140亿参数8个MoE,全球最大开源大模型_马克斯grok网址

赞

踩

前言

马斯克旗下的xAI近日正式宣布,旗舰大模型Grok-1全面开源,这是一个拥有3140亿参数的混合专家(MoE)模型。这一开放行为不仅标志着Grok-1成为全球参数量最大的开源大语言模型,也意味着开源社区即将迎来一场前所未有的技术革新浪潮。

Grok-1的开源,遵循Apache 2.0许可证,允许用户自由地使用、修改和分发软件,旨在推动技术的广泛应用和快速发展。作为当前技术领域最受瞩目的项目之一,Grok-1的开源在短时间内吸引了大量关注,项目发布后迅速获得了上万的星标,成为开源社区的焦点。

-

Huggingface模型下载:https://huggingface.co/xai-org/grok-1

-

AI快站模型免费加速下载:https://aifasthub.com/models/xai-org/grok-1

模型简介

-

模型概况

拥有3140亿个参数,成为目前参数量最大的开源模型;Grok-1 是一个基于 Transformer 的自回归模型。xAI 利用来自人类和早期 Grok-0 模型的大量反馈对模型进行了微调。初始的 Grok-1 能够处理 8192 个 token 的上下文长度,已经于 2023 年 11 月发布。

-

特点

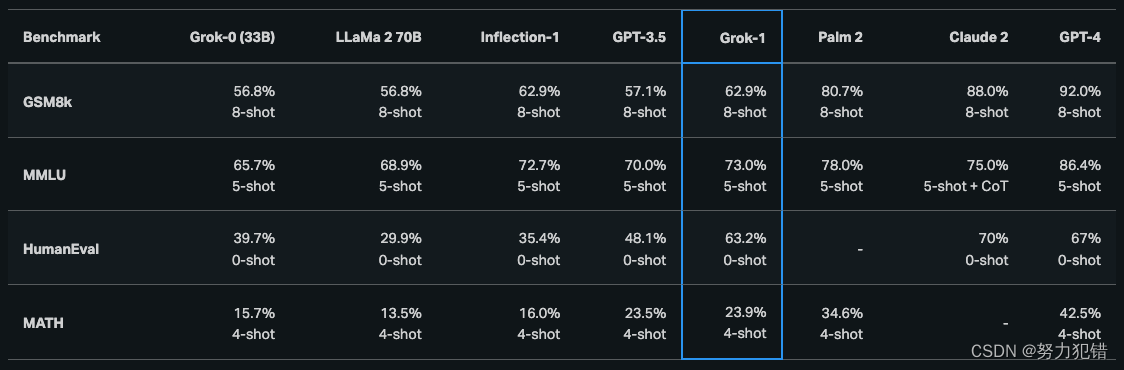

模型采用了混合专家架构,共有8个专家模型,其中每个数据单元(Token)由2位专家处理。这使得每次对Token的处理会涉及860亿激活参数,比目前开源的最大模型Llama-2 70B的总参数量还多。模型包含64个处理层,模型使用了48个用于处理查询的注意力机制单元和8个用于处理键/值对的注意力机制单元。模型支持8bit精度量化。

-

训练数据

Grok-1 发布版本所使用的训练数据来自截至 2023 年第三季度的互联网数据和 xAI 的 AI 训练师提供的数据。

训练复现与应用前景

Grok-1的训练复现方案涵盖了从大规模图像预训练到高质量视频数据微调的全过程。通过这种多阶段训练策略,模型不仅在多个零样本多模态理解任务上表现优异,还在视觉问答(VQA)、图像描述(image caption)等多个下游任务上取得了突破性成果。

开源Grok-1为全球的研究者和开发者提供了一项强大的资源,使得任何人都可以在自己的研究和项目中利用这一最先进的技术。从增强现实到智能助理,从内容创作到社交媒体分析,Grok-1的潜在应用前景无限广阔,预计将在多个领域引发技术创新和应用革命。

开源影响与未来展望

Grok-1的全面开源,不仅是马斯克对开源理念的坚定支持,更是对整个AI行业一个重大的贡献。这一行动有望促进全球AI技术的快速进步,推动更多创新应用的诞生。同时,作为全球参数量最大的开源大模型,Grok-1的成功开源也为AI研究设置了一个新的标杆,鼓励了更多的开源项目和合作。

随着Grok-1开源项目的深入,未来将有更多的技术细节和应用案例被公开。这不仅将加深我们对AI技术的理解,也将激发全球技术社区的创新潜力,共同推动AI技术的发展,造福人类社会。

模型下载

Huggingface模型下载

https://huggingface.co/xai-org/grok-1AI

快站模型免费加速下载

https://aifasthub.com/models/xai-org/grok-1